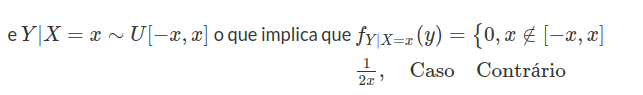

8.2 Variáveis Aleatórias

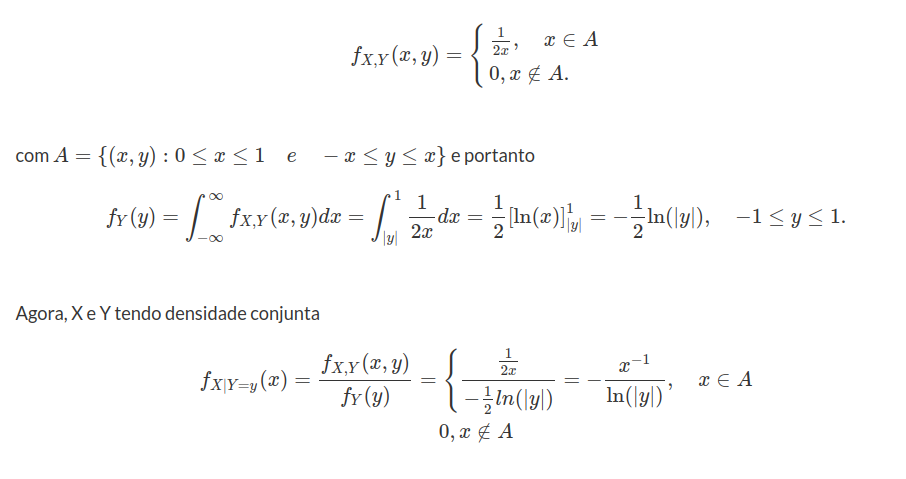

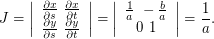

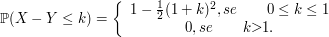

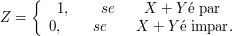

Dado um fenômeno aleatório qualquer, com um certo espaço amostral, desejamos estudar a estrutura probabilística de quantidades associadas a esse fenômeno. Por exemplo, ao descrever uma peça manufaturada podemos empregar duas classificações: “defeituosa” ou “não defeituosa”. Para facilitar a análise, vamos atribuir um número real a cada resultado do experimento. Assim podemos atribuir o valor 0 às peças não defeituosas e 1 às defeituosas. Nós podemos entender por variável aleatória uma função que associa a cada elemento do espaço amostral (neste exemplo os elementos são “defeituosa”, “não defeituosa”) um número real. Denotaremos as variáveis aleatórias por letras maiúsculas.

Definição 2.1

Consideremos um experimento e $ \Omega $ o espaço amostral associado a esse experimento. Uma função X, que associa a cada elemento $ \omega \in \Omega $ um número real, $ X(\omega) $, é denominada variável aleatória (v.a.). Ou seja, variável aleatória é um característico numérico do resultado de um experimento.

As variáveis aleatórias são fundamentais para as aplicações, pois elas representam as características de interesse em uma população. Por exemplo, em uma linha de usinagem de peças estamos interessados em controlar o diâmetro das peças produzidas. Neste caso, o resultado da medição do diâmetro é a variável aleatória de interesse. Em um ensaio clínico, estamos interessados em avaliar o tempo de vida dos pacientes e neste caso, a tempo de vida corresponde à variável aleatória.

Exemplo 2.1

Considere três lançamentos independentes de uma moeda equilibrada. Seja $C$ cara e $K$ coroa. O espaço amostral deste experimento é $S={(C,C,C); (C,C,K); (C,K,C); (K,C,C); (C,K,K); (K,C,K); (K,K,C); (K,K,K)}$. Podemos definir a variável aleatória $X$: “número de caras obtidas nos três lançamentos”. Por exemplo, temos que $X((C,C,C)) = 3$ e $X((K,C,C))=2$.

Exemplo 2.2

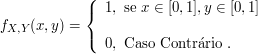

Escolher um ponto ao acaso no quadrado unitário, ou seja, escolher um par ordenado $ (x,y) \in [0,1] \times [0,1] $. Então $ \Omega=[0,1]\times [0,1] $ e como exemplo de variável aleatória o produto das duas coordenadas $ X(\omega)= x y $., para todo $ w =(x,y) \in \Omega $.

Em geral, não é qualquer função com domínio no espaço amostral e imagem na reta que é uma variável aleatória. Para espaços amostrais infinitos não enumeráveis, dizemos que a função $ X: \Omega \rightarrow \Bbb{R} $ é uma variável aleatória se o conjunto $ \lbrace w \in \Omega : X(w) \leq x \rbrace $ é um evento (pertence a $ \sigma $-álgebra de eventos em $ \Omega $), para todo $ x \in \Bbb{R} $

2.1 - Função de distribuição acumulada

A função de distribuição acumulada descreve como probabilidades são associadas aos valores ou aos intervalos de valores de uma variável aleatória. Ela representa a probabilidade de uma variável aleatória ser menor ou igual a um valor real $ x $. Na seção distribuição de probabilidade na reta, mostramos que variável aleatória e função de distribuição acumulada são sinônimos. Desta forma, podemos definir variáveis aleatórias através da sua função de distribuição acumulada. Na sequência, vamos definir e estudar propriedades da função de distribuição acumulada. Para isto, tomamos o espaço de probabilidade $ (\Omega , {\cal F} , \mathbb{P}) $.

Definição 2.1.1

A função de distribuição acumulada de uma variável aleatória $ X $ definida sobre $ (\Omega , \mathcal{F} , \mathbb{P}) $ é uma função que a cada número real $ x \in \mathbb{R} $ associa o valor

$$F(x)=\mathbb{P}\left(X\leq x\right) \in [0,1].$$

A notação $ (X \leq x) $ é usada para designar o conjunto $ \lbrace \omega\in \Omega : X(\omega) \leq x\rbrace $, isto é, denota a imagem inversa do intervalo $ (-\infty,x] $ pela variável aleatória X. Com isso, podemos observar que a função de distribuição acumulada $ F $ tem como domínio os números reais $ (\Bbb{R}) $ e imagem o intervalo $ [0,1] $.

O conhecimento da função de distribuição acumulada é suficiente para entendermos o comportamento de uma variável aleatória. Mesmo que a variável assuma valores apenas num subconjunto dos reais, a função de distribuição é definida em toda a reta. Ela é chamada de função de distribuição acumulada, pois acumula as probabilidades dos valores inferiores ou iguais a $x$.

Exemplo 2.1.1

Consideremos o Exemplo 2.1. Vamos encontrar a função distribuição acumulada de $ X $: “número de caras obtidas nos três lançamentos”.

Os valores que $ X $ pode assumir são $ 0,1,2 $ e $ 3 $. Portanto,

$$\mathbb{P}(X=0)=\mathbb{P}((KKK))=\frac{1}{2}\times\frac{1}{2}\times\frac{1}{2}=\frac{1}{8}.$$

$$\mathbb{P}(X=1)=\mathbb{P}((CKK))+\mathbb{P}((KCK))+\mathbb{P}((KKC))=\frac{3}{8}.$$

$$\mathbb{P}(X=2)=\mathbb{P}((CCK))+\mathbb{P}((CKC))+\mathbb{P}((KCC))=\frac{3}{8}.$$

$$\mathbb{P}(X=3)=\mathbb{P}((CCC))=\frac{1}{8}.$$

Portanto,

$$\text{se} \ x \ < \ 0 \Rightarrow \mathbb{P}(X\leq x) = 0,$$

$$\text{se} \ 0\leq x \ < \ 1 \Rightarrow \mathbb{P}(X\leq x) = \mathbb{P}(X = 0) = \frac{1}{8},$$

$$\text{se} \ 1\leq x \ < \ 2 \Rightarrow \mathbb{P}(X\leq x) = \mathbb{P}(X = 0) + \mathbb{P}(X = 1) = \frac{1}{8} + \frac{3}{8} = \frac{1}{2},$$

$$\text{se} \ 2\leq x \ < \ 3 \Rightarrow \mathbb{P}(X\leq x) = \mathbb{P}(X = 0) + \mathbb{P}(X = 1) + \mathbb{P}(X = 2) = \frac{1}{8} + \frac{3}{8} + \frac{3}{8} = \frac{7}{8} \ \text{e}$$

$$\text{se} \ x\geq 3, \Rightarrow \mathbb{P}(X\leq x) = \mathbb{P}(X = 0) + \mathbb{P}(X = 1) + \mathbb{P}(X = 2) + \mathbb{P}(X = 3) = 1.$$

Desta forma, temos que a função de distribuição acumulada de $ X $ é dada por

$$\displaystyle F(x) = \begin{cases} 0, \ \hbox{se} \ x \ < \ 0; \cr 1/8, \ \hbox{se} \ 0 \leq x \ < \ 1; \cr 1/2, \ \hbox{se} \ 1 \leq x \ < \ 2;\cr 7/8, \ \hbox{se} \ 2\leq x \ < \ 3; \cr 1, \ \hbox{se} \ x \geq 3.\end{cases}$$

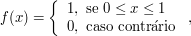

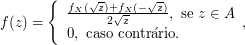

Exemplo 2.1.2

O tempo de validade, em meses, de um óleo lubrificante num certo equipamento está sendo estudado. Seja $ \Omega = \lbrace \omega\in \Bbb{R} : 6 \ < \ \omega \leq 8\rbrace $. Uma variável de interesse é o próprio tempo de validade e, nesse caso, definimos $ X(\omega) = \omega; \ \forall \ \omega\in \Omega $. Por exemplo, podemos tomar a seguinte função de distribuição acumulada de $ X $:

$$F(x) = \begin{cases} 0, \ \hbox{se} \ x \ < \ 6;\cr (x - 6)/2, \ \hbox{se} \ 6 \leq x \ < \ 8;\cr 1, \ \hbox{se} \ x \geq 8.\cr \end{cases}$$

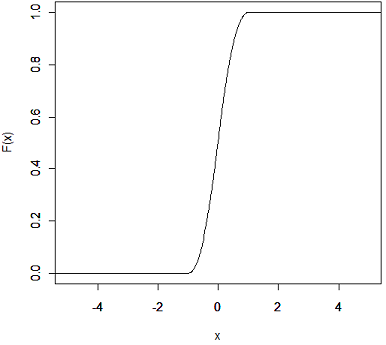

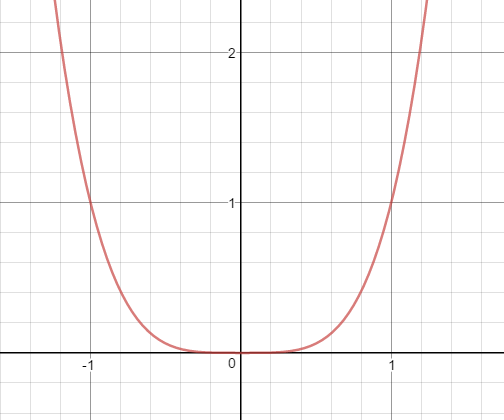

FIgura 8.2.1: Função de Distribuição Acumulada de probabilidade

Observe que neste exemplo, definimos diretamente a Função de Distribuição Acumulada (FDA) ao invés da probabilidade. Na maioria das aplicações, partimos da FDA para definirmos o modelo probabilístico.

A função de distribuição acumulada de uma variável aleatória $ X $ têm três propriedades básicas:

-

$ 0\leq F(x)\leq 1 $, $ \lim_{x \rightarrow -\infty} F(x) =0 $ e $ \lim_{x \rightarrow \infty} F(x)=1 $;

-

$ F $ é não decrescente.

-

$ F $ é uma função contínua à direita e tem limite à esquerda.

Demonstração

(1) Se $ x \rightarrow - \infty $, então $ (X\leq x)\downarrow \emptyset $ e assim $ F(x)=\mathbb{P}(X\leq x)\downarrow 0 $. Se $ x \rightarrow + \infty $, então $ (X\leq x)\uparrow \Omega $ e assim $ F(x)=\mathbb{P}(X\leq x)\uparrow 1 $.

(2) $ F $ não decrescente é equivalente a $ x\leq y\Rightarrow (X\leq x)\subset (X\leq y) \Rightarrow F(x)=\mathbb{P}(X\leq x)\leq \mathbb{P}(X\leq y)=F(y) $

(3) $ F $ é contínua a direita é equivalente a se $ x_n\downarrow x $, então $ (X\leq x_n) $ é um sequência decrescente de eventos aleatórios e $ \displaystyle \bigcap_{n\geq 1}[X\leq x_n]= ([X\leq x) $, pois $ X\leq x $ se, e somente se, $ X\leq x_n{ }\forall n $. Assim, concluímos que

$$F(x_n)=\mathbb{P}(X\leq x_n)\downarrow \mathbb{P}(X\leq x)=F(x)$$

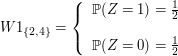

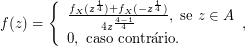

Exemplo 2.1.3

Para o lançamento de uma moeda, temos que $ \Omega = (\text{cara}, \text{coroa}) $ e que $ \mathbb{P}(\text{cara}) = \mathbb{P}(\text{coroa}) = \frac{1}{2} $. Definimos uma variável aleatória $ X:\Omega\rightarrow\mathbb{R} $ da seguinte forma:

$$X(\omega) = \begin{cases}1, \ \hbox{se} \ \omega = \ \hbox{cara}; \cr 0, \ \hbox{se} \ \omega = \ \hbox{coroa}\cr \end{cases}$$

Para obter a função de distribuição acumulada da variável aleatória $ X $, é conveniente separar os vários casos, de acordo com os valores da variável.

Para $ x \ < \ 0 $, $ \mathbb{P}(X \leq x) = 0 $, uma vez que o menor valor assumido pela variável $ X $ é $ 0 $. No intervalo $ 0 \leq x \ < \ 1 $, temos que $ \mathbb{P}(X \leq x) = \mathbb{P}(X = 0) = 1/2 $. E, para $ x \geq 1 $, temos que $ \mathbb{P}(X \leq x) = \mathbb{P}(X = 0) + \mathbb{P}(X = 1) = 1 $. Dessa forma, $ F(x) = \mathbb{P}(X \leq x) $ foi definida para todo $ x $ real. Assim, temos

$$F(x) = \begin{cases} 0, \ \hbox{se} \ x \ < \ 0; \cr 1/2, \ \hbox{se} \ 0 \leq x \ < \ 1;\cr 1, \ \hbox{se} \ x \geq 1.\cr \end{cases}$$

O seguinte resultado, nos diz que qualquer função $ F $ que satisfaz as propriedades básicas (1, 2 e 3) é a função de distribuição acumulada de alguma variável aleatória na reta. A demonstração deste resultado está na seção distribuição de probabilidade na reta.

Teorema 2.1.1

Toda função $ F $ satisfazendo as propriedades básicas é uma função de distribuição acumulada de alguma variável aleatória.

A partir deste resultado, podemos definir variáveis aleatórias através da sua respectiva função de distribuição acumulada.

Exemplo 2.1.4

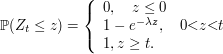

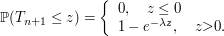

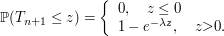

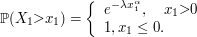

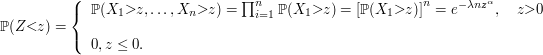

Seja $ X $ é uma variável aleatória com distribuição exponencial de parâmetro $ \lambda > 0 $, qual a distribuição da variável aleatória $ Y=\min(\lambda,X) $? Faça a decomposição de $ F_Y $.

a) Distribuição de Y é dada por

(a1) $ Y< \lambda $ e $ \mathbb{P}(Y\leq y)=0 $

(a2) $ Y=\lambda $ temos que

$$\mathbb{P}(Y\leq y)=\mathbb{P}(Y=\lambda)=\mathbb{P}(X\leq \lambda)=1-e^{-\lambda^2}$$

(a3) $ Y> \lambda $

$$\mathbb{P}(Y\leq y)=\mathbb{P}(X\leq x)=1-e^{-\lambda x}$$

b) Decomposição de $ F_Y $

(b1) $ F_{Y_d}: $

$$\mathbb{P}(Y_{d}=y)=F_Y(y)-F_Y(y^-)=\begin{cases} \displaystyle 0, \text { se } y\neq c\cr \cr 1-e^{-\lambda ^2}, y=\lambda \end{cases}$$

(b2) $ F_{Y_{ab}}(y)=\int_{-\infty}^y f(y)dy $. Então,

$$f(y)=\begin{cases} \displaystyle 0, \text { se } y\neq \lambda\cr \cr \lambda e^{-\lambda y}, y> \lambda \end{cases}$$

Então,

$$F_{Y_{ab}}(y)=\begin{cases} \displaystyle 0, \text { se } y\neq \lambda\cr \cr e^{-\lambda^2}-e^{-\lambda y}, y> \lambda \end{cases}$$

e então, $ F_Y(y)=F_{Y_d}(y)+F_{Y_{ab}}(y), \forall y \in \mathbb{R} $ o que implica que $ F_{Y_s}=0 $ para qualquer $ y\in \mathbb{R} $.

Exemplo 2.1.5

Cinco pontos são escolhidos, independentemente e ao acaso, do intervalo $ [0,1] $. Seja $ X $ o número de pontos que pertencem ao intervalo $ [0,c] $ no qual $ 0< c< 1 $. Qual a distribuição $X$? X É a repetição de ensaios com mesma probabilidade de sucesso de $ p $ e independentes, no qual

$$p=\frac{comp[0,c]}{comp[0,1]}=c.$$

Então, $ X $ tem distribuição binomial com parâmetro $ 5 $ e $ p $.

Exemplo 2.1.6

Determine a distribuição do tempo de espera até o segundo sucesso em uma sequência de ensaios de Bernoulli com probabilidade $ p $ de sucesso.

Seja $ X $ a variável aleatória que designa o tempo de espera até o segundo sucesso. Note que a probabilidade de ocorrer 2 sucessos em $ k(k\geq 2) $ é $ p^2(1-p)^{k-2} $. Agora o último ensaio ocorre na última posição então o primeiro ensaio pode ocorrer em qualquer das posições anteriores. Assim,

$$\mathbb{P}(X=k)=(k-1)p^2(1-p)^{k-2}, k=2,3,\dots$$

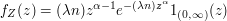

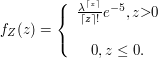

Exemplo 2.1.7

Uma massa radioativa emite partículas segundo um processo de Poisson a uma taxa média de 10 partículas por segundo. Um contador é colocado ao lado da massa. Suponha que cada partícula emitida atinge o contador com probabilidade de $ 1/10 $, que o contador registra todas as partículas que o atingem, e que não há iteração entre as partículas(elas se movimentam independentemente).

(a) Qual a distribuição de $ X_i= $ número de partículas emitidas até o tempo $ t,t> 0 $?

Temos $ (X_t)_{t> 0} $ é a probabilidade de Poisson então

$$\mathbb{P}(X_t=n)=\mathbb{P}(A^n_{0,t})=\begin{cases} \displaystyle \frac{(\lambda t)^n}{n!}e^{-\lambda t}, \text { se } n=0,1,2,\dots \cr \cr 0, \text{ caso contrário }.\end{cases}$$

(b) Prove que $ Y_t $ tem distribuições de Poisson, onde $ Y_t $ é o número de partículas registradas (contadas) até o tempo t, $ t> 0 $. Qual o parâmetro?

$$Y_t=\text{número de partículas registradas.}$$

Agora

$$[Y_t=n]=\bigcup_{k=n}^\infty \left([Y_t=n]\cap [X_t=k]\right)$$

o que implica que

$$\mathbb{P}(Y_t=n)=\sum_{k=n}^\infty \mathbb{P}(Y_t=n,X_t=k)=\sum_{k=n}{\infty}\mathbb{P}(Y_t=n|X_t=n)\mathbb{P}(X_t=k)$$

Agora,

$$\begin{cases} \displaystyle Y_t|X_t=k\sim \hbox{Binom}\left(k,\frac{1}{10}\right)\Rightarrow \mathbb{P}\left(Y_t=n|X_t=k\right)=\frac{k!}{(n-k)!n!} \left(\frac{1}{10}^k\right)\left(\frac{9}{10}^k\right)^{k-n} \cr \cr X_t\sim \hbox{Poisson}(\lambda t) \Rightarrow \mathbb{P}(X_t=k)=\frac{(\lambda t)^k}{k!}e^{-\lambda}\end{cases}$$

Então

$$\mathbb{P}(Y_t=n)=\sum_{k=n}^\infty \frac{k!}{(n-k)!n!}\left(\frac{1}{10}\right)^n \left(\frac{9}{10}\right)^{k-n}\frac{(\lambda t)^k}{n!} c^{\lambda t}= \frac{(\lambda t)^n \left(\frac{1}{10}\right)^n}{n!}e^{-\lambda t}\sum_{k=n}^\infty \frac{\left(\frac{9}{10}\lambda t\right)^{k-n}}{(k-n)!}$$

$$=\frac{\left(\frac{\lambda t}{10}\right)^n e^{-\lambda t}}{10} $$

Então, $ Y_t\sim \hbox{Poisson} \left(\frac{\lambda}{10}t\right) $

2.1.1 - Distribuição de probabilidade na reta

A fim de construir a probabilidade na reta real $ \mathbb{R} $, vamos construir, inicialmente, os conjuntos de Borel da reta. Neste sentido, considere a classe dos intervalos abertos à esquerda e fechados à direita da forma

$$(a,b] = \lbrace x\in\mathbb{R}: a \ < \ x\leq b \rbrace$$

para quaisquer $ a $ e $ b $ tais que $ -\infty\leq a \ < \ b \ < \ \infty $.

Observação 2.1.1.1

Consideramos o intervalo $ (a,\infty] $ como sendo o intervalo aberto $ (a,\infty) $. Esta consideração é importante para que o complementar de um intervalo $ (-\infty,b] $ dado por $ (\infty,b]^c = (b,\infty) = (b,\infty] $ seja um elemento da classe.

Seja $ \mathcal{A} $ a classe de subconjuntos de $ \mathbb{R} $ composta pelo conjunto vazio $ \varnothing $ e dos conjuntos que podem ser escritos como uma união finita de intervalos disjuntos da forma $ (a,b] $, isto é,

$$A\in\mathcal{A} \ \text{se} \ A = \varnothing \ \text{ou} \ A = \bigcup_{i=1}^n(a_i,b_i], \ \text{com} \ (a_i,b_i]\cap (a_j,b_j] = \varnothing \ \text{se} \ i\neq j \ \text{e} \ n \ < \ \infty.$$

Proposição 2.1.1.1

A classe $ \mathcal{A} $ é uma álgebra.

Demonstração

De fato, para que $ \mathcal{A} $ seja uma álgebra, basta verificar as seguintes condições:

-

$ \varnothing\in\mathcal{A} $;

-

Se $ A,B\in\mathcal{A} $ então $ A\cap B\in\mathcal{A} $.

-

Se $ A\in\mathcal{A} $, então $ A^c\in\mathcal{A} $.

O item 1) é imediato da definição da classe $ \mathcal{A} $. Para verificar o item 2), seja $ A,B\in\mathcal{A} $ e observamos que, se ou $ A = \varnothing $ ou $ B = \varnothing $, então $ A\cap B = \varnothing \in\mathcal{A} $. Suponha que

$$A = \bigcup_{i=1}^n(a_i,b_i] \ \text{com} \ (a_i,b_i]\cap(a_j,b_j] = \varnothing \ \text{se} \ i\neq j \ \text{e} \ B = \bigcup_{k=1}^m(c_k,d_k] \ \text{com} \ (c_k,d_k]\cap(c_l,d_l] = \varnothing \ \text{se} \ k\neq l.$$

Segue então que

$$A\cap B = \left(\bigcup_{i=1}^n(a_i,b_i]\right)\bigcap\left(\bigcup_{k=1}^m(c_k,d_k]\right) = \bigcup_{i=1}^n\bigcup_{k=1}^m\left((a_i,b_i]\cap(c_k,d_k]\right).$$

Mas, para $ i = 1,\ldots,n $ e $ k = 1,\ldots, m $ temos que

$$(a_i,b_i]\cap(c_k,d_k] = \begin{cases} \varnothing \ \text{se} \ a_i \ < \ b_i \ < \ c_k \ < \ d_k \ \ \text{ou} \ c_k \ < \ d_k \ < \ a_i \ < \ b_i \ \text{ou substituindo} \ < \ \text{por} \ \leq\cr (c_k,b_i] \ \text{se} \ a_i \ < \ c_k \ < \ b_i \ < \ d_k \ \text{ou substituindo} \ < \ \text{por} \ \leq\cr (a_i,d_k] \ \text{se} \ c_k \ < \ a_i \ < \ d_k \ < \ b_i \ \text{ou substituindo} \ < \ \text{por} \ \leq\cr (a_i,b_i] \ \text{se} \ c_k \ < \ a_i \ < \ b_i \ < \ d_k \ \text{ou substituindo} \ < \ \text{por} \ \leq\cr (c_k,d_k] \ \text{se} \ a_i \ < \ c_k \ < \ d_k \ < \ b_i \ \text{ou substituindo} \ < \ \text{por} \ \leq\end{cases}$$

de modo que $ A\cap B $ pode ser escrito como uma união finita de elementos da forma $ (a,b] $. Portanto, $ A\cap B \in\mathcal{A} $. Basta agora verificar o item 3). Se $ A = \varnothing $, então $ A^c = \mathbb{R} = (-\infty,\infty) $ que pode ser escrito na forma

$$\mathbb{R} = (-\infty,\infty) = (-\infty,0]\cup(0,\infty]\in\mathcal{A}.$$

Para o caso em que $ A = \cup_{i=1}^n(a_i,b_i] $, com $ (a_i,b_i]\cap(a_j,b_j] = \varnothing $ se $ i\neq j $, podemos reescrever $ A $ da forma

$$A = \bigcup_{j=1}^n(a_{i_j},b_{i_j}]$$

de forma que

$$-\infty \leq a_{i_1} \ < b_{i_1} \leq a_{i_2} \ < \ b_{i_2} \leq \ldots \leq a_{i_n} \ < \ b_{i_n} \leq \infty$$

e então, temos que

$$A^c = \left(\bigcup_{j=1}^n(a_{i_j},b_{i_j}]\right)^c = (-\infty,a_{i_1}]\cup (b_{i_1},a_{i_2}] \cup \ldots \cup (b_{i_{n-1}},a_{i_n}] \cup (b_{i_n},\infty] \in \mathcal{A}.$$

completando a demonstração.

É importante observar que, apesar da classe $ \mathcal{A} $ ser uma álgebra, como demonstrado Pela Proposição 2.1.1.1, ela não é uma $ \sigma $-álgebra. De fato, a propriedade $ \sigma $-aditiva não é satisfeita. Basta tomar os conjuntos $ A_n\in\mathcal{A} $ dados por $ A_n = (0,1-\frac{1}{n}] $. Desta forma temos que

$$\bigcup_{n=1}^{\infty}A_n = (0,1)\notin \mathcal{A}.$$

Definição 2.1.1.1

Seja $ \sigma(\mathcal{A}) $ a $ \sigma $-álgebra gerada pela classe de eventos $ \mathcal{A} $. Esta $ \sigma $-álgebra desempenha um papel fundamental em análise e é chamada de $ \sigma $-álgebra de Borel de subconjunto da reta $ \mathbb{R} $, denotada por $ \mathfrak{B}(\mathbb{R}) $. Seus conjuntos são denominados conjuntos de Borel da reta ou de borelianos da reta.

Observação 2.1.1.2

Se $ \mathcal{I} $ é a classe de intervalos da forma $ (a,b] $ e $ \sigma(\mathcal{I}) $ é a menor $ \sigma $-álgebra de conjuntos que contém $ \mathcal{I} $, podemos verificar que $ \sigma(\mathcal{I}) $ é a $ \sigma $-álgebra de Borel. Em outras palavras, podemos obter a $ \sigma $-álgebra de Borel a partir de $ \mathcal{I} $ sem a álgebra $ \mathcal{A} $, já que $ \sigma(\mathcal{I}) = \sigma(\alpha(\mathcal{I})) $.

A $ \sigma $-álgebra de Borel não contém somente os intervalos da forma $ (a,b] $, mas também os conjuntos unitários da forma $ (a) $ e os intervalos da forma $ (a,b) $, $ [a,b] $, $ [a,b) $, $ (-\infty,b) $ e $ (a,\infty) $. De fato, temos que

$$(a,b) = \bigcup_{n=1}^{\infty}\left(a,b-\frac{1}{n}\right], \ a \ < \ b,$$

$$[a,b] = \bigcap_{n=1}^{\infty}\left(a-\frac{1}{n},b\right], \ a \ < \ b,$$

$$(a)=\bigcap_{n=1}^{\infty}\left(a-\frac{1}{n},a\right]$$

e todos os demais elementos são construídos a partir destes três.

Também ressaltamos que $ \mathfrak{B}(\mathbb{R}) $ pode ser construída a partir de quaisquer classes de intervalos das formas mencionadas acima ao invés dos intervalos do tipo $ (a,b] $, já que todas as $ \sigma $-álgebras mínimas geradas por essas classes de intervalos são as mesmas, isto é, $ \mathfrak{B}(\mathbb{R}) $.

Observação 2.1.1.3

O espaço mensurável $ (\mathbb{R},\mathfrak{B}(\mathbb{R})) $ também pode ser denotado por $ (\mathbb{R},\mathfrak{B}) $.

A seguir, demonstramos o Teorema 2.1.1 enunciado na Seção 2.1.

Teorema 2.1.1.1

Toda função $ F $ satisfazendo as propriedades básicas é uma função de distribuição acumulada de alguma variável aleatória.

Demonstração

Suponhamos que a função $ F $ satisfaça as propriedades básicas. Vamos construir uma variável aleatória $ X $ de forma que a função de distribuição acumulada $ F_X $ seja igual a $ F $, isto é, $ F_X=F $. Seja $ \mathbb{P} $ uma probabilidade definida nos borelianos da reta $ \mathfrak{B}(\mathbb{R}) $ de tal forma que $ \mathbb{P}[(-\infty,x)]=F(x) $ para qualquer $ x $ no conjunto dos números reais. Desta forma basta definirmos $ X(\omega)=\omega $ para qualquer $ \omega $ percente ao conjunto dos números reais. Assim o resultado segue, basta construirmos a probabilidade da seguinte forma

$$F_X(x) = \mathbb{P}\left(X(\omega)\leq x\right) = \mathbb{P}\left((-\infty,x]\right)=F\left(x\right),$$

$$1 - F_X(x) = 1-\mathbb{P}\left(X(\omega)\leq x\right) = \mathbb{P}\left((x,\infty)\right)=1-F\left(x\right),$$

$$F_X(b) - F_X(a) = \mathbb{P}\left(a \ < \ X\leq b\right) = \mathbb{P}\left((a,b]\right)=F\left(b\right)-F\left(a\right)$$

e definir $ \mathbb{P} $ na álgebra $ \mathcal{A} $ da forma

$$\mathbb{P}\left((a,b]\cup (c,d]\right)=F(b)-F(a)+F(d)-F(c),$$

para os intervalos $ (a,b], (c, d] $ tal que $ (a,b]\cap (c,d] = \varnothing $. Agora basta usarmos o Teorema de Extensão de Carathéodory ( que será enunciado e demonstrado abaixo para este caso). Assim, após construirmos a probabilidade, temos que $ F $ será uma função de distribuição acumulada da variável aleatória $ X $ definida acima.

Uma demonstração alternativa para o Teorema 2.1.1.1 pode ser dada da seguinte forma.

Seja $ \Omega=(0,1) $, $ \mathcal{F} $ a sigma-álgebra de borel e $ \mathbb{P} $ a medida de Lebesgue ou distribuição uniforme. Para $ \omega \in (0,1) $, considere

$$X(\omega)=\sup\lbrace (y:F(y) \ < \ \omega)\rbrace.$$

Se mostrarmos que

$$\lbrace (\omega : X(\omega)\leq x)\rbrace=\lbrace (\omega:\omega \leq F(x))\rbrace,$$

então o resultado segue imediatamente uma vez que $ \mathbb{P}(\omega:\omega\leq F(x))=F(x) $. De fato, temos que, se $ \omega\leq F(x) $ então $ X(\omega)\leq x $, uma vez que $ x \notin \lbrace y:F(y) \ < \ \omega\rbrace $. Por outro lado temos que, se $ \omega \ < \ F(x) $, então como $ F $ é continua a direita temos que existe um $ \epsilon \ > \ 0 $ tal que

$$F(x+\epsilon) \ < \ \omega \ \text{e} \ X(\omega)\geq x+\epsilon \ > \ x.$$

Assim temos que $\mathbb{P}(\lbrace \omega : X(\omega)\leq x\rbrace)=\mathbb{P}(\lbrace \omega:\omega \leq F(x)\rbrace)=F(x)$. Para demostrarmos o teorema de extensão de carathéodory vamos necessitar de alguns resultados, enunciados nos lemas a seguir.

Lema 2.1.1.1

Seja $ \mathbb{P} $ uma probabilidade definida em uma álgebra $ \mathcal{F}_0 $ de subconjuntos de $ \Omega $. Suponha que $ A_1,A_2,\cdots\in \mathcal{F}_0 $ com $ A_1\subset A_2 \subset \ldots $ com limite $ A $ e os conjuntos $ A^{\prime}_1,A^{\prime}_2,\cdots\in \mathcal{F}_0 $ com $ A^{\prime}_1\subset A^{\prime}_2 \subset \cdots $ com limite $ A^{\prime} $ (com $ A $ e $ A^{\prime} $ não necessariamente em $ \mathcal{F}_0 $). Se $ A\subset A^{\prime} $ então

$$\lim_{m\rightarrow \infty}\mathbb{P}(A_m)\leq \lim_{n\rightarrow \infty}\mathbb{P}(A^{\prime}_n).$$

Se $ A=A^{\prime} $ temos imediatamente que

$$\lim_{m\rightarrow \infty}\mathbb{P}(A_m)= \lim_{n\rightarrow \infty}\mathbb{P}(A^{\prime}_n).$$

Demonstração

Seja $ m $ fixo, então $ A_m\cap A^{\prime}_n \uparrow A_m\cap A^{\prime}=A_m $ e, portanto,

$$\mathbb{P}\left(A_m\cap A^{\prime}_n\right)\rightarrow \mathbb{P}\left(A_m\right).$$

Como $ \mathbb{P}\left(A_m\cap A^{\prime}_n\right)\leq \mathbb{P}\left(A^{\prime}_n\right) $ então

$$\mathbb{P}\left(A_m\right)=\lim_{n\rightarrow \infty}\mathbb{P}\left(A_m\cap A^{\prime}_n\right)\leq\lim_{n\rightarrow \infty}\mathbb{P}(A^{\prime}_n).$$

Assim, basta tomarmos os limite em $ m $ e teremos que

$$\lim_{m\rightarrow \infty}\mathbb{P}\left(A_m\right)\leq\lim_{n\rightarrow \infty}\mathbb{P}\left(A^{\prime}_n\right)$$

e o resultado segue.

Lema 2.1.1.2

Seja $ \mathbb{P} $ uma medida probabilidade definida em uma álgebra $ \mathcal{F}_0 $ de subconjuntos de $ \Omega $. Seja $ \mathcal{G} $ a coleção de todos os conjuntos que são limites de sequências crescentes de conjuntos de $ \mathcal{F}_0 $. Então $ \mathbb{P}^{\ast} $ definida em $ \mathcal{G} $ de tal forma que

$$\mathbb{P}^{\ast}(A)=\lim_{n\rightarrow \infty}\mathbb{P}(A_n)$$

é uma extensão de $ \mathbb{P} $ em $ \mathcal{G} $ e $ \mathbb{P}^{\ast}(B)=\mathbb{P}(B) \ \forall \ B\in \mathcal{F}_0 $. Além disso $ \mathbb{P}^{\ast} $ é uma probabilidade.

Demonstração

É imediato ver que $ \mathbb{P}^{\ast}=\mathbb{P} $ em $ \mathcal{F}_0 $. Assim basta mostramos que $ \mathbb{P}^{\ast} $ é uma probabilidade, ou seja, que

-

$ \mathbb{P}^{\ast}(\emptyset)=0 $, $ \mathbb{P}^{\ast}(\Omega)=1 $ e que $ 0\leq \mathbb{P}^{\ast}(A)\leq 1\forall A\in \mathcal{G} $.

-

Se $ G_1, G_2\in \mathcal{G} $ então $ G_1\cup G_2 $ e $ G_1\cap G_2 \in \mathcal{G} $ e ainda $ \mathbb{P}^{\ast}(G_1\cup G_2)+\mathbb{P}^{\ast}(G_1\cap G_2)=\mathbb{P}^{\ast}(G_1)+\mathbb{P}^{\ast}(G_2) $.

-

Se $ G_1,G_2\in \mathcal{G} $ então $ G_1\subset G_2 $ então $ \mathbb{P}^{\ast}(G_1)\leq \mathbb{P}^{\ast}(G_2) $.

-

Se $ G_n \in \mathcal{G} $, com $ n\in\mathbb{N} $ e $ G_n\uparrow G $ então $ G\in \mathcal{G} $ e $ \mathbb{P}^{\ast}(G_n)\rightarrow \mathbb{P}^{\ast}(G) $.

(1.) É imediato pelo fato de $ \mathbb{P}^{\ast}=\mathbb{P} $ em $ \mathcal{F}_0. $

(2.) Seja $ A_{n_1}\in \mathcal{F}_0 $ e $ A_{n_2}\in \mathcal{F}_0 $, tal que $ A_{n_1}\uparrow G_1 $ e $ A_{n_2}\uparrow G_2 $ então, como $ \mathbb{P}(A_{n_1}\cup A_{n_2})+\mathbb{P}(A_{n_1}\cap A_{n_2})=\mathbb{P}(A_{n_1})+\mathbb{P}(A_{n_2}) $, basta tomarmos o limite em $ n $ e o resultado segue.

(3.) O resultado segue imediatamente pelo Lema 2.1.1.1.

(4.) Como $ G $ é uma união enumerável de conjuntos de $ \mathcal{F_0} $ então $ G\in \mathcal{G} $. Pois para cada $ n $ podemos encontrar conjuntos $ A_{n_m}\in \mathcal{F}_0 $ com $ A_{n_m}\uparrow G_n $. Desta forma seja

$$D_m=A_1\cup A_2\cup\cdots\cup A_{n_m}.$$

Então $ D_m $ é uma sequência crescente de conjuntos de $ \mathcal{F}_0 $ e, além disso

$$A_{n_m}\subset D_m \subset G_m, \ \forall \ n\leq m. \ \text{(1)}$$

e, portanto,

$$\mathbb{P}(A_{n_m})\leq \mathbb{P}(D_m)\leq \mathbb{P}^{\ast}(G_m), \ \forall \ n \leq m. \ \text{(2)}$$

Se $ m\rightarrow \infty $, obtemos por (1) que

$$G_n\subset\displaystyle \bigcup_{m=1}^{\infty}D_m\subset G,$$

assim tomando $ n\rightarrow \infty $ concluímos que $ D_m\uparrow G $ e, portanto,

$$\mathbb{P}(D_m)\rightarrow \mathbb{P}^{\ast}(G)$$

tomando o limite em $ m $ obtemos por (2) que

$$\mathbb{P}^{\ast}(G_n)\leq\lim_{m\rightarrow \infty}\mathbb{P}(D_m)\leq \lim_{m\rightarrow\infty}\mathbb{P}^{\ast}(G_m).$$

Assim, tomando o limite em $ n $ concluímos que

$$\lim_{n\rightarrow}\mathbb{P}^{\ast}(G_n)=\lim_{m\rightarrow \infty}\mathbb{P}(D_m)=\mathbb{P}^{\ast}(G)$$

e, portanto, o resultado segue.

Lema 2.1.1.3

Seja $ \mathcal{G} $ uma classe de subconjuntos do conjunto $ \Omega $, $ \mathbb{P} $ uma probabilidade definida em $ \mathcal{G} $ tal que, $ \mathbb{P} $ e $ \mathcal{G} $ satisfaça as condições do Lema 2.1.1.2. Desta forma definimos para cada $ A\in \Omega $,

$$\mathbb{P}^{\ast}(A)=\inf\lbrace (\mathbb{P}(G):G\in\mathcal{G}, G\supset A)\rbrace.$$

Então $ \mathbb{P}^{\ast}=\mathbb{P} $ em $ \mathcal{G} $ e $ \mathbb{P}^{\ast} $ é uma probabilidade.

Demonstração

É imediato ver que $ \mathbb{P}^{\ast}=\mathbb{P} $ em $ \mathcal{G} $. Assim basta mostramos que $ \mathbb{P}^{\ast} $ é uma probabilidade, ou seja, que

-

$ \mathbb{P}^{\ast}(\emptyset)=0 $, $ \mathbb{P}^{\ast}(\Omega)=1 $ e que $ 0\leq \mathbb{P}^{\ast}(A)\leq 1 \ \forall \ A\in \Omega $.

-

$ \mathbb{P}^{\ast}(G_1\cup G_2)+\mathbb{P}^{\ast}(G_1\cap G_2)=\mathbb{P}^{\ast}(G_1)+\mathbb{P}^{\ast}(G_2) $

-

Se $ A\subset B $ então $ \mathbb{P}^{\ast}(A)\leq \mathbb{P}^{\ast}(B) $

-

Se $ A_n\uparrow A $, então $ \mathbb{P}^{\ast}(A_n)\rightarrow \mathbb{P}^{\ast}(A) $.

(1.) É imediato pelo fato de $ \mathbb{P}^{\ast}=\mathbb{P} $ em $ \mathcal{G} $.

(2.) Se $ \epsilon \ > \ 0 $, escolha $ G_1,G_2\in \mathcal{G} $, tal que $ G_1\supset A $, $ G_2\supset B $ tal que $ \mathbb{P}(G_1)\leq \mathbb{P}^{\ast}(A)+\epsilon/2 $, $ \mathbb{P}(G_2)\leq \mathbb{P}^{\ast}(B)+\epsilon/2 $ e, pelo Lema 2.1.2 temos que

$$\mathbb{P}^{\ast}(A)+\mathbb{P}^{\ast}(B)+\epsilon\geq \mathbb{P}(G_1)+\mathbb{P}(G_2)=\mathbb{P}(G_1\cup G_2)+\mathbb{P}(G_1\cap G_2)\geq \mathbb{P}^{\ast}(A\cup B)+\mathbb{P}^{\ast}(A\cap B).$$

Como $ \epsilon $ é arbitrário, temos que o resultado segue.

(3.) Segue da definição de $ \mathbb{P}^{\ast} $.

(4.) Pelo item anterior temos que $ \mathbb{P}^{\ast}(A)\geq \displaystyle \lim_{n\rightarrow \infty}\mathbb{P}^{\ast}(A_n) $. Se $ \epsilon \ > \ 0 $ para cada $ n $ podemos escolher $ G_n\in\mathcal{G} $, $ G_n\supset A $, tal que

$$\mathbb{P}(G_n)\leq \mathbb{P}^{\ast}(A_n)+\epsilon2^{-n}.$$

Agora tomemos

$$A=\displaystyle \bigcup_{n=1}^{\infty}A_n\subset \bigcup_{n=1}^{\infty}G_n\in \mathcal{G}.$$

Portanto

$$\mathbb{P}^{\ast}(A)\stackrel{item 3.}{\leq} \mathbb{P}^{\ast}\left(\bigcup_{n=1}^{\infty}G_n\right)\stackrel{item 1.}{=}\mathbb{P}\left(\bigcup_{n=1}^{\infty}G_n\right)=\lim_{n\rightarrow \infty}\mathbb{P}\left(\bigcup_{k=1}^{n}G_n\right)$$

pelo Lema 2.1.1.2(4.). Assim basta provarmos que

$$\mathbb{P}\left(\bigcup_{i=1}^{n}G_i\right)\leq \mathbb{P}^{\ast}(A_n)+\epsilon\sum_{i=1}^{n}2^{-i}.$$

Mostremos este fato por indução. Para $ n=1 $ é verdadeiro pela forma como escolhemos $ G_1 $. Suponha válido para $ n $, aplicando o Lema 2.1.1.2(2.) para o conjunto $ \bigcup_{i=1}^{n}G_i $ e $ G_{n+1} $ obtemos

$$\mathbb{P}\left(\bigcup_{i=1}^{n+1}G_i\right)=\mathbb{P}\left(\bigcup_{i=1}^{n}G_i\right)+\mathbb{P}(G_{n+1})-\mathbb{P}\left(\left(\bigcup_{i=1}^{n}G_i\right)\cap G_{n+1}\right).$$

Agora como $ \bigcup_{i=1}^{n}G_i\cap G_{n+1}\supset G_n\cap G_{n+1}\supset A_n\cap A_{n+1}=A_n $, então, utilizando a hipótese de indução, temos que

$$\mathbb{P}\left(\bigcup_{i=1}^{n+1}G_i\right)\leq \mathbb{P}^{\ast}(A_n)+\epsilon\sum_{i=1}^{n}2^{-i}+\mathbb{P}^{\ast}(A_{n+1})+\epsilon 2^{-(n+1)}-\mathbb{P}^{\ast}(A_n)\leq \mathbb{P}^{\ast}(A_{n+1})+\epsilon\sum_{i=1}^{n+1}2^{-i}$$

portanto, o resultado segue.

Lema 2.1.1.4

Sobre as hipóteses do Lema 2.1.1.2 com $ \mathbb{P} $ definida no Lema 2.1.1.3. Seja $ \mathcal{H}=\lbrace H\subset \Omega : \mathbb{P}(H)+\mathbb{P}(H^c)\leq 1\rbrace $ então $ \mathcal{H} $ é uma $ \sigma $-álgebra e $ \mathbb{P} $ é uma probabilidade em $ \mathcal{H} $.

Teorema 2.1.2 (Teorema de Extensão de Carathéodory)

Seja $ \mathbb{P} $ uma medida probabilidade definida em uma álgebra $ \mathcal{F}_0 $ de subconjuntos de $ \Omega $. Então $ \mathbb{P} $ tem uma única extensão para a menor $ \sigma $-álgebra ($ \mathcal{F} $) gerada por $ \mathcal{F}_0 $.

Demonstração

Como $ \mathbb{P} $ é uma medida finita, segue imediatamente dos lemas anteriores que $ \mathbb{P} $ pode ser estendido para $ \sigma(\mathcal{F}_0) $.

2.2 - Variável aleatória discreta

Definição 2.2.1

Seja $ X $ uma variável aleatória (v.a.). Se o número de valores possíveis de $ X $ for enumerável (finito ou infinito), dizemos que $ X $ é uma variável aleatória discreta. Isto é, os possíveis valores de $ X $ podem ser postos em lista como $ x_1,x_2,\ldots $. No caso finito, a lista possui um valor final $ x_n $, e no caso infinito, a lista continua indefinidamente.

Exemplo 2.2.1

Suponha que, após um exame médico, pessoas sejam diagnosticadas como tendo diabetes (D) e não tendo diabetes (N). Admita que três pessoas sejam escolhidas ao acaso e classificadas de acordo com esse esquema.

O espaço amostral é dado por

$ \Omega=(DDD, DDN, DND, NDD, NND, NDN, DNN, NNN) $

Nosso interesse é saber quantas pessoas com diabetes foram encontradas, não interessando a ordem em que tenham sido selecionadas. Isto é, desejamos estudar a variável aleatória $ X $, a qual atribui a cada resultado $ \omega \in \Omega $ o número de pessoas com diabetes. Consequentemente, o conjunto dos possíveis valores de $ X $ é $ (0, 1, 2, 3) $, ou seja, $ X $ é uma variável aleatória discreta.

Definição 2.2.2

Seja $ X $ uma variável aleatória discreta. A cada possível resultado $ x_i $ associaremos um número $ p(x_i) = \mathbb{P}\left(X = x_i\right) $, denominado probabilidade de $ x_i $. Os números $ p(x_i) $, $ i = 1, 2, \ldots $ devem satisfazer as seguintes condições:

-

$ p(x_i) \geq 0 $ para todo $ i $;

-

$ \displaystyle \sum_{i=1}^\infty p(x_i)=1 $.

A função $ p $ é denominada função de probabilidade da variável aleatória $ X $.

Definição 2.2.3

A coleção de pares $ (x_i, p(x_i)) $; $ i = 1, 2, \ldots $ é algumas vezes denominada distribuição de probabilidade de $ X $. Assim, podemos falar que a distribuição de probabilidades de uma variável aleatória discreta $ X $, definida em um espaço amostral $ \Omega $, é uma tabela que associa a cada valor de $ X $ sua probabilidade.

Exemplo 2.2.2

Considere que uma moeda é lançada duas vezes. Seja $ X $ a função definida no espaço amostral que é igual ao número de caras nos dois lançamentos ($ C $ - Cara e $ K $ - Coroa).

Temos na Tabela a seguir a distribuição de probabilidade referente a variável aleatória X.

| Valores de X | Pontos amostrais | Probabilidade |

|---|---|---|

| 0 | KK | 1/4 |

| 1 | KC, CK | 1/2 |

| 2 | CC | 1/4 |

Tabela 8.2.1: Valores das probabilidades

Os valores das probabilidades, na tabela acima, são obtidos da seguinte maneira:

$$\mathbb{P}\left(X=0\right) = \mathbb{P}((KK)) = \frac{1}{4}.$$

$$\mathbb{P}\left(X=1\right) = \mathbb{P}((CK)) + \mathbb{P}((KC)) = \frac{1}{2}.$$

$$\mathbb{P}\left(X=2\right) = \mathbb{P}((CC)) = \frac{1}{4}.$$

Definição 2.2.4

O quantil $ q100\char37 $ ($ 0 \leq q \leq 1 $) de uma variável aleatória discreta $ X $ é o menor valor de $ x $ para o qual

$$F(x)=\mathbb{P}(X\leq x)\geq q.$$

Já o percentil $ p100\char37 $ de um valor $ x $ é o valor da distribuição acumulada em $ x $, ou seja,

$$p=F(x)=\mathbb{P}(X\leq x).$$

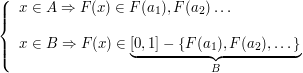

Relação entre a função de distribuição acumulada e a distribuição de probabilidade discreta

Seja $ X $ uma variável aleatória discreta cuja distribuição de probabilidade associa aos valores $ x_1,x_2,\ldots $ as respectivas probabilidades $ \mathbb{P}(X=x_1),\mathbb{P}(X=x_2),\ldots $.

Como os valores de $ X $ são mutuamente exclusivos, temos que a função de distribuição acumulada é dada por

$$F(x)=\sum_{i\in A_x}\mathbb{P}(X=x_i), \ \text{com} \ A_x=(i: x_i\leq x).$$

Assim, dada a distribuição de probabilidade de uma variável aleatória discreta, conseguimos determinar sua função de distribuição acumulada, ou ainda, dada a função de distribuição acumulada, podemos determinar a sua distribuição de probabilidade.

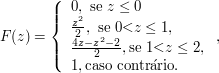

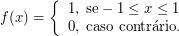

Exemplo 2.2.3

Considere dois lançamentos independentes de uma moeda equilibrada. Com o espaço de probabilidade usual, defina $ X $ como sendo o número de caras nos dois lançamentos. Determine a função de distribuição acumulada de $ X $.

A variável $ X $ é discreta e sua distribuição de probabilidade será dada por

| $ x_i $ | $ 0 $ | $ 1 $ | $ 2 $ |

|---|---|---|---|

| $ P(X = x_i) $ | $ \frac{1}{4} $ | $ \frac{1}{2} $ | $ \frac{1}{4} $ |

Tabela 8.2.2: Distribuição de probabilidade

A função de distribuição acumulada correspondente será:

$$F(x) = \begin{cases} 0, \ \hbox{se} \ x \ < \ 0; \cr 1/4, \ \hbox{se} \ 0 \leq x \ < \ 1;\cr 3/4, \ \hbox{se} \ 1 \leq x \ < \ 2;\cr 1, \ \hbox{se} \ x \geq 2.\cr \end{cases}$$

Figura 8.2.2: Função de Distribuição Acumulada

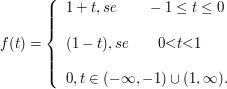

2.3 - Variável aleatória contínua

Definição 2.3.1

Seja $ X $ uma variável aleatória. Suponha que o contradomínio ($ \mathbb{R}_x $) de $ X $ seja um intervalo ou uma coleção de intervalos. Então diremos que $ X $ é uma variável aleatória contínua.

Os exemplos abaixo ajudam a ilustrar esse conceito.

Exemplo 2.3.1

Uma válvula eletrônica é instalada em um circuito, seja $ X $ o período de tempo em a válvula funciona.

Neste caso, $ X $ é uma variável aleatória contínua podendo tomar valores nos reais positivos, ou seja, o subconjunto dos números reais $ [0,\infty) $.

Exemplo 2.3.2

Um navio petroleiro sofre um acidente no qual seu casco é rompido e o óleo é derramado. Seja $ Y $ a variável aleatória que determina a área atingida pelo óleo do navio.

Neste caso, temos que a variável $ Y $ é uma variável continua a qual também assume valores em no subconjunto dos números reais $ [0,\infty) $.

Definição 2.3.2

Dizemos que $ X $ é uma variável aleatória absolutamente contínua se existe uma função $ f_X:\mathbb{R}\rightarrow[0,+\infty) $ denominada função densidade de probabilidade e abreviada por f.d.p, que satisfaz às seguintes propriedades:

-

$ f(x)\geq 0 $, para todo $ x \in\mathbb{R}_x $

-

$ \displaystyle\int_{-\infty}^\infty f(x)dx=1 $

Além disso, definimos para qualquer $ c, d \in \mathbb{R}_x $, com $ c \ < \ d $ que

$$\mathbb{P}(c \ < \ X \ < \ d)=\int_c^d f(x)dx.$$

Vale a pena notar que, da forma como a probabilidade foi definida, a probabilidade de um ponto isolado é sempre zero, ou seja, $ \mathbb{P}(X=c)=\displaystyle \int_{c}^{c} f(x)dx=0 $. Desta forma, podemos concluir que, quando $ X $ é uma variável aleatória contínua, a probabilidade de ocorrer um valor especifico é zero.

Observação

Se $ X $ é uma variável aleatória absolutamente contínua, então

$$\frac{\partial }{\partial x}F_X(x)=f_X(x)$$

Exemplo 2.3.3

Suponha que escolhamos um número ao acaso no intervalo $ [0,1] $. Qual a probabilidade de escolhermos o número $ 0,54 $?

É zero justamente pelo que foi dito acima, todo ponto isolado em uma variável continua tem probabilidade zero.

Exemplo 2.3.4

Seja $ A=\lbrace (x: -1 \ < \ x \ < \ 5)\rbrace $ e seja $ X $ uma variável aleatória tal que sua função densidade de probabilidade seja $ f(x) $ definida abaixo, com $ c $ sendo uma constante. Qual deve ser o valor da constante $ c $?

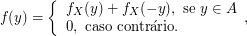

$$f(x) = \begin{cases} c, \ \hbox{se} \ x \ \in \ A; \cr 0, \ \hbox{caso contrário}.\end{cases}$$

Como $ f $ é uma função densidade de probabilidade ela deve satisfazer a condição que

$$\int_{- \infty}^{\infty}f(x)dx=1 \Rightarrow \int_{-1}^{5}c dx = c \cdot (5-(-1))=6c=1 \Rightarrow c=\frac{1}{6}.$$

Exemplo 2.3.5

Consideremos uma variável aleatória $ X $ com densidade abaixo:

$$f(x) = \begin{cases} c(x^2+x), \ \hbox{se} \ 0\leq x \leq 1; \cr 0, \ \hbox{caso contrário}.\end{cases}$$

Determine o valor de c.

Para isto basta integrarmos a função f(x) em todo o seu domínio, lembrando que esta integral deve ter valor 1. Assim

$$\int_{-\infty}^{\infty} f(x)=1 \Rightarrow \int_{0}^{1}c[x^2 + x]=c \int_{0}^{1}x^2+x=c\left[\frac{x^3}{3}+\frac{x^2}{2} \right]^{1}_{0}=c\left(\frac{1}{3}+\frac{1}{2} \right)=\frac{5c}{6}=1 \Rightarrow c=\frac{6}{5}.$$

Exemplo 2.3.6

Seja $ X $ uma variável contínua com f.d.p.

$$f(x) = \begin{cases} 2x, \ 0 \ < \ x \ < \ 1; \cr 0, \ \hbox{para quaisquer outros valores}.\cr \end{cases}$$

Portanto, a função de distribuição acumulada é dada por

$$F(x) = \begin{cases} 0, \ \hbox{se} \ x \leq 0;\cr \int_{0}^{x}2s~ds = x^2, \ \hbox{se} \ 0 \ < \ x \ \leq 1;\cr 1, \ \hbox{se} \ x \ > \ 1. \end{cases}$$

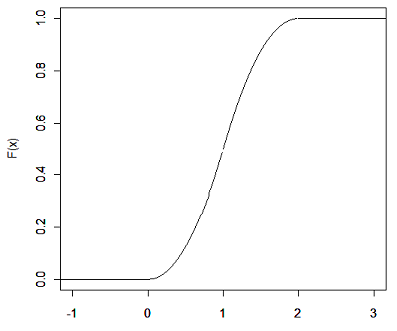

Exemplo 2.3.7

Suponha que o Lucro Líquido ($ LL $) de uma empresa para o ano futuro esteja entre $ a = 12.000 $ e $ b = 20.000 $. Além disso, temos informações suficientes para supor que o $ LL $ esteja concentrado em torno do valor médio do intervalo, isto é, em torno de $ (a+b)/2 = 16.000. $ Com isso, podemos modelar a distribuição de $ LL $ via uma forma triangular, como na Figura a seguir.

Figura 8.2.3: Distribuição de $LL$ na forma triangular

Observe que a função de distribuição de probabilidade é construída de forma que a área total abaixo da curva é igual a 1, note também que ela está concentrada em torno do ponto médio do intervalo (16.000) e se distribui linearmente do ponto médio aos extremos do intervalo. De forma geral, a função distribuição de probabilidade de uma distribuição triangular é dada por:

$$f(x)=\begin{cases} \frac{x-a}{\frac{b-a}{2}^2}; \ \hbox{para todo} \ a \leq x \leq\frac{a+b}{2}\cr \frac{b-x}{\frac{b-a}{2}^2}; \ \hbox{para todo} \ \frac{a+b}{2}\leq x\leq b\cr 0; \ \hbox{para os demais pontos} \ \end{cases}$$

Exemplo 2.3.8

Seja $ X:\Omega\rightarrow \mathbb{R} $ uma variável aleatória absolutamente contínua com função distribuição de probabilidade (f.d.p.) dada por

$$f_X(x)=\frac{1}{\sqrt{2~\pi}}~e^{\frac{-x^2}{2}}, \ \infty \ < \ x \ < \ \infty.$$

Neste caso, dizemos que $ X $ tem distribuição Normal.

Resolução

Para que $ f_X $ seja uma f.d.p, basta mostrarmos que

$$\int^{\infty}_{-\infty}f_X(s)ds=1.$$

Então, tomamos

$$\left[\int^{\infty}_{-\infty} f_X(s)ds \right]^2 = \int^{\infty}_{-\infty} f_X(x)dx \int^{\infty}_{-\infty} f_X(s)ds \overset{\text{Teo Fubinni}}{=} \frac{2}{2~\pi} \int^{\infty}_{0} \int^{\infty}_{0} e^{\frac{x^2+y^2}{2}}dx~dy$$

e, a partir da mudança de variáveis $ x = r\cos\theta $ e $ y = r\text{sen}\theta $, temos que

$$\left[\int^{\infty}_{-\infty}f_X(s)ds\right]^2=\frac{1}{\pi}\int^{\infty}_{0}\int^{\pi}_{0}e^{-\frac{r^2}{2}}r~d\theta~dr=\frac{1}{\pi}\int^{\infty}_{0}\left[e^{-\frac{r^2}{2}}r~\theta~\right]^{\pi}_{0} dr\overset{(**)}{=}\int^{\infty}_{0}e^{-u}du=1.$$

Exemplo 2.3.9

Seja X uma variável aleatória com densidade

$$f(x)=\begin{cases} \displaystyle cx^2, \text { se } -1\leq x\leq 1\cr \cr 0, \text{ caso contrário } \end{cases}$$

(a) Determine o valor da constante c.

$$1=\int_{-\infty}^\infty f(x)dx=\int_{-1}^1 cx^2dx=c\frac{x^3}{3}\bigg|_{-1}^1= c\frac{2}{3}\Rightarrow c=\frac{3}{2}$$

(b) Ache o valor $ \alpha $ tal que $ F_X(\alpha)=\frac{1}{4} $.($ \alpha $ é o primeiro quartil da distribuição de X.)

$$\frac{1}{4}=F_X(\alpha)=\int_{-\infty}^\alpha f(x)dx=\int_{-1}^\alpha \frac{3}{2}x^2 dx=\frac{x^3}{2}\bigg|_{-1}^\alpha=\frac{\alpha^3}{2}+\frac{1}{2}\Rightarrow \frac{\alpha^3}{2}=-\frac{1}{4}\Rightarrow \alpha=-\frac{1}{\sqrt[3]{2}}.$$

Exemplo 2.3.10

Uma variável aleatória X tem função de distribuição

$$F(x)=\begin{cases} \displaystyle 1, \text { se } x> 1 \cr x^3, \text{ se } 0\leq x\leq 1\cr 0\text{ se } x< 0. \end{cases}$$

Qual é a densidade de X?

$$f(x)=\frac{dF(x)}{dx}$$

quando F for diferenciável em $ x $ então

$$f(x)=\begin{cases} \displaystyle 3x^2, \text { se } 0\leq x\leq 1\cr \cr 0, \text{ caso contrário } \end{cases}$$

Exemplo 2.3.11

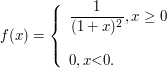

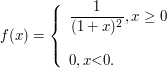

Seja X uma variável aleatória com densidade

$$f(x)=\begin{cases} \displaystyle \frac{1}{(1+x)^2}, \text { se } x> 1\cr \cr 0, \text{ caso contrário } \end{cases}$$

Seja $ Y=\max (X,c) $, no qual $ c $ é uma constante $ c > 0 $.

(a) Ache a função de distribuição de Y.

Vamos dividir em três etapas primeiramente

(a1) $ y< c $ isso implica que $ \mathbb{P}(Y\leq y)=0 $

(a2) $ y=c $ o que implica que

$$\mathbb{P}(Y\leq y)=\mathbb{P}(X\leq c)=\int_0^c \frac{1}{(1+x)^2}dx=-\frac{1}{1+x}\bigg|_0^c=1-\frac{1}{1+c}=\frac{c}{1+c}$$

(a3) $ y> 0 $ o que implica que

$$\mathbb{P}(Y\leq y)=\mathbb{P}(Y< y)=\int_0^y \frac{1}{(1+x)^2}dx=-\frac{1}{1+x}\bigg|_0^y=\frac{y}{1+y}$$

Assim,

$$F_Y(y)=\begin{cases} \displaystyle 0, \text { se } y> c\cr \cr \frac{y}{(1+y)}, y\geq c \end{cases}$$

(b) Decomponha $ F_Y $ em suas partes discreta, absolutamente contínua e singular.

(b1) Parte discreta $ F_{Y_d} $, temos que

$$\mathbb{P}(Y_d\leq y)=F_Y(y)-F_Y(y^-)=\begin{cases} \displaystyle 0, \text { se } y\neq c\cr \cr \frac{c}{(1+c)}, y=c \end{cases}$$

(b2) $ F_{Y_{ab}} $ tal que

$$F_{Y_{ab}}=\int_{-\infty}^y f_Y(x) dx,$$

$$f_Y(y)=\frac{dF_y}{dy}=\begin{cases} \displaystyle 0, \text { se } y\leq c\cr \cr \frac{1}{(1+y)^2}, y> c \end{cases}$$

então

$$F_{Y_{ab}}(y)=\begin{cases} \displaystyle 0, \text { se } y\leq c\cr \cr \displaystyle \displaystyle\int_c^y \frac{1}{(1+y)^2}dy=\frac{y}{1+y}-\frac{c}{1+c}, y\geq c \end{cases}$$

(b3) Agora como $ F_Y(y)=F_{Y_d}(y)+F_{Y_{ab}}(y)+F_{Y_s}(y), \forall y \in \mathbb{R} $, temos

$$F_{Y_s}(y)=F_Y(y)-F_{Y_d}(y)-F_{Y_{ab}}(y)=\begin{cases} \displaystyle 0, \text { se } y< c\cr \cr \frac{c}{1+c}-\frac{c}{1+c}=0, y= c \cr \frac{y}{1+y}-\frac{c}{1+c}-\left(\frac{y}{1+y}-\frac{c}{1+c}\right)=0, y> c \end{cases}$$

então $ F_{Y_s}(y)=0, \forall y\in \mathbb{R} $.

Exemplo 2.3.12

Determine a densidade de $ Y=(b-a)X+a $, no qual $ X\sim U[0,1] $. É a densidade da distribuição uniforme em $ [a,b] $, e escrevemos $ Y\sim U[a,b] $. Faça o gráfico da função de distribuição de Y.

Agora

$$X\sim U[0,1]\Rightarrow \mathbb{P}(X\leq x)=\begin{cases} \displaystyle 0, \text { se } x> 0 \cr \cr x, \text{ se } 0\leq x< 1 \cr 1, x \geq 1.\end{cases}$$

Agora $ Y=(b-a)X+a $, então

$$\mathbb{P}(Y\leq y)=\mathbb{P}((b-a)X+a\leq y)=\mathbb{P}\left(X\leq \frac{y-a}{(b-a)}\right)=\begin{cases} \displaystyle 0, \text { se } y< a \cr \frac{y-a}{b-a}, \text{ se } a\leq y< b \cr 1, y \geq b.\end{cases}$$

e então

$$f_Y(y)=\begin{cases} \displaystyle 0, \text { se } y> a \cr \cr \frac{1}{b-a}, \text{ se } a\leq y< b \cr 0, y \geq b.\end{cases}$$

Exemplo 2.3.13

Se X tem densidade $ f(x)= \frac{e^{-|x|}}{2} $, $ -\infty< x< \infty $, qual a distribuição de $ Y=|X| $?

$$\mathbb{P}(Y\leq y)=\mathbb{P}(|X|< y)=\mathbb{P}(-y\leq X \leq y)=\int_{-y}^y \frac{e^{-|x|}}{2}dx=\int_0^y e^{-x}dx=-e^{-x}\bigg|_0^y=1-e^{-y}$$

Então temos que $ Y\sim \hbox{Exp}(1) $.

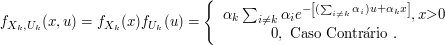

2.4 - Vetores Aleatórios

Nesta seção, vamos introduzir o conceito de vetor aleatório e estudar suas principais características. Por facilidade de notação, vamos considerar apenas vetores bidimensionais. Assim, dizemos que o par ordenado $ (X,Y) $ é um vetor aleatório se seus componentes $ X $ e $ Y $ são variáveis aleatórias.

Exemplo 2.4.1

Considere o experimento de selecionar um ponto ao acaso no quadrado unitário

$$\mathcal{R}=(0 \ < \ x \ < \ 1 \ \text{e} \ 0 \ < \ y \ < \ 1).$$

Denotamos por $ X $ e $ Y $ a primeira e a segunda coordenada do ponto selecionado, respectivamente. Com isso, temos um vetor $ (X,Y) $ que corresponde ao ponto selecionado.

Neste contexto, definimos para duas variáveis aleatórias $ X $ e $ Y $ a função de distribuição acumulada conjunta da seguinte forma:

Definição 2.4.1

a) Um vetor $ Z=(X,Y) $ cujos componentes $ X $ e $ Y $ são variáveis aleatórias é denominado vetor aleatório.

b) A função de distribuição acumulada de $ Z $ é definida como sendo uma função $ F_Z=F_{X,Y}: \mathbb{R}^2 \rightarrow [0,1] $ tal que

$$F_{X,Y}(x,y) = \mathbb{P}\left((X \leq x) \cap (Y \leq y)\right) = \mathbb{P}\left(X \leq x , Y \leq y\right); \ \forall(x,y) \ \in \mathbb{R}^2.$$

A distribuição acumulada de $ X $ pode ser obtida a partir da distribuição acumulada de $ Z $ da seguinte forma:

$$F_{X}(a) = \mathbb{P}(X \leq a)=\mathbb{P}(X \leq a, Y < \infty) = \mathbb{P}(\lim_{b\to \infty}(X\leq a,Y \leq b))=\lim_{b\to \infty}\mathbb{P}(X \leq a, Y \leq b)$$

de onde concluímos que

$$F_X(a) = \lim_{b \to \infty}F(a,b).$$

Analogamente, podemos obter a distribuição marginal de $ Y $.

Propriedades da função de distribuição acumulada

P1. A função de distribuição acumulada $ F_Z $ é não decrescente em cada variável, isto é, se $ x_1 \leq x_2 $, então

$$F_Z(x_1,y) \leq F_Z(x_2,y) \ \forall \ y \in \mathbb{R}$$

P2. $ F_Z $ é contínua à direita e tem limite à esquerda em cada variável, isto é, se $ x_n \downarrow x $ então

$$F_X(x_n,y) \downarrow F_X(x,y) \ \forall \ y \in \mathbb{R}.$$

P3. Temos que

$$\lim_{x \rightarrow -\infty}F_Z(x,y)=0.$$

Dado uma função $ g:\mathbb{R}^2\rightarrow \mathbb{R} $ uma função qualquer, o operador diferença é definido por

$$\Delta_{a_1,b_1} g(x,y)=g(b_1,y)-g(a_1,y) \quad \text{e} \quad \Delta_{a_2,b_2} g(x,y)=g(x,b_2)-g(x,a_2),$$

no qual $ -\infty < a_i< b_i< \infty $ para $ i=1,2 $. Assim, temos que

$$\Delta_{a_1,b_1}\Delta_{a_2,b_2}g(x,y)=\Delta_{a_1,b_1}\left[g(x,b_2)-g(x,a_1)\right]=g(b_1,b_2)-g(a_1,b_2)-g(b_2,a_1)+g(a_1,a_2).$$

Com isso, temos a seguinte propriedade.

P4. Temos que $ \Delta_{a_1,b_1}\Delta_{a_2,b_2}F(x,y) \geq 1. $

Essa quarta propriedade é de fundamental importância, pois sem ela podemos encontrar uma função que satisfaz P1,P2 e P3 porém apresenta probabilidade negativa como podemos ver no exemplo abaixo. Esta propriedade vale para cada componente do vetor.

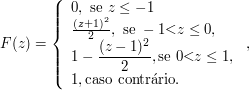

Exemplo 2.4.2

Seja $ \mathbb{R}^2\rightarrow \mathbb{R} $ que satisfaz P1, P2, P3 defina da seguinte forma

$$F(x,y)=\begin{cases} 1, \quad x\geq 0, \quad y\geq 0 \text{ e } x+y\geq 1\cr0, \quad c.c \end{cases}$$

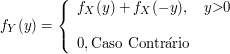

Figura 8.2.4: Função de Distribuição

A região em vermelho representa $ F(x,y)=0 $. Note que F satisfaz as três propriedades, porém não é uma função de distribuição, pois

$$0\leq \mathbb{P}[0< X\leq 1,0< Y \leq 1]=\mathbb{P}[X\leq 1, 0< Y\leq 1]-\mathbb{P}[X\leq 0,0< Y\leq 1]=$$

$$\mathbb{P}[X\leq 1, Y\leq 1]-\mathbb{P}[X\leq 1, Y\leq 0]-\mathbb{P}(X\leq 0,Y\leq 1)+\mathbb{P}[X\leq 0,Y\leq 0]=$$

$$F(1,1)-F(1,0)-F(0,1)+F(0,0)=1-1-1+0=-1$$

o que é um absurdo.

Teorema 2.4.1

Dado uma função $ F $ satisfazendo as propriedades P1, P2, P3 e P4, então existe um vetor aleatório $ (X_1,X_2) $ em $ (\mathbb{R}^2,\mathfrak{B}(\mathbb{R}^2),\mathbb{P}) $ tal que

$$\mathbb{P}(X_1\leq x_1, X_2\leq x_2)=F(x_1,x_2)$$

ou seja, P1, P2, P3 e P4 são suficientes para caracterizar uma função de distribuição

Demonstração: Esse teorema pode ser visto em sua forma geral em distribuição de probabilidade no $ \mathbb{R}^n $.

Dizemos que um vetor aleatório $ Z=(X,Y) $ é discreto se as variáveis aleatórias $ X $ e $ Y $ são discretas.

Definição 2.4.2

Se $ Z=(X,Y) $ é um vetor aleatório discreto, definimos a função de probabilidade conjunta de X e Y por

$$p(x,y)=\mathbb{P}(X=x,Y=y).$$

A função de probabilidade marginal de $ X $ pode ser obtida de $ p(x,y) $ por

$$p_X(x)=\mathbb{P}(X=x)=\sum_{y} p(x,y).$$

E, similarmente, a função de probabilidade marginal de $ Y $ pode ser obtida de $ p(x,y) $ por

$$p_Y(y)=\mathbb{P}(Y=y)=\sum_{x} p(x,y).$$

Exemplo 2.4.3

Considere uma urna contendo $ 3 $ bolas vermelhas, $ 4 $ brancas e $ 5 $ azuis de onde são selecionadas $ 3 $ bolas ao acaso e sem reposição. Se $ X $ e $ Y $ denotam, respectivamente, o número de bolas vermelhas e brancas escolhidas, então a função de probabilidade conjunta de $ X $ e $ Y $, $ p(i,j) = \mathbb{P}(X=i,Y=j) $, é dada por

$$p(0,0)=\left(\begin{array}{c}5\cr3\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{10}{220}$$

$$p(0,1)=\left(\begin{array}{c}4\cr1\end{array}\right)\left(\begin{array}{c}5\cr2\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{40}{220}$$

$$p(0,2)=\left(\begin{array}{c}4\cr2\end{array}\right)\left(\begin{array}{c}5\cr1\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{30}{220}$$

$$p(0,3)=\left(\begin{array}{c}4\cr3\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{4}{220}$$

$$p(1,0)=\left(\begin{array}{c}3\cr1\end{array}\right)\left(\begin{array}{c}5\cr2\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{30}{220}$$

$$p(1,1)=\left(\begin{array}{c}3\cr1\end{array}\right)\left(\begin{array}{c}4\cr1\end{array}\right)\left(\begin{array}{c}5\cr1\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{60}{220}$$

$$p(1,2)=\left(\begin{array}{c}3\cr1\end{array}\right)\left(\begin{array}{c}4\cr2\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{18}{220}$$

$$p(2,0)=\left(\begin{array}{c}3\cr2\end{array}\right)\left(\begin{array}{c}5\cr1\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{15}{220}$$

$$p(2,1)=\left(\begin{array}{c}3\cr2\end{array}\right)\left(\begin{array}{c}4\cr1\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{12}{220}$$

$$p(3,0)=\left(\begin{array}{c}3\cr3\end{array}\right)/\left(\begin{array}{c}12\cr3\end{array}\right)=\frac{1}{220}$$

Estas probabilidades podem ser expressas em forma de tabela, como mostrado abaixo. Observe que a função de probabilidade de $ X $ é obtida ao calcularmos as somas das linhas, enquanto que a função de probabilidade de $ Y $ é obtida ao calcularmos as somas das colunas. Como as funções de probabilidades individuais de $ X $ e $ Y $ aparecem na margem da tabela, são chamadas de funções de probabilidades marginais de $ X $ e $ Y $ respectivamente.

| $i$ \ $j$ | 0 | 1 | 2 | 3 | $ \mathbb{P}(X=i) $ |

|---|---|---|---|---|---|

| 0 | $ \frac{10}{220} $ | $ \frac{40}{220} $ | $ \frac{30}{220} $ | $ \frac{4}{220} $ | $ \frac{84}{220} $ |

| 1 | $ \frac{30}{220} $ | $ \frac{60}{220} $ | $ \frac{18}{220} $ | 0 | $ \frac{108}{220} $ |

| 2 | $ \frac{15}{220} $ | $ \frac{12}{220} $ | 0 | 0 | $ \frac{27}{220} $ |

| 3 | $ \frac{1}{220} $ | 0 | 0 | 0 | $ \frac{1}{220} $ |

| $ \mathbb{P}(Y=j) $ | $ \frac{56}{220} $ | $ \frac{112}{220} $ | $ \frac{48}{220} $ | $ \frac{4}{220} $ |

Tabela 8.2.3: Funções marginais calculadas

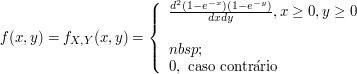

Definição 2.4.3

Dizemos que $ X $ e $ Y $ são conjuntamente contínuas se existe uma função $ f(x,y) $ definida para todos reais $ x $ e $ y $, tal que

$$\mathbb{P}\left((X,Y)\in (a_1 , b_1) \times (a_2 , b_2)\right)=\int_{a_2}^{b_2}\int_{a_1}^{b_1} f(x,y)dxdy.$$

para todo $ -\infty \ < \ a_i \ < \ b_i \ < \ \infty $ com $ i=1,2 $. A função $ f(x,y) $ é denominada função densidade de probabilidade conjunta de $ X $ e $ Y $.

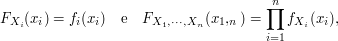

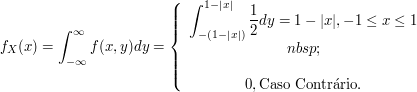

Se $ X $ e $ Y $ são conjuntamente contínuas, então elas são individualmente contínuas e suas funções densidades de probabilidade podem ser obtidas da seguinte forma

$$\mathbb{P}\left(X\in A\right)=\mathbb{P}\left(X\in A,Y\in(-\infty,\infty)\right)=\int_A\int_{-\infty}^{\infty} f(x,y) dydx=\int_A f_X(x)dx$$

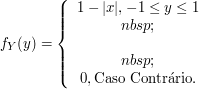

em que $ f_X(x)=\displaystyle \int_{-\infty}^{\infty} f(x,y)dy $ é a função densidade de probabilidade de $ X $. Similarmente, a função densidade de probabilidade de $ Y $ é dada por

$$f_Y(y)=\int_{-\infty}^{\infty} f(x,y)dx$$

Exemplo 2.4.3

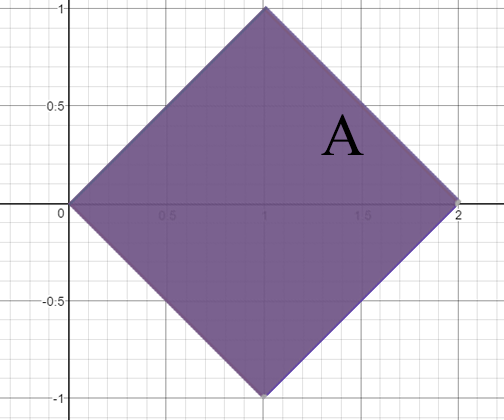

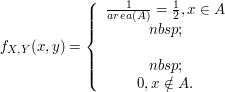

A função densidade conjunta de $ X $ e $ Y $ é dada por

$$f(x,y)=\begin{cases} 2e^{-x}e^{-2y} \ \hbox{se} \ 0 \ < \ x \ < \ \infty, \ 0 \ < \ y \ < \ \infty\cr 0 \ \hbox{caso contrário}\end{cases}$$

Calcule

(a) $ \mathbb{P}\left(X \ > \ 1, Y \ < \ 1\right) $, (b) $ \mathbb{P}\left(X \ < \ Y\right) $ e (c) $ \mathbb{P}\left(X \ < \ a\right) $.

(a) Temos que

$$\mathbb{P}\left(X \ > \ 1, Y \ < \ 1\right)=\int_0^1\int_1^{\infty} 2e^{-x}e^{-2y}dxdy = e^{-1}(1-e^{-2}).$$

(b) Temos que

$$\mathbb{P}\left(X \ < \ Y\right)=\int\int_{\lbrace (x,y):x \ < \ y\rbrace}2e^{-x}e^{-2y}dxdy=\int_{0}^{\infty}\int_0^y 2e^{-x}e^{-2y}dxdy=\int_0^\infty 2e^{-3y}(e^y-1)dy=\frac{1}{3}.$$

(c) Temos que

$$\mathbb{P}\left(X \ < \ a\right)=\int_0^a\int_0^{\infty}2e^{-2y}e^{-x}dydx=1-e^{-a}.$$

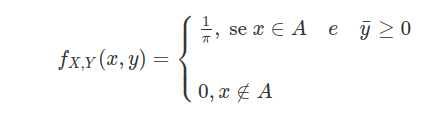

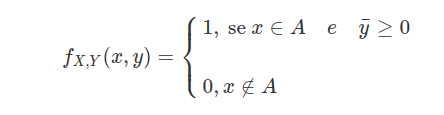

Exemplo 2.4.4

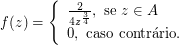

Seja $ A \lbrace (x,y)\in \mathbb{R}^2 | 1\leq x \leq 3; 1\leq y \leq 5 \rbrace $. Consideremos o vetor aleatório $ (X,Y) $ tal que sua função densidade de probabilidade é definida abaixo.

$$f(x) = \begin{cases} c, \ \hbox{se} \ x \ \in \ A; \cr 0, \ \hbox{caso contrário}.\end{cases}$$

Determine o valor de $ c $ e encontre as distribuições marginais de $ X $ e $ Y $.

Como a função densidade de probabilidade integrada em todo seu domínio deve ter valor igual a 1, temos que

$$\int^{-\infty}_{\infty} \int^{-\infty}_{\infty}f(x,y)dx dy = \int^{3}_{1} \int^{5}_{1}c dx dy = c \int^{3}_{1} \int^{5}_{1}1 dx dy =c \int^{3}_{1}4 dy=8c=1 \Rightarrow c=\frac{1}{8}.$$

Agora para encontrar a fdp marginal de $ X $, basta integramos a densidade conjunta em todo seu domínio de $ Y $, ou seja,

$$f_X(x)= \displaystyle \int_{-\infty}^{\infty}f(x,y)dy = \int_{1}^{5}\frac{1}{8} = \frac{4}{8}=\frac{1}{2}.$$

Assim a distribuição marginal de $ X $ é

$$f(x) = \begin{cases} \frac{1}{2}, \ \hbox{se} \ 1\leq x \leq 3; \cr 0, \ \hbox{caso contrário}.\end{cases}$$

Calculemos agora a marginal de $Y$

$$f_Y(y)= \int_{-\infty}^{\infty}f(x,y)dx = \int_{1}^{3}\frac{1}{8} = \frac{2}{8}=\frac{1}{4}.$$

Portanto a marginal de Y é dada por

$$f(y) = \begin{cases} \frac{1}{4}, \ \hbox{se} \ 1\leq y \leq 5; \cr 0, \ \hbox{caso contrário}.\end{cases}$$

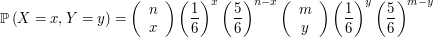

Exemplo 2.4.5

Suponha que uma urna contenha $ 6 $ bolas enumeradas $ 1,2,3,4,5 $ e $ 6 $. Duas bolas são retiradas ao acaso e sem reposição. Seja $ X $ o número da primeira bola e $ Y $ o da segunda bola. Qual a distribuição conjunta de $ X $ e $ Y $?

Note que, como as bolas são retiradas sem reposição, então não existe a possibilidade de retirarmos bolas iguais, ou seja, com a mesma numeração em ambas as retiradas, portanto $ \mathbb{P}(X=i,Y=i)=0 $. Além disso, como as bolas são retiradas ao acaso temos que não existe preferência por nenhuma das bolas. Assim $ \mathbb{P}(X=i,Y=j) $ para $ i\neq j $ é dada por

$$\mathbb{P}(X=i,Y=j)=\mathbb{P}(Y = j|X=i)\mathbb{P}(X=i) = \frac{1}{5}\cdot \frac{1}{6}=\frac{1}{30}.$$

Exemplo 2.4.6

(a) Demonstre que a função

$$F(x,y)=\begin{cases} 1-e^{-x-y}, \text{ se } x\geq 0 \quad e \quad y\geq 0 \cr 0, \text{ caso contrário } \end{cases}$$

não é função de distribuição de um vetor aleatório.

Seja $ I_X=(0,1] $ e $ I_Y=(0,1] $ então

$$F(x,y)=F(1,1)-F(1,0)-F(0,1)+F(0,0)=1-e^{-2}-1+e^{-1}+0=2e^{-1}-e^{-2}-1=-0,3995 $$

Portanto $ F $ não é função de distribuição pois não vale.

$ F(x,y)\geq 0 $, todo $ I_X $ e $ I_Y $ intervalo de números reais.

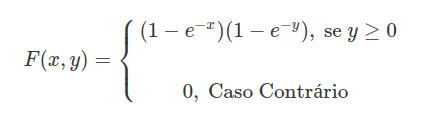

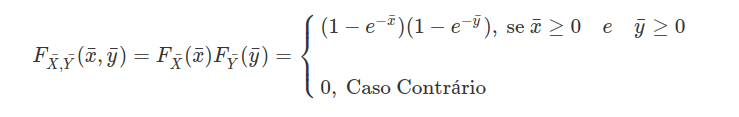

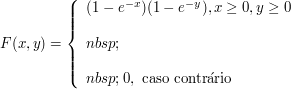

(b) Mostre que a seguinte função é função de distribuição de algum $ (X,Y) $

$$F(x,y)= \begin{cases} (1-e^{-x})(1-e^{-y}), \text{ se } y\geq 0 \cr \cr 0, \text{ caso contrário } \end{cases}$$

Seja $ \bar{X}\sim \hbox{Exp}(1) $ e $ \bar{Y}\sim \hbox{Exp}(1) $ e $ \bar{X} $ independentes $ \bar{Y} $ então

Assim $ F_{\bar{X},\bar{Y}}(x,y)=F(x,y) $, $ \forall x,\forall y \in \mathbb{R} $. Então $ (X,Y) $ é função de algum particular $ (X,Y) $ pois é função de cada $ (\bar{x},\bar{y}) $

Exemplo 2.4.7

Uma urna contém três bolas numeradas 1,2 e 3. Duas bolas são tiradas sucessivamente da urna, ao acaso e sem reposição. Seja $ X $ o número da primeira bola tirada e Y o número da segunda.

(a) Descreva a distribuição conjunta de X e Y.

Todas os resultados possíveis do experimento são equiprováveis, então a função de probabilidade é dada por

$$\mathbb{P}(X=1,Y=1)=\mathbb{P}(1,1)=0$$

$$\mathbb{P}(1,2)=\frac{1}{6}$$

$$\mathbb{P}(1,3)=\frac{1}{6}$$

$$\mathbb{P}(2,1)=\frac{1}{6}$$

$$\mathbb{P}(2,2)=0$$

$$\mathbb{P}(2,3)=\frac{1}{6}$$

$$\mathbb{P}(3,1)=\frac{1}{6}$$

$$\mathbb{P}(3,2)=\frac{1}{6}$$

$$\mathbb{P}(3,3)=0$$

(b) Calcule $ \mathbb{P}(X< Y). $

Pelas probabilidades acima temos que

$$\mathbb{P}(X< Y)=\mathbb{P}(1,2)+\mathbb{P}(1,3)+\mathbb{P}(2,3)=3\frac{1}{6}=\frac{1}{2}=\mathbb{P}(X> Y).$$

Exemplo 2.4.8

Dizemos que a distribuição conjunta de $ X_1,\dots, X_n $ é invariante para permutação se toda permutação das $ X_i $ tem a mesma distribuição, i.e., se

$$X_{\pi_1},X_{\pi_2},\dots, X_{\pi_n}\sim (X_1,\dots, X_n)$$

para toda permutação $ (\pi_1,\dots, \pi_n) $ do vetor $ (1,\dots,n) $.

(a) Mostre que se $ (X,Y)\sim (Y,X) $ e X e Y possuem densidade conjunta $ f(x,y) $, então

$$\mathbb{P}(X< Y)=\mathbb{P}(X> Y)=1/2$$

com $ \mathbb{P}(X=Y)=0 $.

Temos que

$$\mathbb{P}(X< Y)=\int_{-\infty}^\infty \int_x^\infty f_{XY}(x,y)dxdy$$

trocando as varáveis $ x^\prime=y $ e $ y^\prime=x $ e

$$\int_{-\infty}^\infty \int_{y^\prime}^\infty f_{X,Y}(y^\prime, x^\prime)dx^\prime dy^\prime=\int_{-\infty}^\infty \int_{y^\prime}^\infty f(y^\prime, x^\prime)dxdy=\int_{-\infty}^\infty \int_{y^\prime}^\infty f(x^\prime,y^\prime)dxdy=\mathbb{P}(Y< X)$$

Agora $ \mathbb{P}(X=Y)=0 $, pois F é absolutamente contínua e $ \lambda^2(B)=0 $ no qual

$$B=(\lbrace (x,y): x=y\rbrace)$$

então

$$\mathbb{P}(\Omega)=\mathbb{P}\left([X> Y]\bigcup [Y> X]\bigcup [X=Y]\right)$$

o implica que

$$1=\mathbb{P}(X> Y)+\mathbb{P}(Y> X)+\mathbb{P}(X=Y)=2\mathbb{P}(X> Y)$$

então, obtemos que

$$\mathbb{P}(X> Y)=\mathbb{P}(X< Y)=\frac{1}{2}$$

(b) Generalize o item (a), provando que se a distribuição conjunta de $ X_1,\dots, X_n $ é invariante para permutações e $ X_1, \dots, X_n $ possuem densidade conjunta $ f(x_1,\dots,x_n) $, então

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\mathbb{P}(X_{\pi_1}< X_{\pi_2}< \dots < X_{\pi_n})=\frac{1}{n!}$$

e $ \mathbb{P}(X_i=X_j\text{ para algum par } (i,j)\text{ tal que }i\neq j)=0 $.

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\int_{-\infty}^{\infty}\int_{-\infty}^{x_n}\int_{-\infty}^{x_{n-1}}\dots\int_{-\infty}^{x_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

Fazendo uma troca de variáveis $ X_1=X_{\pi_1} $$ \dots $$ X_n=X_{\pi_n} $ temos que

$$\int_{-\infty}^{\infty}\int_{-\infty}^{x_n}\int_{-\infty}^{x_{n-1}}\dots\int_{-\infty}^{x_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

$$=\int_{-\infty}^{\infty}\int_{-\infty}^{x_{\pi_n}}\int_{-\infty}^{x_{\pi_{n-1}}}\dots\int_{-\infty}^{\pi_2}f(x_{\pi_1},x_{\pi_2},\dots, x_{\pi_n})dx_{\pi_1}dx_{\pi_2}\dots dx_{\pi_n}$$

$$=\int_{-\infty}^{\infty}\int_{-\infty}^{x_{\pi_n}}\int_{-\infty}^{x_{\pi_{n-1}}}\dots\int_{-\infty}^{\pi_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

Agora sendo $ B=\lbrace (X_i=X_j : \text{ para algum } (i,j) \text{ tal que } i\neq j)\rbrace\subset\mathbb{R}^n $ e $ \lambda^n(B)=0 $. Assim como

$ F_{X_1,X_2, \dots X_n} $ é absolutamente contínua o que implica que $ \mathbb{P}(B)=0 $. Agora

$$\Omega=\left(\bigcup_{\pi_1,\pi_2,\dots, \pi_n} [X_{\pi_1}< X_{\pi_2}< \dots < X_{\pi_n}]\right)\bigcup B$$

com $ {\pi_1,\pi_2,\dots, \pi_n} $ sendo permutações de $ (X_1,X_2,\dots, X_n) $ então

$$1=n!\mathbb{P}(X_1< X_2< \dots < X_n)$$

o que implica que

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\frac{1}{n!}.$$

Exemplo 2.4.9

Dizemos que a distribuição conjunta de $ X_1,\dots, X_n $ é invariante para permutação se toda permutação das $ X_i $ tem a mesma distribuição, i.e., se

$$X_{\pi_1},X_{\pi_2},\dots, X_{\pi_n}\sim (X_1,\dots, X_n)$$

para toda permutação $ (\pi_1,\dots, \pi_n) $ do vetor $ (1,\dots,n) $.

(a) Mostre que se $ (X,Y)\sim (Y,X) $ e X e Y possuem densidade conjunta $ f(x,y) $, então

$$\mathbb{P}(X< Y)=\mathbb{P}(X> Y)=1/2$$

com $ \mathbb{P}(X=Y)=0 $.

Temos que

$$\mathbb{P}(X< Y)=\int_{-\infty}^\infty \int_x^\infty f_{XY}(x,y)dxdy$$

trocando as varáveis $ x^\prime=y $ e $ y^\prime=x $ e

$$\int_{-\infty}^\infty \int_{y^\prime}^\infty f_{X,Y}(y^\prime, x^\prime)dx^\prime dy^\prime=\int_{-\infty}^\infty \int_{y^\prime}^\infty f(y^\prime, x^\prime)dxdy=\int_{-\infty}^\infty \int_{y^\prime}^\infty f(x^\prime,y^\prime)dxdy=\mathbb{P}(Y< X)$$

Agora $ \mathbb{P}(X=Y)=0 $, pois F é absolutamente contínua e $ \lambda^2(B)=0 $ no qual

$$B=(\lbrace (x,y): x=y\rbrace) $$

então

$$\mathbb{P}(\Omega)=\mathbb{P}\left([X> Y]\bigcup [Y> X]\bigcup [X=Y]\right)$$

o implica que

$$1=\mathbb{P}(X> Y)+\mathbb{P}(Y> X)+\mathbb{P}(X=Y)=2\mathbb{P}(X> Y)$$

então, obtemos que

$$\mathbb{P}(X> Y)=\mathbb{P}(X< Y)=\frac{1}{2}$$

(b) Generalize o item (a), provando que se a distribuição conjunta de $ X_1,\dots, X_n $ é invariante para permutações e $ X_1, \dots, X_n $ possuem densidade conjunta $ f(x_1,\dots,x_n) $, então

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\mathbb{P}(X_{\pi_1}< X_{\pi_2}< \dots < X_{\pi_n})=\frac{1}{n!}$$

e $ \mathbb{P}(X_i=X_j\text{ para algum par } (i,j)\text{ tal que }i\neq j)=0 $.

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\int_{-\infty}^{\infty}\int_{-\infty}^{x_n}\int_{-\infty}^{x_{n-1}}\dots\int_{-\infty}^{x_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

Fazendo uma troca de variáveis $ X_1=X_{\pi_1} $$ \dots $$ X_n=X_{\pi_n} $ temos que

$$\int_{-\infty}^{\infty}\int_{-\infty}^{x_n}\int_{-\infty}^{x_{n-1}}\dots\int_{-\infty}^{x_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

$$=\int_{-\infty}^{\infty}\int_{-\infty}^{x_{\pi_n}}\int_{-\infty}^{x_{\pi_{n-1}}}\dots\int_{-\infty}^{\pi_2}f(x_{\pi_1},x_{\pi_2},\dots, x_{\pi_n})dx_{\pi_1}dx_{\pi_2}\dots dx_{\pi_n}$$

$$=\int_{-\infty}^{\infty}\int_{-\infty}^{x_{\pi_n}}\int_{-\infty}^{x_{\pi_{n-1}}}\dots\int_{-\infty}^{\pi_2}f(x_1,x_2,\dots, x_n)dx_1dx_2\dots dx_n$$

Agora sendo $ B=\lbrace (X_i=X_j : \text{ para algum } (i,j) \text{ tal que } i\neq j)\rbrace\subset\mathbb{R}^n $ e $ \lambda^n(B)=0 $. Assim como $ F_{X_1,X_2, \dots X_n} $ é absolutamente contínua o que implica que $ \mathbb{P}(B)=0 $. Agora

$$\Omega=\left(\bigcup_{\pi_1,\pi_2,\dots, \pi_n} [X_{\pi_1}< X_{\pi_2}< \dots < X_{\pi_n}]\right)\bigcup B$$

com $ {\pi_1,\pi_2,\dots, \pi_n} $ sendo permutações de $ (X_1,X_2,\dots, X_n) $ então

$$1=n!\mathbb{P}(X_1< X_2< \dots < X_n)$$

o que implica que

$$\mathbb{P}(X_1< X_2< \dots < X_n)=\frac{1}{n!}.$$

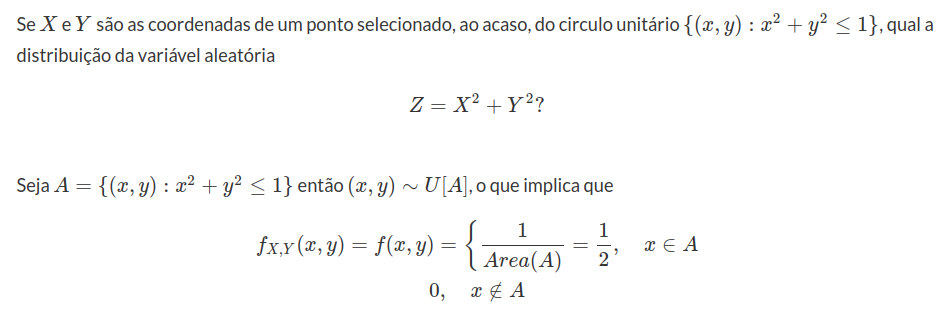

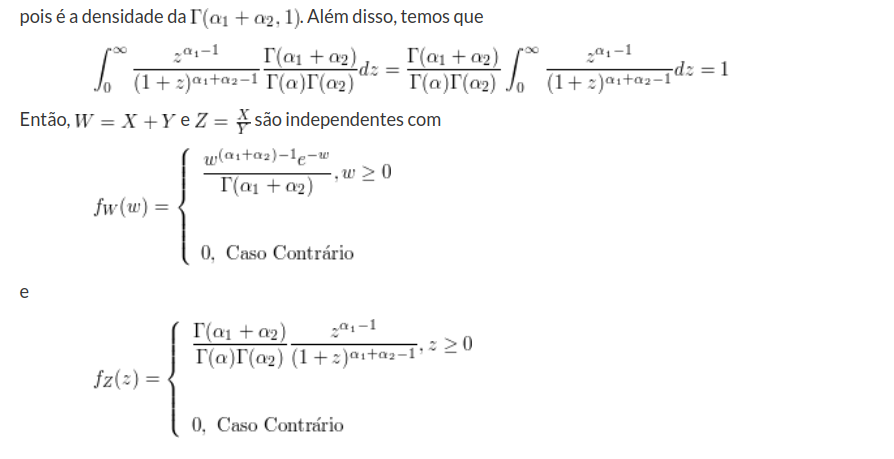

Exemplo 2.4.10

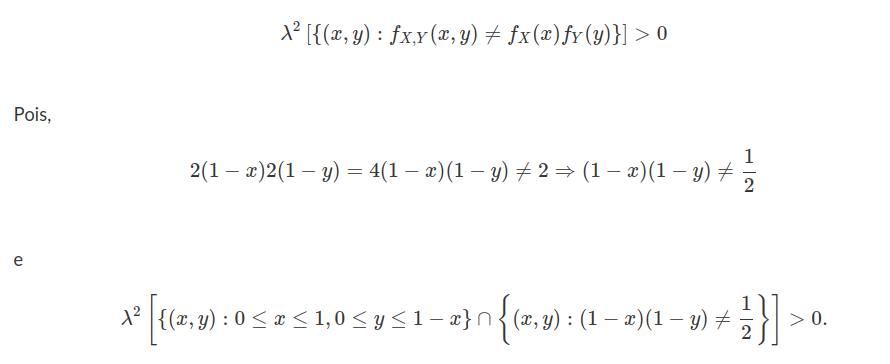

Seleciona-se, ao acaso, um ponto do circulo unitário $(\lbrace (x,y):x^2+y^2\leq 1\rbrace).$ Sejam X e Y as coordenadas do ponto selecionado.

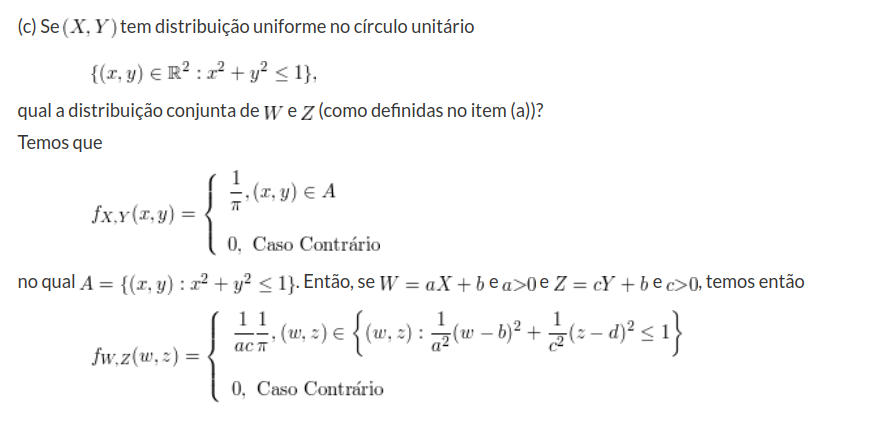

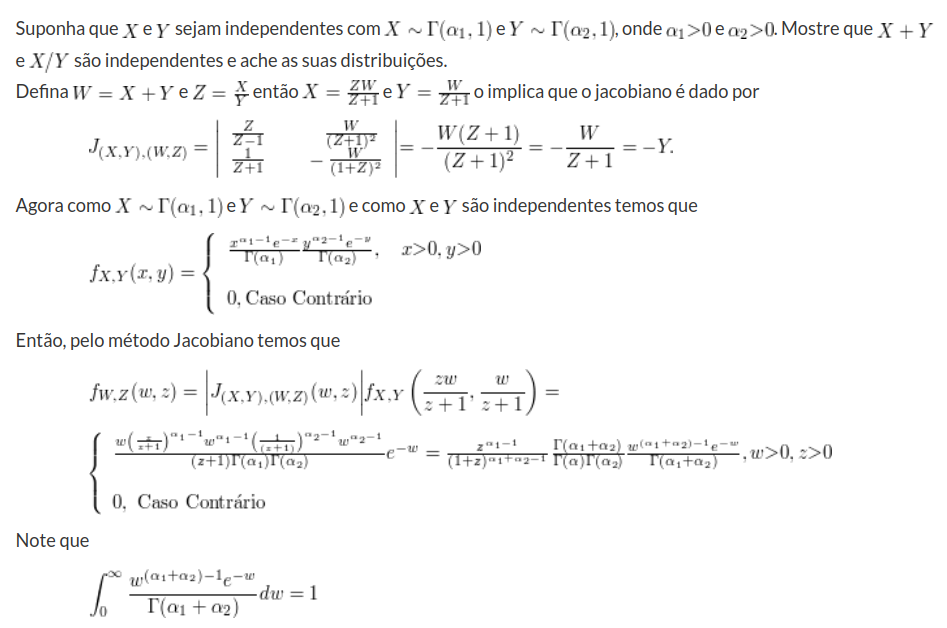

(a) Qual a densidade conjunta de X e Y?

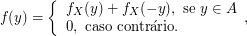

$ (X,Y) $ é uniforme no circulo unitário, então $ A=\lbrace (x,y):x^2+y^2=1\rbrace $. A área $ A=\pi $, então

(b) Determine $ \mathbb{P}(X< Y), \mathbb{P}(X> Y) $

Agora pelo item (a) $ (X,Y)\sim (Y,X) $ então explicando o exercício 19(a)

$$\mathbb{P}(X< Y)=\mathbb{P}(Y< X)=\frac{1}{2}$$

e $ \mathbb{P}(X=Y)=0 $

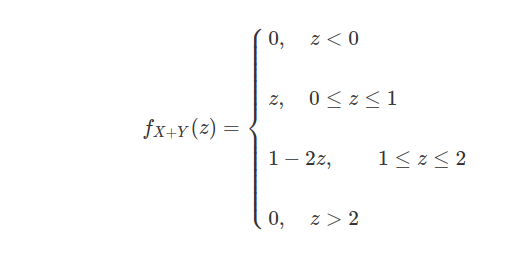

Exemplo 2.4.11

Seleciona-se, ao acaso, um ponto do quadrado unitário $ \lbrace ((x,y):0\leq x\leq 1, 0\leq y\leq 1)\rbrace $. Sejam $ X $ e $ Y $ as coordenadas do ponto selecionado.

(a) Qual a densidade conjunta de X e Y ?

$ (X,Y) $ é uniforme em $ A=\lbrace (x,y): 0\leq x\leq 1, 0\leq y\leq 1\rbrace $. A area $ A=1 $ então

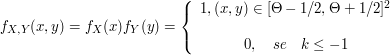

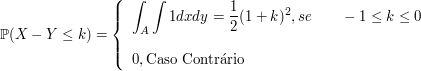

(b) Calcule $ \mathbb{P}\left(\bigg|\frac{Y}{X-1}\bigg|\leq \frac{1}{2}\right) $.

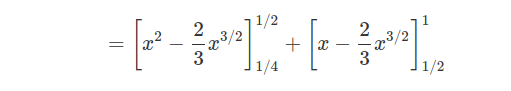

$$\mathbb{P}\left(\bigg|\frac{Y}{X-1}\bigg|\leq \frac{1}{2}\right)=\mathbb{P}\left(-\frac{1}{2}\leq \frac{Y}{X}-1\leq \frac{1}{2}\right)=\mathbb{P}\left(\frac{1}{2}\leq \frac{Y}{X}\leq \frac{3}{2}\right)$$

$$=\int_{0}^{2/3}\int_{1/2}^{3/2}1dxdy+\int_{2/3}^1 \int_{2/2}^1 1dxdy=\left[\frac{x^2}{2}\right]^{2/3}_{0}+\left[x-\frac{x^2}{4}\right]_{2/3}^1=\frac{2}{9}+\frac{3}{4}-\frac{2}{3}+\frac{1}{9}=\frac{5}{12}$$

(c) Calcule $ \mathbb{P}\left(Y\geq X|Y\geq \frac{1}{2}\right) $.

$$\mathbb{P}\left(Y\geq X|Y\geq \frac{1}{2}\right)=\int_{1/4}^{1/2}\int_{\sqrt{x}}^{2x}dydx+\int_{1/2}^1\int_{\sqrt{x}}^1 1dydx$$

$$=\frac{1}{4}-\frac{1}{16}+\frac{2}{3}\left(\frac{1}{4}\right)^{3/2}+ \frac{1}{3}-\frac{1}{2}=10,416\char37$$

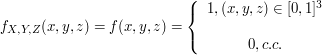

2.4.1 - Distribuição de probabilidade no $R^n$

Os Borelianos de $R^n$

Nesta seção, vamos trabalhar com $ \mathbb{R}^n=\mathbb{R}\times\mathbb{R}\times\cdots\times\mathbb{R} $, o conjunto das n-uplas ordenadas. Nosso primeiro objetivo consiste em construir a $ \sigma $-álgebra de Borel correspondente ao $ \mathbb{R}^n $. Neste caso, o conjunto gerador da $ \sigma $-álgebra de Borel é dado pelos retângulos de $ \mathbb{R}^n $. Os intervalos aberto à esquerda e fechados à direita serão definidos na forma

$$(a,b]=\left(x \in \mathbb{R}: a < x \leq b \right),$$

para todo $ a $ e $ b $ tais que $ -\infty \leq a < b < \infty $. O intervalo $ (a ,\infty] $ é tomado como $ (a,\infty) $, esta convenção é necessária para que o complementar do intervalo $ (\infty,b] $ seja um intervalo da mesma forma (aberto à esquerda e fechado à direita).

Definição 2.4.1.1

Para $ I_k=(a_k,b_k] $ um intervalo, o conjunto $ I=I_1\times I_2\times \cdots\times I_n $ definido por,

$$(x\in \mathbb{R}^n| x_k\in I_k, k=1,\dots,n)$$

é denominado de retângulo de lados $ I_k $, com $ k=1,\cdots,n $. O conjunto de todos os retângulos I, será denotado por $ \mathcal{I} $. De forma geral, um conjunto $ A=A_1\times A_2\times \cdots\times A_n $ é denominado de retângulo (ou cilindro) de lados $ A_i $. Se $ A_i \in \mathfrak{B}(\mathbb{R}) $ dizemos que $ A $ é um retângulo (ou cilindro) de lados borelianos.

Definição 2.4.1.2

A $ \sigma $-álgebra de Borel de subconjuntos de $ \mathbb{R}^n $, denotada por $ \mathfrak{B}(\mathbb{R}^n) $, é a menor $ \sigma $-álgebra gerada por todos os retângulos de $ \mathbb{R}^n $, isto é,$ \mathfrak{B}(\mathbb{R}^n)=\sigma(\mathcal{I}) $.

Da mesma forma que os intervalos geram a $ \sigma $-álgebra de Borel na reta, os retângulos de lados representados por intervalos geram a $ \sigma $-álgebra de Borel do $ \mathbb{R}^n $. Na sequência, mostraremos que a $ \mathfrak{B}(\mathbb{R}^n) $ também pode ser definida como a menor $ \sigma $-álgebra que contém os retângulos com lados Borelianos. Considere

$$\mathcal{R}=(A=A_1\times \cdots\times A_n: A_i \in \beta(\mathbb{R})),$$

a classe dos retângulos com lados Borelianos. Denotamos por

$$ \sigma(\mathfrak{B}(\mathbb{R})\times\mathfrak{B}(\mathbb{R})\times\cdots\times \mathfrak{B}(\mathbb{R}))=\sigma(\mathcal{R}).$$

Exercício

Mostre que a classe dos retângulos $ \mathcal{I} $ e a classe dos retângulos de lados Borelianos $ \mathcal{R} $ formam uma semi-álgebra.

Teorema 2.4.1.1

Temos que, $ \mathfrak{B}(\mathbb{R}^n)=\sigma(\mathcal{I})=\sigma(\mathfrak{B}(\mathbb{R})\times\mathfrak{B}(\mathbb{R})\times\cdots\times \mathfrak{B}(\mathbb{R})) $

Demonstração

Note que o resultado é trivial se $ n=1 $. Vamos mostrar o caso $ n=2 $. Definimos por

$$\mathcal{C}=(B_1\times B_2: B_i\in \mathfrak{B}(\mathbb{R}), i=1,2),$$

a classe dos retângulos com lados Borelianos.

Sabemos que que $ \mathcal{I}\subset \mathcal{C} $, logo é imediato que

$$\mathfrak{B}(\mathbb{R}^2)=\sigma(\mathcal{I})\subset \sigma(\mathcal{C})=\mathfrak{B}(\mathbb{R})\otimes\mathfrak{B}(\mathbb{R})$$

Assim resta-nos apenas mostrar que

$$\mathfrak{B}(\mathbb{R})\otimes\mathfrak{B}(\mathbb{R})\subset\mathfrak{B}(\mathbb{R}^2)$$

Na sequência, considere $ \mathfrak{C} $ uma classe de subconjuntos de $ \mathbb{R}^2 $ e $ B\subset\mathbb{R}^2 $. Então, ao definirmos

$$\mathfrak{C}\cap B=(A\cap B:A\in\mathfrak{{C}}),$$

vamos provar que

$$\sigma(\mathfrak{C}\cap B)=\sigma(\mathfrak{C})\cap B.$$

Como $ \mathfrak{C}\subset \sigma(\mathfrak{C}) $, concluímos que

$$\mathfrak{C}\cap B\subset \sigma(\mathfrak{C})\cap B$$

Além disso, temos que $ \sigma(\mathfrak{C})\cap B $ é uma $ \sigma $-álgebra (exercício). Assim, obtemos que

$$\sigma(\mathfrak{C}\cap B)\subset \sigma(\mathfrak{C})\cap B$$

Na sequência, vamos mostrar

$$\sigma(\mathfrak{C})\cap B\subset \sigma(\mathfrak{C}\cap B) $$

Para isso, tomamos $ \mathcal{C}_B=\lbrace A\in\sigma(\mathfrak{C}):A\cap B\in \sigma(\mathfrak{C}\cap B)\rbrace $. Desde que $ \sigma(\mathfrak{C}) $ e $ \sigma(\mathfrak{C}\cap B) $ são $ \sigma $-álgebras, obtemos que $ \mathcal{C}_B $ também é uma $ \sigma $-álgebra, Portanto, temos que

$$\mathfrak{C}\subset\mathcal{C}_B\subset \sigma(\mathfrak{C})$$

O que implica que $ \mathcal{C}_B= \sigma(\mathfrak{C}) $. Assim, concluímos que

$$A\cap B\in \sigma(\mathfrak{C}\cap B)$$

para todo $ A\in\mathfrak{C} $. Consequentemente $ \sigma(\mathfrak{C})\cap B\subset \sigma(\mathfrak{C}\cap B) $.

Para terminarmos a demonstração do teorema, considere os seguintes conjuntos $ \mathcal{B}\times \mathbb{R}=(B\times \mathbb{R}| B\in\mathfrak{B}(\mathbb{R})) $ e $ \mathbb{R}\times \mathcal{B}=(\mathbb{R}\times B| B\in\mathfrak{B}(\mathbb{R})) $.

Então dado $ B_1\times B_2 $, com $ B_1,B_2\in \mathfrak{B}(\mathbb{R}) $, temos que

$$B_1\times B_2=(B_1\times \mathbb{R})\cap (\mathbb{R}\times B_2) \in\sigma(I_1 \times \mathbb{R})\cap (B_2\times \mathbb{R})= \sigma((I_1 \times \mathbb{R})\cap (B_2\times \mathbb{R}))\subset\sigma ((I_1\times \mathbb{R})\cap (I_2\times\mathbb{R}))=\sigma(\mathcal{I})$$

no qual, $ I_i $ é o conjunto de todos os intervalos de $ \mathbb{R} $ correspondente a $ i $-ésima coordenada, com $ i=1,2 $.. Portanto o resultado segue.

Como a $ \sigma $-álgebra de Borel do $ \mathcal{R}^n $ é gerada pelo produto “direto” da $ \sigma $-álgebra de Borel de cada coordenada, esta também pode ser denotada por $ \mathfrak{B}(\mathbb{R})\otimes\mathfrak{B}(\mathbb{R})\otimes\cdots\otimes \mathfrak{B}(\mathbb{R})=\sigma(\mathcal{R}). $

Distribuição de probabilidade no $R^n$

Suponha $ \mathbb{P} $ uma probabilidade no espaço mensurável $ (\mathbb{R}^n,\mathfrak{B}(\mathbb{R}^n)) $. A função

$$F_n(x_1,\dots,x_n)=\mathbb{P}((-\infty,x_1]\times (-\infty,x_2]\times\dots\times(-\infty,x_n])$$

é denominada função de distribuição da probabilidade $ \mathbb{P} $. Usaremos uma notação mais compacta, a qual será denotada da seguinte forma

$$F_n(x)=\mathbb{P}((-\infty,x])$$

no qual $ x=(x_1,\dots,x_n) $ e $ (-\infty,x]=(-\infty,x_1]\times (-\infty,x_2]\times\dots\times(-\infty,x_n] $. Na sequência, introduzimos o operador diferença $ \Delta_{a_i,b_i}:\mathbb{R}^n\rightarrow \mathbb{R} $ definido por

$$\Delta_{a_i,b_i}F_n(x)=F_n(x_1,\dots,x_{i-1},b_i,x_{i+1},\dots,x_n)-F_n(x_1,\dots,x_{i-1},a_i,x_{i+1},\dots,x_n),$$

no qual $ a_i\leq b_i $ para $ i=1, \cdots , n $. Com esta notação, temos que

$$\Delta_{a_1,b_1}\dots\Delta_{a_n,b_n} F_n(x)=\mathbb{P}((a,b])$$

no qual $ (a,b]=(a_1,b_1]\times\dots\times(a_n,b_n] $. Como no exemplo 2.4.2 mostrado na seção anterior no caso multidimensional em geral $ \mathbb{P}((a,b])\neq F_n(b)-F_n(a) $, com $ a=(a_1,\dots,a_n) $ e $ b=(b_1,\dots,b_n) $. Além disso como $ \mathbb{P} $ é positiva temos que

P1

$$\Delta_{a_1,b_1}\dots\Delta_{a_n,b_n} F_n(x)\geq 0$$

Da continuidade a direita de $ \mathbb{P} $, temos que $ F_n $ também é contínua a direita, ou seja, se uma sequência $ (x^{k})_{k\in\mathbb{N}} $ e $ x^k\downarrow x $, com $ x^k=(x_1^k,\dots,x_n^k) $ então

P2

$$F_n(x^k)\downarrow F_n(x),\quad k\rightarrow \infty.$$

Além disso,

P3

$$\displaystyle\lim_{x\rightarrow \infty}F_n(x)=1$$

e

P4

$$\displaystyle \lim_{x\downarrow y}F_n(x)=0$$

se pelo menos uma coordenada de $ y $ é $ -\infty $.

Definição 2.4.1.3

Uma função de distribuição $ n $-dimensional em $ \mathbb{R}^n $ é uma função $ F=F_n(x_1,\dots,x_n) $ com as propriedades P1,P2,P3,P4.

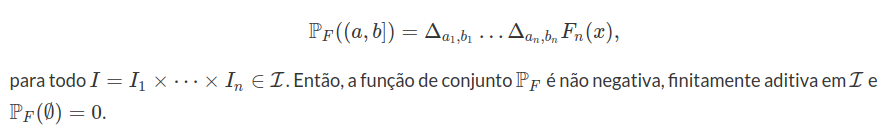

Nosso objetivo é mostrar que se $ F $ é uma função de distribuição, então existe uma única probabilidade $ \mathbb{P} $ definida em $ (\mathbb{R}^n,\mathfrak{B}(\mathbb{R}^n)) $, tal que

$$\mathbb{P}((a,b])=\Delta_{a_1,b_1}\dots\Delta_{a_n,b_n} F_n(x).$$

Para isso, vamos construir uma probabilidade definida na álgebra gerada pelos retângulos e então, usaremos o teorema de extensão. Relembramos que $ \mathcal{I} $ denota semi-álgebra composta pelos retângulos de lados compostos por intervalos na forma $ I_k = (a_k , b_k] $, com $ k=1,\cdots,n $.

Lema 2.4.1.1

Seja $ F $ uma função de distribuição em $ \mathbb{R}^n $. Tomamos a função de conjunto $ \mathbb{P_F} $ sobre a semi-álgebra $ \mathcal{I} $ na forma

Demonstração

Note que, pela definição de $ F $, $ \mathbb{P_F} $ é não negativa em $ \mathcal{I} $ e $ \mathbb{P_F}(\emptyset)=0 $ . Agora para mostrar a aditividade finita, considere o caso n=2, consideraremos somente esse caso, por simplicidade da notação, a demonstração para o caso geral pode ser estendida naturalmente, a partir deste caso.

Assim considere

$$\displaystyle \bigcup_{m=1}^{k}I_m\in \mathcal{I}$$

onde $ I_m $ são elementos disjuntos $ \mathcal{I} $. Primeiramente vamos considerar o caso em que $ I_m $ tem lados disjuntos. Desta forma, podemos rescrever

$$\displaystyle \bigcup_{m=1}^k I_m=\bigcup_{i=1}^{K_1}\bigcup_{j=1}^{K_2} I_{i,j}$$

Onde

$$\displaystyle \bigcup_{m=1}^k I_m= (a^0,a^{K_1}]\times(b^0,b^{K_2}]$$

e

$$I_{i,j}=(a^{i-1},a^{i}]\times (b^{j-1},b^{j}].$$

no qual $ I_m $ é um dos $ I_{i,i} $.

Agora fixando $ i $, temos que

$$\displaystyle \sum_{j=1}^{K_2}\mathbb{P}(I_{i,j})=\sum_{j=1}^{K_2}(F(a^i,b^j)-F(a^i, b^{j-1})-F(a^{i-1},b^j)+F(a^{i-1},b^{j-1}))=$$

$$\displaystyle \sum_{j=1}^{K_2}(F(a^i, b^j)-F(a^i,b^{j-1}))-\sum_{j=1}^{K_2}(F(a^{i-1},b^j)-F(a^{i-1},b^{j-1}))=$$

$$\displaystyle (F(a^i,b^{K_2})-F(a^i,b^0))-(F(a^{i-1},b^{K_2})-F(a^{i-1},b^0))=$$

$$\displaystyle \Delta_{a^{i-1},a^{i}}\Delta_{b^0,b^{K_2}} F(x_1,x_2)$$

Logo, obtemos que

$$\displaystyle \sum_{i=1}^{K_1}\sum_{j=1}^{K_2}\mathbb{P_F}(I_{i,j})=\sum_{j=1}^{K_2}\Delta^1_{a^{i-1},a^{i}}\Delta^2_{b^0,b^{K_2}}F(x_1,x_2)=$$

como

$$\displaystyle \sum_{i}^{K_1}\sum_{j=1}^{K_2}\mathbb{P_F}(I_{i,j})=\displaystyle \bigcup_{m=1}^k\mathbb{P_F}(I_m)$$

$$\displaystyle \sum_{i=1}^{K_1}((F(a^i,b^{K_2})-F(a^i,b^0))-(F(a^{i-1},b^{K_2})-F(a^{i-1},b^0)))=$$

$$\sum_{i=1}^{K_1}(F(a^i,b^{K_2})-F(a^i,b^0))-\sum_{i=1}^{K_1}(F(a^{i-1},b^{K_2})-F(a^{i-1},b^0))=$$

$$F(a^{K_1},b^{K_2})-F(a^0,b^{K_2})-F(a^{K_1},b^0)-F(a^{K_1},b^0)+F(a^0,b^0)=$$

$$\Delta^1_{a^{0},a^{K_1}}\Delta^2_{b^{0},b^{K_2}}F(x_1,x_2)=$$

$$\mathbb{P_F}((a^0,b^{K_2}]\times(a^{K_1},b^{K_2}])=\mathbb{P_F}\left(\bigcup_{m=1}^{k}I_m\right)$$

Como

$$\displaystyle \sum_{i=1}^{K_1}\sum_{j=1}^{K_2}\mathbb{P_F}(I_{i,j})=\sum_{m=1}^k \mathbb{P_F}(I_m)$$

Segue que

$$\mathbb{P_F}\left(\bigcup_{m=1}^{k}I_m\right)=\displaystyle \sum_{i=1}^{K_1}\sum_{j=1}^{K_2}\mathbb{P_F}(I_{i,j})=\sum_{m=1}^k \mathbb{P_F}(I_m)$$

Agora para o caso geral, pode sempre ser reduzido ao caso onde os lados dos retângulos são disjuntos. Por exemplo se

$$I_m=(u_1^{m},u_2^{m}]\times(v_1^m,v_2^m],\quad m=1,\dots,k$$

Assim basta colocar os valores em ordem crescente os valores distintos

$$u_1^{1},u_2^{1}, u_1^2,u_2^{2},\dots,u_1^{k}, u_2^{k}\quad e \quad v_1^{1},v_2^{1}, v_1^2,v_2^{2},\dots,v_1^{k}, v_2^{k}$$

respectivamente por

$$a^0< a^{1}<\dots< a^{K_1}\quad e \quad b^{0}< b^{1}<\dots< b^{K_2}$$

Então

$$\displaystyle \bigcup_{m=1}^k I_m=\bigcup_{i=1}^{K_1}\bigcup_{j=1}^{K_2} (a^{i-1},a^{i}]\times (b^{j-1},b^{j}]$$

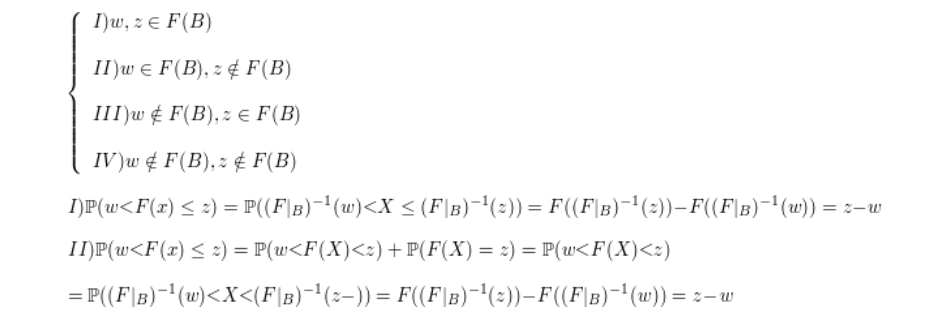

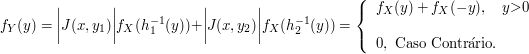

Pelo caso anterior temos que