8.7 Convergência de variáveis aleatórias

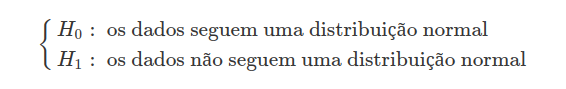

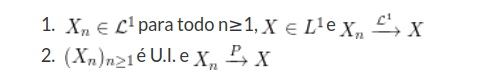

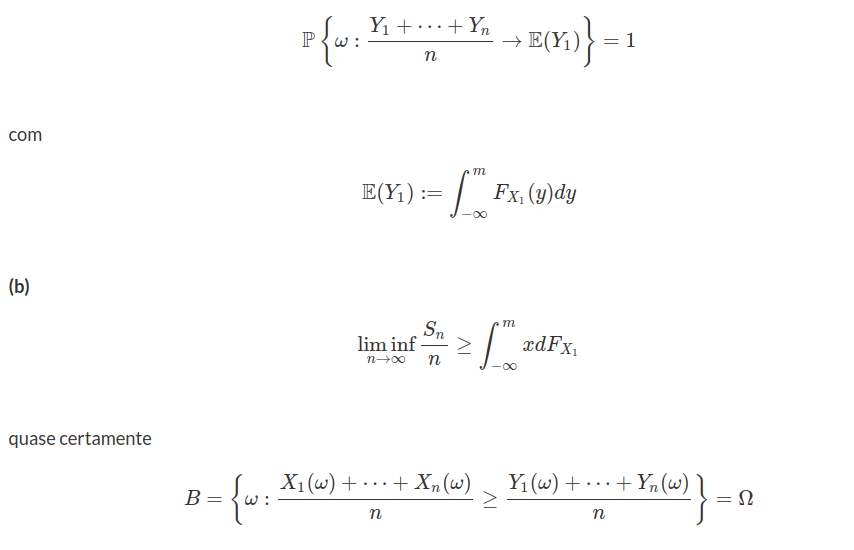

O teorema central do limite é um resultado fundamental com diversas aplicações. Mesmo quando a distribuição da população de eventos não segue uma distribuição Normal, a distribuição da média dos dados converge para a distribuição Normal conforme o tamanho da amostra aumenta. Assim, qualquer que seja a distribuição da amostra, para um número suficientemente grande de observações, a distribuição de probabilidade da média se aproxima da distribuição Normal com média $ \mu $ e variância $ \frac{\sigma^2}{n} $, nos quais $ \mu $ é a média e $ \sigma^2 $ é a variância da população. Para ilustrar, considere uma população $ X $ que possui distribuição exponencial com parâmetro $ \lambda = 1 $, isto é, $ X\sim \ \text{Exp}(1) $. Vamos realizar um estudo da distribuição amostral de $ \overline{X} $.

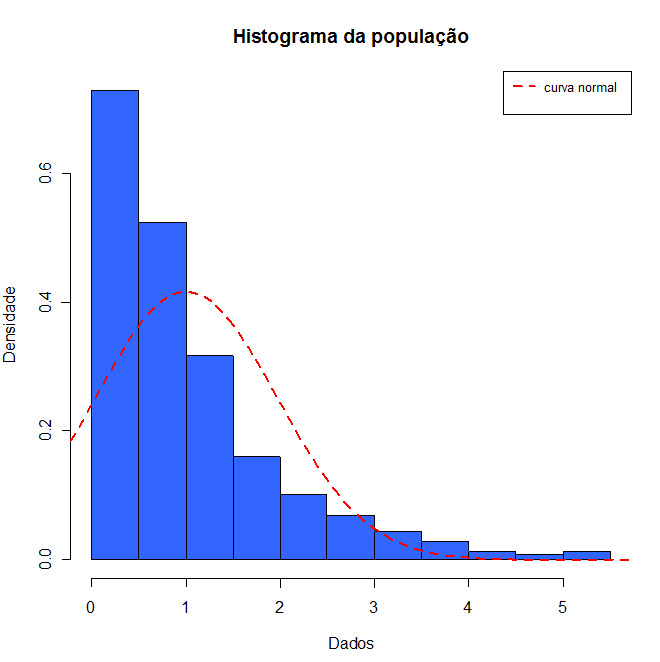

Inicialmente, vamos plotar o histograma da população que possui distribuição exponencial com parâmetro $ \lambda =1 $ e tamanho de amostra 500.

Figura 7.1: histograma dos dados da população com distribuição exponencial com parâmetro λ=1.

Note que o gráfico do conjunto de dados segue uma distribuição não simétrica, diferente da curva da distribuição Normal (linha vermelha). Vamos fazer um resumo descritivo dos dados da população.

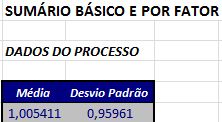

Figura 7.2: Resumo descritivo da população.

Observamos que no caso de toda população, a média a média populacional é aproximadamente 1 e o desvio padrão da média é dada por $ \dfrac{s}{\sqrt{n}}=\dfrac{0,95961}{\sqrt{500}}=0,042915. $ Afim de aplicar o teorema do limite central (TCL), vamos tomar 1000 amostras aleatórias dessa população, cujo tamanho da amostra é dois. De cada uma destas 1000 amostras calculamos a média, em seguida verificamos o comportamento dos dados. A seguir, vamos plotar o histograma dos dados e fazer um resumo descritivo.

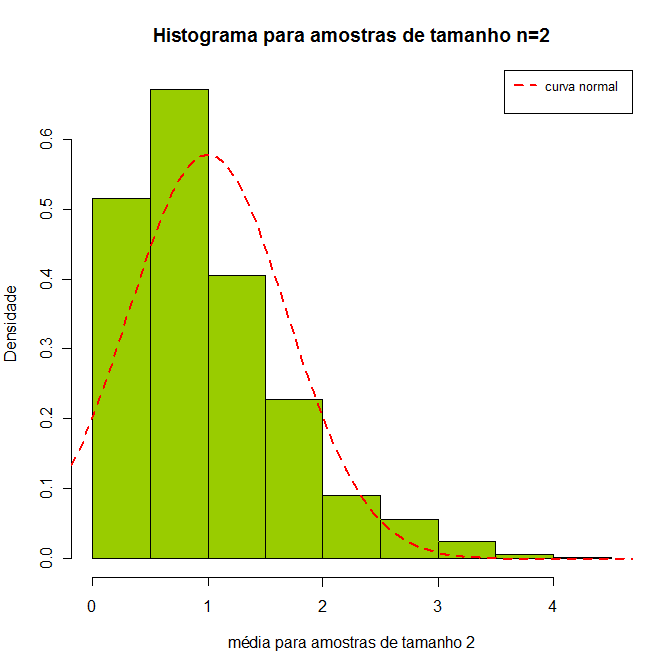

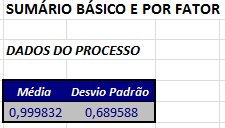

Figura 7.3: histograma usando grupos de 2.

Figura 7.4: Resumo descritivo para amostras de tamanho 2.

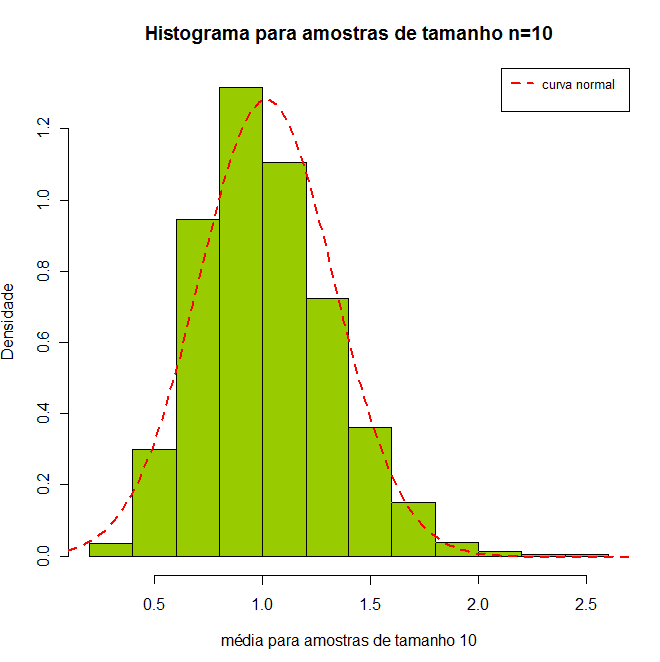

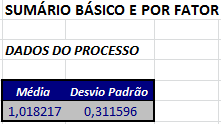

Com amostras de tamanho 2, ainda não obtemos resultados satisfatórios. Com isso, vamos tomar 1000 amostras aleatórias de tamanho 10. De cada uma destas 1000 amostras calculamos a média, em seguida verificamos o comportamento dos dados. A seguir, vamos plotar o histograma dos dados e fazer um resumo descritivo.

Figura 7.5: histograma para amostras de tamanho $ n=10. $

Figura 7.6: Resumo descritivo para amostras de tamanho 10.

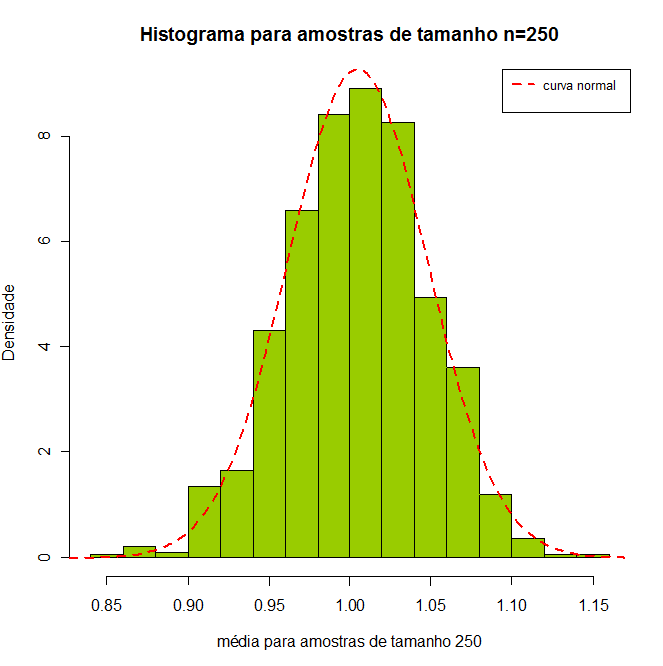

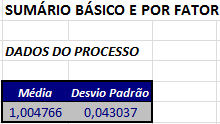

Agora, para amostras de tamanho 2, ainda não obtemos resultados satisfatórios. Por fim, vamos tomar 1000 amostras aleatórias de tamanho 250. De cada uma destas 1000 amostras calculamos a média, em seguida verificamos o comportamento dos dados. A seguir, vamos plotar o histograma dos dados e fazer um resumo descritivo.

Figura 7.7: histograma para amostras de tamanho $ n=250. $

Figura 7.8: Resumo descritivo para amostras de tamanho 250.

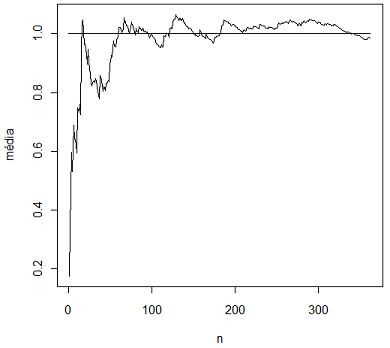

Como percebemos este gráfico já possui uma distribuição similar a da distribuição Normal. Da distribuição da média populacional obtemos $ \mu=\overline{X}=1 $ e $ \sigma_{\overline{X}}=\dfrac{s}{\sqrt{n}}=\dfrac{0,95961}{\sqrt{500}}=0,042915. $ Observamos pela figura 7.8 que a diferença entre os dados com amostras de tamanho 250 e a distribuição da média empírica (erro) é de 0,004 para a média e de 0,00012 para o desvio padrão. Para reforçar isto, vamos realizar um teste de normalidade (para mais detalhes consulte o conteúdo de inferência estatística), em que realizamos o seguinte teste de hipótese (para mais detalhes consulte o conteúdo teste de hipóteses):

(imagem em falta)

Figura 7.9: Teste de normalidade segundo critério de Anderson e Darling.

Notamos que à partir do teste de Anderson e Darling, obtemos um p-valor de 0,53 (para mais detalhes consulte o conteúdo cálculo e interpretação do p-valor). Então, existe forte evidência de que os dados provém de uma distribuição Normal. A seguir, apresentamos um gráfico resumindo todos os passos deste estudo.

Figura 7.10: Todos os passos do estudo.

Logo, quando a distribuição da população não seguem uma distribuição Normal, a distribuição da média dos dados converge para a distribuição Normal conforme o tamanho da amostra aumenta.

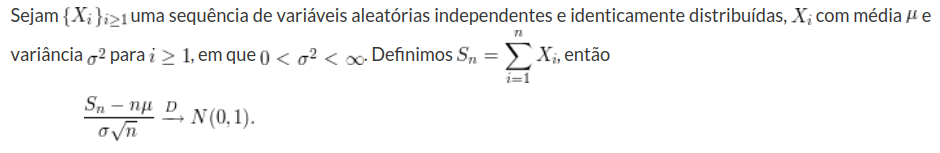

Portanto, o teorema central do limite (TCL) pode ser resumido como. Para amostras grandes, a distribuição amostral da média pode ser aproximada pela distribuição Normal. Mais especificamente, consideramos uma amostra aleatória simples de tamanho n, retirada de uma população com média μ e variância σ2. Representando tal amostra por n variáveis aleatórias independentes X1,…,Xn, e denotando sua média por $ \overline{X} $, temos pelo teorema central do limite, que quando n for suficientemente grande, a variável Z dada por

$$\frac{\overline{X}-\mu}{\sigma / \sqrt{n}}$$

tem distribuição aproximadamente Normal com média 0 e variância 1 (N(0,1)).

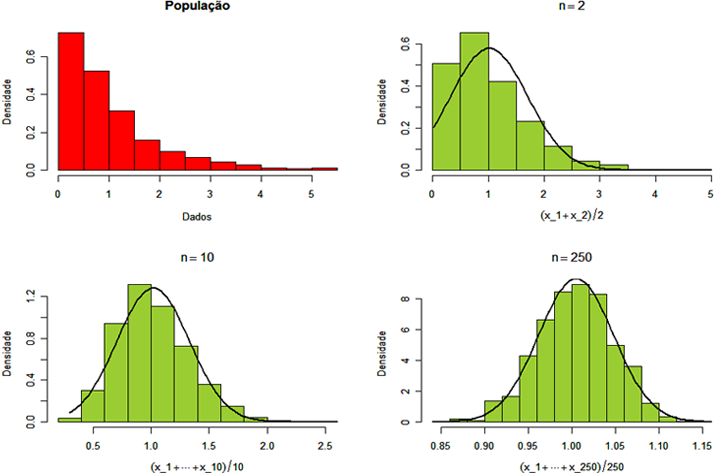

A lei dos grandes números é um dos principais teoremas assintóticos da estatística. Intuitivamente, visualizamos através de um gráfico (figura 7.10) a lei dos grandes números, que diz que a média aritmética dos valores observados tendem a esperança da variável aleatória.

Figura 7.11: Ideia intuitiva da lei dos grandes números.

No gráfico a linha reta representa a média da variável aleatória, enquanto que a outra linha representa a média dos valores observados. Notemos que conforme aumenta o número de observações a média aritmética dos valores observados tende para a média da variável aleatórios.

A seguir, vamos mostrar os resultados com detalhes sobre a lei dos grandes números e do teorema central do limite (TCL).

7.1 - Tipos de Convergência

Neste módulo, apresentamos os principais tipos de convergência estocástica e suas relações.

7.1.1 - Convergências em probabilidade e quase certa

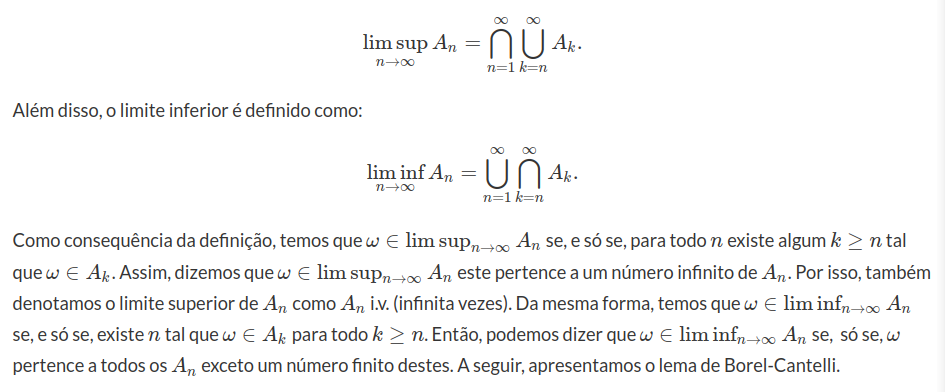

Nesta seção, vamos estudar as convergências em probabilidades e quase certa, porém, inicialmente vamos apresentar um resultado importante, que é o lema de Borel-Cantelli.

Definição 7.1.1.1

Seja $(A_n)_{n\geq 1}$ uma sequência de eventos aleatórios então o limite superior da sequência é definido como

Lema 7.1.1.1 (Lema de Borel-Cantelli)

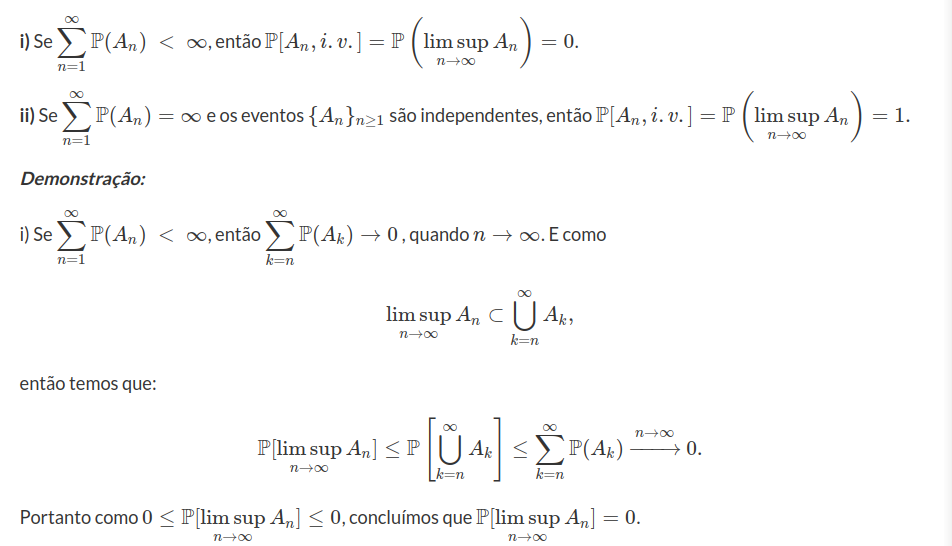

Seja $(A_n)_{n\geq 1}$ uma sequência de eventos aleatórios. Temos que:

Assim, seja $B_n=\displaystyle \bigcup_{k=n}^{\infty}A_k$, note que $B_n \supset \displaystyle \bigcup_{k=n}^{n+m}A_k $, para qualquer $m \in \mathbb{N}$, e portanto $B_n^c \subset \left(\displaystyle \bigcup_{k=n}^{n+m}A_k\right)^c=\displaystyle \bigcap_{k=n}^{n+m}A_k^{c}$ (essa igualdade é válida pelas leis de De Morgan).

Logo, para todo m temos

$$1-\mathbb{P}(B_n)=\mathbb{P}(B_n^c)\leq \mathbb{P}\left(\displaystyle \bigcap_{k=n}^{n+m}A_k^{c}\right).$$

Como cada $A_i$ são independentes então obtemos que

$$\mathbb{P}\left(\displaystyle \bigcap_{k=n}^{n+m}A_k^{c}\right)=\prod_{k=n}^{n+m}\mathbb{P}(A_k^c)=\prod_{k=n}^{n+m}(1-\mathbb{P}(A_k)).$$

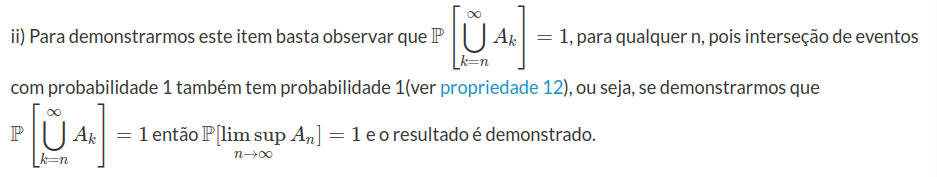

Notemos que $1-p\leq e^{-p}$ para $0\leq p \leq 1$, temos então que:

pois por hipótese temos que $\displaystyle \sum_{n=1}^{\infty}\mathbb{P}(A_n)=\infty$. Portanto $\mathbb{P}(B_n)=1$, para todo $n\geq 1$.

$\Box$

Exemplo 7.1.1.1

Seja $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias independentes tal que, $X_n\sim \text{Bernoulli}(p_n)$, $0 \ < \ p_n \ < \ 1$, $n\geq 1.$

Pelo lema de Borel-Cantelli, temos que

Se $\displaystyle\sum^\infty_{n=1}p_n \ < \ \infty$ então $\mathbb{P}([X_n=1],i.v.)=0$

Se $\displaystyle\sum^\infty_{n=1}p_n=\infty$ então $\mathbb{P}([X_n=1],i.v.)=1$

Exemplo 7.1.1.2

Seja $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias independentes com $X_n\sim \text{Exp}(1).$ Defina $Y_n=\frac{X_n}{\log(n)}$ para $n\geq1.$ Discuta a convergência em probabilidade e quase certa.

Note que

$$\mathbb{P}\left(X_n \ > \ x\right)=e^{-x},\quad x \ > \ 0,~n\geq 1$$

e portanto,

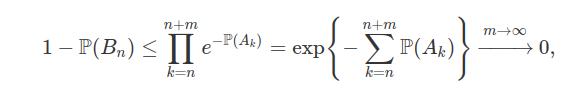

$$\mathbb{P}\left(X_n \ > \ \alpha \log n\right)=e^{-\alpha\log n}=\dfrac{1}{n^\alpha},\quad ~n\geq 1$$

Então, pelo lema de Borel-Cantelli,

Agora, vamos apresentar as definições de convergências em probabilidades e quase certa.

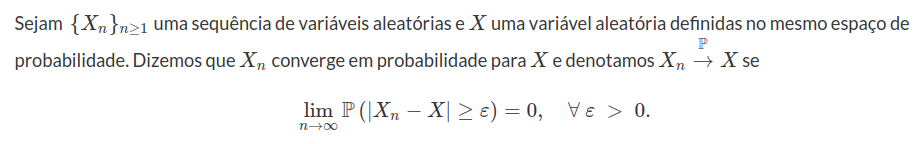

Definição 7.1.1.2: (Convergência em probabilidade)

A principal ideia da convergência em probabilidade é que, quando n é arbitrariamente grande, a probabilidade da diferença $|X_n-X|$ ser maior do que qualquer número positivo $\varepsilon$ tende a zero.

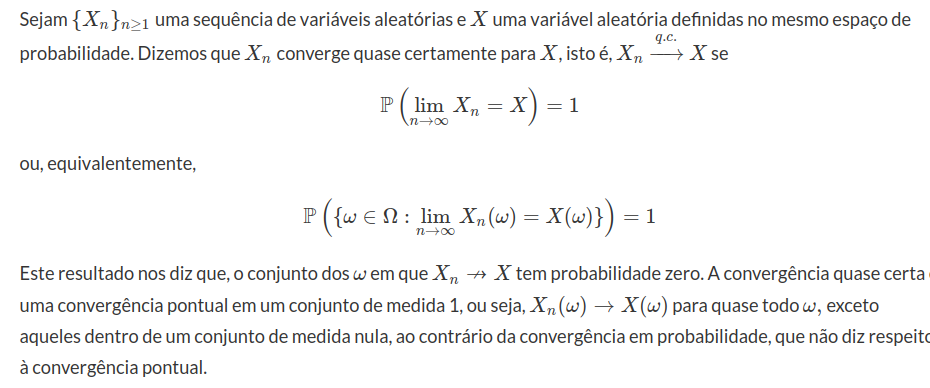

Definição 7.1.1.3: (Convergência quase certa)

Teorema 7.1.1.1: (Critério de convergência quase certa)

Sejam $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias e $X$ uma variável aleatória. Então $X_n$ converge quase certamente para $X$ se, e somente se, para todo $j\geq1$

$$\mathbb{P}\left(|X_n-X|\geq \frac{1}{j} \ \text{i.v.} \right)=0$$

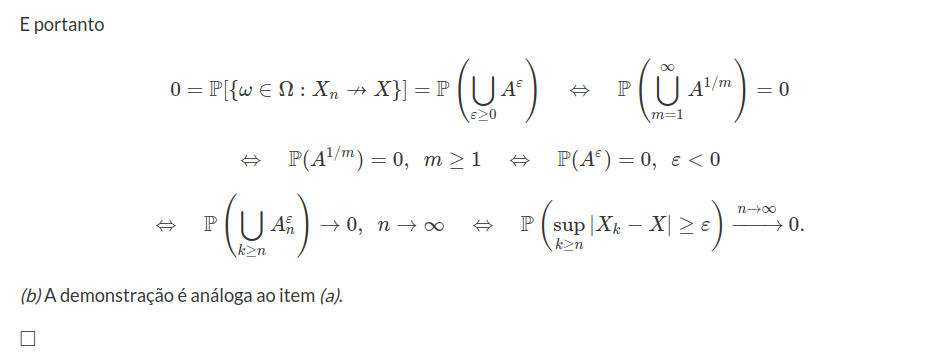

Demonstração:

Um sequência de funções converge se para todo $j\geq 1,$ existe $n\geq 1$ tal que $k\geq n$ implica

$$|X_k(\omega)-X(\omega)| \ < \ \frac{1}{j}$$

equivalentemente

A seguir, apresentamos dois exemplos relacionados com as convergências quase certa e em probabilidade. Na sequência, apresentamos um resultado que comprova que convergência quase certa implica em convergência em probabilidade.

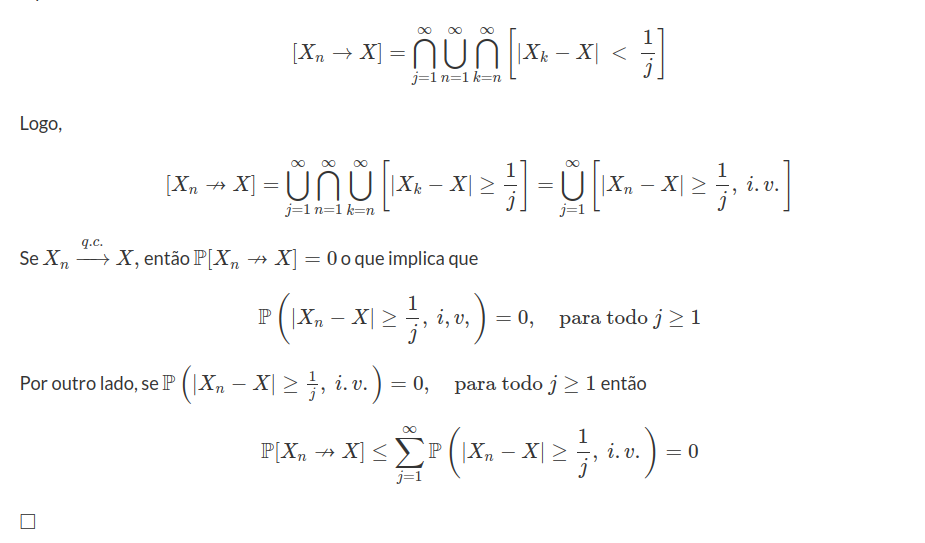

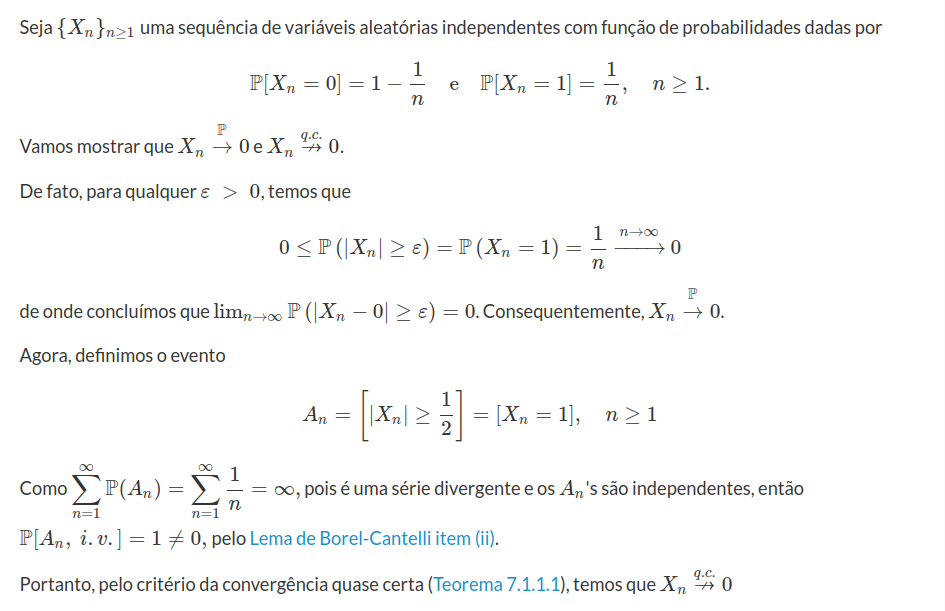

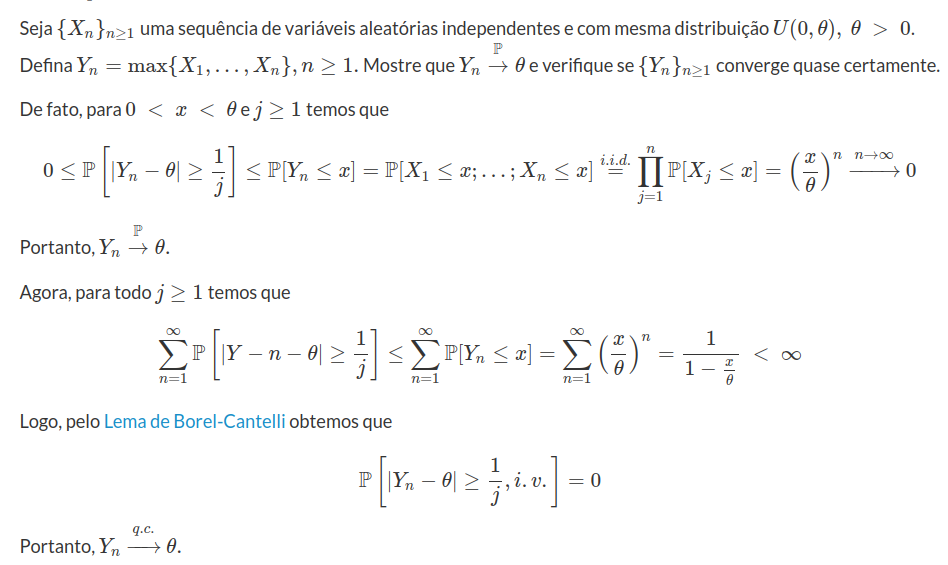

Exemplo 7.1.1.3

Exemplo 7.1.1.4

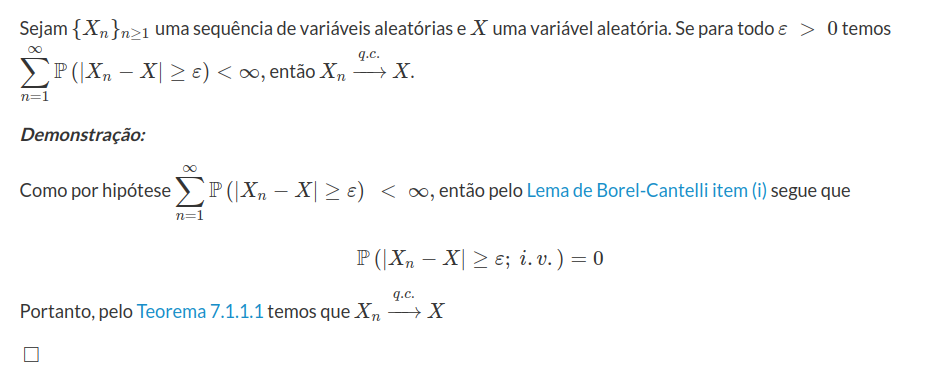

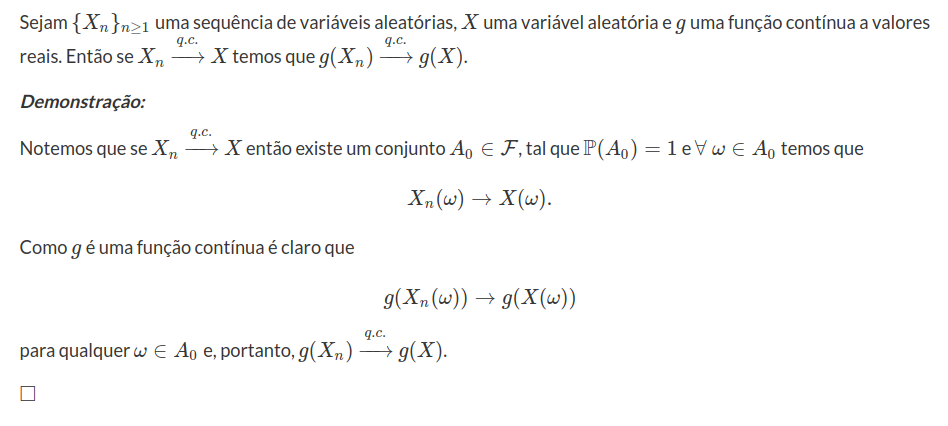

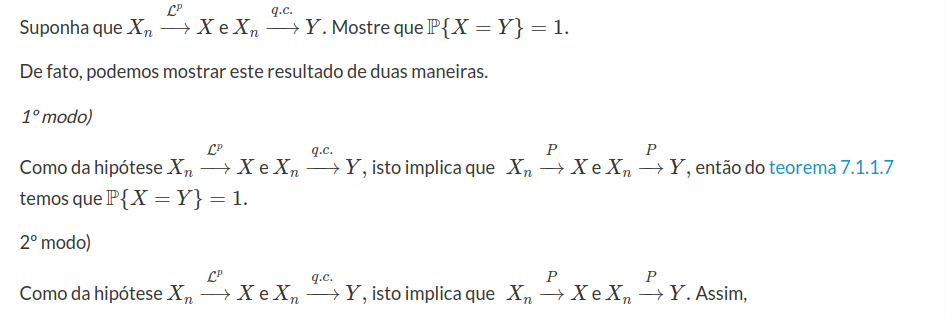

Teorema 7.1.1.2

Teorema 7.1.1.3

Teorema 7.1.1.4

Teorema 7.1.1.5

Teorema 7.1.1.6

Sejam $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias, $X$ uma variável aleatória e $g$ uma função contínua a valores reais. Se $X_n$ converge em probabilidade para $X$ então $g(X_n)$ converge em probabilidade para $g(X)$.

Demonstração:

Inicialmente, suponha que $g$ é uniformemente contínua. Então, dado $\varepsilon \ > \ 0$, existe um $\delta \ > \ 0$ tal que $|g(X_n) - g(x)| \ < \ \varepsilon$ sempre que $|X_n-X| \ < \ \delta$. Neste caso, temos que

logo converge em probabilidade.

$\Box$

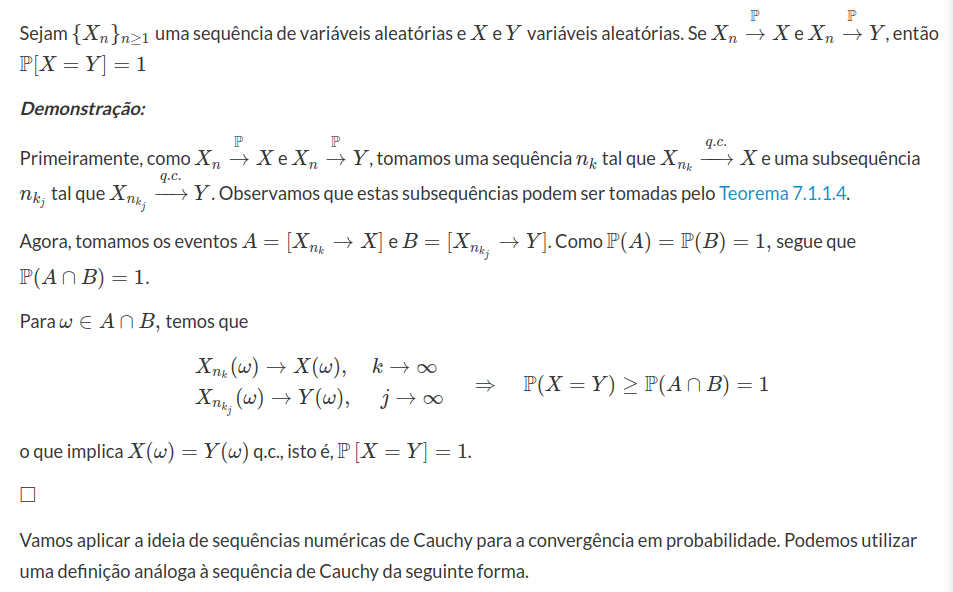

Teorema 7.1.1.7: (O limite em probabilidade é “único”)

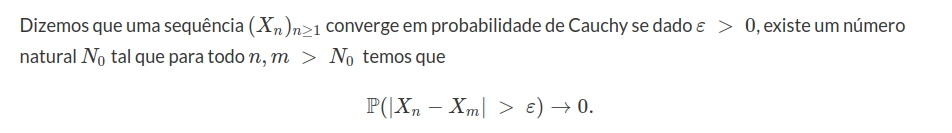

Definição 7.1.1.4

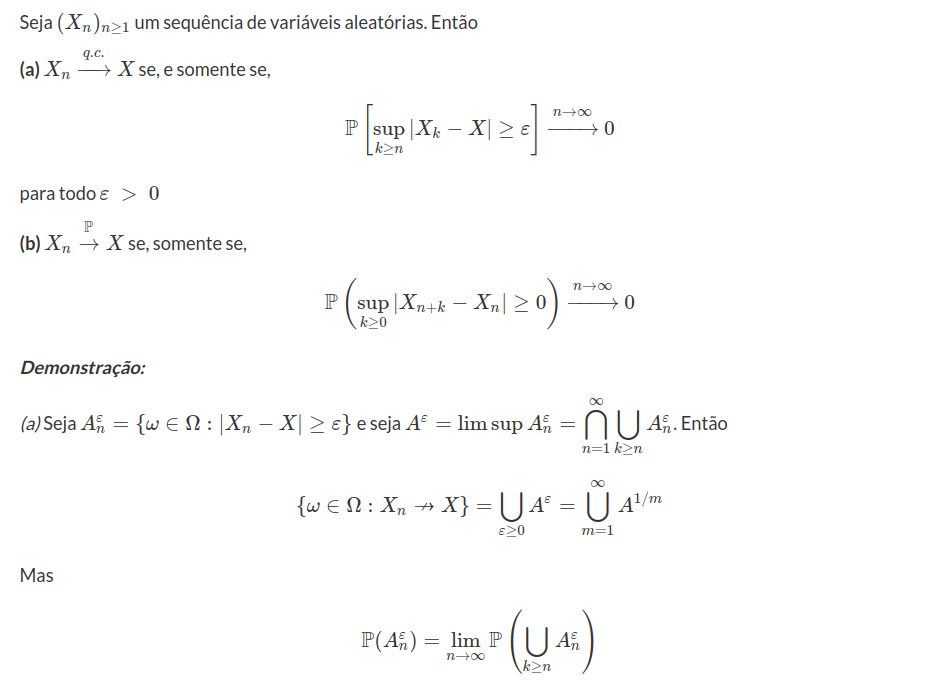

Teorema 7.1.1.8

Exemplo 7.1.1.5

Exemplo 7.1.1.6

Exemplo 7.1.1.7

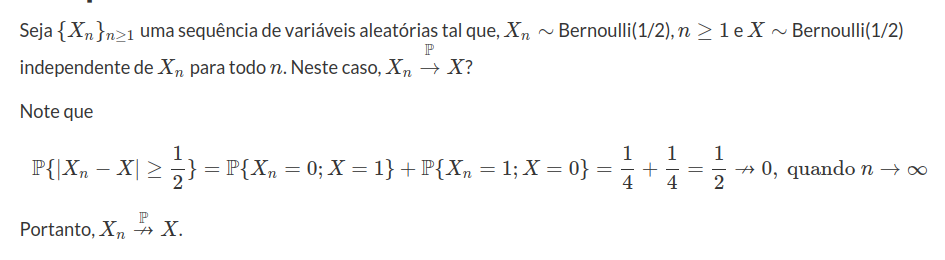

Seja $(X_n)_{n\geq 1}$ uma sequência de v.a’s independentes definidas em $(\Omega, \mathcal{A}, \mathbb{P})$, tal que $X_n\sim U(0,a_n)$, com $a_n \ > \ 0$, $n\geq 1$. Então

(a) Supondo $a_n=n$, prove que, com probabilidade 1, existe um número infinito de v.a’s $X_n$ que assumem valores menores que 1 e um número infinito $X_n$ que assumem valores maiores do que 2.

(b) Com considerações análogas as do item (a) decida sobre a convergência quase certa, no caso em que $a_n=n^2$, $n\geq 1$.

(a) Temos que:

$$\mathbb{P}(X_n \ < \ 1)= \int_{0}^{1}\frac{1}{n}dx_n=\frac{1}{n}$$

Como $\displaystyle \sum_{n=1}^{\infty}\frac{1}{n}=\infty$, então pelo Lema de Borel-Cantelli, concluímos que $\mathbb{P}(X_n \ < \ 1;~ i.v.)=1$.

Agora para

$$\mathbb{P}(X_n \ > \ 2)= \int_{2}^{n}\frac{1}{n}=\frac{n-2}{n}.$$

Como $\displaystyle \sum_{n=1}^{\infty}\frac{n-2}{n}=\infty,$ então pelo Lema de Borel-Cantelli, concluímos que $\mathbb{P}(X_n \ > \ 2;~ i.v.)=1$.

Agora do fato de existirem infitos valores menores do que 1 e infinitos valores maiores que 2, concluímos que a sequência de v.a’s $(X_n)_{n\geq 1}$ não converge quase-certamente.

(b) Temos que,

$$\mathbb{P}(X_n \ < \ 1)= \int_{0}^{1}\frac{1}{n^2}dx_n=\frac{1}{n^2}$$

Como $\displaystyle \sum_{n=1}^{\infty}\frac{1}{n^2} \ < \ \infty$, então pelo Lema de Borel-Cantelli, concluímos que $\mathbb{P}(X_n \ < \ 1;~ i.v.)=0$.

$$\mathbb{P}(X_n \ > \ 2)=\displaystyle \int_{2}^{n^2}\frac{1}{n^2}dx_n=1-\frac{2}{n^2}$$

Como $\displaystyle \sum_{n=1}^{\infty}1-\frac{2}{n^2}=\infty,$ então pelo Lema de Borel-Cantelli, concluímos que $\mathbb{P}(X_n \ > \ 2;~ i.v.)=1$.

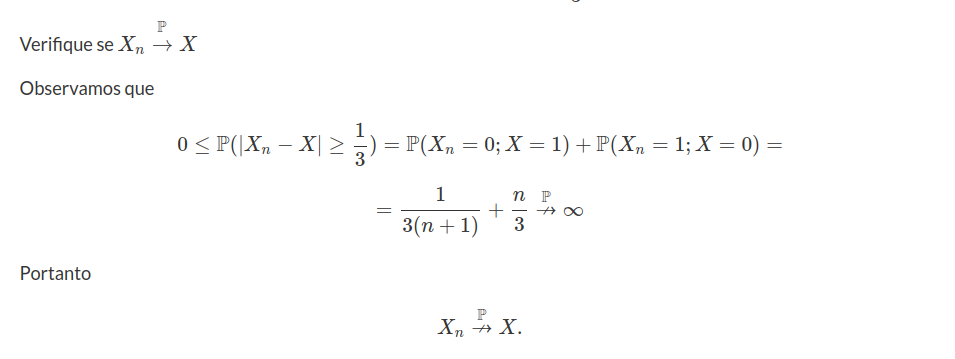

Exemplo 7.1.1.8

Considere X uma v.a. e $(X_n)_{n\geq 1}$ uma sequência de v.a’s definidas sobre $(\Omega,\mathcal{A},\mathbb{P})$, tal que a distribuição conjunta de $(X_n,X)$ seja dada por:

$$\mathbb{P}(X_n=0,X=0)=\displaystyle \frac{n}{3(n+1)}$$

$$\mathbb{P}(X_n=1,X=0)=\displaystyle \frac{1}{3(n+1)}$$

$$\mathbb{P}(X_n=0,X=1)=\displaystyle \frac{n}{3}$$

$$\mathbb{P}(X_n=1,X=1)=\displaystyle \frac{1}{3}$$

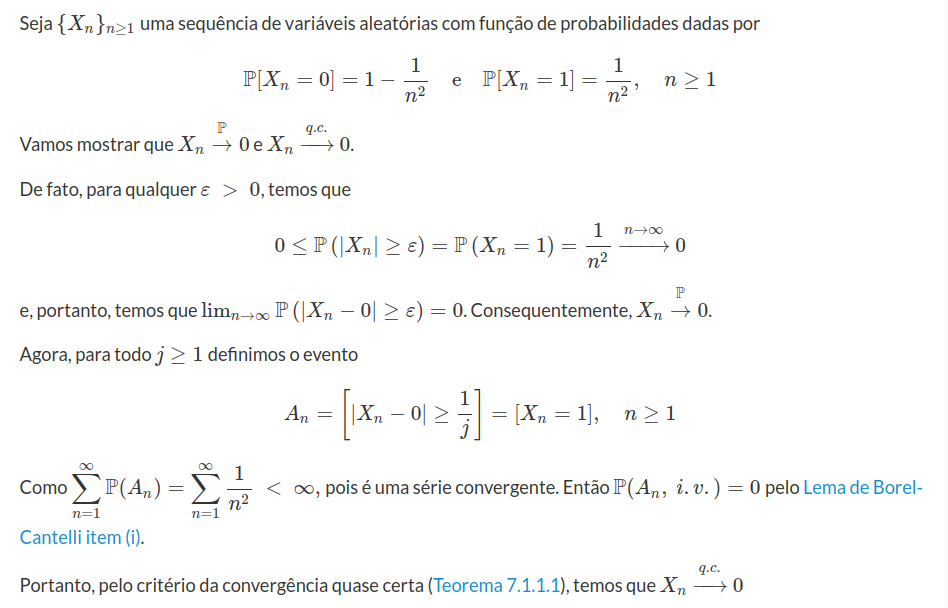

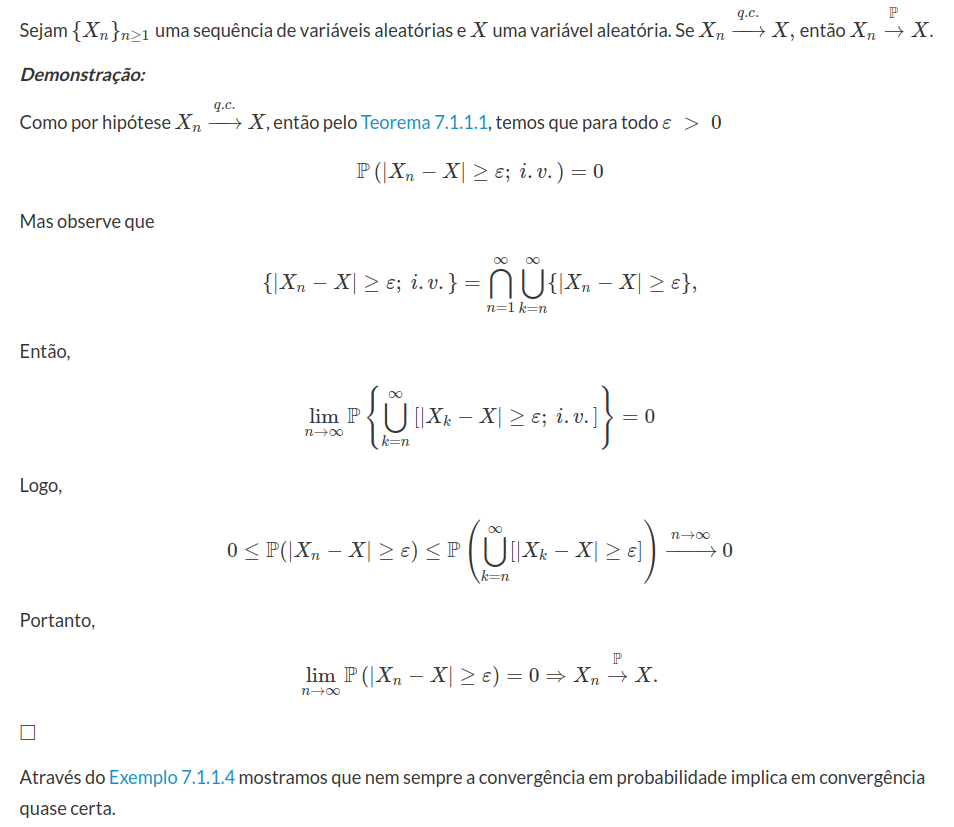

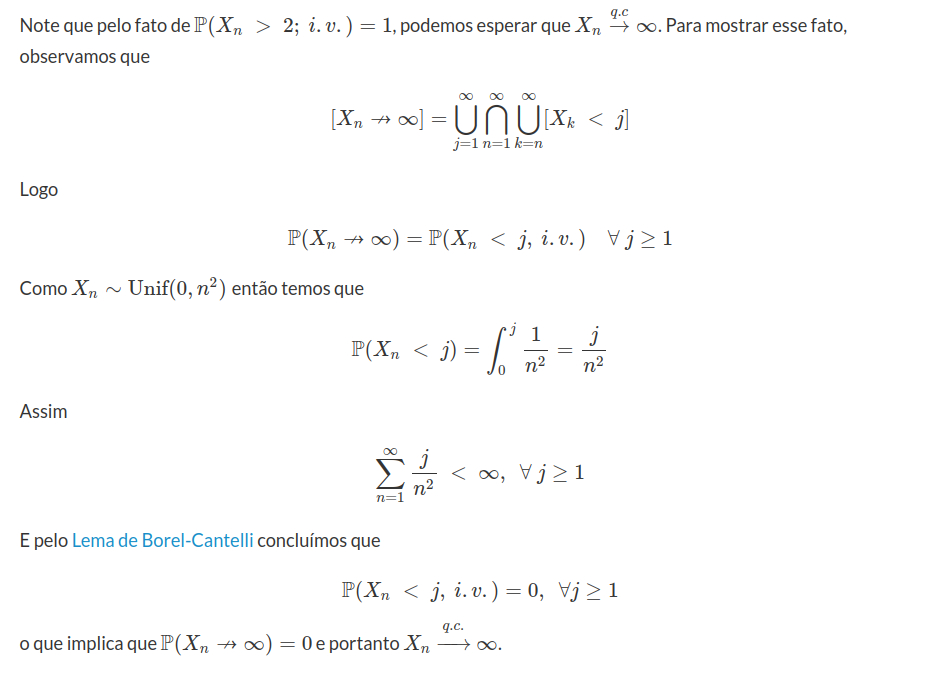

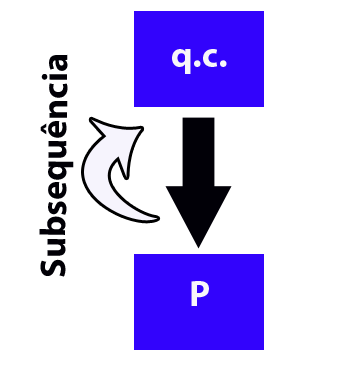

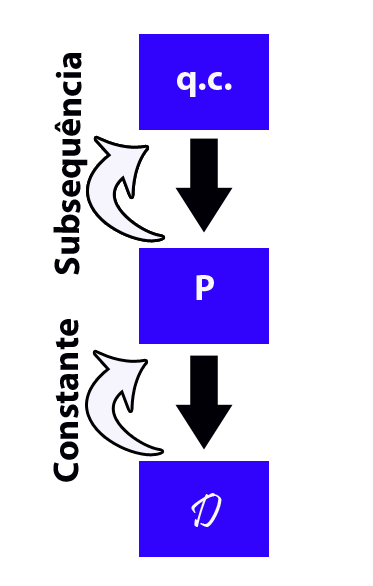

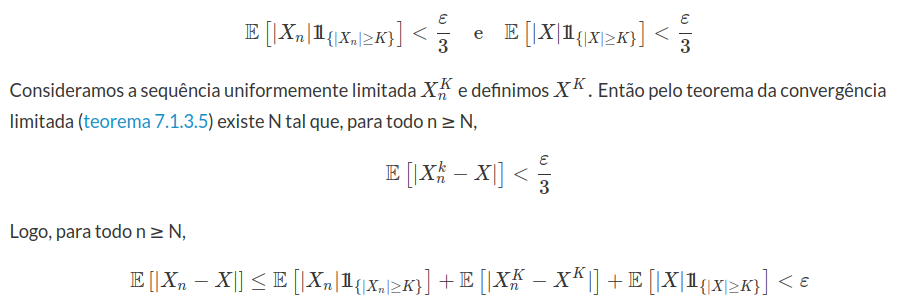

Para finalizar esta seção, vamos apresentar um diagrama dos principais resultados.

Figura 7.1.1.1: Diagrama de implicações entre os tipos de convergência.

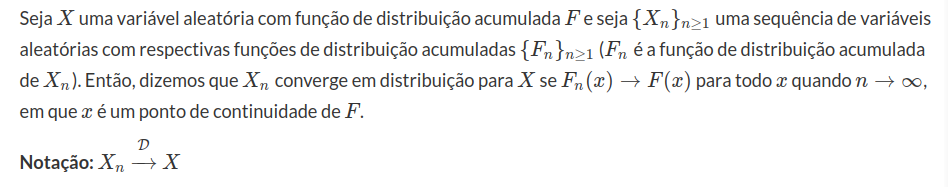

7.1.2 - Convergência em distribuição ou Convergência fraca

Nesta seção, vamos discutir algumas características da convergência em distribuição ou convergência fraca das medidas de probabilidades. A seguir, apresentamos a seguinte definição.

Definição 7.1.2.1

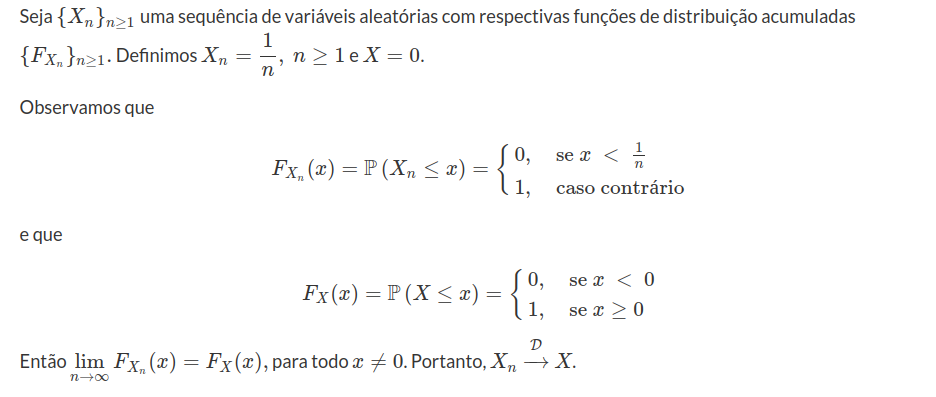

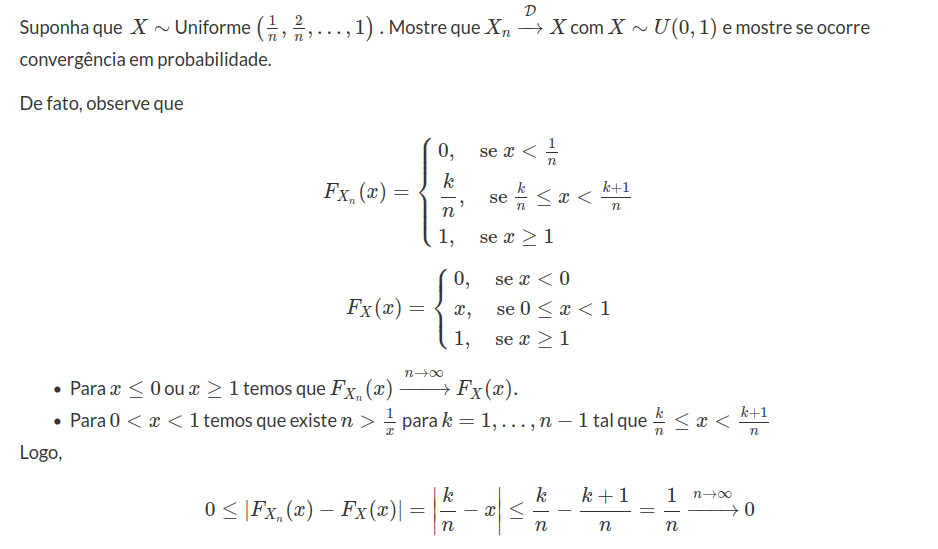

Exemplo 7.1.2.1

Teorema 7.1.2.1

Sejam $F$ uma função de distribuição acumulada e $(F_{n})_{n\geq 1}$ uma sequência de funções de distribuição acumulada. Se $F_{n}\rightarrow F$ então, para toda função $g:\mathbb{R}\rightarrow\mathbb{R}$ contínua e limitada temos que:

$$\displaystyle\int{g(x)dF_n(x)}\rightarrow \int{g(x)dF(x)}.$$

Este teorema é conhecido como teorema de Helly Bray.

Demonstração:

Queremos mostrar que $\displaystyle\int{g(x)dF_n(x)}\rightarrow \int{g(x)dF(x)}$. Para isso, precisamos mostrar que

$$\displaystyle\left|\displaystyle\int{g(x)dF_n(x)}-\int{g(x)dF(x)}\right| \ < \ \varepsilon,~~\forall \ \varepsilon \ > \ 0.$$

Sejam $-\infty \ < \ a \ < \ b \ < \ \infty$. Podemos dividir a diferença entre as integrais acima da seguinte forma:

$$\int{g(x)dF_n(x)}-\int{g(x)dF(x)}= A - B$$

em que

$$A = \int_{-\infty}^{a}{g(x)dF_n(x)} +\int_{a}^{b}{g(x)dF_n(x)}+\int_{b}^{\infty}{g(x)dF_n(x)}$$

e

$$B = \int_{-\infty}^{a}{g(x)dF(x)}+\int_{a}^{b}{g(x)dF(x)}+\int_{b}^{\infty}g(x)dF(x).$$

Por hipótese temos que $g$ é uma função limitada e, portanto, $c=\sup_{x\in \mathbb{R}}|g(x)| \ < \ \infty$. Seja $\varepsilon \ > \ 0$ arbitrário. Usando a desigualdade triangular temos que

$$\displaystyle\left|\displaystyle\int{g(x)dF_n(x)} - \int{g(x)dF(x)}\right|\leq \left|\int g(x)dF_n-\int_{a}^{b}g(x)dF_n(x)\right|+$$

$$+\left|\int_{a}^{b}g(x)dF_n(x)-\int_{a}^{b}g(x)dF(x)\right|+\left|\int_{a}^{b}g(x)dF(x)-\int g(x)dF(x)\right|.$$

Notemos o seguinte fato:

$$\displaystyle\left|\int_{-\infty}^{a}g(x)dF_n(x)-\int_{-\infty}^{a}g(x)dF(x)\right|\leq\int_{-\infty}^{a}cdF_n(x)+\int_{-\infty}^{a}cdF(x)=c[F_n(a)+F(a)].$$

Se $a$ é suficientemente pequeno, como $F$ é não decrescente temos que para $F(a)$ também será pequeno, e o mesmo vale para $F_n(a)$. Desta forma concluímos que para cada $\varepsilon_0 \ > \ 0$ existe um a tal que:

$$c[F_n(a)-F(a)] \ < \ \varepsilon_0$$

Analogamente temos:

$$\displaystyle \left|\int_{b}^{\infty}g(x)dF_n(x)-\int_{b}^{\infty}g(x)dF(x)\right|\leq \int_{b}^{\infty}cdF_n(x)-\int_{b}^{\infty}cdF(x)=c[F_n(b)-F(b)].$$

Para $b$ suficientemente grande temos que:

$$c[F_n(b)-F(b)] \ < \ \varepsilon_2.$$

Agora basta mostrarmos que:

$$\displaystyle\left|\int_{a}^{b}g(x)dF_n(x)-\int_{a}^{b}g(x)dF(x)\right| \ < \ \varepsilon_3.$$

Como por hipótese g é contínua e limitada, temos que no intervalo fechado $[a,b]$ a função g é uniformemente contínua, pois toda função contínua defina em um compacto é uniformemente contínua.

Lembrando que um compacto nos reais é um conjunto fechado e limitado.

Assim, vamos considerar a seguinte partição do intervalo [a,b]:

$$x_0=a \ < \ x_1 \ < \ \cdots \ < \ x_m=b.$$

Para $x\in\mathbb{R}$, com $x_i \ < \ x \ < \ x_{i+1}$ temos que:

$$g(x)-g(x_i) \ < \ \varepsilon_4,~~\forall i,$$

Para $\varepsilon_4 \ > \ 0$. Vamos definir uma função $g_j(x)=g(x_i)$ para todo $x\in(x_i,x_i+1)$, observemos que $g_j$ é uma função constante, desta forma mostremos o seguinte fato:

$$\displaystyle\int_{a}^{b}g(x_i)dF_n(x)=\sum_{i=0}^{m-1}g(x_i)[F_n(x_{i+1})-F_n(x_i)]\rightarrow\sum_{i=0}^{m-1}g(x_i)[F(x_{i+1})-F(x_i)]=\int_{a}^{b}g_j(x)dF(x).$$

Esta convergência decorre do fato de que por hipótese $F_n$ converge para F.

Desta forma temos que para qualquer $\varepsilon \ > \ 0$ existe um n suficientemente grande tal que:

$$\displaystyle \left|\int_{a}^{b}g_m(x)dF_n(x)-\int_{a}^{b}g_m(x)dF(x)\right|\leq\varepsilon_5.$$

Mas

$$\left|\int_{a}^{b}g(x)dF_n(x)-\int_{a}^{b}g(x)dF(x)\right|\leq$$

$$\left|\int_{a}^{b}g(x)dF_n-\int_{a}^{b}g_m(x)dF_n\right|+\left|\int_{a}^{b}g_m(x)dF_n(x)-\int_{a}^{b}g_m(x)dF(x)\right|+$$

$$+\left|\int_{a}^{b}g_m(x)dF(x)-\int_{a}^{b}g(x)dF(x)\right|\leq\left|\int_{a}^{b}\varepsilon_4dF_n+\varepsilon_5+\int_{a}^{b}\varepsilon_4dF_n\right|\leq\varepsilon_5+ 2\varepsilon_4.$$

Portanto podemos concluir que:

$$\left|\int g(x)dF_n(x)-\int g(x)dF(x)\right|\rightarrow 0,$$

$\Box$

Com isso, podemos ter uma definição alternativa, dada por

Definição 7.1.2.2

Dizemos que uma sequência de variáveis aleatórias $(X_n)_{n\geq 1}$ converge em distribuição para a variável aleatória $X$, se

$$\mathbb{E}[f(X_n)]\rightarrow \mathbb{E}[f(X)$$

para toda função contínua e limitada $f$.

Teorema 7.1.2.2

Sejam $(F_n)_{n\geq 1}$ uma sequência de funções de distribuição acumulada e $(\varphi_n)$ uma sequência de funções características, com $\varphi_n$ sendo a função característica de $F_n$. Se $\varphi_n$ converge pontualmente para $\varphi$ e $\varphi$ é contínua em zero, então existe uma função $F$ tal que $F_n \rightarrow F$ tal que $\varphi$ é a função característica de $F$.

Demonstração:

Vamos omitir a prova deste teorema por ser uma prova muito técnica, entretanto ela pode ser encontrada no livro do Barry James e em alguns outros livros que aparecem nas referências.

$\Box$

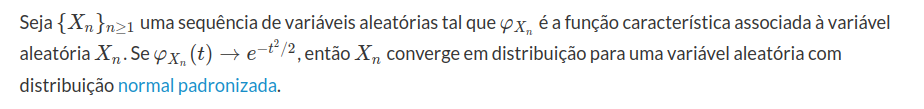

Proposição 7.1.2.1

Demonstração:

Pelo Teorema 7.1.2.2 concluímos que uma função característica define a função de distribuição acumulada de forma única. Como a função característica da distribuição normal é $e^{-t^{2}/2}$ temos que decorre imediatamente do Teorema 7.1.2.2 que $X_n$ converge para a distribuição normal.

$\Box$

Teorema 7.1.2.3

Sejam $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias, $X$ uma variável aleatória e $g$ uma função contínua a valores reais. Se $X_n$ converge em distribuição para $X$ então $g(X_n)$ também converge em distribuição para $g(X)$.

Demonstração:

Por hipótese temos que $X_n$ converge em distribuição para $X$. Assim para mostrarmos que $g(X_n)$ converge em distribuição para $g(X)$. Basta mostrarmos a convergência das funções características. Temos, por definição que

$$\varphi_{g(X_n)}(t)=\mathbb{E}[e^{itg(X_n)}]=\mathbb{E}[\cos{(tg(X_n))}]+i~\mathbb{E}[\text{sen}{(tg(X_n))}].$$

Mas $\cos$ e $\text{sen}$ são funções contínuas e limitadas e assim do Teorema 7.1.2.1 decorre que:

$$\varphi_{g(X_n)}\rightarrow \varphi_{g(X)}.$$

Portanto $g(X_n)$ converge em distribuição para $g(X)$.

$\Box$

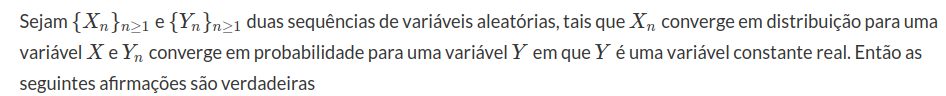

Teorema 7.1.2.4 (Slutsky)

i) $X_n+Y_n$ converge em distribuição para $X+Y.$

ii) $X_n-Y_n$ converge em distribuição para $X-Y.$

iii) $X_nY_n$ converge em distribuição para $YX.$

iv) se $Y\neq 0$ e $\mathbb{P}(Y_n\neq 0)=1$, então $\displaystyle \frac{X_n}{Y_n}$ converge em distribuição para $\displaystyle \frac{X}{Y}$.

Demonstração:

i) Basta mostrarmos que $\varphi_{X_n+Y_n}(t)\rightarrow \varphi_{X+Y}(t)$, mas temos

$$\varphi_{X_n+Y_n}=\mathbb{E}[e^{it(X_n+Y_n)}]=\mathbb{E}[e^{it(X_n+Y)}]+\mathbb{E}[e^{itX_n}(e^{itY_n}-e^{itY})].$$

Como $\mathbb{E}[e^{itX_n}]=\varphi_{X_n}(t)\rightarrow \varphi_X(t)$, e portanto

$$\mathbb{E}[e^{it(X_n+Y)}]=e^{itY}\mathbb{E}[e^{itX_n}]\rightarrow e^{itY}\varphi_X=\varphi_{X+Y}(t).$$

Desta forma, precisamos mostrar apenas que $\mathbb{E}[e^{itX_n}(e^{itY_n}-e^{itY})]\rightarrow 0$.

$$|\mathbb{E}[e^{itX_n}(e^{itY_n}-e^{itY})]|\leq \mathbb{E}[|e^{itX_n}(e^{it Y_n}e^{itY})|]=\mathbb{E}[e^{itY_n}-e^{itY}],$$

pois $|e^{itX_n}|=1$, assim precisamos apenas mostrar que $\mathbb{E}[|e^{it(Y_n-Y)}|]\rightarrow 0$. Mas esse fato é consequência do teorema da convergência dominada.

ii) Esta convergência é imediata de i), pois $-Y_n\rightarrow -Y$.

iii) Vamos supor primeiramente que $Y=0.$ Assim queremos mostrar que $Y_nX_n$ converge em probabilidade para 0, pois convergência em probabilidade implica em convergência distribuição.

Portanto sejam $\varepsilon,~\delta \ > \ 0$ e $x \ < \ 0 \ < \ y$ pontos de continuidade de $F_X$, tais que $F_X(y)-F_X(x)=\mathbb{P}[x \ < \ X \leq y] \ > \ 1-\delta$. Como por hipótese $X_n$ converge em distribuição para $X$, temos que

$$\mathbb{P}[x \ < \ X_n \leq y]=F_{X_n}(y)-F_{X_n}(x) \ > \ 1-\delta$$

para um $n$ suficientemente grande. Além disso, definimos $M=\max(y,-x).$ Então a convergência em probabilidade de $Y_n$ para zero implica que $\mathbb{P}[|Y_n| \ < \ \varepsilon/M] \ > \ 1-\delta$ para $n$ suficientemente grande.

$$\mathbb{P}[x \ < \ X_n \ < \ y, |Y| \ < \ \varepsilon/M] \ >1-2\delta.$$

isto decorre da P10.

Além disso, temos que $x \ < \ X_n \ < \ y$ e $|Y_n| \ < \ \frac{\varepsilon}{M}$ o que implica que $|X_nY_n| \ < \ \varepsilon$.

Logo $\mathbb{P}[|X_nY_n| \ < \ \varepsilon] \ > \ 1-2\delta$ para $n$ suficientemente grande.

Portanto temos que para todo $\varepsilon \ > \ 0$ temos que $\mathbb{P}[|X_nY_n| \ < \ \varepsilon]\rightarrow 1$, ou seja $X_nY_n$ converge em probabilidade para zero.

Para demonstrarmos o caso geral em que $Y=c$, basta analisarmos o seguinte fato

$$Y_nX_n=YX_n+(Yn-Y)X_n$$

e $Y_n-Y$ converge em probabilidade para zero, assim segue do caso em que $Y=0$ que $(Y_n-Y)X_n$ converge em probabilidade para zero.

Além disso, temos que

$$\varphi_{cX_n}(t)=\varphi_{X_n}(ct)\rightarrow \varphi_{X}(ct)=\varphi_{cX}(t)=\varphi_{YX}(t),$$

Assim do Teorema 7.1.2.5 decorre que $YX_n$ converge $YX$. Agora o resultado segue imediatamente do item i), pois temos a soma de dois termos em que um que converge em probabilidade para zero e outro converge em distribuição para $YX$.

iv) Notemos que do Teorema 7.1.2.4 que $\frac{1}{Y_n}$ converge em probabilidade para $\frac{1}{Y}$ e em seguida basta aplicarmos o item iii) que o resultado segue.

$\Box$

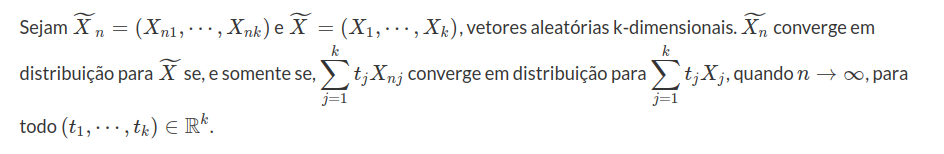

Teorema 7.1.2.4 (Cramér-Wold)

Demonstração:

Para iniciarmos essa demonstração vamos definir a função característica de um vetor aleatório.

Assim, consideramos um vetor j-dimensional $\widetilde{X}=(X_1,\cdots,X_j)$ a função característica de $\widetilde{X}$ é a função $\varphi_{\widetilde{X}}:\mathbb{R}^j\rightarrow C$ a qual é definida por:

$$\displaystyle\varphi_{\widetilde{X}}(t_1,\cdots,t_j)=\mathbb{E}\left[\exp\left(i\sum_{k=1}^{j}t_jX_j\right)\right]=E\left[e^{i\widetilde{t} \widetilde{X}}\right].$$

Agora com a definição da função característica para um vetor aleatório em mãos podemos finalmente partir para a demonstração do teorema de Cramér-Wold.

Suponhamos que $\sum_{j=1}^{k}t_jX_{nj}$ converge em distribuição para

$$\sum_{j=1}^{k}t_jX_{j}$$

Neste caso temos que:

$$\varphi_{X_n}(t_1,\cdots,t_k)=\mathbb{E}[e^{i\sum_{j=1}^{k}t_jX_{nj}}]$$

$$\varphi_{\sum_{j=1}^{k}t_jX_{nj}}(1)\rightarrow\varphi_{\sum_{j=1}^{k}tjXj}(1)=\varphi_{\widetilde{X}}(t_1,\cdots,t_k)$$

Assim decorre imediatamente que como $\varphi_{\widetilde{X_n}}\rightarrow\varphi_{\widetilde{X}}$ que $\widetilde{X_n}$ converge em distribuição para $X$.

Agora vamos supor o caso contrário, suponha que $X_n$ converge em distribuição para $X$.

Assim notemos que:

$$\varphi_{\sum_{j=1}^{k}tjX_{nj}}=E\left[e^{it\sum_{j=1}^{k}t_jX_{nj}}\right]=E\left[e^{i \sum_{j=1}^{k}tt_jX_{nj}}\right]=$$

$$=\varphi_{\widetilde{X_n}}(tt_1,\cdots,tt_k)\rightarrow\varphi_{\widetilde{X}}(tt_1,\cdots,tt_k)=\varphi_{\sum_{j=1}^{k}t_jX_j}(t).$$

Portanto $$\sum_{j=1}^{k}t_jX_{nj}$$

converge em distribuição para $$\sum_{j=1}^{k}t_jX_{j}$$

$\Box$

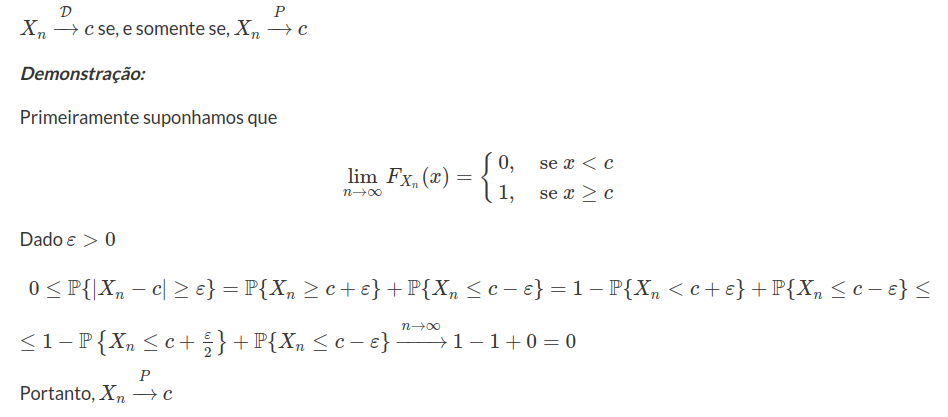

Proposição 7.1.2.2

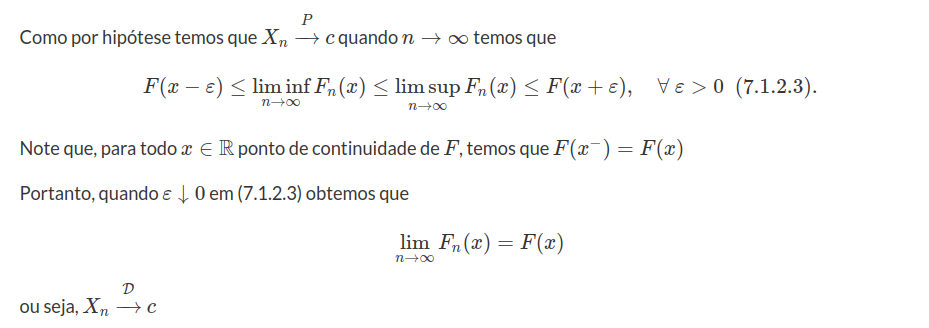

Reciprocamente, seja $F_n$ a função distribuição acumulada de $X_n,~n\geq 1.$ Fixamos $x\in\mathbb{R}$ para todo $x$ ponto de continuidade de $F$. Então para todo $\varepsilon>0$

$$\mathbb{P}(X_n\leq x)\leq\mathbb{P}(X\leq x+\varepsilon)+\mathbb{P}(X_n\leq x~;~X> x+\varepsilon)\leq \mathbb{P}(X\leq x+\varepsilon)+\mathbb{P}(|X_n-c|>\varepsilon)~~(7.1.2.1)$$

e similarmente

$$\mathbb{P}(X_n\leq x)\geq\mathbb{P}(X\leq x-\varepsilon)-\mathbb{P}(|X_n-c|>\varepsilon)~~(7.1.2.2)$$

Logo, de (7.1.2.1) e (7.1.2.2) obtemos que

$$F(x-\varepsilon)-\mathbb{P}(|X_n-c|> \varepsilon)\leq F_n(x)\leq F(x+\varepsilon)+\mathbb{P}(|X_n-c|>\varepsilon)$$

$\Box$

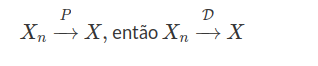

Teorema 7.1.2.5

Demonstração:

Basta, usar a volta da proposição 7.1.2.2 trocando c por $X.$

$\Box$

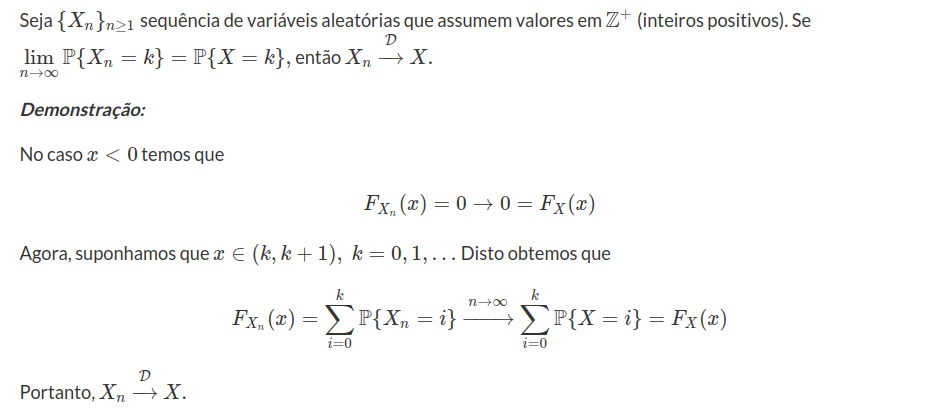

Proposição 7.1.2.3: (Caso discreto)

$\Box$

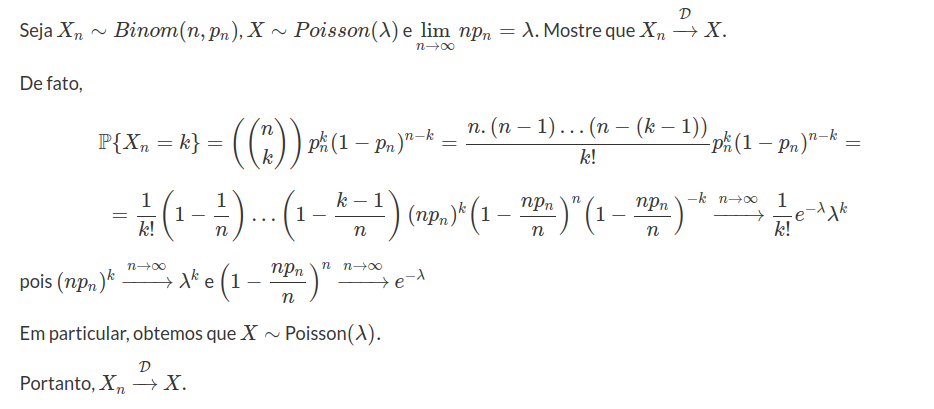

Exemplo 7.1.2.2

Exemplo 7.1.2.3

Portanto segue o resultado.

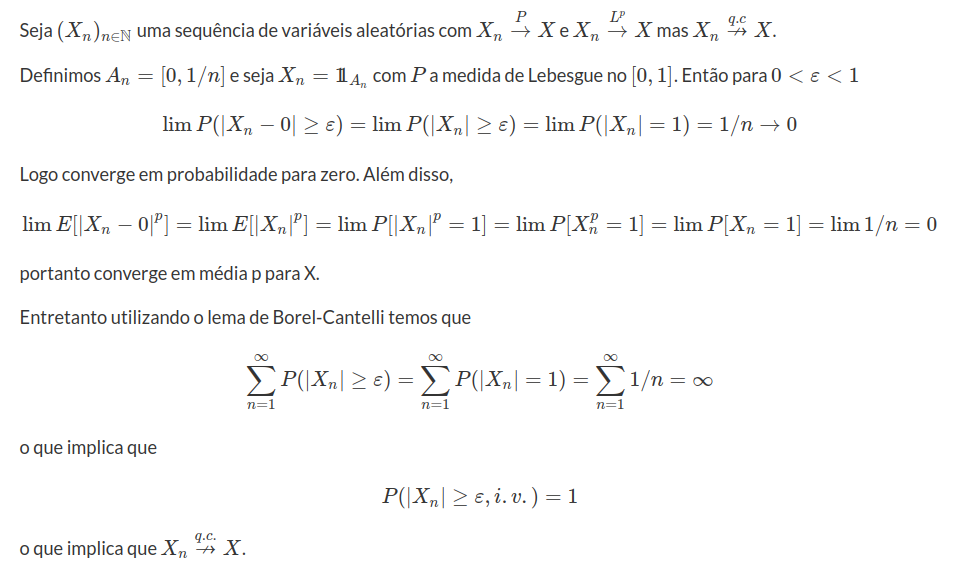

Agora, apresentamos um exemplo de uma sequência de variáveis aleatórias a qual converge em probabilidade e em média p para X $\forall p\geq 1$, mas não converge quase certamente.

Exemplo 7.1.2.4

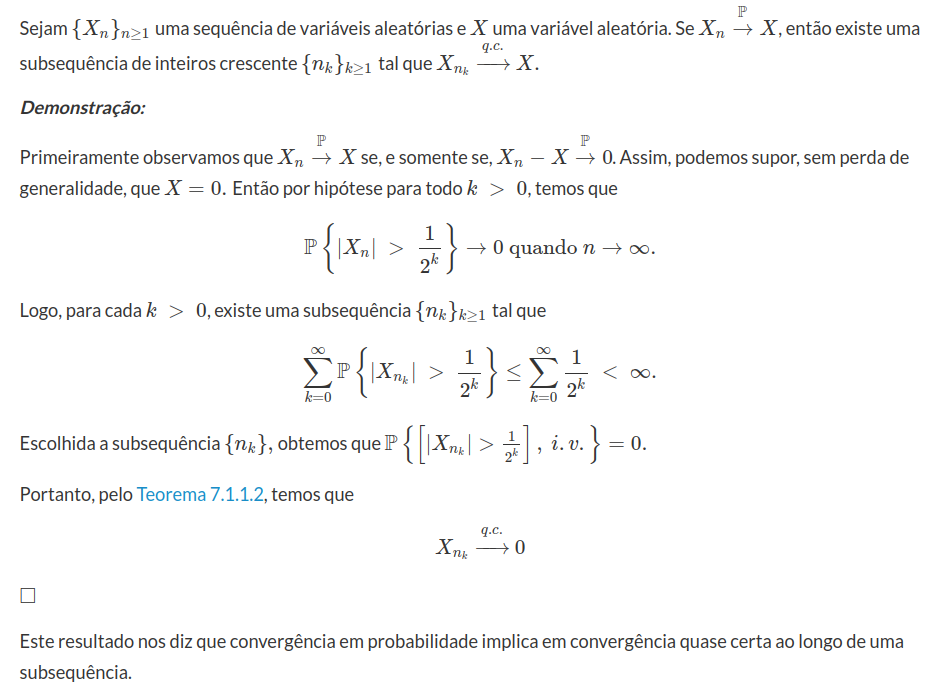

Para finalizar esta seção, vamos apresentar um diagrama dos principais resultados.

Figura 7.1.2.1: Diagrama de implicações entre os tipos de convergência.

7.1.3 - Convergência em média p

Nesta seção, vamos estudar as convergências em média p, porém, inicialmente necessitamos de desigualdades importantes como por exemplo as desigualdades de Markov e Chebyshev. Chebyshev estabeleceu uma simples desigualdade que permitiu uma prova trivial da Lei dos Fraca dos Grandes Números. A seguir, apresentamos as principais desigualdades.

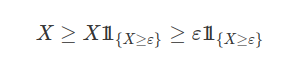

Proposição 7.1.3.1 (Desigualdade de Markov)

Seja X uma variável aleatória não negativa, ou seja, que assume apenas valores reais positivos. Então temos que para qualquer $\varepsilon > 0$:

$$\mathbb{P}[X > \varepsilon]\leq \displaystyle \frac{\mathbb{E}[X]}{\varepsilon}$$

Demonstração:

Para todo $\varepsilon > 0$, observe que

Logo, $\mathbb{E}[X]\geq \varepsilon \mathbb{P}(X\geq \varepsilon)$

Portanto, $\mathbb{P}(X\geq \varepsilon ) \leq \dfrac{\mathbb{E}[X]}{\varepsilon}$ segue a desigualdade de Markov.

$\Box$

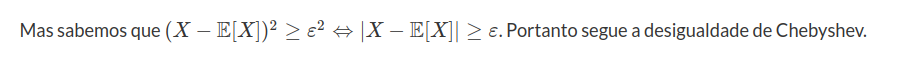

Proposição 7.1.3.2 (Desigualdade de Chebyshev)

Seja X uma variável aleatória tal que $\mathbb{E}(X)< \infty$, $\text{Var}(X)<\infty$ e $\varepsilon > 0$ então:

$$\mathbb{P}[|X-\mathbb{E}[X]|> \varepsilon]\leq \displaystyle \frac{\text{Var}(X)}{\varepsilon^2}.$$

Demonstração:

Primeiramente vamos definir uma variável aleatória $Y=(X-\mathbb{E}[X])^2.$ Note que a variável Y satisfaz as hipóteses da desigualdade de Markov, pois Y é uma variável não negativa. Assim, temos que:

$$\mathbb{P}[Y> \varepsilon^2]\leq \displaystyle \dfrac{\mathbb{E}[Y]}{\varepsilon^2}=\dfrac{\mathbb{E}[(X-\mathbb{E}[X])^2]}{\varepsilon^2}$$

Por definição temos que $\mathbb{E}[(X-\mathbb{E}[X])^2]=\text{Var}[X],$ então

$$\mathbb{P}[Y> \varepsilon^2]\leq \displaystyle \frac{\text{Var}[X]}{\varepsilon^2}.$$

$\Box$

A seguir, vamos enunciar uma desigualdade importante, que é a desigualdade de Jensen, muito utilizada na teoria das probabilidades. Johan Valdemar Jensen, engenheiro de telecomunicações dinamarquês, publicou esta desigualdade em 1906 na Acta Matemática.

Proposição 7.1.3.3 (Desigualdade de Jensen)

Seja X uma variável aleatória, então para toda a variável aleatória $X\in \mathcal{L}^1(\mathbb{P})$ tal que $-\infty\leq a< X< b\leq +\infty$ e $\varphi: (a,b)\rightarrow \mathbb{R}$ convexa

$$\varphi(\mathbb{E}[X])\leq \mathbb{E}[\varphi(X)]$$

Demonstração:

Ideia intuitiva: (Caso particular) Seja $\varphi(x)=x^2$ uma função $\varphi: (a,b)\rightarrow \mathbb{R}$ convexa. Vimos na seção variância de variáveis aleatórias que

$$\text{Var}(X)=\mathbb{E}(X^2)-[\mathbb{E}(X)]^2.$$

Podemos rescrever como

$$\mathbb{E}(X^2)=\underbrace{\text{Var}(X)}_{\geq 0}+[\mathbb{E}(X)]^2\geq [\mathbb{E}(X)]^2$$

O caso geral, pode ser visto no artigo de Johan L. W. V. Jensen. Podemos ver uma outra demonstração no conteúdo Propriedades do valor esperado.

$\Box$

Proposição 7.1.3.4 (Desigualdade de Cauchy-Schwartz)

Sejam X e Y uma variáveis aleatórias, tais que $\mathbb{E}[X^2]<\infty$ e $\mathbb{E}[Y^2]<\infty,$ então

$$\mathbb{E}[|X|.|Y|]\leq \sqrt{\mathbb{E}[X^2]\mathbb{E}[Y^2]}$$

Demonstração:

Para $\lambda\in \mathbb{R},$

$$0\leq\mathbb{E}\left[(\lambda|X|+|Y|)^2\right]=\mathbb{E}[\lambda^2|X|^2+2\lambda|X|.|Y|+|Y|^2]=\lambda^2\mathbb{E}[X^2]+2\lambda\mathbb{E}[|X|.|Y|]+\mathbb{E}[|Y|^2]$$

Usamos a ideia do discriminante na solução da equação do 2º grau da seguinte forma

$$\Delta=4(\mathbb{E}[|X|.|Y|])^2-4\mathbb{E}[|X|^2]\mathbb{E}[|Y|^2]\leq0$$

Portanto,

$$\mathbb{E}[|X|.|Y|]\leq \sqrt{\mathbb{E}[X^2]\mathbb{E}[Y^2]}$$

$\Box$

Com isso, vamos definir a convergência em média p da seguinte forma.

Definição 7.1.3.1

Considere $X$ uma variável aleatória com $\mathbb{E}[|X|^p]< \infty$ e $(X_n)_{n\geq 1}$ sequência de variáveis aleatórias. Dizemos que $X_n$ converge em média p para X ou converge em $\mathcal{L}^p$ para X (caso queira saber mais sobre os espaço $\mathcal{L}^p$ consulte o conteúdo Propriedades do espaço L^p) se

$$\lim_{n\rightarrow\infty}\mathbb{E}\left[|X_n-X|^p\right]=0,\quad \text{para}~p\geq 1$$

Observação

quando $p=2,$ dizemos que converge em média quadrática.

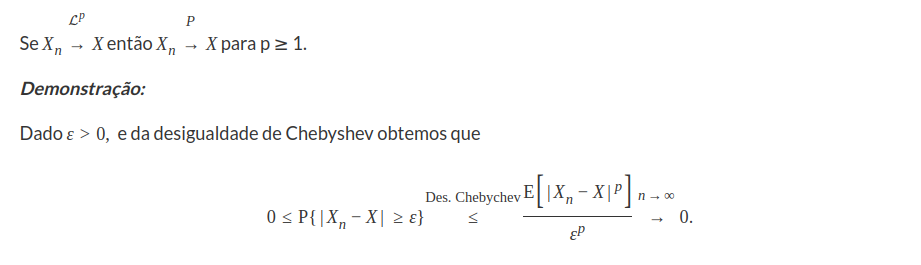

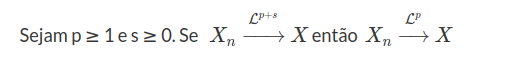

Teorema 7.1.3.1

$\Box$

Lema 7.1.3.1

$\Box$

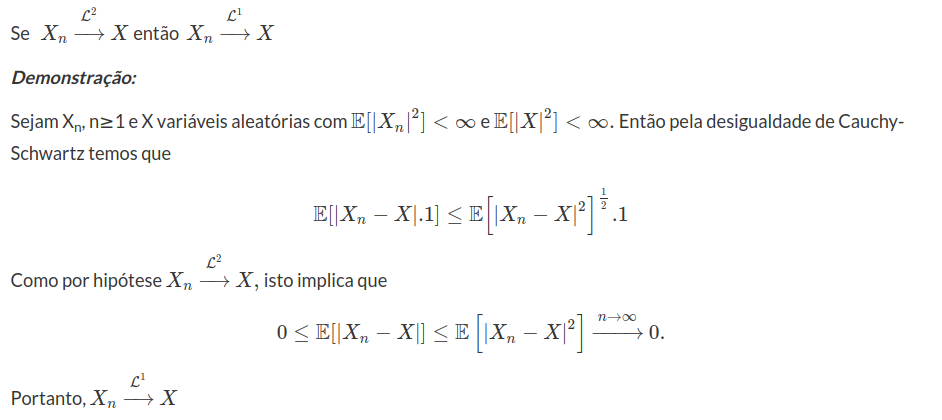

Teorema 7.1.3.2

Demonstração:

Consideramos $q=p+s$ e pela desigualdade de Jensen obtemos que

$$\left(\mathbb{E}|X_n-X|^p\right)^{\frac{1}{p}}\leq \left(\mathbb{E}|X_n-X|^q\right)^{\frac{1}{q}}\rightarrow 0$$

$\Box$

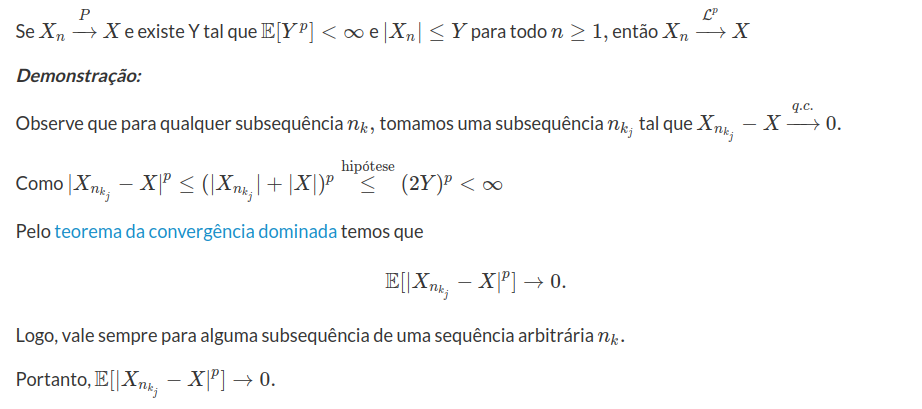

No caso particular, temos que se $X_{n}$ converge em média quadrática para X, então também $X_{n}$ converge em média para X (lema 7.1.3.1). No teorema 7.1.3.1 vimos que se $X_{n}$ converge em média p para X então converge em probabilidade, porém a recíproca nem sempre é verdadeira. A seguir, apresentamos um caso particular em que vale a volta.

Teorema 7.1.3.3 (Caso dominado)

$\Box$

Teorema 7.1.3.4

Seja $(X_n)$ uma sequência de variáveis aleatórias não negativas tal que

$X_n\stackrel{q.c}{\rightarrow}X$ e $\mathbb{E}[X_n]\rightarrow \mathbb{E}[X]$, então $X_n\stackrel{\mathcal{L}^1}{\rightarrow}X$

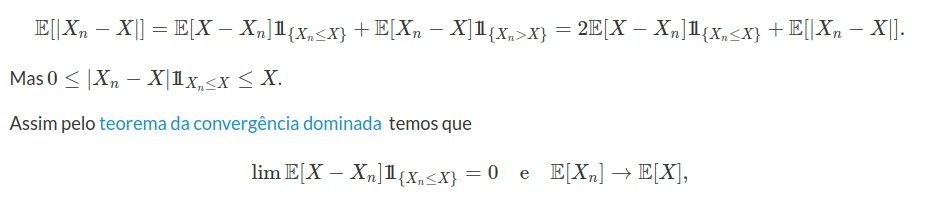

Demonstração:

Para n suficientemente grande temos que $\mathbb{E}[X_n]< \infty$ e temos que

o que prova o resultado.

$\Box$

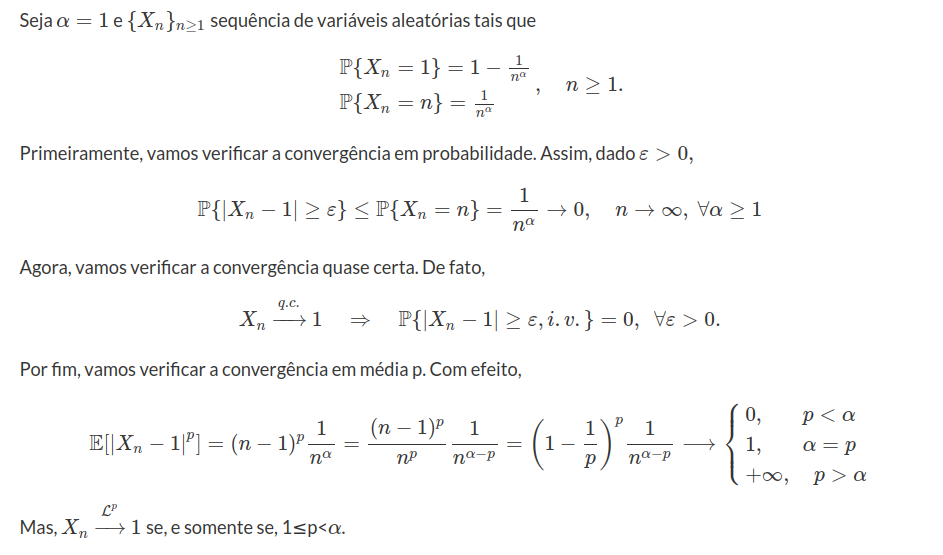

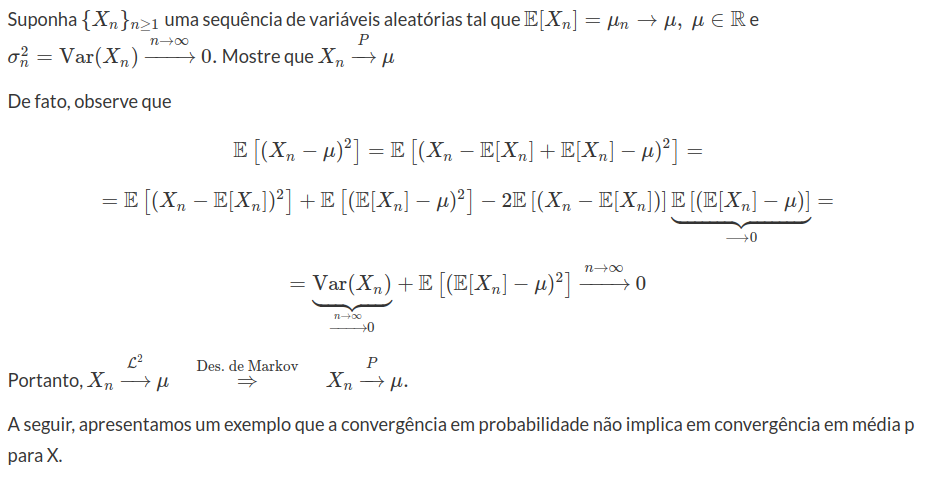

Exemplo 7.1.3.1

Exemplo 7.1.3.2

$$\varepsilon\leq |X-Y|\leq |X_n-X|+|X_n-Y|$$

Agora, observamos os seguintes eventos

$$[|X-Y|\geq \varepsilon]\subseteq [|X_n-X|\geq \frac{\varepsilon}{2}]\cup[|X_n-Y|\geq \frac{\varepsilon}{2}].$$

Logo,

$$0\leq \mathbb{P}[|X-Y|\geq \varepsilon]\leq \mathbb{P}[|X_n-X|\geq \frac{\varepsilon}{2}]+[|X_n-Y|\geq \frac{\varepsilon}{2}]\rightarrow 0$$

o que implica que $\mathbb{P}[|X-Y|\geq \varepsilon]\rightarrow 0,~\forall \varepsilon> 0$

Portanto, $$\mathbb{P}[|X-Y|> 0]=\lim_{n\rightarrow \infty}\mathbb{P}\left(|X-Y|> \frac{1}{n}\right)=0.$$

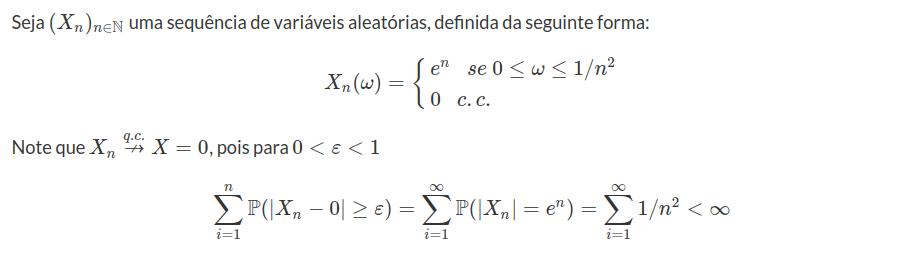

Exemplo 7.1.3.3

Exemplo 7.1.3.4

Logo converge quase certamente e portanto converge em probabilidade. Mas observe que não converge em média p para $X=0$, pois

$$\lim_{n\rightarrow\infty} \mathbb{E}[|X_n|^p]=\lim_{n\rightarrow\infty} \frac{e^{np}}{n^2}=\infty, ~~\forall p\geq 1.$$

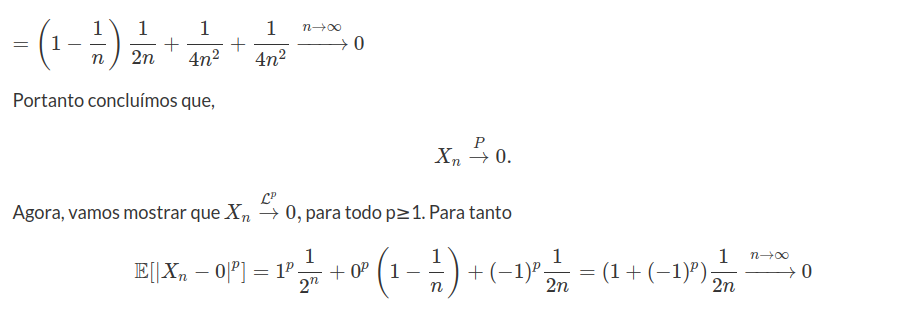

Exemplo 7.1.3.5

Suponha $(X_n)_{n\geq 1}$ uma sequência de v.a’s tal que

$$\mathbb{P}(X=0)=1-\displaystyle \frac{1}{n}$$

$$\mathbb{P}(X_n=1)=\displaystyle \frac{1}{2n}=\mathbb{P}(X_n=-1).$$

Mostre que $X_n\stackrel{P}{\rightarrow} 0$ e $X_n\stackrel{\mathcal{L}^p}{\rightarrow} 0,$ para todo p≥1.

Primeiramente vamos mostrar que $X_n\stackrel{P}{\rightarrow} 0.$ Para isto, dado ε>0,

$$\mathbb{P}(|X_n-0|\geq \varepsilon)=\mathbb{P}(X_n=0;X=0)+\mathbb{P}(X_n=0;X=1)+\mathbb{P}(X_n=0;X=-1)=$$

Portanto $X_n\stackrel{\mathcal{L}^p}{\rightarrow} 0.$

Exemplo 7.1.3.6

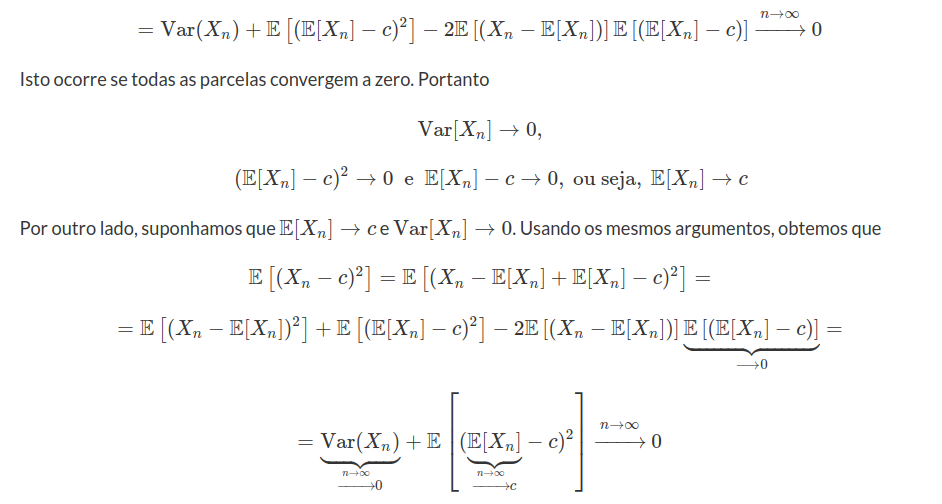

Para $c\in\mathbb{R}$, constante, mostre que $X_n\stackrel{\mathcal{L}^2}{\rightarrow} c$ se, e somente se, $\mathbb{E}[X_n]\rightarrow c$ e $Var[X_n]\rightarrow 0$.

Primeiramente supomos que $X_n\stackrel{\mathcal{L}^2}{\rightarrow} c$.

$$\mathbb{E}\left[(X_n-c)^2\right]=\mathbb{E}\left[(X_n-\mathbb{E}[X_n]+\mathbb{E}[X_n]-c)^2\right]=$$

$$=\mathbb{E}\left[(X_n-\mathbb{E}[X_n])^2\right]+\mathbb{E}\left[(\mathbb{E}[X_n]-c)^2\right]-2\mathbb{E}\left[(X_n-\mathbb{E}[X_n])\right]\mathbb{E}\left[(\mathbb{E}[X_n]-c)\right]=$$

Portanto $X_n\stackrel{\mathcal{L}^2}{\rightarrow} c.$

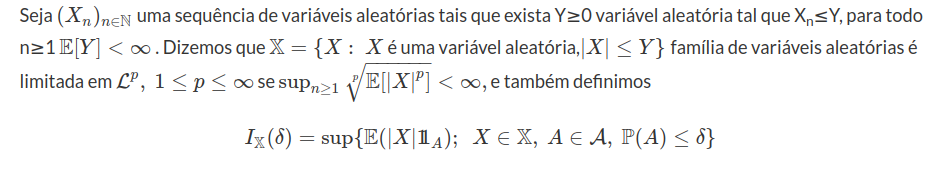

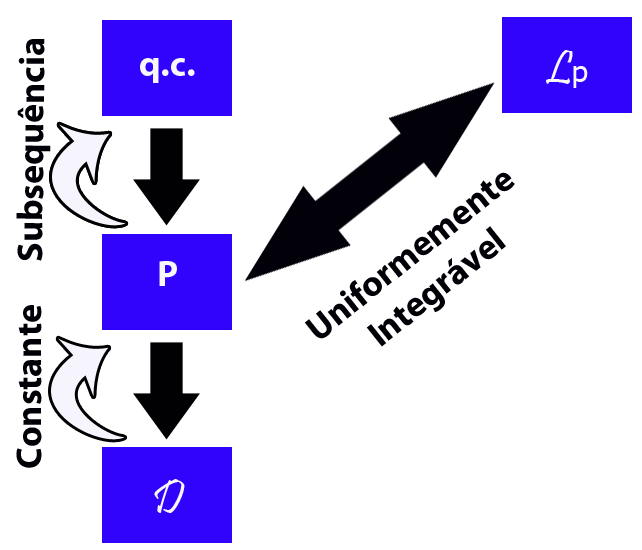

Uniformemente integrável e limitado em $\mathcal{L}^1$

A principal preocupação entre as relações dos tipos de convergência estocástica é saber se é uma condição necessária e suficiente. Para isto vamos introduzir o conceito de Uniformemente Integrável (UI) e limitado em $\mathcal{L}^1.$ A seguir, vamos apresentar resultados e definições para mostrar que uma condição necessária e suficiente para que a convergência em média p para X, implique em convergência em probabilidade.

Definição 7.1.3.2

Obs: (caso queira saber mais sobre os espaço $\mathcal{L}^p$ consulte o conteúdo Propriedades do espaço L^p)

Observamos que $\mathbb{X}$ é limitada em $\mathcal{L}^1$ se, e somente se $I_{\mathbb{X}}(1)< \infty.$

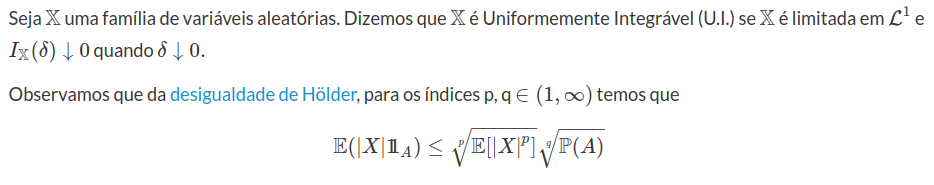

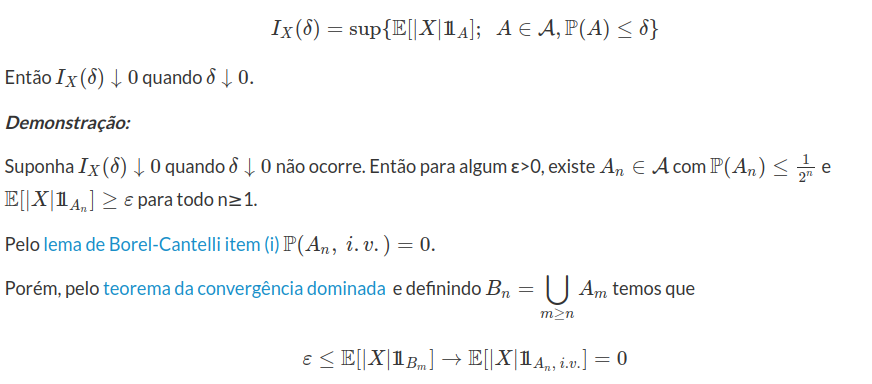

Definição 7.1.3.3

Logo, se $\mathbb{X}$ é limitada em $\mathcal{L}^p$ para algum p$\in(1,\infty)$ então $\mathbb{X}$ é U.I.

Lema 7.1.3.1

Seja $(\Omega,\mathcal{A},\mathbb{P})$ espaço de probabilidade fixado e X uma variável aleatória integrável e o conjunto

que é uma contradição.

$\Box$

A seguir, apresentamos uma outra caracterização de U.I.

Lema 7.1.3.2

Seja $\mathbb{X}$ uma família de variáveis aleatórias. Então $\mathbb{X}$ é U.I. se, e somente se,

Portanto, $\mathbb{X}$ é U.I.

$\Box$

Agora, necessitamos de uma definição e um resultado que são de grande importância para demonstração do último resultado deste assunto.

Definição 7.1.3.4

Teorema 7.1.3.5

Demonstração:

Vamos omitir esta demonstração, pois necessitamos de resultados de análise funcional.

$\Box$

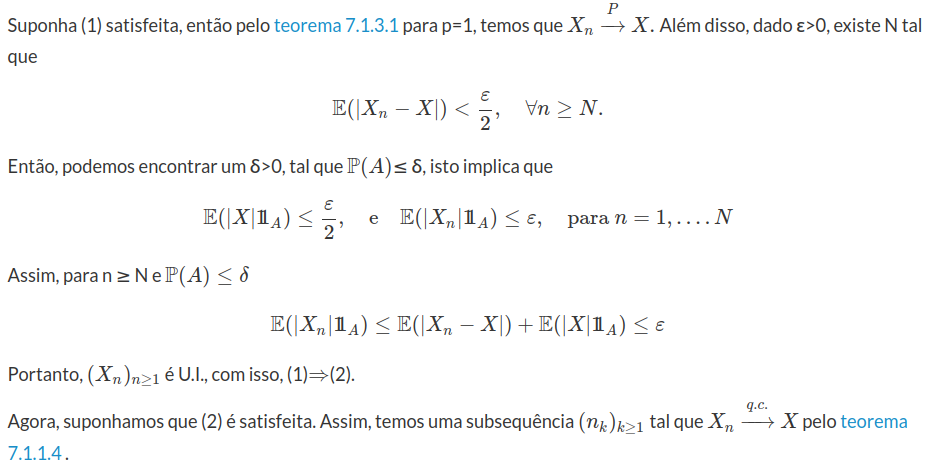

Finalmente, vamos provar o resultado que mostra a condição necessária e suficiente para que a convergência em média p para X, implique em convergência em probabilidade.

Teorema 7.1.3.6

Seja $(X_n)_{n\geq 1}$ uma sequência de variáveis aleatórias e X variável aleatória. Obtemos as seguintes equivalências:

Demonstração:

Inicialmente, vamos enunciar o lema de Fatou.

Lema de Fatou

Considere $(X_n)_{n\geq 1}$ sequência de variáveis aleatórias não negativas. Então pelo Teorema da Convergência Monótona temos que $\mathbb{E}[\liminf Xn]\leq\liminf_n \mathbb{E}[X_n].$

Logo, pelo lema de Fatou $\mathbb{E}[|X|]\leq\displaystyle\liminf_k \mathbb{E}[|X_{n_k}|]<\infty.$

Com isso, dado ε > 0, existe um K < ∞ tal que para todo n ≥ 1, temos que

Como tomamos um ε > 0 arbritrário, podemos concluir que (2)$\rightarrow$(1).

$\Box$

Para finalizar esta seção, vamos apresentar um diagrama dos principais resultados.

Figura 7.1.3.1: Diagrama de implicações entre os tipos de convergência.

7.2 - Lei dos Grandes Números

A lei dos grandes números foi primeiramente provada pelo matemático James Bernoulli na quarta parte de seu livro Ars Conjectandi publicado em 1713. Como acontece na maioria dos casos, a prova dada por Bernoulli é muito mais difícil do que a realizada com a desigualdade de Chebyshev. Chebyshev desenvolveu sua desigualdade (uma generalização da desigualdade de Markov) para demonstrar uma forma mais geral da Lei dos Grandes Números.

A lei dos grandes números é uma das principais leis assintóticas da estatística, sua ideia é bastante intuitiva, mas de grande importância. Antes de enunciarmos esta lei, vamos tentar analisar a ideia intuitiva dela.

Por exemplo, seja X uma variável aleatória que representa o lançamento de uma moeda honesta, no qual $X(cara)=1$ e $X(coroa)=0.$ Se lançarmos essa moeda n vezes então temos que a média aritmética dos valores observados tendem a 1/2, ou seja, tendem a $\mathbb{E}[X].$ A lei dos grandes números nos diz que a média aritmética dos valores observados tendem a esperança da variável aleatória.

Um outro exemplo, é quando lançamos um dado equilibrado, com as faces numeradas de 1 a 6. A probabilidade de obtermos o número 4 é de $\dfrac{1}{6}=0,16666\dots,$ pois os eventos são equiprováveis. Vamos simular os resultados no computador da seguinte forma. Primeiramente lançamos os dados 100 vezes e anotamos quantas vezes a face 4 aparece nos resultados e por fim calculamos a proporção de vezes que a face 4 aparece. Repetimos isto para 1000 e 10000 lançamentos. Assim, obtemos os seguintes resultados:

| Lançamentos | Face do dado igual a 4 | Proporção de face igual a 4 |

|---|---|---|

| 100 | 11 | 0,11 |

| 1000 | 159 | 0,159 |

| 10000 | 1660 | 0,166 |

Observe que quanto maior o número de lançamentos do dado, mais o resultado experimental se aproxima da probabilidade esperada.

7.2.1 - Lei Fraca dos Grandes Números

Fundada no final do século XIX, a escola de São Petersburgo produziu grandes matemáticos russos com grandes contribuições à Lei dos Grandes Números. Chebyshev influenciado por grandes matemáticos russos, publicou o importante livro Fundamentos da teoria matemática de probabilidades, que fazem parte das linhas estudadas por Daniel Bernoulli e Euler em São Petersburgo. Chebyshev foi o primeiro a raciocinar sistematicamente em termos de variáveis aleatórias e seus momentos. Chebyshev estabeleceu uma simples desigualdade que permitiu uma prova trivial da Lei Fraca dos Grandes Números.

Antes de definirmos e demonstrarmos formalmente a Lei Fraca dos Grandes Números, vamos necessitar de conhecimento de convergência em probabilidade e quase certa e de algumas desigualdades importantes , como as desigualdades de Markov e Chebyshev (para mais detalhes consulte o conteúdo de convergência de variáveis aleatórias).

A principal diferença entre a lei fraca e a lei forte dos grandes números é que a primeira converge em probabilidade e a segunda converge quase certamente. A convergência em probabilidade é uma convergência mais fraca que a convergência quase certa, pois se houver convergência quase certa há convergência em probabilidade. Vejamos isto através da seguinte proposição.

Proposição 7.1.1.1

Se uma sequência de variáveis aleatórias $Y_n$ sobre um espaço de probabilidade $(\Omega , \mathcal{F} , \mathbb{P} )$ converge quase certamente para uma variável aleatória $Y $ então $Y_n \to Y$ em probabilidade.

Demonstração:

Dado $\varepsilon > \ 0 $ tome $ S_m = ( Y_m : Y_m - Y > \varepsilon ) $ para todo $m \in \mathbb{N} $.

Como $Y_m \to Y $ quase certamente, temos

$\mathbb{P}(\limsup S_m ) \leq \limsup \mathbb{P}(S_m ) = 0 $ e $\mathbb{P}(S_m ) \ge 0$ para todo $m \in \mathbb{N} $. Assim temos $\mathbb{P}(S_m ) \to 0$

$\Box$

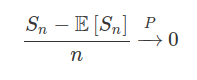

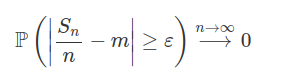

Teorema 7.1.1.1 (Lei Fraca de Chebyshev)

Sejam $X_i$ uma sequência enumerável de variáveis aleatórias independentes dois a dois. Se a sequência $X_i$ tem variância finita e uniformemente limitada, ou seja, existe uma constante $c\in \mathbb{R}$ tal que $\text{Var}[X_i]\leq c$. Então a sequência $X_i$ satisfaz a Lei Fraca dos Grandes Números:

em que $\displaystyle S_n=\sum_{i=1}^{n}X_i$

Demonstração:

Como $X_i$ são independentes temos que $\text{Var}\left[S_n\right]=\displaystyle\sum_{i=1}^{n}\text{Var}[X_i]\leq nc,$ logo as hipóteses da desigualdade de Chebyshev são satisfeitas.

Portanto, temos que

$$\mathbb{P}\left[\left|\displaystyle S_n - \mathbb{E}\left[S_n\right]\right|\right]\geq \varepsilon n]\leq\displaystyle \dfrac{\text{Var}\left[S_n\right]}{\varepsilon^2 n^2}\leq\dfrac{c}{\varepsilon^2 n^2}\rightarrow 0,~~\text{quando} ~~ n\rightarrow \infty.$$

$\Box$

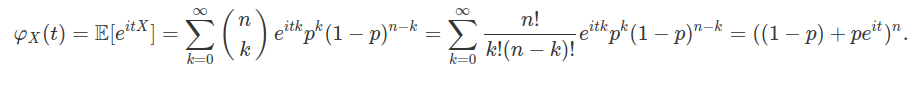

Teorema 7.1.1.1 (Lei Fraca de Khintchine)

Sejam $X_i$ uma sequência enumerável de variáveis aleatórias independentes e identicamente distribuídas e integráveis com média $\mu.$ Então $X_i,~i\in\mathbb{N}$ satisfazem a Lei Fraca do Grandes Números:

$$\frac{S_n}{n}\stackrel{P}{\rightarrow}\mu$$

Demonstração:

De fato, como as $X_n$ são independentes e identicamente distribuídos e usando a função característica (para mais detalhes consulte o conteúdo Função Característica ou Transformada de Fourier), temos que

$$\varphi_{S_n/n}(t)=\left(\varphi_{X_1}\left(\frac{t}{n}\right)\right)^n=\left(1+it\frac{\mu}{n}+r_1\left(\frac{t}{n}\right)\right)^n$$

em que $\frac{r_1(t)}{t}\stackrel{t\rightarrow 0}\longrightarrow0.$ Disto, obtemos que

$$\varphi_{S_n/n}(t)\stackrel{n\rightarrow \infty}\longrightarrow e^{it\mu},\quad \forall ~t\in \mathbb{R}$$

Pelo teorema da continuidade de Lévy, temos que

$$\frac{S_n}{n}\stackrel{\mathcal{D}}\rightarrow\mu$$

Mas como $\mu$ é constante, temos que

$$\frac{S_n}{n}\stackrel{P}\rightarrow\mu$$

$\Box$

Proposição 7.1.1.4

Sejam $X_1,\dots,X_n$ variáveis aleatórias independentes com $E[X_i]=\mu$ e $\text{Var}(X_i)=\sigma^2$ para $i=1,2,\dots,n.$ Então, para todos $\varepsilon> 0$ temos:

$$\mathbb{P}\left[\left|\frac{S_n}{n}-\mu\right|\geq \varepsilon \right]\leq \dfrac{\sigma^2}{n\varepsilon^2}$$

Demonstração:

Seja $S_n=X_1+\dots+X_n,$ aplicamos a desigualdade de Chebyshev e obtemos que

$$\mathbb{P}\left[\left|\frac{S_n}{n}-\mu\right|\geq \varepsilon \right]\leq \dfrac{\text{Var}\left(\frac{S_n}{n}\right)}{\varepsilon^2}=\dfrac{\sigma^2}{n\varepsilon^2}$$

$\Box$

A primeira lei dos grandes números foi proposta por Bernoulli em 1713 e é um caso particular da lei fraca de Chebychev, a qual é proposta como a proposição abaixo.

Proposição 7.1.1.5 (Lei Fraca dos Grandes Números de Bernoulli)

Seja $X_i$ uma sequência de ensaios de bernoulli independentes, com mesma probabilidade de sucesso. Então

$\displaystyle \frac{S_n}{n}\stackrel{P}\rightarrow p$

em que $S_n=\displaystyle\sum^n_{i=1}X_i$

Demonstração:

Podemos demonstrar esse resultado de duas formas. A primeira delas basta observarmos que $p=\mathbb{E}[X_i]$ e $\text{Var}[X_i]=p(1-p)$, e portanto a sequência $X_i$ tem variância uniformemente limitada. Assim, as hipóteses do teorema anterior são satisfeitas o que implica que:

$\displaystyle \frac{S_n-np}{n}=\frac{S_n}{n}-p\stackrel{P}\rightarrow 0$

ou seja,

$\displaystyle \frac{S_n}{n}\stackrel{P}\rightarrow p.$

A outra maneira de demonstrarmos este resultado seria usando a desigualdade de Chebychev. Como as hipóteses da desigualdade são satisfeitas, temos que

$$\mathbb{P}[|\displaystyle S_n-\mathbb{E}[S_n]|\geq \varepsilon n]=\mathbb{P}[|S_n -np]|\geq \varepsilon n]\leq\displaystyle \frac{\text{Var}[S_n]}{\varepsilon^2 n^2}\leq\frac{p(1-p)}{\varepsilon^2 n^2}\rightarrow 0,$$

quando $n\rightarrow \infty$, ou equivalentemente $\displaystyle \frac{S_n}{n}\stackrel{P}\rightarrow p.$

$\Box$

Para finalizarmos esta seção, vamos apresentar alguns exemplo para fixarmos os conceitos apresentados.

Exemplo 7.1.1.1

Seja $X_i$ uma sequência de variáveis aleatórias, mostre que se $\mathbb{E}[X_i]\rightarrow \alpha$ e $\text{Var}[X_i]\rightarrow 0$, então $X_n\stackrel{P}\rightarrow\alpha$.

Como $\mathbb{E}[X_i]\rightarrow \alpha$ temos que para cada $\varepsilon > 0$, existe $n_0$ tal que $|\mathbb{E}[X_n]-\alpha|<\dfrac{\varepsilon}{2}$ para $n\geq n_0$.

Assim, para todo $n\geq n_0$ temos que:

$$[|X_n-\alpha|> \varepsilon]\subseteq[|X_n-\mathbb{E}[X_n]|> \dfrac{\varepsilon}{2}],$$

pois

$$\varepsilon < |X_n-\alpha|=|X_n-\mathbb{E}[X_n]+\mathbb{E}[X_n]-\alpha|\leq|X_n-\mathbb{E}[X_n]|+|\mathbb{E}[X_n]-\alpha|\leq|X_n-\mathbb{E}[X_n]|+\dfrac{\varepsilon}{2}$$

Logo,

$$|X_n-\mathbb{E}[X_n]|+\dfrac{\varepsilon}{2}>\varepsilon\quad \rightarrow\quad |X_n-\mathbb{E}[X_n]|> \dfrac{\varepsilon}{2}$$

Mas pela desigualdade de Chebyshev para todo $n\geq 1$.

$\mathbb{P}(|X_n-\mathbb{E}[X_n]|>\dfrac{\varepsilon}{2})\leq\displaystyle\dfrac{4}{\varepsilon^2}\text{Var}(X_n).$

Portanto para todo $n\geq n_0,$

$\mathbb{P}(|X_n-\alpha|> \varepsilon)\leq \dfrac{4}{\varepsilon^2}\text{Var}[X_n],$

mas como $\text{\text{Var}}[X_n]\rightarrow 0$, quando $n\rightarrow \infty$, concluímos que $X_n \stackrel{P}\rightarrow \alpha$.

Exemplo 7.1.1.2

Suponha que em uma fábrica borracha o número de borrachas produzidas por dia seja uma variável aleatória X com média $\mu=70$. Estime a probabilidade de que a produção diária seja maior que 210.

Neste caso basta usarmos a desigualdade de Markov, e obtemos o seguinte resultado:

$\mathbb{P}(X\geq 210)\leq\displaystyle\dfrac{\mathbb{E}[X]}{210}=\frac{70}{210}=\dfrac{1}{3}.$

Exemplo 7.1.1.3

Se no exemplo acima a variância de X é igual a 20, qual a probabilidade de que a produção do dia esteja entre 40 e 100 borrachas produzidas ?

Utilizando a desigualdade de Chebyshev, obtemos que:

$\mathbb{P}(|X-\mathbb{E}[X]|\geq 30)=\displaystyle\dfrac{\text{Var}[X]}{30^2}=\dfrac{20}{30^2}=\dfrac{1}{45}$

ou seja,

$\mathbb{P}(X-\mathbb{E}[X]\leq 30)=1-\mathbb{P}(X-\mathbb{E}[X]\geq 30)=1-\displaystyle \dfrac{1}{45}=\dfrac{44}{45}\approx 0,977.$

Desta forma a probabilidade de que a produção do dia esteja entre 40 e 100 borrachas produzidas é de aproximadamente 97,7%.

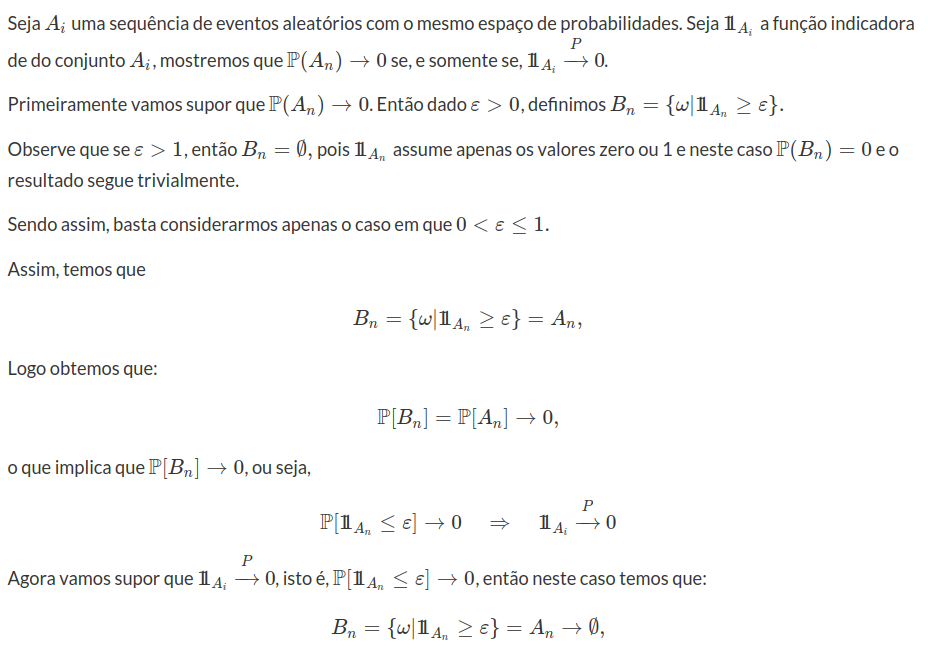

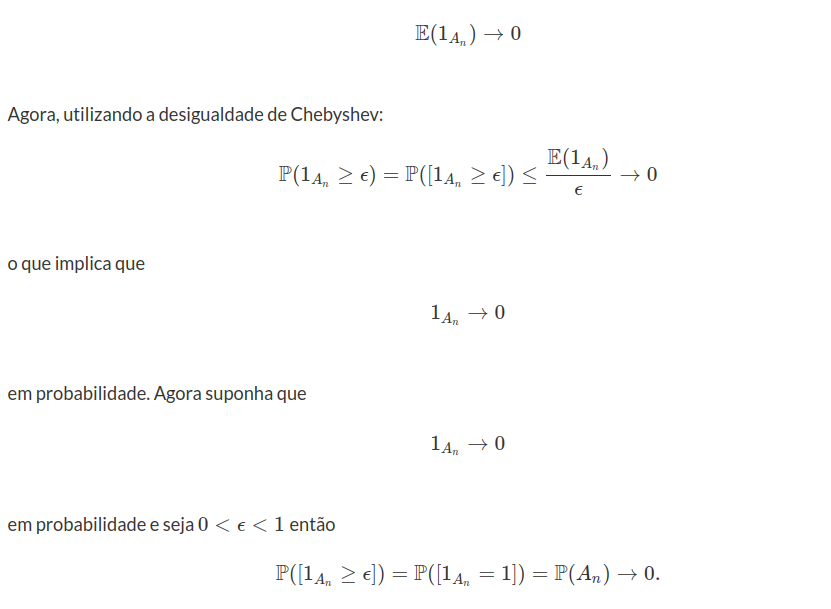

Exemplo 7.1.1.4

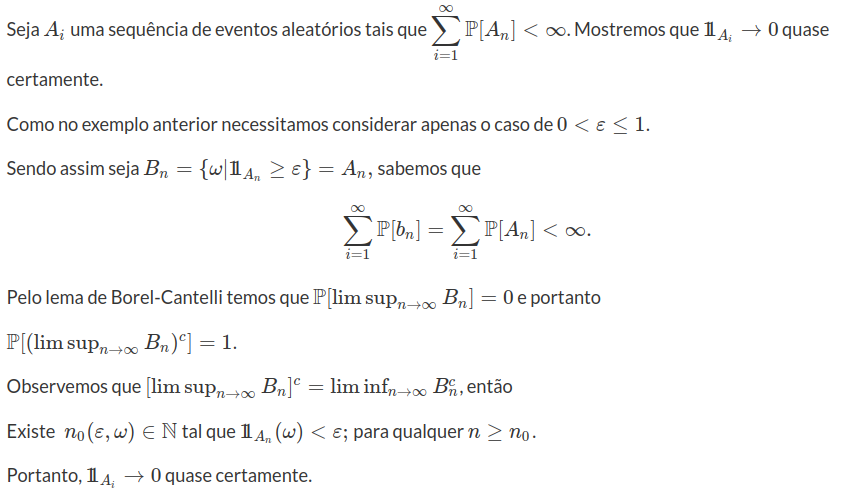

Portanto $\mathbb{P}[B_n]=\mathbb{P}[A_n]\rightarrow 0$

Exemplo 7.1.1.5

Uma variável com variância zero é um valor determinístico.

De fato, seja X uma variável aleatória com variância zero $\text{Var}(X)=0,$ pela desigualdade de Chebyshev temos que

$$\mathbb{P}[|X-\mu|\geq k]\leq \dfrac{\text{Var}(X)}{k^2}\quad \rightarrow \quad \mathbb{P}[|X-\mu|>0]=0$$

Portanto, $X=\mu$ com probabilidade 1, isto é, é determinístico.

Exemplo 7.1.1.6

Um candidato a prefeito da cidade de São Carlos gostaria de ter uma ideia de quantos votos receberá nas próximas eleições. Para isto, foi feito uma pesquisa com os cidadães, em que $p$ representa a proporção de votos do candidato com $0\leq p< 1.$ Quantas pessoas devem ser entrevistadas com 95% de confiança para que o valor de $p$ tenha sido determinado com erro inferior a 5%, supondo que as escolhas de cada pessoa sejam independentes.

Seja $n$ o número de candidatos, denotamos $X_i, ~i=1,\dots,n$ a variável aleatória de Bernoulli que assume valor 1, com probabilidade p, se a i-ésima pessoa entrevistada declara a intenção de votar no candidato. Assume o valor 0, com probabilidade $1-p$ caso contrário.

Note que $S_n=X_1+\dots+X_n\sim b(n,p)$ (para mais detalhes consulte distribuição binomial). Assim, $\frac{S_n}{n}$ é uma aproximação do valor de $p$ que é desconhecido.

Logo, do enunciado, queremos

$$\mathbb{P}\left[\left|\frac{S_n}{n}-p\right|\leq 0,05\right]\geq 0,95$$

Da proposição 7.1.1.4 temos que

$$\mathbb{P}\left[\left|\frac{S_n}{n}-p\right|\geq 0,05\right]\leq \frac{p(1-p)}{n(0,05)^2}\leq \frac{1}{4n~(0,05)^2}, \quad\text{pois}~p(1-p)\leq \frac{1}{4}\quad (7.1.1.1)$$

A probabilidade do lado esquerdo de (7.1.1.1) é o complementar à probabilidade desejada, isto é, $1-0,95=0,05.$

Logo,

$$\frac{1}{4n(0,05)^2}\leq 0,05\quad \rightarrow \quad n\geq 2000.$$

Portanto, devemos entrevistar pelo menos 2000 pessoas.

Exemplo 7.1.1.7

$$\mathbb{P}(A_n)\rightarrow 0$$

o que implica que

E o resultado segue

Exemplo 7.1.1.8

Sejam $ X_1,X_2,\dots $ variáveis aleatórias independentes com distribuição comum $ Poisson(\lambda) $. Qual o limite em probabilidade da sequência $ (Y_n)_{n\geq 1} $, no qual

$$Y_n=\frac{X_1^2+\dots+X^2_n}{n}$$

Temos que $ \mathbb{E}(X_1^2)=Var(X_1)+[\mathbb{E}(X_1)]^2=\lambda+\lambda^2=\lambda(\lambda+1) $. Agora sejam $ Z_i=X^2_i, i=1,2,\dots $ variável aleatória que serão independentes pela “propriedade hereditária”, identicamente distribuídas e integráveis. Então, pela Lei Fraca de Khintchine

$$Y_n=\frac{X_1^2+\dots+X_n^2}{n}\stackrel{\mathbb{P}}{\rightarrow} \mathbb{E}(X_1^2)=\lambda(\lambda+1)$$

Exemplo 7.1.1.9

Seja $ (X_n)_{n\geq 1} $ uma sequência de variáveis aleatórias. Prove que se $ \mathbb{E}(X_n)\rightarrow \alpha $.

Sejam $ \epsilon > 0 $ qualquer e

$$A_n=[|X_n-\alpha|\geq \epsilon]=[|X_n-\mathbb{E}(X_n)+\mathbb{E}(X_n)-\alpha|\geq \epsilon]$$

$$B_n=[(|X_n-\mathbb{E}(X_n)|+|\mathbb{E}(X_n)-\alpha|)\geq \epsilon]$$

Agora $ \omega \in A_n $ o que implica que $ \omega \in B_n $ pois

$$(|X_n-\mathbb{E}(X_n)|+|\mathbb{E}(X_n)-\alpha|)\geq |X_n-\alpha|\geq \epsilon$$

Então $ A_n\subset B_n $ o que implica que

$$\mathbb{P}(A_n)\leq \mathbb{P}(B_n)$$

No entanto, através da desigualdade clássica de Chebyshev-Bienayme. Temos

$$\mathbb{P}(A_n)\leq \mathbb{P}(B_n)=\mathbb{P}((|X_n-\mathbb{E}(X_n)|+|\mathbb{E}(X_n)-\alpha|)\geq \epsilon)$$

$$=\mathbb{P}((|X_n-\mathbb{E}(X_n)|)\geq \epsilon-|\mathbb{E}(X_n)-\alpha|)\leq \frac{Var(X_n)}{[\epsilon-|\mathbb{E}(X_n-\alpha)|]^2}\rightarrow 0$$

Exemplo 7.1.1.10

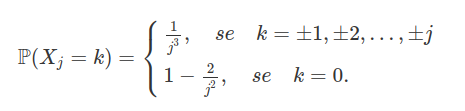

Sejam $ X_1,X_2,\dots $ variáveis aleatórias independentes tais que $ X_1=0 $ e para $ j\geq 2 $, $ X_j $ é variável aleatória discreta satisfazendo

Prove que

$$\frac{\displaystyle \sum_{j=1}^n X_j}{n^\alpha}\stackrel{\mathbb{P}}{\longrightarrow} 0$$

quando $ n\rightarrow \infty $, se $ \alpha > \frac{1}{2} $.

Temos que por conta da simetria $ \mathbb{E}(X_j)=0 $ para $ j=1,2,\dots $ e

$$Var(X_j)=2\sum_{k=1}^n k^3\frac{1}{j^3}=\frac{2}{j^3}\sum_{k=1}^n k^2=\frac{j(j+1)(2j+1)}{6j^3}=\frac{2j^2+3j+1}{3j^2}$$

$$=\frac{2}{3}+\frac{1}{j}+\frac{1}{3j^2}\leq 2$$

Agora

$$Var\left(\sum_{j=1}^n X_j\right)=\sum_{j=1}^n Var X_j\leq 2n$$

Aplicando a desigualdade de Chebyshev-Bienayme temos

$$\mathbb{P}\left(\bigg|\frac{\sum_{j=1}^n X_j}{n^\alpha}\bigg|\geq \epsilon \right)=\mathbb{P}\left(|\sum_{j=1}^n X_j|\geq n^{\alpha}\epsilon\right)$$

$$\leq \frac{Var\left(\sum_{j=1}^n X_j\right)}{n^{2\alpha}\epsilon^2}\leq \frac{2}{n^{2\alpha-1}\epsilon^2}\rightarrow 0$$

Exemplo 7.1.1.11

Seja S uma sequência finita de caras e coroas. Demonstre que se uma moeda não necessariamente honesta( com probabilidade de cara igual a p, $ 0< p< 1 $) for jogada independentemente um número infinito de vezes então S sairá infinitas vezes na sequência obtida, com probabilidade 1.

Teremos

$$\Omega=(W=(\omega_1,\omega_2,\dots),\quad no\quad qual\quad \omega_i=1 \quad ou\quad \omega_i=0,\quad todo\quad i)$$

Seja $ S_k $ a sequência finita(de k elementos) de caras e coroas

$$S_k=(s_1,s_2,\dots,s_k)$$

no qual $ s_i\in (0,1) $ e $ i=1,\dots,k $. Agora, seja a sequência de eventos aleatórios

$$A_1=(\text{a ocorrência da sequência} S_k\text{nos k primeiros ensaios})$$

\colorbox[rgb]{1,1,0}{Revisar}

$$A_2=(\text{a ocorrência da sequência} S_k\text{nos (k+1)2k primeiros ensaios})$$

$ \vdots $

$$A_n=(\text{a ocorrência da sequência} S_k\text{nos k primeiros ensaios})$$

ou seja, $A_n=(\omega\in \Omega: \omega_{(n-1)k+i}=s_i, i=1,\dots,k)$ no qual $ A_1,A_2,\dots $ são eventos aleatórios independentes pois os ensaios são independentes, então temos

$$\mathbb{P}(A_n)=p^j(1-p)^{k-j}=q$$

no qual $ S_k $ tem $ j $ caras e $ k-j $ coroas. Agora $ \sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty q=\infty $. Como $ A_1,A_2,\dots $ são eventos aleatórios independentes aplicando o teorema de Borel-Cantelli, temos

$$\mathbb{P}(A_n,\quad i.o)=1$$

No entanto, sendo $ \mathcal{S} $ o evento “ocorrência de S infinitas vezes”, temos

$$\mathcal{S}\supset [A_n,\quad i.o.]$$

o que implica que $ \mathbb{P}(\mathcal{S})\geq \mathbb{P}(A_n,\quad i.o)=1 $ o que implica que $ \mathbb{P}(\mathcal{S})=1 $

Exemplo 7.1.1.12

Sejam $ X_1,X_2,\dots $ variáveis aleatórias independentes tais que $ X_n $ tem distribuição $ U[0,a_n] $, no qual $ a_n> 0 $. Mostre

(a) Se $ a_n=n^2 $, então com probabilidade 1, somente um número finito das $ X_n $ toma valores menores que 1.

Seja $ A_n=[X_n< 1] $. Então $ A_1,A_2,\dots $ são eventos aleatórios independentes pois $ A_i $ depende apenas de $ X_i $. E

$$\mathbb{P}(A_n)=\mathbb{P}([X_n< 1])=\frac{1}{n^2}, \quad n=1,2,\dots$$

Então,

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty \frac{1}{n^2}< \infty$$

o que implica por Borel-Cantelli que

$$\mathbb{P}(A_n,\quad i.o)=0$$

o que implica que $ \mathbb{P}(A_n,\quad f.o.)=1 $.

(b) Se $ a_n=n, $ então com probabilidade 1, um número infinito das $ X_n $ toma valores menores que 1.

Então,

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\mathbb{P}([X_n< 1])=\frac{1}{n}=\infty$$

por Borel-Cantelli e por $ A_n $ ser independentes, isso implica que

$$\mathbb{P}(A_n,\quad i.o)=1$$

Exemplo 7.1.1.13

Sejam $ X_1, X_2,\dots $ variáveis aleatórias independentes tais que $ \mathbb{P}(X_n=1)=1/n, \mathbb{P}(X_n=0)=1-1/n $. Mostre que $ X_n\stackrel{\mathbb{P}}{\rightarrow}0 $ mas $ \mathbb{P}(X_n\rightarrow 0)=0. $

Para todo $ \epsilon> 0, $

$$\mathbb{P}(|X_n|\geq \epsilon)\leq \mathbb{P}(X_n=1)=\frac{1}{n}\stackrel{n\rightarrow\infty}{\longrightarrow} 0$$

Seja $ A_n=[X_n\neq 0] $, então $ A_1,A_2,\dots $ são independentes pois $ A_i $ depende de $ X_i $. Então,

$$\mathbb{P}(A_n)=\mathbb{P}([X_n\neq 0])=\mathbb{P}(X_n=1)=\frac{1}{n}.$$

Agora,

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty \frac{1}{n}=\infty$$

por Borel-Cantelli temos que $ \mathbb{P}(A_n,\quad i.o.)=1 $. Então, um número infinito de $ X_i $ são diferentes de zero. Então,

$$\mathbb{P}(\omega\in \Omega: X_n(\omega)\nrightarrow 0)=1$$

o que implica que

$$\mathbb{P}(\omega\in\Omega:X_n(\omega)\rightarrow 0)=0$$

Exemplo 7.1.1.14

Sejam $ X_1,X_2, \dots $ variáveis aleatórias independentes e identicamente distribuídas com distribuição exponencial de parâmetro 1. Mostre que

$$\displaystyle \mathbb{P}\left(\frac{X_n}{\ln(n)}> 1 \text{infinitas}\quad \text{vezes}\right)=1$$

mas

$$\displaystyle \mathbb{P}\left(\frac{X_n}{\ln(n)}> 2 \text{infinitas}\quad \text{vezes}\right)=0$$

Primeiramente vamos mostrar que

$$\displaystyle \mathbb{P}\left(\frac{X_n}{\ln(n)}> 1 \text{infinitas}\quad \text{vezes}\right)=1$$

Seja $ A_n=\left[\frac{X_n}{\ln{(n)}}> 1\right] $ o que implica que $ A_1, A_2, \dots $ são independentes pois $ A_i $ depende apenas de $ X_i $ que são variáveis aleatórias independentes. Agora,

$$\mathbb{P}(A_n)=\mathbb{P}\left(\left[\frac{X_n}{\ln(n)> 1}\right]\right)=\mathbb{P}(X_n> \ln(n))=e^{-\ln(n)}=\frac{1}{n}$$

então pelo lema de Borel-Cantelli temos que

$$\displaystyle \sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty \frac{1}{n}=\infty$$

o que implica que $ \mathbb{P}(A_n,\quad i.o.)=1 $.

Agora vamos mostrar que

$$\displaystyle \mathbb{P}\left(\frac{X_n}{\ln(n)}> 2 \text{infinitas}\quad \text{vezes}\right)=0$$

Analogamente seja $ B_n=\left[\frac{X_n}{\ln{n}}> 2\right] $, novamente temos que $ B_i $ são independentes. Agora

$$\mathbb{P}(B_n)=\mathbb{P}\left(\frac{X_n}{\ln(n)}> 2\right)=\mathbb{P}(X_n> 2\ln(n))=e^{-2\ln(n)}=\frac{1}{n^2}$$

Então

$$\sum_{n=1}^\infty\mathbb{P}(B_n)=\sum_{n=1}^\infty \frac{1}{n^2}< \infty$$

pelo teorema de Borel-Cantelli temos que $ \mathbb{P}(B_n,\quad i.o)=0 $. E o resultado segue.

Exemplo 7.1.1.15

Sejam $ X_1,X_2, \dots $ variáveis aleatórias tais que

$$\mathbb{P}(X_n=0)=1-\frac{1}{n^2},\mathbb{P}(X_n=n^2)=\frac{1}{n^2}$$

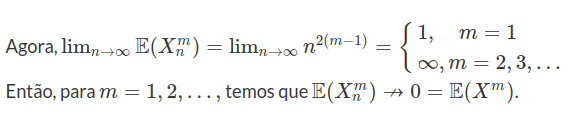

para $ n=1,2,\dots $. Demonstre que $ X_n $ converge quase certamente (ache o limite X), mas $ \mathbb{E}(X^m_n)\nrightarrow \mathbb{E}(X^m) $ quando $ n\rightarrow \infty $, para todo $ m=1,2,\dots $.

Vamos mostrar que $ X_n\rightarrow 0 $ q.c.

Seja $ A_n=[X_n\neq 0] $ o que implica que $ \mathbb{P}(A_n)=\mathbb{P}(X_n\neq 0)=1-\mathbb{P}(X_n=0)=\frac{1}{n^2} $ então

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty \frac{1}{n^2}< \infty$$

o que implica que $ \mathbb{P}(A_n,\quad i.o.)=0 $ o que implica que

$$\mathbb{P}(X_n\neq 0\quad\text{um número finito de vezes})=1$$

o que implica que $ \mathbb{P}(X_n\rightarrow 0)=1 $ o que implica que $ X_n\stackrel{q.c.}{\rightarrow}0 $

Agora vamos mostrar que

$$\mathbb{E}(X_n^m)\nrightarrow \mathbb{E}(X^m)$$

Temos que

$$\mathbb{P}(X_n^m=0)=\mathbb{P}(X_n=0)=1-\frac{1}{n^2}$$

Além disso,

$$\mathbb{P}(X_n^m=n^{2m})=\mathbb{P}(X_n=n^2)=\frac{1}{n^2}$$

Então,

$$\mathbb{E}(X_n^m)=n^{2m}\frac{1}{n^2}=n^{2(m-1)}$$

e ainda

$$\mathbb{E}(X^m)=\mathbb{E}(0)=0$$

Exemplo 7.1.1.16

Sejam $ X_1,X_2, \dots $ variáveis aleatórias

(a) Demonstre: se $ \sum_{n=1}^\infty \mathbb{P}(|X_n|> n)< \infty $, então

$$\limsup_{n\rightarrow \infty} \frac{|X_n|}{n}\leq 1$$

quase certamente.

Note que

$$\sum_{n=1}^\infty \mathbb{P}(|X_n|> n)=\sum_{n=1}^\infty \mathbb{P}\left(\frac{|X_n|}{n}> 1\right)< \infty$$

Seja $ A_n=\left[\frac{|X_n|}{n}> 1\right] $ então pelo lema de Borel-Cantelli temos

$$\mathbb{P}(A_n,\quad i.o)=0$$

o que implica que

$$\mathbb{P}\left(\frac{|X_n|}{n}> 1,\quad \text{finita vezes}\right)=1$$

o que implica que

$$\mathbb{P}\left(\omega:\frac{|X_n(\omega)|}{n}> 1,\quad \text{finita vezes}\right)=1$$

o que implica que

$$\frac{|X_n(\omega)|}{n}> 1$$

finitas vezes, implica que

$$\frac{|X_n(\omega)|}{n}\leq 1$$

para n suficientemente grande, o que implica que

$$\liminf_{n\rightarrow \infty}\frac{|X_n(\omega)|}{n}\leq 1$$

Então, defina \frac{|X_n(\omega)|}{n}> 1,\quad \text{finita vezes}) $ e \limsup_{n\rightarrow \infty}\frac{|X_n(\omega)|}{n}\leq 1) $. Então, $ A\subset B $ e portanto

$$\mathbb{P}(B)\geq \mathbb{P}(A)=1.$$

(b) Se as $ X_n $ são identicamente distribuídas e integráveis, demonstre que

$$\limsup_{n\rightarrow \infty }\frac{|X_n|}{n}\leq 1$$

quase certamente.

Note que,

$$\sum_{n=1}^\infty \mathbb{P}(|X_n|> n)=\sum_{n=1}^\infty \mathbb{P}(|X_1|> n)$$

$$=\sum_{n=0}^\infty \mathbb{P}(|X_1|> n)-\mathbb{P}(|X_1|> 0)=\sum_{n=0}^\infty \mathbb{P}(|X_1|> n)-1$$

Agora, como $ X_1 $ é integrável, temos pelo critério da integrabilidade que

$$\sum_{n=0}^\infty \mathbb{P}(|X_1|\geq n)=\sum_{n=0}^\infty \mathbb{P}(|X_1|> n)< \infty$$

então

$$\sum_{n=1}^\infty \mathbb{P}(|X_n|> n)< \infty$$

o que implica que $ \mathbb{P}(B)=1 $.

Exemplo 7.1.1.17

Sejam $ X_1,X_2,\dots $ variáveis aleatórias independentes e identicamente distribuídas tais que $ X_1\sim U[0,1] $. Prove que $ n^{-X_n}\rightarrow 0 $ em probabilidade, mas $ n^{-X_n} $ não converge quase certamente para 0.

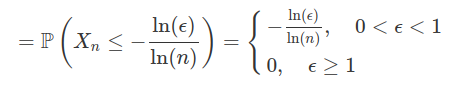

(a)

$$\mathbb{P}(n^{-X_n}\geq \epsilon)=\mathbb{P}(-X_n\ln(x)\geq \ln(\epsilon))=\mathbb{P}(X_1\ln(n)\geq \ln(\epsilon))$$

então, qualquer $ \epsilon > 0 $,

$$\mathbb{P}(n^{-X_n}\geq \epsilon)\leq \frac{\ln(\epsilon)}{\ln(n)}\stackrel{\longrightarrow}{n\rightarrow \infty} 0.$$

(b)Sejam os eventos: $ A_n=[n^{-X_n}\neq 0] $ então $ A_1,A_2,\dots $ eventos independentes e

$$\mathbb{P}(A_n)=\mathbb{P}(n^{-X_n}\neq 0)=\mathbb{P}(n^{-X_1}\neq 0)$$

$$=\left(1,\quad n=1\ \mathbb{P}(-X_1\neq 0)=\mathbb{P}(X_1\neq 0)=1,\quad n> 1\right.$$

Então $ \mathbb{P}(A_n)=1 $, para qualquer n. Então,

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty 1=\infty$$

Agora, como $ A_1,A_2, \dots $ são independentes o que implica pelo Lema de Borel-Cantelli

$$\mathbb{P}(A_n,\quad i.o)=1$$

o que implica que

$$\mathbb{P}(\omega: n^{-X_n(\omega)}\neq 0,\quad i.o.)=1\Rightarrow \mathbb{P}(\omega:n^{-X_n(\omega)}\nrightarrow 0)=1$$

$$\Rightarrow \mathbb{P}\left(\omega:n^{-X_n(\omega)}\rightarrow 0\right)=0\Rightarrow n^{-X_n}\nrightarrow 0$$

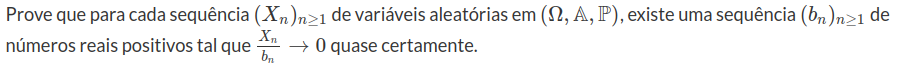

Exemplo 7.1.1.18

a) Provaremos incialmente que para cada n existe $ b_n $ tal que

$$\mathbb{P}(|X_n|> \frac{b_n}{n})< \frac{1}{n^2}$$

Para isso, vamos fixar um determinado n, e seja $ (Y_m^n)_{m\geq 1} $ uma sequência de número reais onde

$$Y_m^n=\mathbb{P}\left(|X_n|> \frac{m}{n}\right)$$

Temos que

$$\lim_{m\rightarrow \infty} Y_m^n=\lim_{m\rightarrow \infty}\left[\mathbb{P}\left(\frac{m^-}{n}\right)-1+\mathbb{P}\left(\frac{m}{n}\right)\right] = 0-1+1=0$$

Então dado $ \epsilon> 0 $ existe $ m_0(\epsilon)\in \mathbb{N} $ tal que $ m\geq m_0 $ o que implica que

$$\bigg|\mathbb{P}\left(|X_n|> \frac{m}{m_0}\right)\bigg|< \frac{1}{\epsilon}.$$

Tome em $ \epsilon=\frac{1}{n^2} $ e tomemos $ b_n=m_0\left(\frac{1}{n^2}\right) $ então

$$\mathbb{P}\left(|X_n|> \frac{b_n}{n}\right)< \frac{1}{n^2}$$

Repetindo o procedimento acima descrito obtemos todos os $ b_n\in \mathbb{N}^\star \subset \mathbb{R}^+_\star $.

b) Agora temos fazendo $ \epsilon > 0 $ e

$$A_n=\left[\bigg|\frac{X_n}{b_n}\bigg|> \epsilon\right]$$

o que implica que existe $ n_0(\epsilon) $, tal que $ n> n_0 $ o que implica que

$ \frac{1}{n}< \epsilon $ e $ n> n_0 $.

$$\omega\in \left[\bigg|\frac{X_n}{b_n}\bigg|> \frac{1}{n}\right]$$

o que implica que

$$\mathbb{P}(A_n)\leq \mathbb{P}\left(\bigg|\frac{X_n}{b_n}\bigg|> \frac{1}{n}\right)$$

Então,

$$\sum_{n=1}^\infty \mathbb{P}(A_n)=\sum_{n=1}^\infty \mathbb{P}(A_n)+ \sum_{n> n_0} \mathbb{P}(A_n)$$

$$\leq n_0+\sum_{n> n_0}\mathbb{P}\left(\bigg|\frac{X_n}{b_n}\bigg|> \frac{1}{n}\right)\leq n_0+ \sum_{n> n_0}\frac{1}{n^2}< \infty$$

Então, pelo Lema de Borel-Cantelli.

$$\mathbb{P}(A_n,\quad i.o.)=0$$

o que implica que para qualquer $ \epsilon> 0 $ temos

$$\mathbb{P}\left(\omega:\bigg|\frac{X_n(\omega)}{b_n}\bigg|> \epsilon,i.o.\right)=0$$

o que implica que

$$\mathbb{P}\left(\omega:\bigg|\frac{X_n(\omega)}{b_n}\bigg|\leq \epsilon, \quad n \text{suficientemente grande}\right)=1$$

o que implica que

$$\mathbb{P}\left(\omega:\bigg|\frac{X_n(\omega)}{b_n}\bigg|\rightarrow 0\right)=1$$

então

$$\frac{X_n}{b_n}\rightarrow 0.$$

Na próxima seção, vamos estudar a Lei Forte dos Grandes Números.

7.2.2 - Lei Forte dos Grandes Números

Após estudarmos a Lei Fraca do Grandes Números, vamos estudar agora a Lei Forte dos Grandes Números. A principal diferença da Lei Fraca é que ao invés da convergência em probabilidade, temos a convergência quase certa como dita na seção anterior. Os detalhes destes dois tipos de convergência, foi amplamente discutido na seção convergências em probabilidade e quase certa. A seguir, apresentamos os principais resultados para Lei Forte dos Grandes Números.

Teorema 7.1.2.1

Sejam $ (X_i)_{i\geq 1} $ uma sequência de variáveis aleatórias independentes e identicamente distribuídas. Se $ \mathbb{E}[|X_1|]=\infty $, então com probabilidade 1, a sequência

$ \displaystyle \frac{|S_n|}{n} = \frac{|X_1 + \cdots + X_n|}{n}, $

não é limitada.

Demonstração:

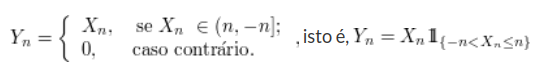

Sabemos que $ \mathbb{E}[|X_1|]=\infty $, então como consequência temos que $ \displaystyle \mathbb{E}\left[\frac{|X_1|}{k}\right]=\frac{\mathbb{E}[|X_1|]}{k}=\infty $.

Então mostremos primeiramente que $ \displaystyle\sum_{n=1}^{\infty}\mathbb{P}(|X|\geq n)\leq \mathbb{E}[|X|]\leq 1+\displaystyle\sum_{n=1}^{\infty}\mathbb{P}(|X|\geq n) $, para qualquer variável aleatória X.

De fato, se $ x\geq 0 $, seja $ [x] $ o maior número inteiro menor ou igual a $ x $. Então a variável aleatória $ [|X|] $ assume valor k quando $ k\leq |X|< k+1 $ e portanto

$$0\leq [|X|]\leq |X|\leq [|X|]+1,$$

Assim pela linearidade e pela monotonicidade da esperança, temos que:

$$0\leq \mathbb{E}([|X|])\leq \mathbb{E}[|X|]\leq \mathbb{E}([|X|])+1,$$

Como [|X|] é uma variável aleatória que assume apenas valores inteiros temos que

$$\mathbb{E}([|X|])=1-F_X[0]+1-F_X[1]+1-F_X[2]\cdots=\displaystyle \sum_{n=0}^{\infty}1-F[n]=\sum_{n=0}^{\infty}\mathbb{P}[X> n].$$

Desta forma temos que $ \mathbb{E}([|X|])=\displaystyle\sum_{n=0}^{\infty}\mathbb{P}[[|X|]\geq n]=\sum_{n=0}^{\infty}\mathbb{P}[|X|\geq n] $. Logo

$$\sum_{n=0}^{\infty}\mathbb{P}[|X|> n]\leq \mathbb{E}|X|\leq 1+\sum_{n=0}^{\infty}\mathbb{P}[|X|> n].$$

Assim $ \displaystyle\sum_{n=0}^{\infty}\mathbb{P}\left[\frac{|X_1|}{k}> n\right]=\infty $ para qualquer $ k\in \mathbb{N} $. Como as variáveis $ X_n $ são identicamente distribuídas temos que:

$$\displaystyle\sum_{n=0}^{\infty}\mathbb{P}\left[\frac{|X_1|}{k}> n\right]=\displaystyle\sum_{n=0}^{\infty}\mathbb{P}\left[\frac{|X_n|}{k}> n\right]=\displaystyle\sum_{n=0}^{\infty}\mathbb{P}\left[\frac{|X_n|}{n}> k\right].$$

Como os $ X_n $ são independentes, os eventos $ A_n=\left[\frac{|X_n|}{n}\geq k\right] $ são independentes, desta forma usando o lema de Borel Cantelli

$$\mathbb{P}\left(\limsup \displaystyle\frac{|X_n|}{n}\geq k\right)=1.$$

Seja $ B_k=\left[\limsup \displaystyle \frac{|X_n|}{n}\geq k\right] $, temos então

$$\mathbb{P}\left(\displaystyle \bigcap_{k=1}^{\infty}B_k\right)=1,$$

pois a intersecção de um número enumerável de eventos de probabilidade 1 também tem probabilidade 1, como demonstrado na Propriedade 12. Mas o evento $ \displaystyle \bigcap_{k=1}^{\infty}B_k $ é o evento “a $ \displaystyle\frac{|X_n|}{n}\geq k $ é ilimitada”. Assim basta provarmos que se $ \displaystyle\frac{|X_n|}{n} $ é ilimitada, então $ \displaystyle \frac{|S_n|}{n} $ também é ilimitada. Agora, com $ S_0=0 $, temos

$$\displaystyle\frac{|X_n|}{n}=\frac{|S_n-S_{n-1}|}{n}\leq \frac{|S_n|}{n}+\frac{|S_{n-1}|}{n},$$

para $ n \in \mathbb{N} $. Portanto, se $ \frac{X_n}{n} $ é ilimitada, então $ \frac{|S_n|}{n} $ é ilimitada ou $ \frac{|S_{n-1}|}{n} $. Mas se $ n\geq 2 $, temos que

$$\frac{|S_{n-1}|}{n}=\frac{|S_{n-1}|}{n-1} \frac{n-1}{n}$$

e $ \frac{1}{2}\leq \frac{n-1}{n}< 1 $, de modo que $ \frac{|S_{n-1}|}{n} $ é ilimitada se, e somente se,$ \frac{|S_n|}{n} $ também é, pois $ \frac{|S_{n-1}|}{n-1} $ e $ \frac{S_n}{n} $ formam a mesma sequência.

$ \Box $

Teorema 7.1.2.2

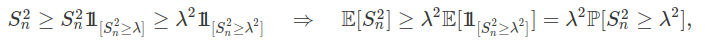

Seja $ X_i $ uma sequência de variáveis aleatórias independentes tais que $ \mathbb{E}[X_n]=0 $ e a $ \text{Var}[X_n]\leq \infty $. Então para todo $ \lambda> 0 $,

$ \mathbb{P}\left[\displaystyle\max_{1\leq k \leq n}|\sum_{i=1}^{k}X_i|\geq \lambda\right]\leq \displaystyle \sum_{k=1}^{n}\frac{\text{Var}[X_k]}{\lambda^2}. $

Demonstração:

Para facilitar a notação seja $ S_n=\displaystyle\sum_{i=1}^{n}X_i $. Observemos que:

Mas isto implica que :

$$\mathbb{P}(|S_n|\geq \lambda)\leq \displaystyle \frac{1}{\lambda^2}\mathbb{E}[S_n^2]=\frac{\text{Var}[S_n]}{\lambda^2}.$$

Nossa meta é encontrar uma cota superior para $ \mathbb{P}\left[\displaystyle \max_{1\leq k\leq n}S_k^2\geq \lambda^2\right] $, para isto consideramos $ A=\left(\displaystyle\max_{1\leq k\leq n}S_k^2\geq \lambda^2\right) $.

Vamos decompor A da seguinte forma:

$$A_1=[S_1^2\geq \lambda^2]$$

$$A_2=[S_1^2< \lambda^2,S_2^2\geq \lambda^2]$$

$$A_k=[S_1^2< \lambda^2,S_2^2< \lambda^2,\cdots,S_{k-1}< \lambda^2,S_k^2\geq \lambda^2]$$

Note que os $ A_k $ são disjuntos 2 a 2 e $ A=\displaystyle\bigcup_{k=1}^{n}A_k $:

Concluímos que

$$\mathbb{E}[S_n^2]\geq \displaystyle \sum_{k=1}^{n}\lambda^2\mathbb{P}[A_k]=\lambda^2\mathbb{P}[A]$$

Assim

$$\mathbb{P}(A)\leq \displaystyle \frac{\mathbb{E}[S_n^2]}{\lambda^2}=\frac{\text{Var}[S_n]}{\lambda^2}.$$

$ \Box $

Teorema 7.1.2.3 (Primeira Lei Forte de Kolmogorov)

Seja $ (X_i)_{i\geq 1} $ uma sequência de variáveis aleatórias independentes e integráveis, e suponha que:

$ \displaystyle \sum_{i=1}^{\infty}\frac{\text{Var}[X_i]}{i^2}< \infty,\quad (7.1.2.1) $ (condição de Kolmogorov)

então

$ \displaystyle\sum^n_{i=1}\frac{X_i -\mathbb{E}[X_i]}{n}\rightarrow 0, ~~ \text{quase certamente}. $

Demonstração:

Vamos redefinir a nossa sequência de variáveis aleatórias de forma que esperança seja zero. Para isto, seja $ Y_i=X_i-\mathbb{E}[X_i] $, assim $ \mathbb{E}[Y_i]=0 $ e $ \text{Var}[Y_i]=\text{Var}[X_i] $, por P1 da variância.

Desta forma queremos mostrar que

$ \displaystyle\sum_{i=1}^{\infty}\frac{Y_i}{n}\rightarrow 0, ~~ \text{quase certamente}. $

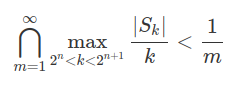

Vale salientar que é equivalente mostrarmos que

$ \displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k}\rightarrow 0,~~ \text{quase certamente}, $

quando $ n\rightarrow \infty, $ em que $ S_k=\displaystyle\sum^k_{i=1}Y_i. $

Agora, para cada m fixo, temos que

$ \mathbb{P}\left(\displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k}\geq \frac{1}{m}\right)\leq \mathbb{P}\left(\displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k}\geq \frac{2^n}{m}\right)\leq \mathbb{P}\left(\displaystyle \max_{1< k < 2^{n+1}}\frac{|S_k|}{k}\geq \frac{2^n}{m}\right) $

$ \leq \displaystyle\frac{m^2}{4^n}\displaystyle\sum^{2^{n+1}}_{k=1}\text{Var}(Y_k), $

Notemos que a última desigualdade é válida pelo Teorema 7.1.2.2. Desta forma temos

$$\displaystyle \sum_{n=1}^{\infty}\mathbb{P}\left(\max_{2^n< k\leq 2^{n+1}}\frac{S_k}{k}\geq \frac{1}{m}\right)\leq m^2 \displaystyle\sum_{n=1}^{\infty}\left(\frac{1}{4^n}\sum_{k=1}^{2^{n+1}}\text{Var} (Y_k)\right)=m^2\displaystyle\sum_{k=1}^{\infty}\displaystyle~\sum_{n:2^{n+1}\geq k}\left(\frac{\text{Var}(Y_k)}{4^n}\right)$$

$$=m^2\displaystyle\sum_{k=1}^{\infty}\left(\text{Var}(Y_k)\displaystyle\sum_{n:2^{n+1}\geq k}^{\infty}\frac{1}{4^n}\right)$$

Observe que

$\displaystyle\sum_{n:2^{n+1}\geq k}\frac{1}{4^n}< \frac{16}{3k^2},$

Portanto

$ \displaystyle \sum_{n=1}^{\infty} \mathbb{P}\left(\max_{2^{n}< k < 2^{n+1}}\displaystyle\frac{S_k}{k}\right)\leq \frac{(4m)^2}{3}\sum_{k=1}^{\infty}\frac{\text{Var}(Y_k)}{k^2}< \infty. $

Assim usando o lema de Borel Cantelli temos que

$ \displaystyle\mathbb{P}\left(\limsup_{n\rightarrow \infty}A_n\right)=0, $

no qual $ A_n=\left[\displaystyle \max_{2^n< k \leq 2^{n+1}}\frac{S_k}{k}\geq\frac{1}{m}\right]. $

Logo, $ \mathbb{P}(\displaystyle\liminf_{n\rightarrow \infty}A_n)=1 $, pois se $ \mathbb{P}\left(\limsup A_n\right)=0 $ temos que para cada m fixo a probabilidade de que $ \displaystyle \max_{2^n< k< 2^{n+1}}\frac{S_k}{k} $ assuma um valor maior que $ \frac{1}{m} $ é 0.

Assim a probabilidade de que $ \displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k} $ assuma um valor maior que zero um número finito de vezes é 1. Logo,

deve ocorrer para todo n a partir de um índice, ou seja, temos que

$ \forall m, 0\leq\displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k} < \frac{1}{m} $ para todo n a partir de um índice.

Portanto concluímos que $ \displaystyle \max_{2^n< k< 2^{n+1}}\frac{|S_k|}{k}\rightarrow 0 $ quase certamente.

$ \Box $

Uma observação importante é que a condição de Kolmogorov (7.1.2.1) é suficiente, mas não é necessária para lei forte dos grandes números. Podemos construir exemplos tais que $ \displaystyle \sum_{i=1}^{\infty}\frac{\text{Var}[X_i]}{i^2}= \infty $ e que satisfaçam a lei dos grandes números.

Exemplo 7.1.2.1

Valor esperado infinito implica em variância infinita.

De fato, seja $ X $ uma variável aleatória tal que $ \mathbb{E}[X]=\infty. $

Por definição, temos que $ \text{Var}(X)=\mathbb{E}[X^2]-\mathbb{E}^2[X]. $

Mas, $ \mathbb{E}[X]=\infty $ e $ \mathbb{E}[X^2]\geq\mathbb{E}^2[X]. $

Portanto, $ \text{Var}(X)=\infty $

Em particular, variáveis aleatórias com valor esperado infinito não satisfazem a condição de Kolmogorov e consequentemente não há garantias que cumpra a lei dos grandes números.

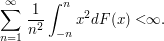

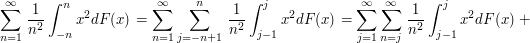

Proposição 7.1.2.2

Seja X uma variável aleatória e seja F sua função de distribuição acumulada. Então,

Demonstração:

Vamos relembrar o seguinte fato, o qual vamos utilizar para a demonstração desta proposição.

$ \displaystyle \sum_{n=j}^{n^2}< \frac{2}{j} $

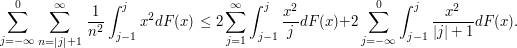

Como

$ \displaystyle\int_{-n}^{n}x^2dF(x)=\sum_{j=-n+1}^{n}\int_{j-1}^{j}x^2dF(x) $

Assim temos que:

Como $ \frac{x^2}{j}\leq x $ em $ (j-1,j] $, $ j< 1 $, e $ \frac{x^2}{|j|+1}\leq |x| $ em $ (j-1,j] $, para j\leq 0, temos

$ \Box $

Teorema 7.1.2.4 (A Lei Forte de Kolmogorov)

Seja $ X_i $ uma sequência de variáveis aleatórias independentes e identicamente distribuídas e com $ \mathbb{E}[X_i]=\mu < \infty $. Então

$ \displaystyle \sum_{i=1}^{n}\frac{X_i}{n}\rightarrow \mu, {quase certamente}. $

Demonstração:

Vale observar neste momento que basta mostrarmos para $ \mu=0 $, pois no caso geral em que $ \mu\neq 0 $ fazermos uma mudança de variável, usando $ G_n=X_n-\mu. $ Neste caso as variáveis aleatórias $ G_n $ serão independentes e indenticamentes distribuidas com $ \mathbb{E}[G_n]=0 $.

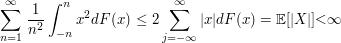

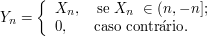

Seja $ Y_n $ definida da seguinte forma.

E seja $ Z_n=X_n-Y_n\quad\Rightarrow\quad X_n=Y_n+Z_n $

$$\frac{X_1+\cdots+X_n}{n}=\frac{Y_1+\cdots+Y_n}{n}+\frac{Z_1+\cdots+Z_n}{n}$$

Vamos dividir a demonstração deste teorema em três partes.

Primeiro mostramos que $ \displaystyle\frac{Z_1+\cdots+Z_n}{n}\rightarrow 0 $ quase certamente.

Observamos que $ Z_n\neq 0\Leftrightarrow Y_n\neq X_n\rightarrow X_n \notin (-n,n] $.

Assim,

$$\mathbb{P}(Z_n\neq 0)=\mathbb{P}(X_n\notin (-n,n])< \mathbb{P}(|X_n|> n).$$

Mas os eventos $ A_n=[Z_n\neq 0] $ satisfazem

$$\displaystyle\sum_{n=1}^{\infty}\mathbb{P}(A_n)\leq \sum_{n=1}^{\infty}\mathbb{P}(|X_n|\geq n)$$

Notemos que se os $ X_i $ são identicamentes distribuídos, então temos que:

$$\sum_{n=1}^{\infty}\mathbb{P}(|X_n|\geq n)=\sum_{n=1}^{\infty}\mathbb{P}(|X_1|\geq n)< \infty,$$

no qual a última passagem é consequência da intregabilidade de $ X_1 $.

Assim pelo lema de Borel-Cantelli decorre que $ \mathbb{P}(\displaystyle\limsup_{n\rightarrow \infty}A_n)=0 $, o que implica que:

$$\mathbb{P}(\displaystyle\limsup_{n\rightarrow \infty}Z_n\neq 0)=0$$

Ou seja,

$$\mathbb{P}(\displaystyle\liminf_{n\rightarrow \infty}A_n)=1\quad\Rightarrow\quad \mathbb{P}(Z_m=0)=1$$

com $ m> n $ para algum n suficientemente grande, isto é, $ Z_n\rightarrow 0 $ e ainda

$$\displaystyle\frac{Z_1+\cdots+Z_n}{n}\rightarrow 0\quad\Rightarrow\quad \mathbb{P}\left(\frac{Z_1+\cdots+Z_n}{n}\rightarrow 0\right)=1$$

Logo $ \displaystyle\frac{Z_1+\cdots+Z_n}{n}\rightarrow 0 $ quase certamente.

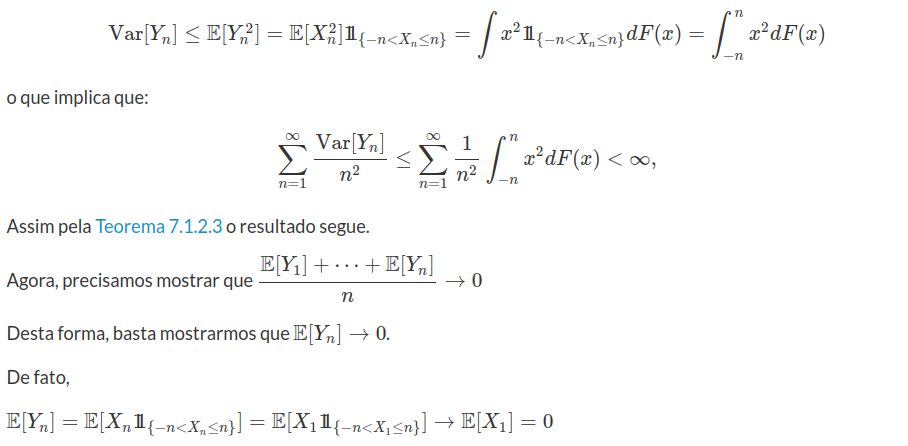

Mostramos agora que $ \displaystyle \frac{Y_1+\cdots+Y_n}{n}-\frac{\mathbb{E}[Y_1]+\cdots+\mathbb{E}[Y_n]}{n}\rightarrow 0 $ quase certamente.

Como por hipótese $ X_i $ são identicamente distribuídos, então temos que $ F_{X_1}=\cdots=F_{X_n} $.

Notemos que

Logo o teorema segue, pois

$ A=\displaystyle\left[\frac{Z_1+\cdots+Z_n}{n}\rightarrow 0\right] $ e $ B=\displaystyle\left[\frac{Y_1+\cdots+Y_n}{n}-\frac{\mathbb{E}[Y_1]+\cdots+\mathbb{E}[Y_n]}{n}\rightarrow 0\right] $.

Portanto $ \displaystyle \frac{X_1+\cdots+X_n}{n}\rightarrow 0 $ quase certamente e no caso mais geral:

$ \displaystyle\frac{X_1+\cdots+X_n}{n}\rightarrow \mu,\quad\text{quase certamente} $

$ \Box $

Teorema 7.1.2.5 (Cantelli)

Seja $ (X_i)_{i\in\mathbb{N}} $ uma sequência de variáveis aleatórias com quarto momento finito, e seja

$$E[|X_n-E[X_n]|^4]\leq C$$

com $ C\in \mathbb{R} $. Então quando $ n\rightarrow \infty $

$$\frac{S_n-E[S_n]}{n}\stackrel{q.c}{\rightarrow} 0 $$

Demonstração:

Sem perda de generalidade podemos assumir que $ \mathbb{E}[X_n]=0 $, pois caso não seja, redefinirmos $ X_n=X_n-\mathbb{E}[X_n] $. Assim para mostramos que $ \dfrac{S_n}{n}\rightarrow 0 $ quase certamente basta mostramos que

$$\displaystyle \sum^\infty_{n=1} \mathbb{P}\left(\left|\dfrac{S_n}{n}\right|\geq \epsilon\right)< \infty,~~~\forall \epsilon > 0$$

Utilizando a desigualdade de Chebyshev, basta mostrarmos que

$$\displaystyle \sum^\infty_{n=1} \mathbb{E}\left(\left|\dfrac{S_n}{n}\right|^4\right)< \infty.$$

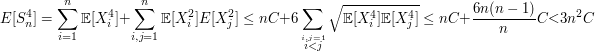

Note que $ S_n=(X_1+\cdots X_n)^4 $, logo

Logo

$$\mathbb{E}\left[\left(\frac{S_n}{n}\right)^4\right]< 3\frac{C}{n^2}$$

Assim

$$\sum^\infty_{n=1} \mathbb{E}\left[\left(\frac{S_n}{n}\right)^4\right]< 3C \sum^\infty_{n=1} \frac{1}{n^2}< \infty$$

E portanto, segue o resultado.

$ \Box $

Teorema 7.1.2.6 (Kolmogorov)

$$\displaystyle \sum^\infty_{n=1} \frac{Var[S_n]}{b^2_n}< \infty$$

Então

$$\displaystyle \frac{S_n-E[S_n]}{n}\stackrel{q.c}{\rightarrow} 0$$

Demonstração:

Vamos omitir a demonstração deste resultado, porém ela pode ser encontrada no livro do Shiryaev.

$ \Box $

Para finalizarmos esta seção, vamos apresentar alguns exemplo para fixarmos os conceitos apresentados.

Exemplo 7.1.2.2

Exemplo 7.1.2.3

Seja $ (X_i)_{i\geq 1} $ uma sequência de variáveis aleatórias independentes e identicamente distribuídas, com distribuição exponencial de parâmetro $ 1 $. Mostremos que:

$ \mathbb{P}\left(\displaystyle\limsup_{n \rightarrow \infty}\frac{X_n}{\log n}> 1\right)=1. $

Para mostrarmos isso basta mostrarmos que $ \displaystyle \sum_{i=1}^{\infty}A_i=\infty $. Assim primeiramente vamos definir o evento $ A_i=(X_i> \log i) $ para $ i\geq 1 $. Como cada $ A_i $ são eventos independentes. Portanto

$ \mathbb{P}(A_i)=\mathbb{P}(X_i> \log i)=e^{-\log{i}}=\displaystyle \frac{1}{i}. $

Desta forma concluímos que:

$ \displaystyle \sum_{i=1}^{\infty}\mathbb{P}(A_i)=\sum_{i=1}^{\infty}\frac{1}{i}=\infty $

consequentemente pelo lema de Borel-Cantelli concluímos que $ \mathbb{P}\left(\displaystyle\limsup_{n \rightarrow \infty}\frac{X_n}{\log n}> 1\right)=1 $ como queríamos demonstrar.

Exemplo 7.1.2.4

Podemos generalizar o exemplo 7.1.2.3 proposto acima, da seguinte forma seja $ X_i $ uma sequência de variáveis aleatórias independentes e identicamente distribuídas, com distribuição exponencial de parâmetro $ \lambda $. Mostremos que:

$ \mathbb{P}\left(\displaystyle\limsup_{n \rightarrow \infty}\frac{X_n}{\log n}> \frac{1}{\lambda}\right)=1. $

A demonstração segue da mesma forma, basta definirmos o conjunto $ A_i=(X_i> \log i) $ para $ i\geq 1 $. Assim

$ \mathbb{P}(A_i)=\mathbb{P}(X_i> \frac{\log i}{\lambda})=e^{-\lambda\frac{\log{i}}{\lambda}}=\displaystyle \frac{1}{i}. $

E portanto concluímos que

$ \displaystyle \sum_{i=1}^{\infty}\mathbb{P}(A_i)=\sum_{i=1}^{\infty}\frac{1}{i}=\infty $

usando novamente o lema de Borel-Cantelli concluímos que $ \mathbb{P}\left(\displaystyle\limsup_{n \rightarrow \infty}\frac{X_n}{\log n}> \frac{1}{\lambda}\right)=1. $

Exemplo 7.1.2.5

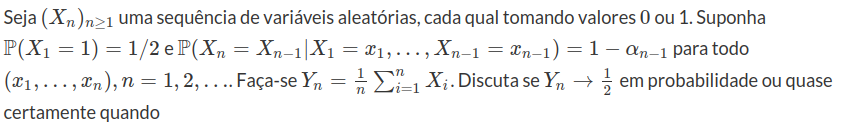

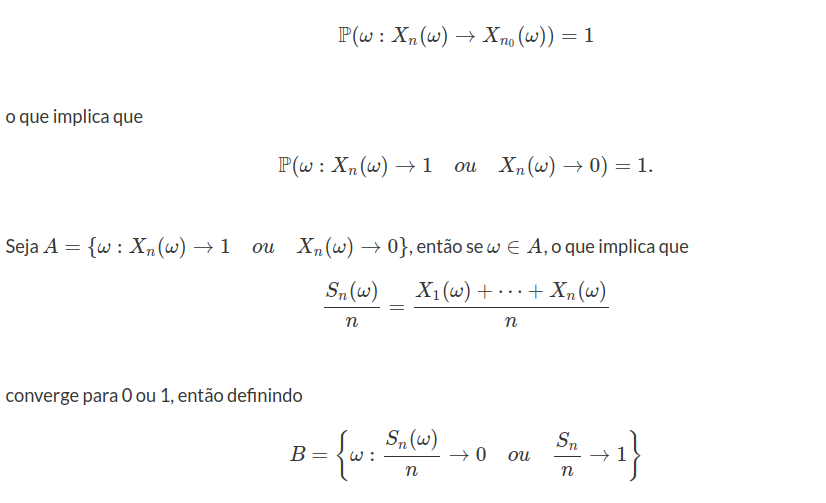

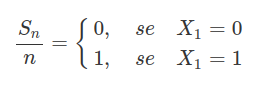

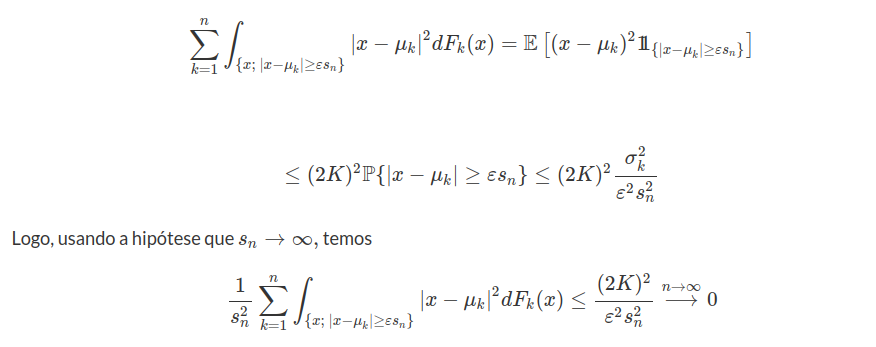

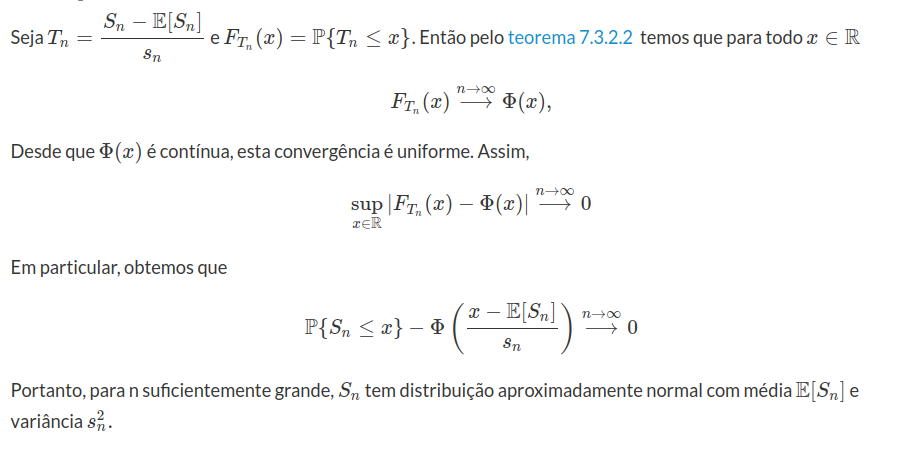

Seja $ (X_i)_{i\geq 1} $ uma sequência de variáveis aleatória independentes com distribuição Poisson com parâmetro $ \lambda $. Qual é o limite em probabilidade da sequência $ Y_n $, em que $ Y_n=\dfrac{X_1^2+\cdots+X_n^2}{n} $?