12. Processo Estocástico

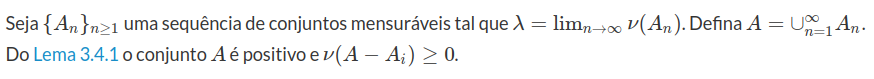

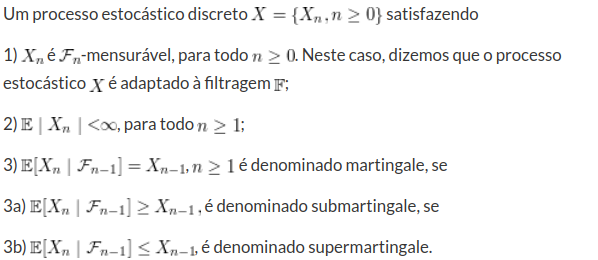

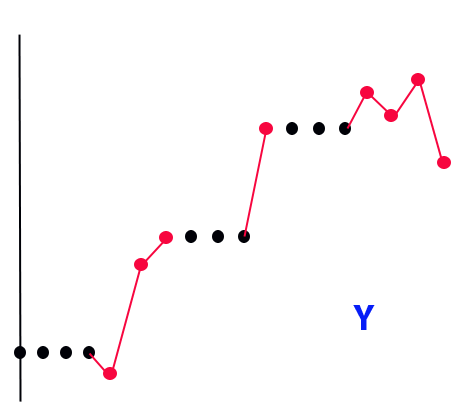

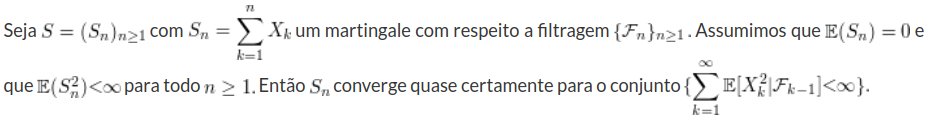

Processo estocástico é uma coleção de variáveis aleatórias que, em geral, são utilizadas para estudar a evolução de fenômenos (ou sistemas) que são observados ao longo do tempo. Assim, ao invés de descrevermos o sistema através de equações determinísticas (como, equações diferenciais ordinárias), que dado uma condição inicial, conhecemos toda a evolução do sistema, vamos utilizar processos estocásticos, para o qual, dado uma condição inicial, ainda temos diversas trajetórias possíveis para a evolução do sistema.

1 - Base Estocástica

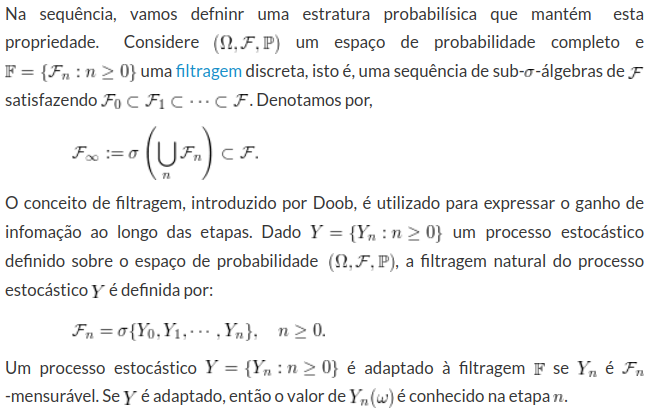

O processo estocástico é uma coleção de variáveis aleatórias que descreve a evolução de um sistema ao longo do tempo. Assim, a evolução da informação acumulada ao longo do tempo é fundamental para estudarmos o comportamento do sistema. Esta evolução da informação é definida através de uma coleção encaixante de $ \sigma $-álgebras, denominada filtragem. O conceito de filtragem foi introduzido por Doob e corresponde a uma das principais ferramentas para estudarmos processos estocásticos

Dado um espaço de probabilidade $ (\Omega , \mathcal{F} , \mathbb{P}) $, uma filtragem é uma coleção de sub-$ \sigma $-álgebras$ ( \mathcal{F_t} : t \geq 0 ) $ de $ \mathcal{F} $ tal que $ \mathcal{F_s} \subset \mathcal{F_t} $ para $ s \leq t $. Podemos interpretar $ \mathcal{F_t} $ como a $ \sigma $-álgebra dos eventos que ocorrerarm até o tempo $ t $ e a filtragem $(\mathcal{F_t} : t \geq 0)$ como a coleção de $ \sigma $-álgebras que representam a evolução da informação do sistema.

Definição 1.1

Dado uma filtragem $ \mathbb{F} $ associamos as seguintes filtragens:

$$\mathcal{F_{t^+}}=\displaystyle \bigcap_{s> t}\mathcal{F_s},$$

para todo $ t \geq 0 $ e

$$\mathcal{F_{t^-}}=\sigma( \displaystyle \bigcup_{s< t}\mathcal{F_s})=\bigvee_{s\leq t} \mathcal{F_s},$$

para todo $ t> 0 $. Para $ t=0 $ utilizamos $ \mathcal{F_{0^-}}=\mathcal{F_0} $.

Definição 1.2

Dizemos que uma filtragem $ \mathbb{F} $ é contínua a direita se $ \mathcal{F_t}=\mathcal{F_{t^+}}, $ para todo $ t \geq 0 $. Para facilitar a notação tomamos $ \mathcal{F_{\infty}}=\mathcal{F} $ e ainda

$$\displaystyle \mathcal{F_{\infty^-}}=\bigvee_{s\in\mathbb{R_{+}}}\mathcal{F_s}.$$

Lembrando que o símbolo $ \bigvee $ significa que é a $ \sigma $-álgebra gerada pela união das $ \mathcal{F_s} $, pois união de $ \sigma $-álgebra nem sempre é $ \sigma $-álgebra. A base estocástica $ \mathfrak{B}=(\Omega,\mathcal{F},\mathbb{F},\mathbb{P}) $ é chamada também de espaço de probabilidade filtrado.

Definição 1.3

Dizemos que uma base estocástica $ \mathfrak{B}=(\Omega,\mathcal{F},\mathbb{F},\mathbb{P}) $ satisfaz as hipóteses usuais da teoria geral de processos estocásticos se:

(i) O espaço $ (\Omega,\mathcal{F},\mathbb{P}) $ é completo.

(ii) $ \mathbb{F} $ é $ \mathbb{P} $-completada, isto é, $ \mathcal{F_0} $ contém todos os conjuntos $ \mathbb{P} $-nulos da $ \sigma $-álgebra $ \mathcal{F} $. Neste caso, temos que todo conjunto $ F $ que pertence ao $ \mathbb{P} $ completamento de $ \mathcal{F} $ com $ \mathbb{P}(F)=0 $ também pertence a $ \mathcal{F_t} $ para todo $ t \geq 0 $.;

(iii) A filtragem $ \mathcal{F} $ é contínua à direita.

1.1 - Tempos de Parada

Considere $ T $ uma variável aleatória que pode ser interpretada como o tempo de ocorrência de um fenômeno que depende “casualmente” da evolução do sistema. Aqui, casualidade significa que, para cada tempo $ t \geq 0 $, a resposta à questão: o fenômeno já ocorreu? depende somente da informação acumulada sobre o sistema até o tempo $ t \geq 0 $. Assim, o conjunto $ ( T \leq t ) $ deve ser um elemento da $ \sigma $-álgebra $ \mathcal{F_t} $. Seja $ \mathfrak{B}=(\Omega,\mathcal{F},\mathbb{F},\mathbb{P}) $ a base estocástica que carrega toda a informação acumulada sobre o sistema ao longo do tempo.

Definição 1.1.1

Seja $ T $ uma variável aleatória, tal que $T:\Omega \rightarrow \overline{\mathbb{R_+}}$, com $ \overline{\mathbb{R}}_+=[0,\infty] $, a parte dos positivos da reta estendida (incluindo o $ \infty $). Então dizemos que $ T $ é um $ \mathbb{F} $-tempo de parada se, e somente se,

$$(T\leq t)\in \mathcal{F_t}, \quad t \geq 0.$$

Observação

Note que $ T $ é um tempo de parada segundo alguma filtragem, ou seja, se mudarmos a filtragem pode ser que ele deixe de ser um tempo de parada. Além disso, usamos frequentemente o termo tempo de parada ao invés de $ \mathbb{F} $-tempo de parada, quando não houver dúvidas em relação a qual filtragem estamos nos referindo, ressaltamos também que $(T\leq t)=(\omega\in \Omega:T(\omega)\leq t)$

Proposição 1.1.1

Algumas propriedades de tempos de parada.

i) Se $ T $ é um tempo de parada com respeito à filtragem $ \mathbb{F} $, então $ (T< t)\in \mathcal{F_t} $ para todo $ t\geq 0 $

ii) Se $ T(\omega)=a, ~\forall \omega \in \Omega $, para qualquer constante $ a\in \overline{\mathbb{R}}_+ $. Então, $ T $ é um tempo de parada.

iii) Se $ T $ é um tempo de parada e $ a\in \overline{\mathbb{R}}_+ $ uma constante, então T+a também é um tempo de parada.

iv) Se $ T $ e $ S $ são tempos de parada sobre a mesma filtragem, então $ S+T $ também é um tempo de parada.

v) Se $ T $ e $ S $ são tempos de parada com respeito a mesma filtragem, então $ \min(S,T) $ e $ \max(S,T) $ também são tempos de parada.

vi) Se $ T $ é um tempo de parada e $ a\in \overline{\mathbb{R}}_+ $ uma constante, então $ \min(T,a) $ é um $ \mathcal{F}_a $- tempo de parada.

Demonstração

i) Note que $ (T< t)\in \mathcal{F_t} $, é equivalente a $ (T\leq t-1/n)\in \mathcal{F_t} $.

De fato, note que $ (T\leq t-1/n)\in \mathcal{F_{t-1/n}}\subset\mathcal{F_{t}} $ e portanto

$$(T< t )=\displaystyle \bigcup_{n\geq 1}(T\leq t-1/n)\in \mathcal{F_t},$$

para todo $ t \geq 0 $. Observe que entretanto $ (T< t)\in \mathcal{F_t} $ não implica $ (T\leq t)\in \mathcal{F_t} $, a menos que a filtragem seja contínua a direita. Neste caso, as definições são equivalentes.

ii) De fato, note que se $ T(\omega)=a, \forall \omega \in \Omega $ então para $ t< a $ temos que

$$(T\leq t)=\emptyset \in \mathcal{F_t}, \forall t< a,$$

pois $ \mathcal{F_t} $ é $ \sigma $-álgebra. Agora se $ t\geq a $ então

$$(T\leq t)=\Omega \in \mathcal{F_t},$$

para todo $ t \geq 0 $. Portanto $ T $ é um tempo parada.

iii) Temos que $ T $ é um tempo de parada logo, $ (T\leq k)\in \mathcal{F}_k $. Vamos mostrar que $ S=T+t $ também é um tempo de parada, ou seja, $ (S\leq k)\in\mathcal{F}_k $. Basta notar que se $ k< t $ então

$$(S\leq k)=\emptyset\Rightarrow (S\leq k)\in \mathcal{F}_k,~~\forall k< t.$$

Agora suponha que $ k\geq t $, então temos que

$$(S\leq k)=(T+t\leq k)=(T\leq k-t)\in\mathcal{F}_{k-t}\Rightarrow(S\leq k)\in \mathcal{F}_k,$$

pois $ \mathcal{F}_{k-t}\subset \mathcal{F}_k,~~\forall k\geq t. $ E o resultado segue.

iv) Seja $ t> 0 $, então

$$(T+S> t)=(T=0, S> t)\cup (0< T< t, T+S> t)\cup (T> t, S=0 )\cup(T\geq t, S > 0).$$

Como da um desses eventos pertence a $ \sigma $-álgebra $ \mathcal{F_t} $, então temos que a união também pertence e portanto $ S $ é tempo de parada e o resultado segue.

v) Note que, $ (\max(T,S)\leq t)=(S\leq t)\cap(T\leq t) $ e como $ (S\leq t)\in\mathcal{F_t} $ e $ (S\leq t)\in\mathcal{F_t} $, pois são tempos de parada e como $ \mathcal{F_t} $ é $ \sigma $-álgebra temos que

$$(\max(T,S)\leq t)=(S\leq t)\cap(T\leq t)\in \mathcal{F_t},$$

para todo $ t \geq 0 $. Para o mínimo basta observar que $ (\min(T,S)\leq t)=(S\leq t)\cup(T\leq t) $ e o resultado segue de forma análoga.

vi) De fato, basta notar que se $ t\leq a $ temos que

$$(\min(T,a)\leq t)=(T\leq t)\in\mathcal{F_t}\subset\mathcal{F}_a.$$

Por outro lado, se $ t\geq a $ então:

$$(\min(T,a)\leq t)=\Omega \in \mathcal{F}_a.$$

Portanto o resultado segue.

Teorema 1.1.1

Seja $ (T_n,n\geq 1) $ uma familia de $ \mathbb{F} $ tempos de parada. Então $ \sup_{n}T_n $ é um $ \mathbb{F} $ tempo de parada, e ainda $ \inf_n T_n $ é um $ (\mathcal{F}_{t+}) $ tempo de parada.

Demonstração

De fato, basta notar que

$$\displaystyle (\sup_{n}T_n \leq t)=\bigcap_n (T_n\leq t)\in\mathcal{F_t}$$

$$\displaystyle (\inf_{n}T_n \leq t)=\bigcup_{m\leq 1}\bigcap_{n\geq 1}(T_n< t+\frac{1}{m})\in\bigcap_{m\leq 1}\mathcal{F}_{t+\frac{1}{m}}=\mathcal{F}_{t+}$$

Observação

Em particular podemos notar que se $ \mathcal{F_t} $ é contínua a direita, então o $ \limsup T_n $ e $ \liminf T_n $ e o $ \lim T_n $ (caso existe) são $ \mathbb{F} $ tempos de parada.

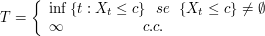

Exemplo 1.1.1

Se $X: \Omega \times [0,\infty) \rightarrow \mathbb{R}$ é um processo estocástico com trajetórias contínuas à direita (ou contínuas à esquerda) e $ \mathbb{F} $ uma filtragem contínua à direita. Também admitimos que $ X(t) $ é $ \mathcal{F_t} $-mensurável para todo $ t \geq 0 $. Neste caso, dizemos que $ X $ é adaptado à filtragem $ \mathbb{F} $. Definimos $ T $ por:

Então $ T $ é um tempo de parada.

Demonstração

Temos que $ (T> t)=(X(s)< c ~\forall s\in [0,t]) $. Como $ X $ é contínuo à direita (ou contínuo à esquerda) obtemos que:

$$\bigcap_{s \in [0,t]}~\displaystyle (X(s)< c)=\bigcup_{n=1}^{\infty}\bigcap_{k=0}^{2^n}(X(kt/2^n)< c)\in \mathcal{F_t},$$

para todo $ t \geq 0 $. Portanto o resultado segue.

$ \Box $

Considere $ (\Omega, \mathcal{F}, \mathbb{P}) $ um espaço de probabilidade, $ \mathbb{F} $ uma filtragem e $ T $ um tempo de parada. Na sequência, vamos definir a $ \sigma $-álgebra $ \mathcal{F_t} $ que representa as informações até o tempo $ T $.

Definição 1.1.2

i) Se $ T $ é um tempo de parada denotamos por $\mathcal{F_t}=(A\in \mathcal{F}:A\cap {T\leq t}\in\mathcal{F_t}, \forall t\in\mathbb{R_+})$.

ii) Se $ T $ é um tempo de parada denotamos por $ \mathcal{F_{T^-}} $ a $ \sigma $-álgebra gerada por $ \mathcal{F_0} $ e todos os conjuntos da forma $ A\cap (t< T) $, com $ A \in \mathcal{F_t} $ e $ t \geq 0 $.

A $ \sigma $-álgebra $ \mathcal{F_{T^-}} $ representas os eventos anteriores ao tempo de parada $ T $. Observe que $ \mathcal{F_{T^-}} $ também é a $ \sigma $-álgebra gerada pela seguinte família de subconjuntos de $ \mathcal{F} $,

$$(F \cap {t \leq T}: F \in \mathcal{F_{t^-}}, t \geq 0).$$

Note que a definição (i) acima apresenta algumas sutilezas, como por exemplo, será que de fato, $ \mathcal{F_t} $ é uma $ \sigma $-álgebra. Além disso, se tomarmos $ T=t $ para alguma constante $ t \geq 0 $, devemos obter que $ \mathcal{F_t}=\mathcal{F_t} $.

Proposição 1.1.2

A definição 1.1.2 (i) está bem definida.

Demonstração

Primeiramente mostremos que $ \mathcal{F_t} $ é de fato uma $ \sigma $-álgebra. De fato, $ \emptyset\in \mathcal{F_t} $, pois $ \emptyset \cap(T\leq t)=\emptyset \in \mathcal{F_t}, \forall t \in \mathbb{R_+} $. Mostremos que se $ A\in \mathcal{F_t} $ então $ A^c \in \mathcal{F_t} $. De fato, se

$$A\in \mathcal{F_t}\Rightarrow A\cap (T\leq t)\in \mathcal{F_t},\forall t \in \mathcal{R}_+.$$

Mas isso implica que $ (A\cap(T\leq t))^c\in \mathcal{F_t}, \forall t \in \mathbb{R_+} $, pois $ \mathcal{F_t} $ é $ \sigma $-álgebra. Além disso, como

$$(T\leq t)\in \mathcal{F_t}, \forall t\in \mathbb{R_+},$$

obtemos que

$$(A\cap(T\leq t))^c\cap (T\leq t)=A^c\cap(T\leq t)\in \mathcal{F_t}, \forall t\in \mathbb{R_+}.$$

Portanto temos que $ A^c\in \mathcal{F_t}. $

A seguir, tomamos $ A_1,A_2,\cdots \in \mathcal{F_t} $ uma sequência de conjuntos disjuntos, mostremos que $ \displaystyle \bigcup_{i=1}^{\infty}A_i\in \mathcal{F_t} $. De fato, basta notar que $ A_i\cap (T\leq t)\in \mathcal{F_t},\forall t\in \mathbb{R_+} ~e~ \forall i\in \mathbb{N}. $ Assim, obtemos que

$$\displaystyle \left(\bigcup_{i=1}^{\infty}A_i\right)\cap(T\leq t)=\bigcup_{i=1}^{\infty}\left(A_i\cap(T\leq t)\right)\Rightarrow \bigcup_{i=1}^{\infty}A_i\in \mathcal{F_t}.$$

Como consequência, obtemos que $ \mathcal{F_t} $ é uma $ \sigma $-álgebra.

Agora mostremos que se $ T=t $ para alguma constante $ t \geq 0 $, então $ \mathcal{F_t}=\mathcal{F_t} $. Na realidade, basta notarmos que se $ k< t $, então o conjunto $ (T\leq k)=\emptyset $ e se $ k\geq t $, então o conjunto $ (T\leq k)=\Omega $. Assim, obtemos que

$$A\cap\emptyset=\emptyset\in \mathcal{F}_k,\forall k< t$$

e

$$A\cap \Omega=A\in \mathcal{F}_k, \forall k\geq t \Leftrightarrow A\in\mathcal{F_t}.$$

Como consequência, concluímos que $ \mathcal{F_t}=\mathcal{F_t} $, e portanto não existe ambiguidade na notação.

$ \Box $

Teorema 1.1.2

Se $ T $ é um $ \mathbb{F}=(\mathcal{F_t}: t \geq 0) $ tempo de parada, então $ \mathcal{F_{T-}}\subset \mathcal{F_t} $ e T é $ \mathcal{F_{T-}} $-mensurável e portanto $ \mathcal{F_t} $-mensurável

Demonstração

Para mostramos que $ \mathcal{F_{T-}}\subset \mathcal{F_t} $, basta mostramos que o geradores de $ \mathcal{F_{T-}} $ pertencem a $ \mathcal{F_t} $. De fato, note que

$$\mathcal{F_0}\subset \mathcal{F_t}$$

para todo $ t \geq 0 $ e, ainda que

$$A_s \cap(s< T)\cap(T\leq t)=A_s\cap(s< T\leq t )\in \mathcal{F_t},~ \forall s,t\in [0,\infty)$$

com $ A_s\in\mathcal{F_s} $. Com isso concluimos que $ \mathcal{F_{T-}}\subset \mathcal{F_t} $. Agora para mostrar que T é $ \mathcal{F_{T-}} $-mensurável basta mostar que $ (T> a)\in\mathcal{F_{T-}}, ~\forall a \geq 0 $ e que $ (T=0)\in\mathcal{F_{T-}} $, o que de fato ocorre por que esses conjuntos são alguns dos geradores de $ \mathcal{F_{T-}} $.

$ \Box $

Teorema 1.1.3

Seja $ T $ um $\mathbb{F}=(\mathcal{F_t}:t\geq 0)$ tempo de parada e $S:\Omega\rightarrow [0,\infty]$ uma variável aleatória $ \mathcal{F_t} $-mensurável tal que $ S\geq T $, então S é um tempo de parada.

Demonstração

De fato, basta notar que

$$(S\leq t)=(S\leq t)\cap(T\leq t)\cup (S\leq t )\cap(T> t)$$

Entretanto como $ S\geq T $ temos que $ (S\leq t )\cap(T> t)=\emptyset $. Além disso, como $ S $ é $ \mathcal{F_t} $-mensurável, temos que $ (S\leq t)\in \mathcal{F_t} $ e portanto por definição temos que $ (S\leq t )\cap(T\leq t)\in \mathcal{F_t} $

$ \Box $

Uma consequência do teorema 1.1.3: acima é o corolário abaixo

Corolário 1.1.1

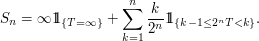

Qualquer tempo de parada pode ser aproximado por uma sequência decrescente $ (S_n,n\geq 1) $ de $\mathbb{F}=(\mathcal{F_t}:t \geq 0)$ tempos de parada assumindo um número enumerável de valores.

Demonstração

Basta tomarmos

$ \Box $

Teorema 1.1.4

Sejam $ S $ e $ T $ dois $\mathbb{F}=(\mathcal{F_t}: t \geq 0)$ tempos de parada. Para todo $ A\in \mathcal{F_s} $ temos que $ A\cap(S\leq T)\in \mathcal{F_t} $ e $ A\cap (S< T)\in \mathcal{F_{T-}} $.

Demonstração

Para todo $ t\geq 0 $,

$$A\cap (S\leq T)\cap (T\leq t)=A\cap (S\leq t)\cap (T\leq t )\cap(\min{(S, t)}\leq \min{(T,t)})$$

Agora $ (\min{(S, t)}\leq \min{(T,t)})\in\mathcal{F_t} $, desde que $ \min{(S, t)} $ e $ \min{(T,t)} $ são $ \mathcal{F_t} $-mensurável, além disso $ A\cap (S\leq t)\in \mathcal{F_t} $, pois $ A\in\mathcal{F_s}\subset\mathcal{F_t} $ e claro como $ (T\leq t) $ é tempo de parada temos que $ (T\leq t)\in\mathcal{F_t} $, desta forma temos que $ A\cap (S\leq T)\cap (T\leq t)\in \mathcal{F_t}, ~\forall t\geq 0 $. Portanto concluímos que $ A\cap(S\leq T)\in \mathcal{F_t} $.

A segunda implicação deve-se ao fato de

$$A\cap (S< T)=\displaystyle \bigcup_{r\in \mathbb{Q}}A\cap (S\leq r)\cap(r\leq T)\in\mathcal{F_{T-}}$$

pois $ A\cap (S\leq r)\in \mathcal{F_{r}} $ e portanto $ A\cap (S\leq r)\cap(r\leq T) $ é um gerador de $ \mathcal{F_{T-}} $.

$ \Box $

Teorema 1.1.5

Sejam $ S $ e $ T $ dois $\mathbb{F}=(\mathcal{F_t}:t\geq 0)$ tempos de parada tal que $ S\leq T $. Então $ \mathcal{F_s}\subset\mathcal{F_t} $ e $ \mathcal{F_{S-}}\subset\mathcal{F_{T-}} $

Demonstração

Para concluirmos esse teorema, basta observarmos que $ A\cap(S\leq T)\in\mathcal{F_s} $, para todo $ A\in \mathcal{F_s} $, por que $ (S\leq T)=\Omega $, logo $ \mathcal{F_s}\subset \mathcal{F_t} $. Agora $ \mathcal{F_{S-}}\subset\mathcal{F_{T-}} $, pois todos os geradores de $ \mathcal{F_{S-}} $ também são geradores de $ \mathcal{F_{T-}} $, pois se $ A\in\mathcal{F_t} $

$$A\cap(t< S)=A\cap(t< S)\cap(t< T)=B\cap(t< T)$$

com $ B\in\mathcal{F_t} $. Portanto o resultado segue.

$ \Box $

Teorema 1.1.6

Seja $ (T_n,n\geq 1) $ uma sequência monótona de $\mathbb{F}=(\mathcal{F_t}:t\geq 0)$ tempos de parada, no qual $ \mathbb{F} $ contínua a direita. Então

i) Se $ (T_n, n\geq 1) $ é descrescente $ \mathcal{F_t}=\displaystyle \bigcap_{n\geq 1}\mathcal{F_{T_n}} $

ii) Se $ (T_n, n\geq 1) $ é crescente $ \mathcal{F_{T-}}=\displaystyle \bigvee_{n\geq 1}\mathcal{F_{T_n-}} $

Demonstração

Primeiramente note que $ T=\displaystyle \lim_n T_n $ é um tempo de parada, como demonstrado no teorema 1.1.1.

i) Pelo teorema 1.1.5 temos que $ \mathcal{F_t}\subset\mathcal{F_{T_n}},~\forall n\geq 1 $, portanto $ \mathcal{F_t}\subset\displaystyle \bigcap_{n\geq 1}\mathcal{F_{T_n}} $.

Inversamente seja $ A\in\mathcal{F_{T_n}}~\forall n\geq 1 $, logo para todo n temos que

$$A\cap (T_n< t)\in \mathcal{F_t}, ~\forall t\geq 0$$

Portanto temos que $ A\cap (T< t)\in \mathcal{F_t}, ~\forall t\geq 0 $, como $ \mathcal{F_t} $ é uma filtragem contínua a direita, temos que $ A\cap (T\leq t)\in \mathcal{F_t}, ~\forall t\geq 0 $, o que implica que $ A\in \mathcal{F_t} $.

ii) Pelo teorema 1.1.5 temos que $ \mathcal{F_{T_n-}}\subset \mathcal{F_{T-}},~\forall n\geq 1 $ e portanto

$$\displaystyle \bigvee_{n\geq 1}\mathcal{F_{T_n-}}\subset\mathcal{F_{T-}}$$

Inversamente seja $ A_s \cap (s< T) $ um gerador de $ \mathcal{F_{T-}} $, com $ A_s \in \mathcal{F_s} $. Note que $ A_s \cap(s< T) $, também está contido em $ \displaystyle \bigvee_{n\geq 1}\mathcal{F_{T_n-}} $, pois $ A_s \cap (s< T)=\displaystyle \lim_n A_s \cap(s< T_n) $. E portanto o resultado segue.

$ \Box $

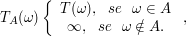

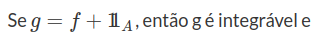

Proposição 1.1.3

Se $ A\in\mathcal{F_t} $, então

é um $ \mathbb{F} $-tempo de parada.

Demonstração

Vamos mostrar que $ (T_A\leq t)\in \mathcal{F_t} $. Basta notar que se $ A\in\mathcal{F_t} $, então $ A\cap(T\leq t)\in \mathcal{F_t}, ~ \forall t $. Assim temos que

$$(T_A\leq t)=A\cap(T\leq t)\in \mathcal{F_t},\forall t.$$

Portanto o resultado segue.

$ \Box $

Teorema 1.1.7

Se $ T $ é um $ \mathcal{F_t} $ tempo de parada e $ A\in\mathcal{F_\infty}=\mathcal{F}=\displaystyle \bigvee_{t\geq 0}\mathcal{F_t} $ o evento $ A\cap(T=\infty)\in \mathcal{F_{T-}} $

Demonstração

Primeiramente defina $G=(B\in\mathcal{F}:B\cap{T=\infty}\in \mathcal{F_{T-}})$, note que $ G $ é $ \sigma $-álgebra. De fato,

$ \emptyset \in G $, pois $ \emptyset\cap(T=\infty)=\emptyset\in\mathcal{F_{T-}} $. Da mesma forma temos que

$ \Omega \cap (T=\infty)=(T=\infty)\in \mathcal{F_{T-}} $. Além disso, se $ A_0,A_1,A_2,\cdots \in G $ então

$ A_i\cap(T=\infty)\in \mathcal{F_{T-}},~\forall i\geq 0 $. Assim, como $ \mathcal{F_{T-}} $ é $ \sigma $-álgebra, obtemos que $ \bigcap_{n\geq 0}A_n(T=\infty)\in\mathcal{F_{T-}} $ e portanto $ \bigcap_{n\geq 0}A_n $, logo $ G $ é $ \sigma $-álgebra.

Assim precisamos mostrar que $ \mathcal{F_n}\subset G, \forall \mathcal{F_n} $,e, como consequência $ \mathcal{F_\infty}\subset G $ e o resultado segue.

Então seja $ A\in\mathcal{F_n} $. Temos que $ A\cap(T=\infty)=\displaystyle \bigcap_{m\geq n}(A\cap(m< T))\in \mathcal{F_{T-}} $, pois $ A\cap(m< T) $ é um gerador de $ \mathcal{F_{T-}} $, sempre que $ m\geq n $. Finalizando a prova.

$ \Box $

Teorema 1.1.8

Sejam $ S $ e $ T $ dois $\mathbb{F}=(\mathcal{F_t}:t\geq 0)$ tempos de parada satisfazendo $ S\leq T $. Se além disso, $ S< T $ quando $ (0< T< \infty) $, então $ \mathcal{F_s}\subset \mathcal{F_{T-}} $

Demonstração

Para todo $ A\in \mathcal{F_s} $, podemos escrever o conjunto $ A $ da seguinte forma, $ (A\cap(S=0))\cup(S< T)\cup(A\cap(T=\infty)) $.

Mas note que $ A\cap (S=0)\in \mathcal{F_0} $, pela definição de $ \mathcal{F_s} $ e ainda temos que $ (S< T)\in \mathcal{T-} $ pelo Teorema 1.1.4. e por fim temos que $ A\cap(T=\infty)\in \mathcal{F_{T-}} $ pelo teorema anterior. Portanto o resultado segue.

$ \Box $

Corolário 1.1.2

Seja $ (T_n,n\geq 1) $ uma sequência monótona de $ \mathbb{F} $ tempos de parada, com $ \mathbb{F} $ contínua a direita. Então

i) Se $ (T_n,n\geq 1) $ e decrescente e se para todo $ n\geq 1 $ temos que $ T< T_n $ quando $ (0< T_n< \infty) $, então $ \mathcal{F_t}=\displaystyle \bigcap_{n\geq 1}\mathcal{F_{T_n-}} $

ii) Se $ (T_n,n\geq 1) $ e crescente e se para todo $ n\geq 1 $ temos que $ T_n< T $ quando $ (0< T< \infty) $, então

$ \mathcal{F_{T-}}=\displaystyle \bigvee_{n\geq 1}\mathcal{F_{T_n}} $

Demonstração

É consequência imediata do teorema 1.1.6 e dos teoremas 1.1.7 e teorema 1.1.8.

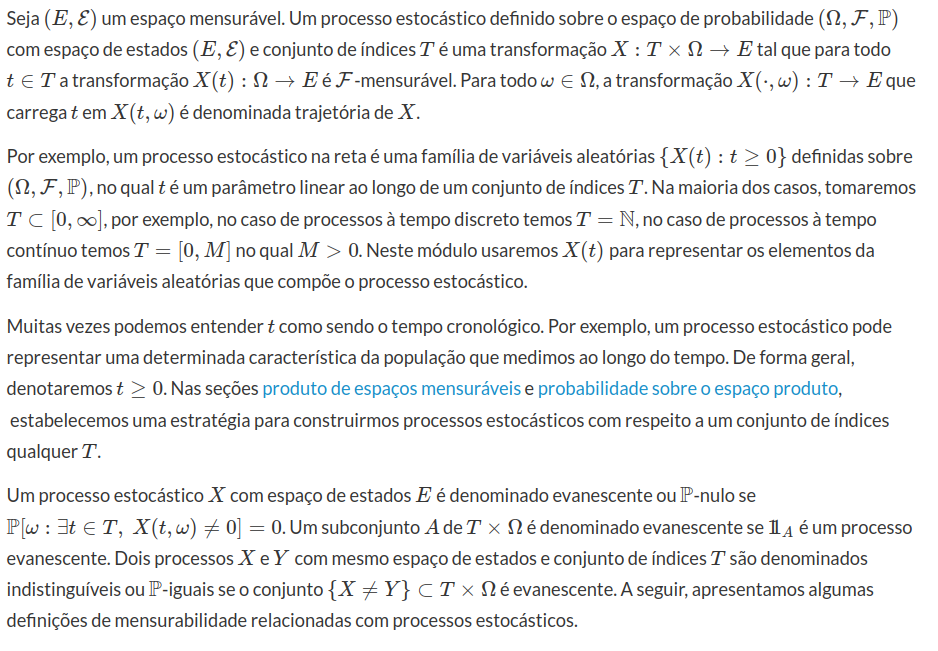

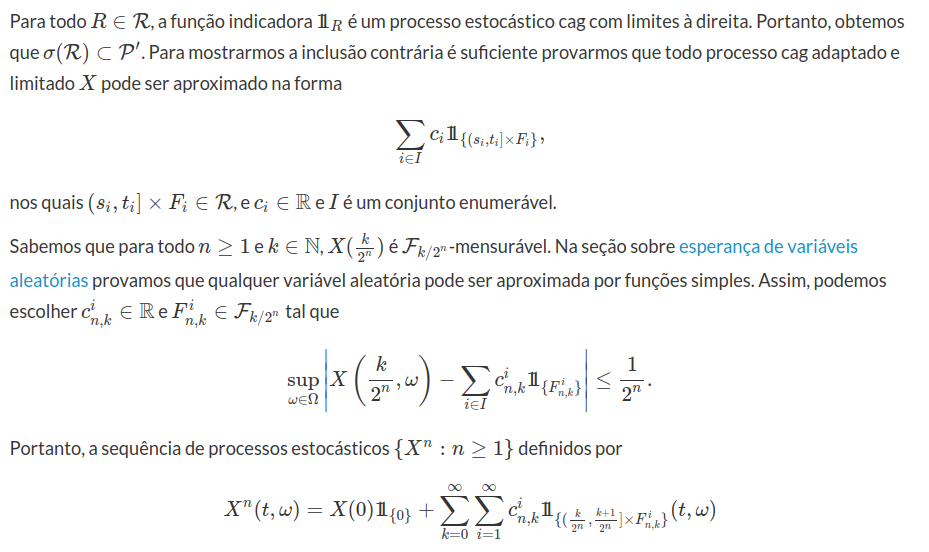

2 - Processo Estocástico

Considere $ (\Omega, \mathcal{F} , \mathbb{F}, \mathbb{P}) $ uma base estocástica, no qual $ (\Omega , \mathcal{F} , P) $ é um espaço de probabilidade e $\mathbb{F}=(\mathcal{F_t}: t \geq 0)$ uma filtragem. Neste módulo, vamos introduzir o conceito de processo estocástico e suas principais propriedades.

Definição 2.1

Seja $ (\Omega, \mathcal{F}, \mathbb{F},\mathbb{P}) $ uma base estocástica e $ X $ um processo estocástico com conjunto de índices $ T $ e espaço de estados $ (E,\mathcal{E}) $.

Definição 2.2

Um processo $ X $ é adaptado a filtragem $ \mathbb{F} $, se $ X(t) $ é $ \mathcal{F_t} $-mensurável para todo $ t \in T $. Muitas vezes, dizemos que o processo $ X $ é não antecipativo. O processo $ X $ é denominado mensurável se a transformação $X:(T\times \Omega, \beta_T \times \mathcal{F}) \rightarrow (E,\mathcal{E})$ é mensurável no qual $ \beta_T $ denota a $ \sigma $-álgebra de Borel do conjunto de índices $ T $.

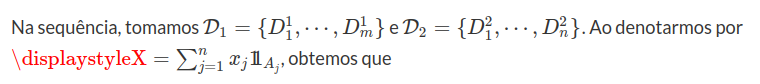

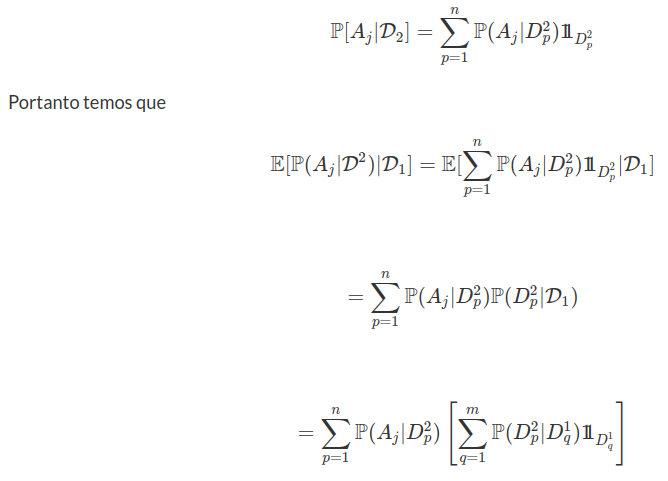

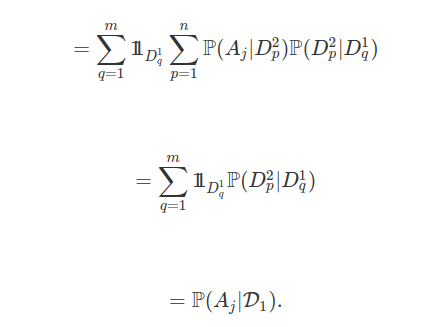

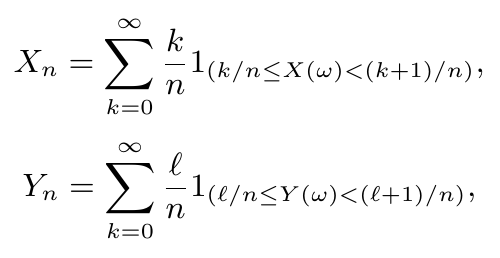

Na sequência, tomamos como conjunto de índices $ T \subset [0, \infty] $. Um processo estocástico $ X $ é dito progressivamente mensurável, se para todo $ t\in T $ a transformação $ X $ restrita a $ ([0,t] \cap T)\times \Omega $ é $ \beta_{[0,t]} \times \mathcal{F_t} $-mensurável, no qual $ \beta_{[0,t]} $ denota a $ \sigma $-álgebra de Borel dos subconjuntos de $ [0,t]\cap T $.

Definição 2.3

A filtragem interna de um processo é definida como sendo

$$\mathcal{F_t}=\sigma(X_s:s\leq t),\quad t\geq 0.$$

Obviamente, que todo processo $ X $ é adaptado e progressivamente mensurável com respeito a sua filtragem interna.

Suponha que o espaço de estados $ E $ seja um espaço topológico com $ \mathcal{E} $ a $ \sigma $-álgebra de Borel (gerada pelos abertos da topologia). Um processo estocástico $ X $ é denominado contínuo à direita (cad) se este possui trajetória contínuas à direita. Da forma análoga, o processo $ X $ é contínuo à esquerda (cag) se este possui trajetórias contínuas à esquerda. Também, dizemos que o processo estocástico $ X $ é contínuo se este tem trajetórias contínuas e dizemos $ X $ é cadlag se possui trajetórias contínuas à direita e com limites à esquerda.

Teorema 2.4

Todo Processo $ X $ adaptado e cad (respectivamente, cag) é progressivamente mensurável.

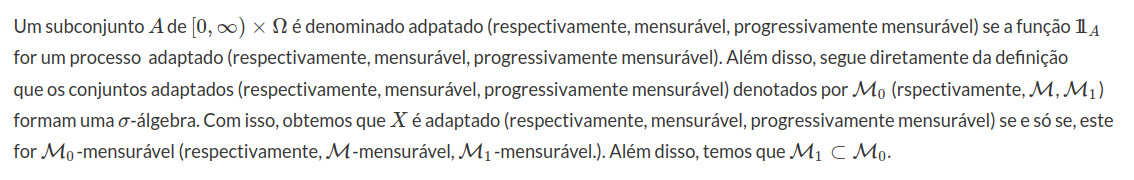

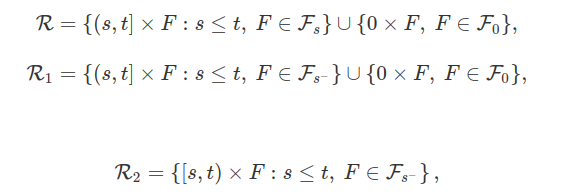

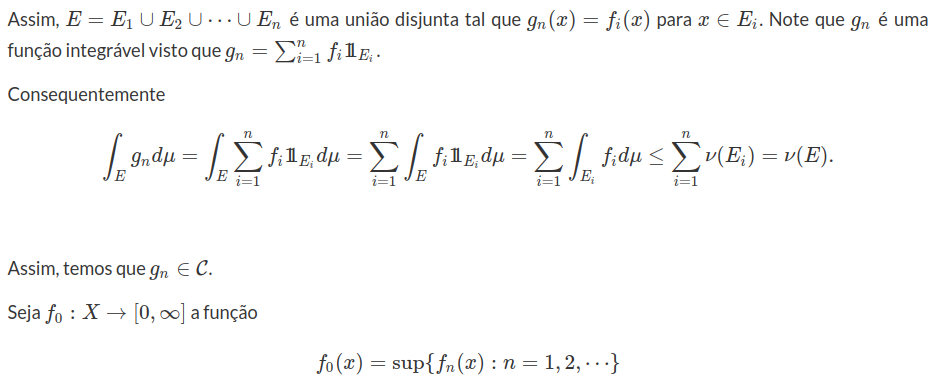

Desde que $ X $ é adaptado, os processo estocásticos $ X^n_1 $ e $ X^n_2 $ são $ \beta_{[0,s]}\times \mathcal{F_s} $-mensurável em $ [0,s] \times \Omega $. Se $ X $ é cad (respectivamente, cag) a sequência n \geq 1) $ (respectivamente, n \geq 1) $) converge em $ [0,s] \times \Omega $ para $ X $. Portanto, obtemos que $ X $ é progressivamente mensurável. Segue o teorema.

Considere $ (\Omega, \mathcal{F}, \mathbb{F}, \mathbb{P}) $ uma base estocástica. Dizemos que um subconjunto $ O \subset [0, \infty) \times \Omega $ é opcional se este pertence a $ \sigma $-álgebra $ \mathcal{O} $ gerada pelos processos estocásticos cadlag à valores nos reais. Um processo estocástico $ X $ a valores no espaço topológico $ E $ é denominado opcional se este for $ \mathcal{O} $-mensurável. Como consequência do teorema 2.4 temos que $ \mathcal{O} \subset \mathcal{M}_1 $.

A $ \sigma $-álgebra $ \mathcal{P} $ de subconjuntos de $ [0, \infty) \times \Omega $ gerada pelos processos adaptados e contínuos à valores reais é denominada previsível. Um processo estocástico $ X $ a valores no espaço topológico $ E $ é denominado previsível se este for $ \mathcal{P} $-mensurável.

Teorema 2.5

(1) A seguinte inclusão é válida: $ \mathcal{P} \subset \mathcal{O} $.

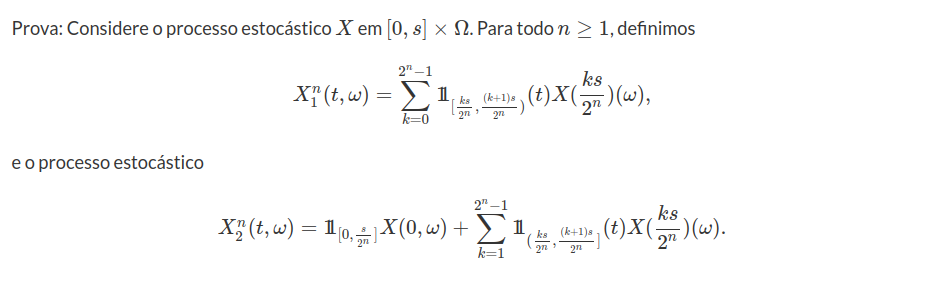

(2) A $ \sigma $-álgebra $ \mathcal{P} $ é gerada pelos processos adaptados e cag e pelas seguintes classes de conjuntos:

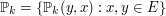

no qual tomamos $ \mathcal{F_{0^-}}=\mathcal{F_{0}} $.

Prova: Como $ \mathcal{P} $ é a $ \sigma $-álgebra gerada pelos processos contínuos concluímos que facilmente que $ \mathcal{P} \subset \mathcal{O} $. Da mesma forma, temos que $ \mathcal{P} \subset \mathcal{P}^\prime $, no qual $ \mathcal{P}^\prime $ corresponde a $ \sigma $-álgebra gerada pelos processos adaptados e cag.

converge de forma pontual para $ X $ sobre $ [0, \infty )\times \Omega $. Com isso, obtemos que $ \mathcal{P}^\prime \subset \sigma(\mathcal{R}) $ e $ \mathcal{P} \subset \sigma(\mathcal{R}) $.

Para provarmos a igualdade entre $ \mathcal{P} $, $ \sigma(\mathcal{R}) $ e $ \mathcal{P}^\prime $ é suficiente mostrarmos $ \sigma(\mathcal{R}) \subset \mathcal{P} $. Para isto, tomamos $ (s,t] \times F \in \mathcal{R} $. Então, existe uma sequência $ (\varphi_n) $ de funções contínuas a valores positivos tal que

Como consequência, obtemos que

$$\sigma(\mathcal{R}_1) \subset \sigma(\mathcal{R}_2)=\sigma(\mathcal{R}_2^\prime)\subset \sigma(\mathcal{R}_1^\prime)=\sigma(\mathcal{R}_1).$$

Obtemos diretamente da definição $ \sigma(\mathcal{R}_1) \subset \sigma(\mathcal{R}) $. Por outro lado, sabemos que

o gráfico do tempo de parada $ T $.

Lema 2.6

Lema 2.7

Lema 2.8

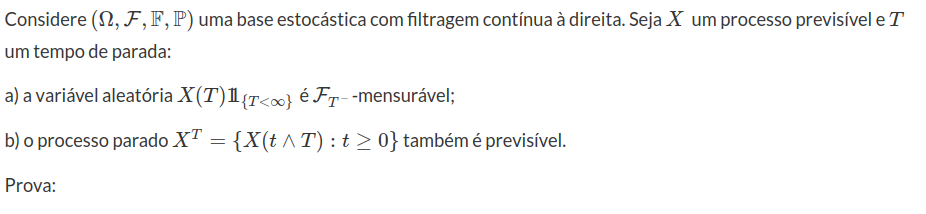

Teorema 2.9

Teorema 2.10

Ao denotarmos por $ \mathcal{T} $ a classe de todos os tempos de parada, obtemos que

A seguir, estabelecemos uma construção da $ \sigma $-álgebraprevisível por intervalos estocástico.

Teorema 2.11

Considere $ (\Omega, \mathcal{F}, \mathbb{F}, \mathbb{P}) $ uma base estocástica. Ao denotarmos por $ \mathcal{T} $ a classe de todos os tempos de parada, obtemos que

$$\mathcal{P}=\sigma ([0, S]: S \in \mathcal{T}) = \sigma(]S,T] ~ ~ \text{e} ~ ~ (0) \times F, ~ F \in \mathcal{F}_0).$$

Segue o teorema.

Dado $ X $ um processo estocástico cadlag, denotamos por $ X^- $ a versão contínua à esquerda de $ X $ definida por $ X^-(t) = \lim_{n \rightarrow \infty} X \left(t-\frac{1}{n} \right)= X(t^-) $. O salto de $ X $ é dado por $ \Delta X(t) = X(t) - X^-(t) $. Então, o processo $ X^{-} $ é previsível. Além disso, se $ X $ for previsível, então $ \Delta X $ também é previsível.

Definição 2.12

Um conjunto estocástico $ B $ é denominado magro se,

$$B = \bigcup_{n=1}^\infty [T_n],$$

no qual $ (T_n : n \geq 1) $ é uma sequência de tempos de parada.

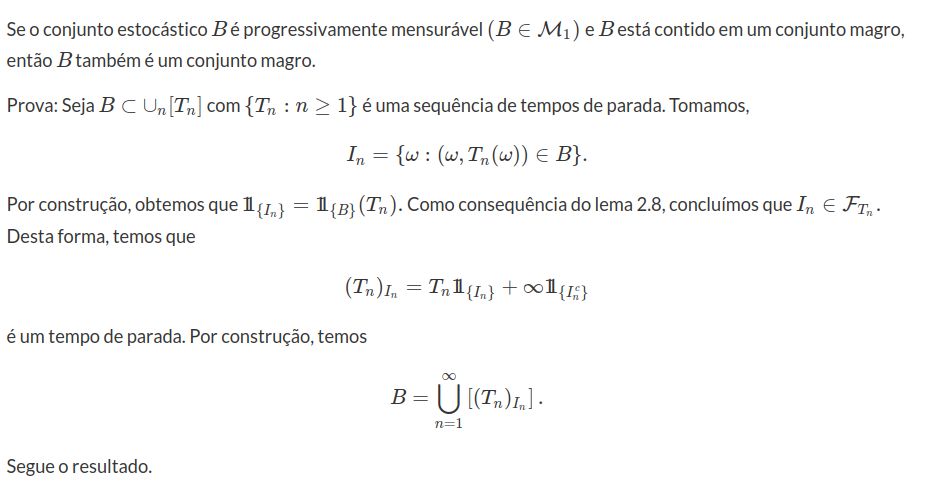

Lema 2.13

Teorema 2.12

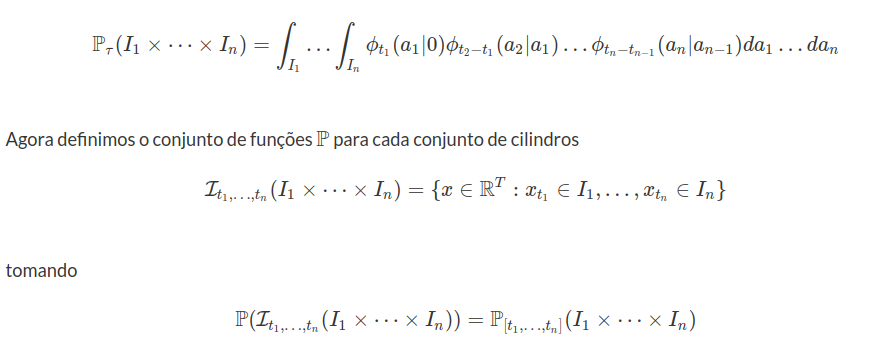

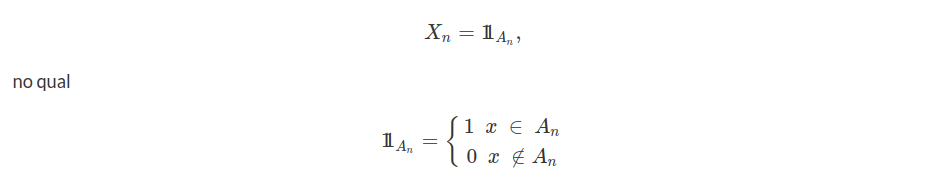

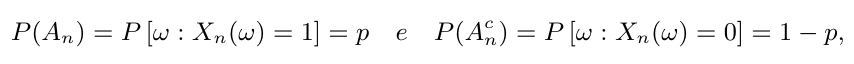

Construção de Processo Estocástico

Dados $ (\Omega ,\mathcal{F},\mathbb{P}) $ um espaço de probabilidade, $ T $ um conjunto de índices qualquer e $ X_t : \Omega \rightarrow \Bbb{R} $ uma variável aleatória para todo $ t \in T $. Sejam $ t_1 , \cdots, t_n $ elementos de $ T $ e $ x_1, \cdots , x_n $ elementos em $ \Bbb{R} $ ou $ + \infty, - \infty $. Definimos a função de distribuição $ n $-dimensional de $ (X_{t_1}, \cdots,X_{t_n}) $, por

$$ F_{t_1, \cdots, t_n} (x_1, \cdots, x_n)=\mathbb{P}\left[ \cap_{i=1}^{n} \left(\omega\in \Omega:X_{t_1}(\omega) \leq x_i \right) \right]. $$

Quando $ n \in \mathbb{N} $ e os pontos $ t_i $’s em $ T $ variam, obtemos uma família de distribuições $ n $-dimensionais $ ( F_{t_1, \cdots t_n}:t_i \in T , n \in \mathbb{N} ) $.

Definição 2.6

Desde que $ (\omega: X_t (\omega)<\infty )=\Omega $ para todo $ t \in T $, temos

$$F_{t_1, \cdots, t_n} (x_1, \cdots, x_{n-1}, \infty) ~ = ~ F_{t_1, \cdots,t_{n-1}} (x_1, \cdots,x_{n-1})$$

e

$$F_{t_{i_1},\cdots,t_{i_n}} (x_{i_1},\cdots,x_{i_n})=F_{t_1,\cdots,t_n} (x_1,\cdots,x_n),$$

no qual $ (i_1,\cdots,i_n) $ é qualquer permutação de $ (1,\cdots,n) $. Estas relações são denominadas condições de compatibilidade de Kolmogorov da família $ (F_{t_1,\cdots t_n}:t_i \in T,n \in \mathbb{N} ) $.

Portanto, qualquer família de variáveis aleatórias $ (X_t:t \in T) $ sobre um espaço de probabilidade determina uma classe compatível de funções de distribuição finito dimensionais. Entretanto, existe um problema básico que é a existência do espaço de probabilidade $ (\Omega, \mathcal{F},\mathbb{P}) $ suportando a família de variáveis aleatórias. Um resultado fundamental de Kolmogorov nos diz que uma família compatível de distribuições finito dimensionais nos produz um espaço de probabilidade e uma coleção de variáveis aleatórias sobre este tal que suas distribuições finito dimensionais são iguais a classe compatível de distribuições. Entretanto, extensões do teorema de Kolmogorov para espaços mais gerais do que a reta $ (X_{t}(\omega)\in \mathbb{R}) $ não necessariamente são válido [Halmos (1950), pg. 150, ex. 3]. Na seção produto de espaços mensuráveis, vamos construir uma $ \sigma $-álgebra no espaço produto. Com isso, na seção probabilidade sobre o espaço produto, construímos uma probabilidade sobre o espaço produto que suporta a coleção de variáveis aleatórias $ (X_t:t\geq 0) $.

2.1 - Produto de espaços mensuráveis

Nesta seção, vamos definir o produto qualquer de espaços mensuráveis e construir uma $ \sigma $- álgebra sobre este espaço produto de tal forma que esta $ \sigma $- álgebra tenha algumas propriedades importantes. O produto de espaços mensuráveis é utilizado em diversas aplicações na teoria de probabilidade, como a construção de processos estocásticos, tais como a cadeia de markov e o movimento browniano.

Considere uma classe arbitrária de conjuntos $ ( \Omega_t : t \in T ) $ com $ \Omega_t \neq \emptyset $ para todo $ t \in T $, no qual $ T $ é um conjunto de índices. O espaço produto pode ser definido como

$$ \prod_{t \in T} \Omega_t \ = \ \left( { conjunto~das~famílias} \ w = (w_t : t \in T ) \ { com } \ w_t \in \Omega_t \right). $$

Para qualquer $ S \subset T $, também denotamos o espaço produto por $ \prod_S \Omega_s $ o espaço produto dos conjuntos $ \left( \Omega_s : s \in T \right) $. Em particular se $ \Omega_t = \Omega \ \forall t \in T $ denotaremos o espaço produto por $ \prod_{t \in T} \Omega_t \ = \Omega^T $ que é denominado o espaço das aplicações $ w : T \to \Omega $.

Exemplo 2.2.1

Considere $ T = (1,2,3) $, com $ \Omega_t = \mathbb{R}, \ \ \forall t \in T $. Então

$$\prod_{t=1}^3 \Omega_t = \prod_{t= 1}^3 \mathbb{R} = \mathbb{R}^3$$

Exemplo 2.2.2

Considere $ T = \mathbb{N} $, com $ \Omega_t = \mathbb{R}, \ \ \forall t \in T $. Então

$$ \prod_{t\in T} \Omega_t = \prod_{t\in\mathbb{N}} \mathbb{R} = \mathbb{R}^{\infty}=(\omega=(\omega_1,\omega_2,\cdots):-\infty< \omega_i<\infty,i=1,2,\cdots), $$

corresponde ao espaço das sequências ordenadas de números reais.

A seguir faremos algumas definições que serão utilizadas na construção da $ \sigma $-álgebra produto.

Definição 2.2.1

Dada um classe arbitrária de conjuntos $ ( \Omega_t : t \in T) $, no qual T é um conjunto de índices qualquer, definimos

a- aplicação coordenada em $ s \in T $ : a transformação $ X_s : \prod_T \Omega_t \to \ \Omega_s $, tal que $ X_s (w) = w_s $ para todo $ w\in \prod_T \Omega_t $. Esta aplicação pode ser interpretada como o estado da trajetória $ w $ no instante s.

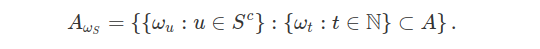

b- seção : Para qualquer subconjunto $ S \subset T $, a seção para $ w_S = ( \omega_s : s \in S ) $ de uma parte $ A \in \prod_T \Omega_t \ \hbox{em} \ \prod_{u \in S^c } \Omega_u $ é definido por:

$$ A_{\omega_S } = ( ( \omega_u : u \in S^c ) :( \omega_t : t \in T ) \in A ) $$

c- cilindro : Uma parte $ A \in \prod_T \Omega_t $ é denominado cilindro de base B em $ \prod_{s \in S } \Omega_s $, com $ S \subset T $, se este for da forma:

$$ A \ = \ B \times \prod_{u \in S^c } \Omega_u $$

Portanto A é um cilindro de base B em $ \prod_{s \in S} \Omega_s $, se e só se, suas seções $ A_{\omega_{S^c}} $ são independentes de $ \omega_{S^c } $, no qual $ A_{\omega_{S^c}} = B $.

d- retângulo : Um retângulo em $ \prod_T \Omega_t $ é um subconjunto da forma:

$$ \prod_T A_t \ = \ ( \omega \in \prod_T \Omega_t : \omega_t \in A_t \ (t \in T ) ) $$

no qual $ A_t = \Omega_t $ exceto um número finito de $ t \in T $.

e- projeção : Para todo $ S \subset T $ e $ A \in \prod_T \Omega_t $, a transformação

$$ \pi_S (A) = ( ( \omega_s :s \in S ) :A_{\omega_S} \neq \emptyset ) $$

é denominado projeção da parte A nas coordenadas de S.

Para fins ilustrativos, vamos exemplificar as definições anteriores.

Exemplo 2.2.3

No caso do espaço das sequências ordenadas de números reais, denotada por $ \mathbb{R}^{\infty} $, a transformação coordenada $ X_n:\mathbb{R}^{\infty}\rightarrow \mathbb{R} $ é tomada na forma $ X_n(\omega)=\omega_n $, no qual $ \omega=(\omega_1,\omega_2,\cdots)\in \mathbb{R}^{\infty} $. Para qualquer subconjunto $ S\subset \mathbb{N} $, a seção para $ \omega_{S}=(\omega_s:s\in S) $ de uma parte $ A\subset \mathbb{R}^{\infty} $ em $ \mathbb{R}^{S^c} $ é dada por

Da mesma forma, dado $ B\subset \mathbb{R}^S $, um cilindro de base $ B $ é dado por $ A=B\times \mathbb{R}^{S^c} $. Por exemplo, se $ S=(1,2,\cdots,n) $, temos que $ B\subset \mathbb{R}^n $ e assim, $ A $ é um cilindro com base no $ \mathbb{R}^n $ na forma

$$A=B\times\mathbb{R}\times \mathbb{R}\times \cdots .$$

Além disso, um retângulo em $ \mathbb{R}^{\infty} $ é um subconjunto na forma

$$ \prod_{t\in \mathbb{N}}A_t=\left(\omega=(\omega_1,\omega_2,\cdots)\in \mathbb{R}^{\infty}:\omega_t\in A_t,t\in T\right), $$

no qual $ A_t=\mathbb{R} $ exceto um número finito de índices $ t \in \mathbb{N} $. Assim, ao tomarmos $ (A_1,A_2,\cdots ,A_n) $ subconjuntos dos números reais, obtemos que $ R=A_1\times A_2\times \cdots \times A_n \times \mathbb{R}\times \mathbb{R}\times \cdots $ é um retângulo de lados $ (A_1,\cdots ,A_n) $.

Para construir a $ \sigma $-álgebra produto, vamos usar as mesmas ideias que são utilizadas para construção da topologia produto. A principal exigência para a construção da topologia produto é que esta deve ser a menor topologia que faz cada aplicação coordenada contínua. Aqui, vamos trocar continuidade por mensurabilidade. Desta forma, queremos definir uma $ \sigma $-álgebra produto nos quais as transformações coordenadas sejam mensuráveis. Para isto, vamos definir a $ \sigma $-álgebra produto através da classe dos retângulos com lados mensuráveis.

Proposição 2.1.1

Considere $ ((\Omega_t , \mathfrak{F}_t ) : t \in T) $ uma família de espaços mensuráveis. Então o conjunto de todos os retângulos mensuráveis de $ \prod_T \Omega_t $, isto é, todos os retângulos $ \prod_T A_t $ tais que $ A_t \in \mathfrak{F}_t $, com $ A_t = \Omega_t $ exceto um número finito de t’s, formam uma semi-álgebra.

Demonstração

Vamos denotar por $ C $ a classe de todos os retângulos mensuráveis. Na sequência, vamos mostrar que a classe $ C $ é uma semi-álgebra. Sabemos que $ \prod_T \Omega_t $ é um retângulo mensurável, para isto basta tomarmos $ \Omega_t = A_t $ para todo $ t\in T $. Da mesma forma, o conjunto $ \emptyset $ é um conjunto um retângulo mensurável, pois basta tomarmos $ A_t \ = \ \emptyset $ para algum $ t \in T $.

Agora, vamos mostrar que a classe $ C $ é fechada por intersecção finita. Com esta finalidade, tomamos os retângulos mensuráveis $ B_1 \ e \ B_2 $, no qual $ B_i $ tem $ n_i $ componentes diferente de $ \Omega_t $, para $ i=1,2 $. Sem perda de generalidade podemos assumir que $ n_1 \leq n_2 $, assim temos que

$$B_1 \cap B_2 = (\prod_T A_t )\cap (\prod_T F_t) = $$

$$ = \left[ (A_{t_1} \times \dots \times A_{t_{n_1}}) \times \prod_{t \neq t_1 , \dots t_{n_1}} \Omega_t \right] \cap \left[ (F_{t_1 } \times \dots \times F_{t_{n_2}} ) \times \prod_{t \neq t_1 , \dots t_{n_2}} \Omega_t \right] = $$

$$ = \left[ (A_{t_1 }\cap F_{t_1 }) \times \dots \times (A_{t_{n_1}}\cap F_{t_{n_1}})\times (\Omega_{t_{n_1+1}}\cap F_{t_{n_1+1}})\times (\Omega_{t_{n_2}}\cap F_{t_{n_2}}))\times \prod_{t \neq t_1 , \dots t_{n_2}} \Omega_t \right] \in C.$$

Com isso concluímos que $ C $ é fechada por intersecção finita. Para finalizar, vamos mostrar que o complementar é união finita disjunta de elementos de $ C $. Para isto, tomamos,

$$A = A_1 \times A_2 \times \prod_{t\neq t_1 , t_2 } \Omega_t.$$

Então, temos que

$$A^c = A^c_{t_1 } \times A_{t_2 } \times \prod_{t\neq t_1 , t_2 } \Omega_t\cup A^{c}_{t_2}\times \prod_{t\neq t_2 } \Omega_t.$$

Assim, segue a proposição.

O ponto principal para a demonstração desta proposição concentra-se na restrição ‘'$ A_t = \Omega_t $ exceto para um número finito de índices t’', na definição de retângulo mensurável.

Assim, construímos uma semi-álgebra via os retângulos mensuráveis. Na sequência, acrescentando a classe dos retângulos mensuráveis uniões finitas (disjuntas 2 a 2) de retângulos mensuráveis obtemos uma álgebra. A álgebra dos retângulos mensuráveis será denotada por $ \mathcal{E} $. A $ \sigma $-álgebra gerada por esta álgebra, denotada por:

$$\beta^T=\bigotimes_T \mathcal{F_t}=\sigma(\mathcal{E})$$

é denominada $ \sigma $-álgebra produto. Para todo $ S \subset T $, vamos denotar por $ \beta^S $ a $ \sigma $-álgebra produto sobre o espaço $ \prod_S \Omega_s $. Por construção $ \beta^S $ é a menor $ \sigma $-álgebra que contém os retângulos mensuráveis. Com isso construímos o espaço mensurável produto

$$\prod_T (\Omega_t , \mathcal{F_t} ) = (\prod_T \Omega_t , \beta^T ).$$

Exemplo 2.2.4

No caso do $ \mathbb{R}^{\infty} $, temos que a $ \sigma $-álgebra gerada pelos retângulos mensuráveis será denotada por $ \beta^{\infty} $. Assim, concluímos que

$$\prod_{\mathbb{N}}(\mathbb{R},\mathcal{F})=(\mathbb{R}^{\infty},\beta^{\infty}),$$

no qual $ \mathcal{F} $ é a $ \sigma $-álgebra de Borel de $ \mathbb{R} $. Dado $ n \in \mathbb{N} $ um número natural, a construção da $ \sigma $-álgebra produto no $ \mathbb{R}^n $ através de retângulos mensuráveis está descrita em Distribuição de Probabilidade no $ \mathbb{R}^n $ e pode ser visto como um caso particular da contrução acima.

A principal característica da $ \sigma $-álgebra produto é que esta foi construída a partir dos retângulos mensuráveis e então, a partir de conjuntos que dependem apenas de um número finito de coordenadas. Na sequência, vamos explorar esta característica para apresentar algumas propriedades interessantes para a $ \sigma $-álgebra produto. Inicialmente, precisamos verificar se nossa forma de construção atende ao propósito básico de que esta é a menor $ \sigma $-álgebra cujas aplicações coordenadas sejam mensuráveis. Considere a aplicação coordenada $ X_s : \prod_T \Omega_t \to \Omega_s $, então

$$ \forall A \in {\cal F_s} \rightarrow X_{s}^{-1}(A) = A \times \prod_{t \neq s} \Omega_t $$

é um retângulo mensurável. Portanto, concluímos que $ \beta^T $ é a menor $ \sigma $-álgebra cujas aplicações coordenadas são mensuráveis. Além disso, a equação acima nos apresenta um fato importante, pois

$$ A \times \prod_{t \neq s} \Omega_t $$

é um cilindro de base $ A \in \mathcal{F_s} $. Com esta observação, podemos elaborar uma outra forma de construção da $ \sigma $-álgebra produto via os cilindros mensuráveis de base com dimensão finita. Esta estratégia foi aplicada na construção do espaço de Cantor $ S^\infty $ com sua respectiva $ \sigma $-álgebra produto $ \mathcal{F} $.

Para isto, introduzimos a seguinte notação,

$$ D ~ = ~ ( S \subset T ~ : ~ S ~ {finito} ) ~ ~ \text{e} ~ ~ C_S ~ = ~ ({família~dos~cilindros~com~base~em} ~ ~ \beta^S)~ ~ ; ~ ~ S\in D. $$

Para todo $ S \subset T $, a projeção coordenada $ X_{S} $ leva elementos de $ \prod_T \Omega_t $ em elementos de $ \prod_{S} \Omega_s $. Agora, se tomarmos $ S \in D $ e $ B \in \beta^S $, obtemos que

$$X_{S}^{-1} (B) ~ = ~ B \times \prod_{t \not \in S} \Omega_t $$

é um cilindro de base $ B \in \beta^S $. Desta forma, temos que $ C_S=(X^{-1}(B):B\in \beta^S) $. Vamos utilizar esta notação para denotarmos os cilindros mensuráveis no espaço produto. Na sequência, vamos mostrar como podemos obter a $ \sigma $-álgebra produto via os cilindros mensuráveis de dimensião finita.

Lema 2.1.1

A classe de subconjuntos $ \prod_T \Omega_t $, definida por

$$\mathcal{A}=\cup_{S\in D}C_S$$

é uma álgebra. Além disso, temos $ \beta^T=\sigma(\mathcal{A}) $.

Demonstração

Vamos mostrar que $ {\cal A} $ é uma álgebra. Sabemos que $ \emptyset, ~ \Omega^T ~ \in ~ {\cal A} $, pois

$$ \emptyset= \emptyset \times \prod_{t \neq t_1} \Omega_t ~ = ~ X_{(t_1)}^{-1}( \emptyset) ~ ~ \text{e} ~ ~ \Omega^T=\Omega_{t_1} \times \prod_{t \neq t_1} \Omega_t ~ = ~ X_{(t_1)}^{-1}(\Omega_{t_1}) ;; ;;; \forall ~ t_1 \in T.$$

Na sequência, tomamos $ A_1, A_2 \in \mathcal{A} $, na forma

$$A_1=X_{S_1}^{-1}(B_1) ~ ~ \text{e} ~ ~ A_2=X_{S_2}^{-1}(B_2)$$

com $ B_i\in \beta^{S_i} $, no qual $ S_i \in D $ para $ i=1,2 $. Assim, obtemos que

$$ A_1 \cap A_2=X_{(S_1 \cup S_2)}^{-1} (B_1 \cap B_2).$$

Agora, para todo $ A=X_{S}^{-1}(B) $, temos que

$$A^c =\left(X_{S}^{-1}(B)\right)^c=X_{S}^{-1}(B^c).$$

Com isso, concluímos que $ \mathcal{A} $ é uma álgebra.

Na sequência, vamos mostrar que $ \sigma(\mathcal{A}) = \beta^T $. Para isto, basta mostrarmos que $ C_{S} \subset \beta^T $ para todo $ S\in D $. Desde que a classe de conjuntos $ \mathcal{G}=(B\in\beta^S:X^{-1}_{S}(B)\in \beta^T) $ é uma $ \sigma $-álgebra e contém os retângulos mensuráveis, concluímos que $ X^{-1}_{S}(B)\in \beta^S $ para todo $ B\in \beta^S $. Portanto, concluímos o lema.

Na sequência, apresentamos mais caracterizações da $ \sigma $-álgebra produto. Denotamos por $ \mathcal{L} $ a classe de todos os subconjuntos finitos ou enumeráveis de índices. Para todo $ S\in \mathcal{L} $, definimos a projeção coordenada $ X_{S}:\prod_T \Omega_t \rightarrow \prod_S \Omega_s $ por $ X_{S}((\omega_t:t\in T))=(\omega_s:s\in S) $. Denotamos por $ \mathcal{H}_{S}=(X^{-1}_{S}(B):B\in \beta^S) $ a classe dos cilindros com base em $ \beta^S $, no qual $ S $ é um subconjunto finito ou enumerável de índices $ (S\in \mathcal{L}) $. Com esta notação, obtemos a seguinte proposição.

Proposição 2.1.2

A classe de de conjuntos $ \mathcal{F}=\cup_{S\in \mathcal{L}}\mathcal{H}_{S} $ é uma $ \sigma $-álgebra que coincide com a $ \sigma $-álgebra produto $ \beta^T $.

Demonstração

Obviamente que o vazio e $ \prod_T \Omega_t $ estão em $ \mathcal{F} $. Seja $ A\in \mathcal{F} $. Então, existe $ S\in \mathcal{L} $ e $ B\in \beta^S $ tal que $ A=X_{S}^{-1}(B) $. Desta forma, temos que $ A^c=[X^{-1}_{S}(B)]^c=X^{-1}_{S}(B^c)\in \mathcal{F} $, pois $ B^c\in \beta^S $. Na sequência, tomamos $ A_1, A_2, \cdots \in \mathcal{F} $. Então, existe $ S_i\in \mathcal{L} $ e $ B_i\in \beta^{S_i} $ tal que $ A_i=X^{-1}_{S}(B_i) $ para todo $ i=1,2,\cdots $. Com isso, obtemos que

$$\cup_{i=1}^{\infty}A_i=\cup_{i=1}^{\infty}X^{-1}_{S_i}(B_i)=X^{-1}_{\cup_i S_i}\left(\cup_{i=1}^{\infty}B_i\right)\in \mathcal{F},$$

pois temos que união enumerável de conjuntos enumeráveis é enumerável e $ \cup_i B_i \in \beta^{\cup_i S_i} $. Portanto, obtemos que $ \mathcal{F} $ é uma $ \sigma $-álgebra.

Na sequência, vamos mostrar que $ \mathcal{F} $ coincide com a $ \sigma $-álgebra produto $ \beta^T $. Desde que $ \beta^T=\sigma(\mathcal{A})\subset \mathcal{F} $, basta mostrarmos que $ X_{S}^{-1}(B)\in \beta^T $, para todo $ B\in \beta^S $ e $ S\in \mathcal{L} $. Para isto, dados $ S_1,S_2\in \mathcal{L} $ subconjuntos de índices tais que $ S_1\subset S_2 $, definimos a projeção coordenada $ X_{S2,S_1}:\prod_{t\in S_2} \Omega_t \rightarrow \prod_{u\in S_1} \Omega_u $ por $ X_{S_2,S_1}((\omega_t:t\in S_2))=(\omega_u :u\in S_1) $. Considere $ S\in \mathcal{L} $ um subconjunto enumerável de índices e $ S^{\prime} \subset S $ um subconjunto finito. Então, para todo $ B\in \beta^{S^{\prime}} $, sabemos que $ X^{-1}_{S,S^{\prime}}(B)\in \beta^{S} $. Além disso, temos que $ X_{S}^{-1}\left(X^{-1}_{S,S^\prime}(B)\right)=X^{-1}_{S^\prime}(B). $ Desde que a classe $ \mathcal{G}=(H\in \beta^S:X^{-1}_{S}(H)\in \beta^{\infty}) $ é uma $ \sigma $-álgebra e contém os cilindros de base finita, concluímos que $ \mathcal{G}=\beta^S $. Portanto, segue o lema.

A seguir, fechamos esta seção apresentando consequências da proposição acima.

Corolário 2.1.1

Se tomarmos o espaço produto $ (\prod_T \Omega_t , \beta^T) $ e $ S \subset T $, obtemos que os espaços mensuráveis $ (\Omega^S, \beta^S) $ e $ (\Omega^{S^c}, \beta^{S^c}) $ tem como produto $ (\prod_T \Omega_t, \beta^T) $ e toda seção

$$ A_{w_S} ~=~ \left( (w_u : u \in S^c ) : ( w_t : t \in T ) \in A \right) $$

com $ A \in \beta^T $ é mensurável em $ (\prod_{S^c} \Omega_u, \beta^{S^c}) $,

Em particular, se $ A $ é um cilindro em $ \prod_T \Omega_t $ com base $ B $ em $ \prod_S \Omega_s $, segue que $ A $ é mensurável em $ \beta^T $ se, e só se, $ B $ é mensurável em $ \beta^S $. Além disso, para toda função $X: \prod_{T} t \rightarrow \Bbb{R}$ mensurável, a seção

$$ X_{ ( w_S )} (w_{S^c}) ~ = ~ X \left[ w_{S} , w_{S^c} \right] $$

é mensurável sobre $ (\prod_{S^c} \Omega_u , \prod_{S^c} \beta_u) $.

Demonstração

Vamos mostrar que $ \beta^S\otimes \beta^{S^c}=\beta^T $. Se tomarmos $ A_1 \in \beta^{S} $ e $ A_2 \in \beta^{S^c} $, segue da proposição acima que, existe $ S_1,S_2 \subset T $ enumeráveis, tal que

$$ A_1 \times A_2 ~ \in ~ \beta^{S_1 \cup S_2} ~ \subset ~ \beta^{T} $$

Então,

$$ \beta^{S} \otimes \beta^{S^c} ~ \subset ~ \beta^T $$

Por outro lado, se tomarmos $ A \in \beta^T $, existe $ S^{\prime} \subset T $ enumerável, tal que $ A \in \beta^{S^{\prime}} $. Assim, definindo

$$ S_1 ~ = ~ S^{\prime} \cap S ~ ~ ~ {e} ~ ~ ~ S_{2}~ = ~ S^{\prime} \cap S^c $$

obtemos da proposição acima, que

$$ A ~ \in ~ \beta^{S_1 \cup S_2} ~ \subset ~ \beta^{S} \otimes \beta^{S^c} $$

Portanto,

$$ \beta^{S} \otimes \beta^{S^c} ~ = ~ \beta^T $$

Na sequência, se denotarmos por

$$ C_{w_S} ~ = ~ \left( A\subset\prod_T\Omega_t:A_{w_S} \in \beta^{S^c} \right) $$

com $ S \subset T $, obtemos que todo retângulo mensurável pertence a $ C_{w_S} $ e que esta classe é fechada por complementação e intersecção enumerável. Portanto,

$$ \beta^T ~ \subset ~ C_{w_S}.$$

Com isso, provamos o corolário.

Através do corolário acima, concluímos que se tomarmos $ ( S_i : i \in I ) $ uma partição de $ T $, então

$$ \prod_{T} ( \Omega_t , F_t ) ~ = ~ \prod_{i \in I} \left( \prod_{S_i} \Omega_s ,\beta^{S_i} \right) $$

Corolário 2.1.2

Todo subconjunto mensurável de $ \Omega^T $ e toda variável aleatória definida sobre $ (\Omega^T, \beta^T) $ depende somente de um número enumerável de coordenadas.

Portanto, através de uma família de espaços mensuráveis, construímos o espaço mensurável produto e estudamos algumas propriedades deste. Na próxima seção, vamos construir uma probabilidade sobre o espaço mensurável produto.

Espaços mensurável $ (\mathbb{R}^n,\beta(\mathbb{R}^n)) $

Na sequência, tomamos o espaço dos $ n $-pares ordenados $ \mathbb{R}^n=\mathbb{R}\times\mathbb{R}\times\cdots\times\mathbb{R} $. A partir dos resultados acima, vamos construir a $ \sigma $-álgebra produto no $ \mathbb{R}^n $ através de retângulos com base nos intervalos finitos.

Definição 2.1.1

O conjunto $ I=I_1\times I_2\times \cdots\times I_n $, com $ I_k=(a_k,b_k] $, definido por

$$ (x\in \mathbb{R}^n : x_k\in I_k, k=1,\dots,n) $$

é denominado de retângulo de lados $ I_i $. O conjunto de todos os retângulos I, será denotado por $ \mathcal{I} $. De forma geral, um conjunto $ A=A_1\times A_2\times \cdots\times A_n $ é chamado de retângulo de lados $ A_i $. Se $ A_i \in \beta(\mathbb{R}) $ dizemos que $ A $ é um retângulo de lados borelianos.

Definição 2.1.2

A $ \sigma $-álgebra de Borel de subconjuntos de $ \mathbb{R}^n $ é denotada por $ \beta(\mathbb{R}^n) $ e é a menor $ \sigma $-álgebra gerada por todos os retângulos de $ \mathbb{R}^n $ ($ \sigma(\mathcal{I}) $). Outra forma de gerarmos a $ \sigma $-álgebra de Borel é

$$\sigma(\beta(\mathbb{R})\times\beta(\mathbb{R})\times\cdots\times \beta(\mathbb{R}))$$

ou seja, é a menor $ \sigma $-álgebra que contém os retângulos com lados Borelianos, é comum essa $ \sigma $-álgebra ser denotada por

$$\beta(\mathbb{R})\otimes\beta(\mathbb{R})\otimes\cdots\otimes \beta(\mathbb{R})$$

Observação

É importante dizer que

$$\beta(\mathbb{R})\times\beta(\mathbb{R})\times\cdots\times \beta(\mathbb{R})\neq \beta(\mathbb{R})\otimes\beta(\mathbb{R})\otimes\cdots\otimes \beta(\mathbb{R})$$

mais do que isso $ \beta(\mathbb{R})\times\beta(\mathbb{R})\times\cdots\times \beta(\mathbb{R}) $ não é uma $ \sigma $-álgebra.

Teorema 2.1.1

$ \sigma(\mathcal{I})=\beta(\mathbb{R}^n)=\beta(\mathbb{R})\otimes\beta(\mathbb{R})\otimes\cdots\otimes \beta(\mathbb{R})=\sigma(\beta(\mathbb{R})\times\beta(\mathbb{R})\times\cdots\times \beta(\mathbb{R})) $

Demonstração

Note que o resultado é trivial se $ n=1 $. Assim sendo considere primeiramente $ n=2 $, e defina

$$ \mathcal{C}=(B_1\times B_2: B_i\in \beta(\mathbb{R}), i=1,2) $$

Note que, é óbvio que $ \mathcal{I}\subset \mathcal{C} $, logo é imediato que

$$\beta(\mathbb{R}^2)=\sigma(\mathcal{I})\subset \sigma(\mathcal{C})=\beta(\mathbb{R})\otimes\beta(\mathbb{R}).$$

Assim, basta mostrarmos que

$$\beta(\mathbb{R})\otimes\beta(\mathbb{R})\subset\beta(\mathbb{R}^2)$$

Para isso, vamos mostrar que dado uma classe $ \mathfrak{C} $ de subconjuntos de $ \mathbb{R} $, e seja $ B\subset\mathbb{R} $, temos que

$$ \mathfrak{C}\cap B=(A\cap B:A\in\mathfrak{{C}}). $$

Claro que, como $ \mathfrak{C}\subset \sigma(\mathfrak{C}) $ então

$$\mathfrak{C}\cap B\subset \sigma(\mathfrak{C})\cap B$$

Como $ \sigma(\mathfrak{C})\cap B $ é uma $ \sigma $-álgebra temos então que

$$\sigma(\mathfrak{C}\cap B)\subset \sigma(\mathfrak{C})\cap B$$

Agora vamos mostrar

$$\sigma(\mathfrak{C})\cap B\subset \sigma(\mathfrak{C}\cap B) $$

Para isso considere $ \mathcal{C}_B=(A\in\sigma(\mathfrak{C}):A\cap B\in \sigma(\mathfrak{C}\cap B)) $, a qual é uma $ \sigma $-álgebra, portanto

$$\mathfrak{C}\subset\mathcal{C}_B\subset \sigma(\mathfrak{C})$$

O que implica que $ \mathcal{C}_B= \sigma(\mathfrak{C}) $ o que implica que

$$A\cap B\in \sigma(\mathfrak{C}\cap B)$$

para todo $ A\in\mathfrak{C} $ e consequentemente $ \sigma(\mathfrak{C})\cap B\subset \sigma(\mathfrak{C}\cap B) $. O que finalmente implica que $ \mathfrak{C}\cap B=(A\cap B:A\in\mathfrak{{C}}) $. Com isso em mente, considere os seguinte conjuntos $ \mathcal{B}\times \mathbb{R}=(B\times \mathbb{R}| B\in\beta(\mathbb{R})) $ e $ \mathbb{R}\times \mathcal{B}=(\mathbb{R}\times B| B\in\beta(\mathbb{R})) $.

Então dado $ B_1\times B_2 $, com $ B_1,B_2\in \beta(\mathbb{R}) $, temos que

$$B_1\times B_2=(B_1\times \mathbb{R})\cap (\mathbb{R}\times B_2) \in \sigma(I_1\times \mathbb{R})\cap (B_2\times \mathbb{R})= \sigma((I_1\times \mathbb{R})\cap (B_2\times \mathbb{R}))\subset\sigma ((I_1\times \mathbb{R})\cap (I_2\cap \mathbb{R}))=\sigma(\mathcal{I})$$

no qual, $ I_i $ é o conjunto de todos os intervalos de $ \mathbb{R} $. Portanto o resultado segue.

Espaço mensurável $ (\mathbb{R}^\infty,\beta(\mathbb{R}^\infty) $

Este espaço mensurável é um dos espaços mais importante na teoria de probabilidade, pois é base para a construção de diversos modelos. Dizemos que $ x\in \mathbb{R}^\infty $ se $ x=(x_1,x_2,\dots) $ com $ -\infty< x_i< \infty, k\in\mathbb{N} $. Denotamos por $ I_k=(a_k,b_k] $ um intervalo e $ B_k $ um boreliano em $ \beta(\mathbb{R}) $. Nesse caso tomamos as seguintes classes de cilindros de base finita

$$ C(I_1\times\dots\times I_n)=(x\in\mathbb{R}^\infty: x=(x_1,x_2,\dots), x_1\in I_1,\dots,x_n\in I_n), $$

$$ C(B_1\times\dots B_n)=(x\in\mathbb{R}^\infty: x=(x_1,x_2,\dots), x_1\in B_1,\dots,x_n\in B_n) $$

$$ C(B^n)=(x\in\mathbb{R}^\infty: x=(x_1,x_2,\dots,x_n)\in B^n) $$

no qual $ B^n $ é um boreliano de $ \beta(\mathbb{R}^n) $. É importante notarmos que cada cilindro na forma $ C(B_1\times\dots B_n) $, ou mesmo $ C(B^n) $, pode ser definido como um cilindro com base em $ \mathbb{R}^{n+k} $, para qualquer $ k\in \mathbb{N} $, pois

$$C(B_1\times\dots B_n)=C(B_1\times\dots B_n\times \underbrace{\mathbb{R}\times\dots\times\mathbb{R}}_{k~ vezes}) ~ ~ \text{e} ~ ~ C(B^n)=C(B^{n+k})$$

no qual $ B^{n+k}=B^n\times \underbrace{\mathbb{R}\times \dots \times \mathbb{R}}_{k~vezes} $.

É fácil vermos que as classes de cilindros na formas $ C(B_1\times\dots B_n) $ e $ C(B^n) $ são álgebras, pois $ \emptyset \in C(B_1\times\dots B_n) $ e $ \emptyset \in C(B^n) $. Além disso, também é fácil observarmos que a união disjuntas destes cilindros também é um cilindro. Denotamos por $ \mathcal{A} $, $ \mathcal{A}_1 $ e $ \mathcal{A}_2 $ a álgebra gerada respectivamente pelas classes de cilindros $ C(I_1\times\dots\times I_n) $, $ C(B_1\times\dots B_n) $ e $ C(B^n $. Sejam $ \beta(\mathbb{R}^\infty) $, $ \beta_1(\mathbb{R}^\infty) $ e $ \beta_2(\mathbb{R}^\infty) $ a menor $ \sigma $-álgebra que contem estas classes de cilindros $ C(I_1\times\dots\times I_n) $, $ C(B_1\times\dots B_n) $ e $ C(B^n) $ respectivamente. Por construção, temos que

$$\beta(\mathbb{R}^\infty)\subset \beta_1(\mathbb{R}^\infty)\subset \beta_2(\mathbb{R}^\infty),$$

pois temos que $ C(I_1\times\dots\times I_n)\subset C(B_1\times\dots B_n)\subset C(B^n) $. Mostraremos que na verdade essas $ \sigma $-álgebras são identicas.

Teorema 2.1.2

$ \beta(\mathbb{R}^\infty)= \beta_1(\mathbb{R}^\infty)= \beta_2(\mathbb{R}^\infty) $

Demonstração

Para mostrar isso, como $ \beta(\mathbb{R}^\infty)\subset \beta_1(\mathbb{R}^\infty)\subset \beta_2(\mathbb{R}^\infty) $, basta mostrarmos que

$$\beta_2(\mathbb{R}^\infty)\subset \beta(\mathbb{R}^\infty)$$

De fato, considere o conjunto

$$ \mathcal{C}_n=(A\subset \mathbb{R}^n: (x\in \mathbb{R}^\infty:(x_1,x_2,\dots,x_n)\in A)\in \beta(\mathbb{R}^\infty)) $$

para $ n\in \mathbb{N} $. Seja $ B^n\in \beta(\mathbb{R}^n) $. Então,

$$B^n\in \mathcal{C}_n\subset \beta(\mathbb{R}^\infty)$$

pois $ (x\in\mathbb{R}^\infty: (x_1,x_2,\dots,x_n)\in B^n)\in \beta(\mathbb{R}^\infty) $. Mas $ \mathcal{C}_n $ também é uma $ \sigma $-álgebra de $ \mathbb{R}^\infty $, e portanto

$$\beta(\mathbb{R}^n)\subset\sigma(\mathcal{C}_n)=\mathcal{C}_n\subset\beta(\mathbb{R}^\infty)$$

Consequentemente pela definição de $ \beta_2(\mathbb{R}^\infty) $, temos que

$$\beta_2(\mathbb{R}^\infty)\subset\mathcal{C}_n\subset\beta(\mathbb{R}^\infty)$$

E portanto o resultado segue.

Daqui por diante descreveremos $ \beta(\mathbb{R}^\infty) $ como os conjuntos de Borel em $ \mathbb{R}^\infty $.

Espaço mensurável $ (\mathbb{R}^T,\beta(\mathbb{R}^T)) $

O espaço $ \mathbb{R}^T $ no qual T é um conjunto arbitrário é uma coleção de funções reais $ (x:T \rightarrow \mathbb{R}) $ com domínio em $ T $ e imagem na reta. Em geral, estamos interessados no caso em que $ T $ é um conjunto não enumerável do conjunto de números reais. Por simplicidade, podemos tomamos $ T=[0,\infty) $. Da mesma forma, consideramos três tipos de cilindros definidos como

$$ C_{t_1,t_2,\dots,t_n}(I_1\times\dots\times I_n)=(x\in\mathbb{R}^T: x_{t_1}\in I_1,\dots,x_{t_n}\in I_n), $$

$$ C_{t_1,t_2,\dots,t_n}(B_1\times\dots B_n)=(x\in\mathbb{R}^T: x_{t_1}\in B_1,\dots,x_{t_n}\in B_n), $$

$$ C_{t_1,t_2,\dots,t_n}(B^n)=(x\in\mathbb{R}^T: x=(x_{t_1},x_{t_2},\dots,x_{t_n})\in B^n) $$

definimos então $ I_k=(a_k,b_k] $ e $ B_k $ um boreliano de $ \beta(\mathbb{R}) $ e $ B^n $ é um boreliano de $ \beta(\mathbb{R}^n) $. Vamos então definir a $ \sigma $-álgebras geradas pelos cilindros $ \beta(\mathbb{R}^T) $, $ \beta_1(\mathbb{R}^T) $ e $ \beta_2(\mathbb{R}^T) $ geradas respectivamente $ C_{t_1,t_2,\dots,t_n}(I_1\times\dots\times I_n) $, $ C_{t_1,t_2,\dots,t_n}(B_1\times\dots B_n) $ e $ C_{t_1,t_2,\dots,t_n}(B^n) $.

É fácil ver que

$$\beta(\mathbb{R}^T)\subset \beta_1(\mathbb{R}^T)\subset \beta_2(\mathbb{R}^T)$$

É importante notar que assim como no caso anterior

$$\beta(\mathbb{R}^T)=\beta_1(\mathbb{R}^T)=\beta_2(\mathbb{R}^T)$$

Teorema 2.1.3

Seja $ T $ qualquer conjunto não enumerável. Então $ \beta(\mathbb{R}^T)=\beta_1(\mathbb{R}^T)=\beta_2(\mathbb{R}^T) $. Além disso, para todo conjunto $ A\in\beta(\mathbb{R}^T) $ existe um conjunto enumerável de índices $ t_1,t_2,\dots $ de $ T $ e um conjunto de Borel $ B\in \beta(\mathbb{R}^\infty) $ tal que

$$ A=(x\in\mathbb{R}^T: (x_{t_1},x_{t_2},\dots)\in B). $$

Demonstração

Desde que a $ \sigma $-álgebra gerada pelos retângulos coincide com a $ \sigma $-álgebra gerad pelos cilindros de base finita, concluímos que

$$\beta_1(\mathbb{R}^T)=\beta_2(\mathbb{R}^T).$$

Além disso, mostramos que a $ \sigma (I^n) $ gerada pelos intervalos do $ \mathbb{R^n} $ coincide com a $ \sigma $-álgebra de Borel do $ \mathbb{R}^n $. Assim, mostramos a igualdade entre as três $ \sigma $-álgebras. A partir da Proposição 2.1.2 obtemos o teorema.

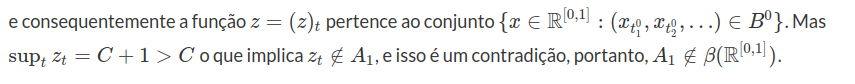

O interessante do teorema anterior é que ele nos mostra que a $ \sigma $-algebra $ \beta(\mathbb{R}^T) $ é determinada por restrições no máximo em um conjunto enumeráveis de pontos imposta sobre as funções $ x=(x_t), ~t\in T $. Daí segue, em particular, que o conjunto

$$ A_1=(x\in\mathbb{R}^{[0,1]}: \sup x_t< C, \forall t\in [0,1]), $$

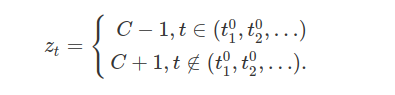

o qual depende do comportamento da função em um conjunto não-enumerável de pontos não pertence a $ \sigma $-álgebra produto $ \mathbb{R}^{[0,1]}) $. Para verificarmos isso, suponha que $ A_1\in \beta(\mathbb{R}^{[0,1]}) $. Então pelo teorema anterior existe $ (t_1^0,t_2^0,\dots) $ and um conjunto $ B^0\in \beta(\mathbb{R}^\infty) $ tal que

$$ \left(x\in\mathbb{R}^T:\sup_t x_t< C,~t\in[0,1]\right)=(x\in\mathbb{R}^{[0,1]}:(x_{t^0_1},x_{t^0_2},\dots)\in B^0). $$

Podemos então notar, que a função $ y_t=C-1 $ pertence a $ A_1 $, e consequentemente $ (y_{t_1^0},y_{t_2}^0,\dots)\in B^0 $. Agora considere a função

Então claro que

$$(y_{t_1^0},y_{t_2}^0,\dots)=(z_{t_1^0},z_{t_2}^0,\dots)$$

Desde que o conjunto $ A_1 $ são não-mensurável com respeito a $ \sigma $-álgebra $ \beta(\mathbb{R}^{[0,1]}) $ é o espaço de todas as funções $ x=(x_t) $ $ t\in [0,1] $ é natural que se considere como sendo a menor classe de funções para as quais esses conjuntos são mensuráveis.

Espaço mensurável $ (C(T),\beta(C(T))) $

Seja $ T=[0,1] $ e seja $ C(T) $ o espaço das funções continua $ x=(x_t) $ $ 0\leq t\leq 1 $. Esse espaço é um espaço métrico com a métrica

$$\rho(x,y)=\sup_{t\in T}|x_t-y_t|.$$

Iremos considerar duas $ \sigma $-álgebras em $ C(T) $, $ \beta(C(T)) $, gerada pelos cilindros

$$ C_{t_1,t_2,\dots,t_n}(b_1\times\dots\times b_n)=(x\in C(T):x_{t_1}< b_1,\dots,x_{t_n}< b_n), $$

a qual chamaremos $ \beta(C(T)) $ e a $ \sigma $-algebra gerada pelos abertos com respeito as métricas $ \rho(x,y) $ a qual chamaremos $ \beta_0(C(T)) $.

Vamos mostrar que ambas são idênticas, assim seja $ B=(x:x_{t_0}< b) $ claro que $ B $ é um cilindro, e ainda é aberto, disto segue

$$ (x:x_{t_1}< b_1,\dots , x_{t_n}< b_n )\in \beta_0(C(T)) $$

o que implica $ \beta(C(T))\subset \beta_0(C(T)) $.

Inversamente considere o conjunto $ B_\rho=(y\in C(T):y\in S_{\rho}(x^0)) $, no qual $ x^0 $ é um elemento de $ C(T) $ e

$$ S_{\rho}(x^0)=(x\in C:\sup_{t\in T}|x_t-x^0_t|< \rho) $$

é uma bola aberta com centro em $ x^0 $. Desde que as funções em $ C $ e são continuas,

$$ B_{\rho}=(y\in C(T): y\in S_{\rho}(x^0))=\left(y\in C(T):\max_t |y_t-x_t^0|< \rho\right)=\bigcap_{t_k}\left(y\in C(T): |y_{t_k}-x_{t_k}^0|< \rho\right)\in \beta(C(T)). $$

no qual $ t_k $ são pontos racionais de $ [0,1] $. Portanto $ \beta_0(C(T))\subset \beta(C(T)) $, o que implica $ \beta_0(C(T))=\beta(C(T)) $.

Espaço mensurável $ (D(T),\beta(D(T))) $

$ D(T) $ é o espaço das funções $ x=(x_t)_{t\in T} $ continuas as direita, com $ T=[0,1] $

Da mesma forma, como acontece com o espaço das funções contínuas, podemos introduzir uma métrica

$$ d(x,y)=\inf \left(\epsilon > 0: \exists \lambda \in \Lambda : \sup_t |x_t-y_{\lambda(t)}|\leq \epsilon \right) $$

onde $ \Lambda $ é um conjunto de funções $ \lambda =\lambda(t) $ estritamente crescente, o qual é continua de $ [0,1] $ e temos $ \lambda(0)=0 $, $ \lambda(1)=1 $.

Essa métrica foi introduzida por Skorohod e é uma métrica muito importante para esse espaço. E da mesma forma que o espaço das funções contínuas a $ \sigma $-algebra gerada pelos abertos da topologia de Skorohod é igual a $ \sigma $-algebra gerada pelos cilindros de $ D(T) $.

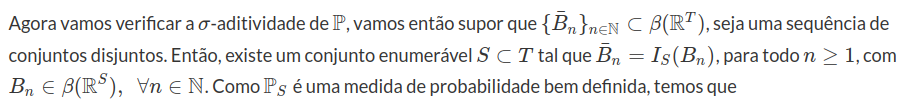

2.2 - Probabilidade sobre o espaço produto

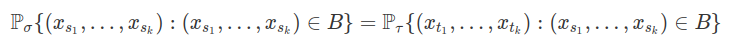

Nesta seção vamos construir uma probabilidade sobre o espaço produto de espaços mensuráveis. Considere que o espaço de probabilidade $ (\Omega_t , \mathcal{F_t}, \mathbb{P}_t) $ seja compacto para todo $ t \in T $, no qual $ T $ é uma família de índices. Denotamos por $ D=( u: u \subset T, ~ u ~\text{subconjunto finito}) $ a classe de todos os subconjuntos finitos de $ T $. Suponha que a família de probabilidades $ (\mathbb{P_u}: u \in D) $ satisfaça as condições de compatibilidade de Kolmogorov, então, vamos mostrar que existe uma única probabilidade sobre o espaço produto que estende a família de probabilidades $ (\mathbb{P_u}: u \in D) $. Como toda probabilidade no $ (\mathbb{R}^n , \beta(\mathbb{R}^n)) $ é compacta, Kolmogorov mostrou que existe uma probabilidade $ \mathbb{P} $ sobre $ (\mathbb{R}^T ,\beta^T) $ se ,e só se, a família de probabilidades $ (\mathbb{P_u}: u \in D) $ satisfaz a condição de compatibilidade.

As condições de compatibilidade de Kolmogorov podem ser expressas numa forma mais sistemática usando a seguinte abstração devido a Bochner (1955). Para ilustração, seja $ \Omega_t=\mathbb{R} $, $ T\subset [0,\infty) $ e $ \beta^u $ a $ \sigma $-álgebra de Borel do $ \mathbb{R}^u $, com $ u=(t_1, \cdots, t_n) \subset T $. Denotamos por $ \mathbb{P_{u}} $ a probabilidade de Lebesgue-Stieltjes determinada pela função de distribuição $ F_{t_1, \cdots, t_n} $, na forma

$$\mathbb{P_{u}} (A) ~ = ~ \int_{A} \cdots \int d F_{t_1, \cdots, t_n} (dx_1, \cdots, x_n) ~ ~ ; ~ ~ A \in \beta^u.$$

Então a família de distribuições $ ( F_{t_1, \cdots, t_n} : t_i \in T, i \in \mathbb{N} ) $ é equivalente ao conjunto $ (P_{u}: u \in D ) $ de probabilidades, no qual $ D $ é o conjunto de todos os subconjuntos finitos de $ T $. Portanto, vamos traduzir as condições de compatibilidade de Kolmogorov para a família de probabilidades $ (\mathbb{P_{u}}:u\in D) $.

Se $ u $ e $ v $ é um par de elementos de $ D $, denotamos por $ u < v $ a relação $ u \subset v $. Neste caso, dizemos que$ D $ é um conjunto dirigido, isto é, $ (D, < ) $ é um conjunto parcialmente ordenado e para quaisquer dois elementos de $ D $ existe um terceiro (a união) que contém ambos. Se $ u < v $ denotamos por $ \pi_{uv} $ a projeção coordenada do $ \mathbb{R}^v $ em $ \mathbb{R}^u $. Portanto, as condições de compatibilidade tomam a forma

$$ \mathbb{P_{u}} ~ = ~ \mathbb{P}_{v} \circ \pi^{-1}_{uv} \qquad \qquad (1). $$

Considere uma família de espaços mensuráveis $ ((\Omega_t, \mathcal{F_t} ) : t \in T ) $ e $ D $ o conjunto dirigido formado por todos os subconjuntos finito de $ T $. Para facilitar a notação, tomamos

$$ \Omega^u ~ = ~ \prod_{t \in u} \Omega_t ~ ~ ; ~ ~ \beta^u ~ = ~ \otimes_{t \in u} \mathcal{F_t} $$

e $ \mathbb{P_u} : \beta^u \rightarrow [0,1] $ uma probabilidade para cada $ u \in D $. A família $ ( \mathbb{P_u} : u \in D ) $ é denominada compatível se (1) é válido para todo par $ u \ < \ v $ (em $ D $). Então, dado a família $ ( (\Omega^u , \beta^u , \mathbb{P_u} , \pi_{uv}) : u < v \in D ) $, procuramos por uma probabilidade $ \mathbb{P} $ sobre o espaço produto $ (\Omega^T , \beta^T) $ tal que sua $ u $-marginal seja $ \mathbb{P_u} $ para todo $ u \in D $.

A família $ ( (\Omega^u , \beta^u , \mathbb{P_u} , \pi_{uv}) : u < v \in D ) $ é denominada sistema projetivo de espaços de probabilidade se a classe $ ( \mathbb{P}_u : u \in D ) $ é compatível. Dizemos que o sistema projetivo admite um limite projetivo se existe uma probabilidade $ \mathbb{P} $ sobre $ (\Omega^T , \beta^T) $, tal que

$$ \mathbb{P_{u}} ~ = ~ \mathbb{P} \circ \pi^{-1}_{u} ,$$

para todo $ u \in D $

Na sequência, vamos demonstrar o teorema de Kolmogorov-Bochner em etapas. Para isto, vamos utilizar a notação e resultados da seção anterior, sobre a construção de espaços produto. Mais uma vez, dado uma família de espaços mensuráveis $ ((\Omega_t , \mathcal{F_t} : t \in T ) $, construímos o espaço mensurável produto

$$ \prod_{T} ( \Omega_t , \mathcal{F_t}) ~ = ~ ( \Omega^T , \beta^T) $$

no qual

$$\Omega^T ~ = ~ \prod_{T} \Omega_t ~ ~ ; ~ ~ \beta^T ~ = ~ \sigma \left[ \cup_{u \in D} C_u \right] $$

e

$$C_u ~ = ~ \left( A \subset \Omega^T : A = \pi^{-1}_u (B), ~ B \in \beta^u \right)$$

corresponde a classe dos cilindros com base em $ \beta^u $. Vamos denotar por

$$ \mathcal{A} ~ = ~ \cup_{u \in D} C_u,$$

a álgebra formada pelos cilindros de base finita.

Proposição 2.2.1

Dado uma família de espaços mensuráveis $ ((\Omega_t , \mathcal{F_t} : t \in T ) $ e uma família de probabilidades $ (\mathbb{P_u} : u \in D ) $, existe uma função de conjunto $ \mathbb{P} $ sobre a álgebra $ \mathcal{A} $ satisfazendo

$$\mathbb{P_u} ~ = ~ \mathbb{P} \circ \pi^{-1}_u ~ ~ ; ~ ~ u \in D \qquad \qquad (2)$$

se, e só se, a família $ (\mathbb{P_u} : u \in D ) $ é compatível.

Demonstração

As projeções coordenadas satisfazem a regra de composição

$$\pi_{uv} \circ \pi_{v \gamma} ~ = ~ \pi_{u \gamma} $$

para todo $ u \ < v \ < \ \gamma $ com $ \pi_{uu} $ a função identidade. Suponha que existe uma função de conjunto $ \mathbb{P} $ sobre $ \mathcal{A} $ tal que

$$\mathbb{P_u} ~ = ~ \mathbb{P} \circ \pi^{-1}_u ~ ~ ; ~ ~ u \in D .$$

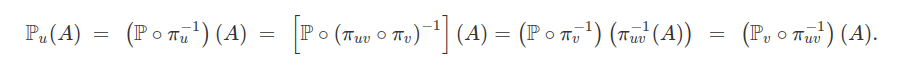

Então, para todo $ A \in \beta^u $ e $ u \ < \ v $ em $ D $, temos que $ \pi_{u} = \pi_{uv} \circ \pi_v $ e

Assim, temos que

$$\mathbb{P_u} ~ = ~ \mathbb{P_v} \circ \pi^{-1}_{uv} $$

e a família $ (\mathbb{P_u} : u \in D ) $ é compatível.

Por outro lado, se a família $ (\mathbb{P_u} : u \in D ) $ é compatível, podemos construir uma função de conjunto $ \mathbb{P} $ sobre a ágebra $ \mathcal{A} $ satisfazendo (2). Para todo elemento $ A \in \mathcal{A} $, existe $ u \in D $ e $ B \in \beta^u $ tal que $ A ~ = ~ \pi^{-1}_u (B) $. Assim, definimos

$$\mathbb{P}(A) ~ = ~ \mathbb{P_u} (B) ~ ~ ; ~ ~ u \in D.$$

Na sequência, vamos mostrar que a função de conjunto $ \mathbb{P} $ está bem definida. Suponha que $ A \in \mathcal{A} $ tenha duas representações, isto é, existe $ u,v \in D $, $ B_1 \in \beta^u $ e $ B_2 \in \beta^v $, tal que

$$A ~ = ~ \pi_{u}^{-1} (B_1) ~ = ~ \pi_{v}^{-1} (B_2).$$

Como $ D $ é um conjunto dirigido, existe $ \gamma \in D $ tal que $ u \ < \ \gamma $ e $ v \ < \ \gamma $. Desde que, $ \pi_u = \pi_{u \gamma} \circ \pi_{\gamma} $ e $ \pi_v = \pi_{v \gamma} \circ \pi_{\gamma} $, temos

$$\pi_{\gamma}^{-1} \circ \pi_{u \gamma}^{-1}(B_1) ~ = ~ \pi^{-1}_u (B_1) ~ = ~ A ~ = ~ \pi^{-1}_v (B_2)~ = ~ \pi_{\gamma}^{-1} \circ \pi^{-1}_{v \gamma}(B_2) \qquad \qquad (3).$$

Além disso, como $ \pi_{\gamma} ( \Omega^T) = \Omega^{\gamma} $, a relação (3) no diz que

$$\pi_{u \gamma}^{-1}(B_1) ~ = ~ \pi^{-1}_{v \gamma}(B_2).$$

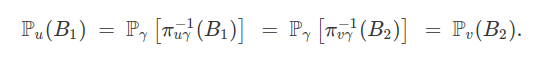

Então, utilizando a compatibilidade da família $ (\mathbb{P_u} : u \in D ) $, obtemos

Portanto, a função de conjunto $ \mathbb{P} $ definida sobre $ \mathcal{A} $ está bem definida. Com isso, concluímos a proposição.

Através desta proposição, definimos uma função de conjunto $ \mathbb{P} $ sobre a álgebra $ A $, na forma

$$\mathbb{P}(A) ~ = ~ \mathbb{P_u} (B) \quad (4)$$

no qual $ A= \pi^{-1}_u (B) $ para algum $ u \in D $ e $ B \in \beta^u $. Na sequência, vamos mostrar que esta função de conjunto satisfaz algumas propriedades interessantes.

Lema 2.2.1

A função de conjunto $ \mathbb{P} $ é não negativa, finitamente aditiva sobre a álgebra $ \mathcal{A} $ e $ \mathbb{P}(\Omega^T) = 1 $.

Demonstração

Desde que $ \mathbb{P_u} $ é não negativa $ (u \in D) $, obtemos que $ \mathbb{P} $ é não negativa. Se tomarmos $ A $ e $ B $ em $ \mathcal{A} $ disjuntos, existem $ u,v \in D $, $ A_1 \in \beta^u $ e $ B_1 \in \beta^v $, tais que

$$A ~ = ~ \pi_u^{-1} (A_1) ~ ~ ; ~ ~ B ~ = ~ \pi_{v}^{-1} (B_1).$$

Como $ D $ é um conjunto dirigido, existe $ \gamma \in D $ tal que $ u \ < \ \gamma $ e $ v \ < \ \gamma $,com

$$A ~ = ~ \pi_{\gamma}^{-1} \left[ \pi^{-1}_{u \gamma} (A_1) \right] ~ ~ ; ~ ~ B ~ = ~ \pi_{\gamma}^{-1} \left[ \pi^{-1}_{v \gamma} (A_2) \right].$$

Ao denotarmos por

$$A_{\gamma} ~ = ~ \pi_{u \gamma}^{-1}(A_1) ~ ~ ; ~ ~ B_{\gamma} ~ = ~ \pi^{-1}_{v \gamma} (A_2),$$

obtemos que $ A_{\gamma} $ e $ B_{\gamma} $ são elementos de $ \beta^{\gamma} $ e disjuntos, pois $ A $ e $ B $ são disjuntos. Com isso, temos que

Ao utilizarmos a equação (3), temos

$$\mathbb{P} \left( \Omega^T \right) ~ = ~ \mathbb{P_{u}} \left( \Omega^{u} \right) ~ = ~ 1 ~ ~ ; ~ ~ u \in D.$$

Com estes resultados preliminares, podemos apresentar e demonstrar uma versão do teorema de Kolmogorov-Bochner, que não utiliza hipóteses topológicas. Nossa construção está baseada no conceito de probabilidade compacta, que nos garante que a probabilidade de um conjunto da $ \sigma $-álgebra pode ser aproximado pela probabilidade de um subconjunto que pertence a uma classe compacta.

Teorema 2.2.1

Considere $ ((\Omega_t , \mathcal{F_t} : t \in T ) $ uma família de espaços mensuráveis e uma família compatível $ (\mathbb{P_u} : u \in D ) $ de probabilidades . Se, para todo $ t \in T $, a probabilidade $ \mathbb{P_t} $ é compacta. Então, o sistema projetivo $ ( (\Omega^u , \beta^u , \mathbb{P_u} , \pi_{uv} ) : u < v \in D ) $ tem um único limite projetivo.

Demonstração

Esta demonstração será baseada nos resultados de probabilidades compactas. Vamos mostrar que a função de conjunto $ \mathbb{P} $ (definida na equação (4)) é compacta com respeito a uma semi-álgebra formada por retângulos mensuráveis. Desta forma, podemos aplicar o teorema de exntensão de probabilidades compactas para mostrarmos a existência de um único limite projetivo.

Por hipótese, o espaço de probabilidade $ (\Omega_t , \mathcal{F_t} , \mathbb{P}_t) $ é compacto para todo $ t \in T $. Assim, sabemos que existe uma classe compacta $ \mathcal{C}_t $ composta de subconjuntos de $ \Omega_t $ tal que

$$ \mathbb{P}_t(A) = \sup ( P(C) : ~ C \subset A, ~ C \in \mathcal{C}_t). $$

Considere $ Y $ a classe de retângulos mensuráveis, na forma

$$C_t \times \prod_{s \neq t} \Omega_s $$

no qual $ C_t $ percorre a classe compacta $ \mathcal{C_t} $ e $ t $ percorre o conjunto de índices $ T $. Vamos mostrar que $ Y $ é uma classe compacta. Dado uma sequência $ (E_n)_{n \geq 1} \subset Y $, a intersecção

$$\bigcap_{n=1}^{\infty} E_{n} ~ = ~ \bigcap _{n=1}^{\infty} \left[ C_{t_n} \times \prod_{s \neq t_n} \Omega_s \right]$$

para $ C_{t_n} \in \mathcal{C}_{t_n} $ e $ t_n \in T $ com $ n \in \Bbb{N} $. Com isso, se tomarmos

$$ A_{t_k} ~ = ~ \bigcap_{ (n : t_n = t_k )} C_{t_n} $$

para $ k=1,2, \cdots $ , temos

$$\bigcap_{n=1}^{\infty} E_n ~ = ~ \bigcap _{k=1}^{\infty} \left[ A_{t_k} \times \prod_{s \neq t_k} \Omega_s \right] $$

Se $ \cap E_n = \emptyset $, existe pelo menos um $ A_{t_k} $ vazio, por exemplo $ A_{t_i} $. Como $ \mathcal{C}_{t_i} $ é uma classe compacta, existe um subconjunto finito $ J \subset (n : t_n = t_i ) $, tal que

$$ \bigcap_{J} C_{t_n} ~ = ~ \emptyset $$

o que implica em

$$\bigcap_{J} E_n ~ = ~ \emptyset $$

Com isso, a classe $ Y $ formada pelos retângulos mensuráveis é compacta. Além disso, a classe $ \mathcal{C} $ obtida via intersecções enumeráveis de elementos de $ Y $ também é compacta. Agora, considere $ A $ um retângulo mensurável, com base

$$\prod_{i=1}^{n} A_{t_i} $$

tal que $ A_{t_i} \in \mathcal{F}_{t_i} $. Para todo $ \varepsilon > 0 $, tomamos $ C_i \in C_{t_i} $ tal que

$$C_i \subset A_{t_i} ~ ~ {e} ~ ~ \mathbb{P}_{t_i}(A_{t_i}) ~ \leq ~ \mathbb{P}_{t_i}(C_i) ~ + ~ \frac{\varepsilon}{n} .$$

Agora, o conjunto

$$C ~ = ~ \bigcap_{i=1}^{n} \left[ C_i \times \prod_{t \neq t_i} \Omega_t \right] ~ \in ~ \mathcal{C} $$

e está contido em $ A $, a álgebra gerada pelos retângulos mensuráveis. Além disso,

$$A - C ~ \subset ~ \bigcup_{i=1}^{n} \left( (A_{t_i} - C_i) \times \prod_{s \neq t_i} \Omega_s \right) .$$

Assim, utilizando a aditividade finita de $ \mathbb{P} $, temos

$$\mathbb{P}(A) ~ - ~ \mathbb{P}(C) ~ \leq ~ \sum_{i=1}^n ~ \left( \mathbb{P}_{t_i}(A_{t_i}) - \mathbb{P}_{t_i} (C_i) \right) ~ \leq ~ \epsilon $$

Portanto, fazendo $ \epsilon \rightarrow 0 $, obtemos que

$$ \mathbb{P}(A) ~ = ~ \sup \left( \mathbb{P}(C) : C \subset A , A \in C \right) $$

para todo retângulo mensurável. Assim através do teorema da classe compacta, existe uma única probabilidade $ \mathbb{P} $ definida sobre o espaço das funções $ (\Omega^T, \beta^T) $ que estende a família compatível de probabilidades $ (\mathbb{P_u}: u \in D) $.

A partir do teorema de extensão de Komogorov-Bochner, mostrarmos a existência de uma única probabilidade $ \mathbb{P} $ sobre o espaço produto $ (\Omega^T, \beta^T) $ satisfazendo:

a) $ \mathbb{P} (A) = \mathbb{P_u} (B) $, no qual $ A=\pi^{-1}_u (B) $, com $ B \in \beta^u $ para algum $ u \in D $.

b) $ \mathbb{P}(A) = \sup ( \mathbb{P} (C) : C \subset \mathcal{C}) $, para todo $ A \in \beta^T $.

A seguir, apresentamos algumas aplicações do teorema de Kolmogorov-Bochner.

Distribuicao $ (\mathbb{R}^\infty,\beta(\mathbb{R}^\infty)) $

A construção da medida de probabilidade desse espaço é similar a do espaço $ \mathbb{R}^n $ na qual pode ser encontrada na seção de probabilidade, considere os retângulos de $ \mathbb{R}^\infty $ definidos como

$$ I_n(B)=(x\in\mathbb{R}^\infty:(x_1,x_2,\dots,x_n)\in B), ~B\in\beta(\mathbb{R}^n) $$

Seja $ \mathbb{P} $ uma medida de probabilidade em $ (\mathbb{R}^\infty,\beta(\mathbb{R}^\infty)) $. Para $ n=1,2,\dots $, temos

$$\mathbb{P}_n(B)=\mathbb{P}(I_n(B)),~ B\in\beta(\mathbb{R}^n)$$

A sequência de medida de probabilidade $ \mathbb{P}_1,\mathbb{P}_2,\dots,\mathbb{P}_n $, definida respectivamente em $ ((\mathbb{R},\beta(\mathbb{R})), (\mathbb{R}^2,\beta(\mathbb{R}^2)),\dots,(\mathbb{R}^n,\beta(\mathbb{R}^n))) $, temos então a seguinte propriedade

$$\mathbb{P}_{n+1}(B\times \mathbb{R})=\mathbb{P}_n(B)$$

para $ n=1,2,\dots $

Teorema 2.2.2

Seja $ \mathbb{P}_1,\mathbb{P}_2,\dots $ uma sequência de medidas de probabilidade em $ ((\mathbb{R},\beta(\mathbb{R})), (\mathbb{R}^2,\beta(\mathbb{R}^2)),\dots) $ tal que

$$\mathbb{P}_{n+1}(B\times \mathbb{R})=\mathbb{P}_n(B)$$

Então existe uma única medida de probabilidade $ \mathbb{P} $ em $ (\mathbb{R}^\infty, \beta(\mathbb{R}^\infty)) $, tal que

$$\mathbb{P}(I_n(B))=\mathbb{P}(B), ~B\in\beta(\mathbb{R}^n)$$

para $ n=1,2,\dots $

Demonstração

Seja $ B^n\in \beta(\mathbb{R}^n) $ e seja $ I_n(B^n) $ um cilindro com base $ B^n $. Atribuímos a medida $ \mathbb{P}(I_n(B^n)) $ para o cilindro tomando

$$\mathbb{P}(I_n(B^n))=\mathbb{P}_n(B^n)$$

Vamos mostrar que em virtude da condição de consistência, essa definição é consistente, isto é, o valor de $ \mathbb{P}(I_n(B^n)) $ é independente da representação do conjunto $ I_n(B^n) $. De fato, considere o mesmo cilindro representado de duas formas

$$I_n(B^n)=I_{n+k}(B^{n+k})$$

Disto segue que se $ (x_1,\dots,x_{n+k})\in\mathbb{R}^{n+k} $, temos que

$$(x_1,\dots,x_n)\in B^n\Leftrightarrow (x_1,\dots,x_{n+k})\in B^{n+k},$$

Com isso, temos que

$$ \mathbb{P_n}(B^n)=\mathbb{P_{n+1}}\left((x_1,\dots,x_{n+1}):(x_1,\dots,x_n)\in B^{n}\right) $$

$$ =\mathbb{P_{n+1}}\left((x_1,\dots,x_{n+2}):(x_1,\dots,x_{n+1})\in B^{n}\right) $$

$$=\dots=\mathbb{P}_{n+k}(B^{n+k})$$

Seja $ \mathcal{A}(\mathbb{R}^\infty) $ denota a coleção de todos os cilindros $ \bar{B}^n=I_n(B^n) $, $ B^n\in \mathbb{R}^n $, $ n=1,2,\dots $ .

Agora seja $ \bar{B}_1,\dots,\bar{B}_k $ conjuntos disjuntos em $ \mathcal{A}(\mathbb{R}^\infty) $. Podemos assumir sem perda de generalidade que $ \bar{B}_i=I_n(B_i^n), ~i=1,\dots,k $ para algum $ n $, no qual $ B^n_1,\dots,B^n_k $ são conjuntos disjuntos em $ \beta(\mathbb{R}^n) $. Então,

$$\mathbb{P}\left(\sum_{i=1}^k \bar{B}_i\right)=\mathbb{P}\left(\sum_{i=1}^k I_n{B}^n_i\right)=\mathbb{P}_n\left(\sum_{i=1}^k B^n_i\right)= \sum_{i=1}^k\mathbb{P}_n\left( B^n_i\right)=\sum_{i=1}^k\mathbb{P}\left( \bar{B}_i\right)$$

Isto implica que a função $ \mathbb{P} $ é finitamente aditiva na algebra $ \mathcal{A}(\mathbb{R}^\infty) $. Agora precisamos mostrar $ \mathbb{P} $ é continua em zero, isto é, se a sequência de conjuntos $ \bar{B}_n\downarrow \emptyset $, $ n\rightarrow \infty $, então $ \mathbb{P}(\bar{B}_n)\rightarrow 0 $ quando $ n\rightarrow \infty $. Para isso, suponha o contrario, isto é,

$$\lim_{n\rightarrow \infty}\mathbb{P}(\bar{B}_n)=\delta> 0.$$

Suponha sem perda de generalidade que $ (\bar{B}_n) $ tem a forma

$$ \bar{B}_n=(x\in\mathbb{R}^\infty:(x_1,\dots,x_n)\in B_n)~ B_n\in \beta(\mathbb{R}^n) $$

Para demonstrar isso vamos precisar de uma propriedade da medida de probabilidade $ \mathbb{P}_n $ no espaço $ (\mathbb{R}^n,\beta(\mathbb{R}^n)) $. Se $ B_n\in \beta(\mathbb{R}^n) $, para $ \delta> 0 $ dado podemos encontrar um compacto $ A_n\beta(\mathbb{R}^n) $ dado $ A_n\subset B_n $ e

$$\mathbb{P}_n(Bn-A_n)\leq \frac{\delta}{2^{n+1}}$$

Portanto se

$$ \bar{A}_n=(x\in \mathbb{R}^\infty:(x_1,x_2,\dots,x_n)\in A_n), $$

temos que

$$\mathbb{P}(\bar{B}_n-\bar{A}_n)=\mathbb{P}_n(B_n-A_n)\leq \frac{\delta}{2^{n+1}}$$

Seja $ \displaystyle \bar{C_n}=\bigcap_{k=1}^n \bar{A_k} $ e seja $ C_n $ tal que

$$ \bar{C}_n=(x\in \mathbb{R}^\infty:(x_1,x_2,\dots,x_n)\in C_n) $$

Então, desde que o conjuntos $ \bar{B}_n $ é decrescente, obtemos