Parte 2

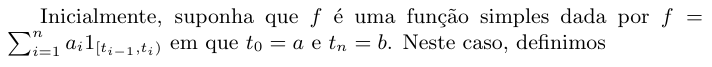

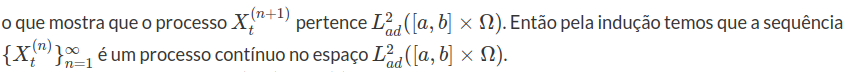

7 - Processo de Poisson

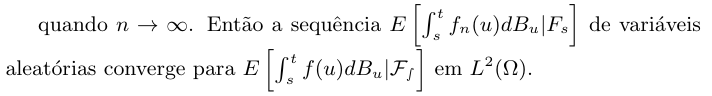

O processo de Poisson é o processo estocástico a tempo contínuo com a estrutura mais simples. Este processo conta o número de eventos de interesse em um intervalo da reta. Por exemplo, o número de falhas de um sistema durante um intervalo de tempo. Nesta seção, vamos construir o processo de Poisson e estudar suas principais propriedades.

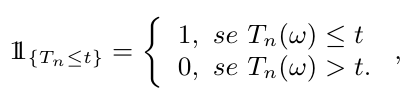

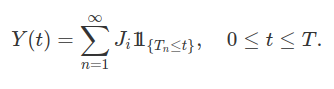

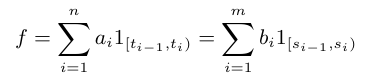

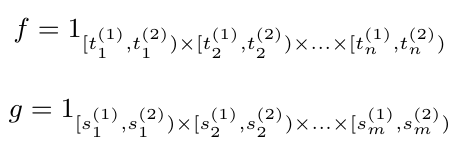

Seja $ (T_n)_{n> 0} $ uma sequência de variáveis aleatórias positivas estritamente crescente $ (T_0=0 \ < \ T_1 \ < \ T_2 \cdots) $ definidas na base estocástica $ \mathfrak{B}=(\Omega,\mathcal{F},\mathbb{F},\mathbb{P}) $. As variáveis aleatórias $ (T_n) $ representam os instantes de tempo nos quais o evento de interesse ocorre. Para contar o número de eventos ocorridos até o tempo $ t \geq 0 $, introduzimos a função indicadora

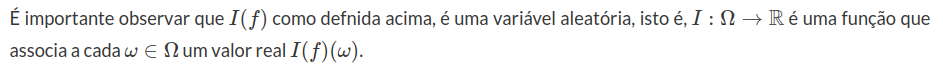

para $ n \geq 1 $. A partir destes elementos, vamos introduzir o processo de contagem dos eventos de interesse.

Definição 7.1

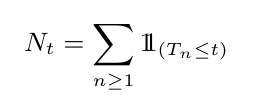

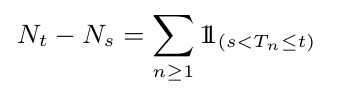

O processo estocástico $ N=(N_t)_{0\leq t \leq \infty} $ definido por:

é denominado processo de contagem associado a sequência $ (T_n)_{n\geq 1}. $

Definimos também $ T= \sup_n T_n $, então

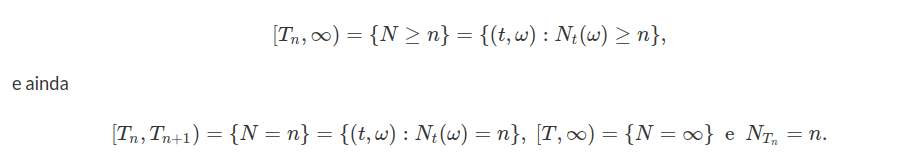

A variável aleatória T é denominada tempo de explosão do processo de contagem $ N $. Se temos $ T=\infty $ quase certamente então $ N $ é um processo de contagem não explosivo. Para um processo de contagem $ N $ não explosivo e para $ 0\leq s< t< \infty $, temos que

conta o numero de eventos que ocorrem entre o tempos $ s $ e $ t $ fixos.

Observação

É importante notarmos que da maneira como definimos o processo de contagem $ N $, este não necessariamente é um processo adaptado a filtagem $ \mathbb{F} $. Pois, ser um processo adaptado depende estritamente da filtragem, ou seja, o processo pode ser adaptado para uma determinada filtragem e não ser para outra. O teorema a seguir o nos diz sob qual circunstância $ N $ é um processo adaptado com respeito a filtragem $ \mathbb{F} $.

Teorema 7.1

O processo de contagem $ N $ é um processo adaptado, se e somente se, a variável aleatória $ T_n $ é um tempo de parada para to $ n \geq 1 $.

Demonstração

Suponha primeiramente que $ (T_n)_{n\geq 1} $ são tempos de parada, assim temos que o evento

$$ (N_t=n)=(\omega\in \Omega: T_n(\omega )\leq t< T_{n+1}(\omega))\in \mathcal{F_t}, $$

para todo $ n\geq 0 $. Então temos que $ N_t $ é $ \mathcal{F_t} $-mensurável e portanto N é um processo adaptado.

Agora suponha que $ N $ seja um processo adaptado, então o evento

$$(T_n\leq t)=(N_t\geq n)\in \mathcal{F_t},$$

para todo $ t \geq 0 $. Portanto temos que $ T_n $ é um tempo de parada. E o resultado segue.

Definição 7.2

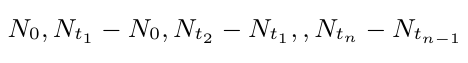

Um processo estocástico $ (N_t, t\geq 0) $ é dito possuir incrementos independentes se para quaisquer $ t_1, t_2, t_3,\cdots, t_n $, com $ 0< t_1< t_2< \cdots < t_n $ temos que

são variáveis aleatórias independentes em $ (\Omega, \mathcal{F} , \mathbb{P}) $.

Por exemplo, isto significa que o número de eventos que tenham ocorrido até tempo t (que é dado por $ N_t $) deve ser independente do número de eventos que ocorrem entre os tempos de t e t + s (isto é, $ N_{t + s}-N_t $).

Definição 7.3

Um processo estocástico $ N=(N_t, t\geq 0) $ é dito ter incrementos estacionários se $ P[N_{t+s}-N_{t}=k]=P[N_{s}=k] $, para qualquer $ t\geq 0 $ e qualquer $ k \geq 0 $.

Definição 7.4

O processo de contagem $ (N_t, t\geq 0) $adaptado na filtragem $ \mathbb{F}=(\mathcal{F_t} : t \geq 0) $ e não explosivo é dito ser um processo de Poisson se:

- N(0)=0.

- Incrementos independentes.

- Incrementos estacionários.

Com o resultado a seguir, vamos mostrar que o número de saltos relacionado com o processo de Poisson segue a distribuição de Poisson, ou seja, $ N_t $ tem distribuição de Poisson com parâmetro $ \lambda t $ para algum $ \lambda > 0 $, o que justifica o nome do processo estocástico de contagem. Note que na definição do processo $ N $ em momento algum foi citado que o processo tem alguma relação com a distribuição de Poisson, obtemos isso como consequência desta definição.

Teorema 7.2

Seja N um processo de Poisson. Então, temos que

$$\mathbb{P}(N_t=n)=\frac{e^{-\lambda t}(\lambda t)^n}{n!},~\forall n\in \mathbb{N},$$

para algum $ \lambda> 0 $. Ou seja, $ N_t\sim ~Poisson(\lambda t) $. Além disso, o processo $ N $ é contínuo em probabilidade (ou seja, $ \displaystyle \lim_{t\rightarrow u}N_t=N_u $ tomando o limite em probabilidade, ou equivalentemente temos que $ \lim_{t\rightarrow u}\mathbb{P}(|N_t-N_u|\geq \epsilon)=0, ~\forall \epsilon > 0 $) .

Demonstração

Para demonstrarmos esse resultado, vamos dividi-lo em algumas etapas.

(a) Para todo $ t\geq 0 $, temos que

$$\mathbb{P}(N_t=0)=e^{-\lambda t},$$

para algum $ \lambda> 0. $

(b) $ \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t\geq 2)=0. $

(c) $ \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t= 1)=\lambda $, no qual $ \lambda $ é a constante que aparece em (a).

(d) E por fim o resultado desejado. Temos que

$$\mathbb{P}(N_t=n)=\frac{e^{-\lambda t}(\lambda t)^n}{n!},~\forall n\in \mathbb{N}.$$

(a) Primeiramente observe que o número de chegadas no intervalo $ [0,t+s] $ é zero se, e somente se, não existe chegada no intervalo $ [0,t] $ e no intervalo $ (t,t+s] $, ou seja, o evento $ (N_{t+s}=0) $ é igual ao evento $ (N_t=0, N_{t+s}-N_t=0) $. Por definição esses eventos são independentes, então,

$$\mathbb{P}[N_{s+t}=0]=\mathbb{P}[N_t=0, N_{t+s}-N_t=0]=\mathbb{P}[N_t=0]\mathbb{P}[N_{t+s}-N_t=0].$$

Por outro lado temos que a distribuição é estacionária. Assim, temos que

$$\mathbb{P}[N_{t+s}-N_t=0]=\mathbb{P}[N_s=0].$$

Logo, concluímos que

$$\mathbb{P}[N_{s+t}=0]=\mathbb{P}[N_t=0, N_{t+s}-N_t=0]=\mathbb{P}[N_t=0]\mathbb{P}[N_s=0].$$

Portanto, temos que a função $ g(t)=\mathbb{P}[N_t=0] $, satisfaz a seguinte condição

$$g(t+s)=g(t)g(s).$$

Por um resultado clássico de análise matemática, sabemos que apenas duas funções satisfazem essa condição, ou $ g(t)=0,~ \forall t\geq 0 $, ou

$$g(t)=e^{-\lambda t},$$

para algum $ \lambda \geq 0 $. Formalmente temos que $ \lambda\in \mathbb{R} $, porém como estamos tomando a função $ g $ igual a uma probabilidade, temos que $ \lambda $ é não negativo. Assim, basta mostrarmos que $ g(t) $ não pode ser zero para todo $ t $.

De fato, note que se $ g(t) $ for igual a $ 0 $ para todo $ t $, temos que

$$N_{s}\stackrel{d}{=}N_{t+s}-N_t\geq 1, ~ ~ \mathbb{P}-q.c.,$$

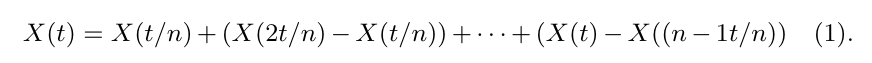

não importando quão pequeno seja $ s $. Assim sejam $ t_1< t_2< t_3< \cdots < t_n=t $, então

$$N_t=N_{t_1}+(N_{t_2}-N_{t_1})+\cdots +(N_{t_n}-N_{t_{n-1}}).$$

Desde que

$$N_{t_i}-N_{t_{i-1}}\geq 1, ~ \forall i=1,\cdots, n,$$

obtemos que $ N_t(\omega)\geq n,~ \forall n\in\mathbb{N} ~ \mathbb{P}-q.c. $. Mas isto implica que

$$N_t=\infty,$$

o que é absurdo pois por hipótese N é um processo não explosivo. Isto implica que $ g(t) $ não pode ser identicamente igual a $ 0 $. Assim, concluímos que $ g(t)=e^{-\lambda t} $ para algum $ \lambda $ não negativo. Agora, se $ \lambda =0 $, temos que $ \mathbb{P}[N_t=0]=1 $ para todo $ t \geq 0 $. Como consequência, temos que $ T_1 = \infty ~ ~ \mathbb{P}-q.c. $, o que é um absurdo, pois $ T_1 $ é uma variável aleatória. Assim, tomamos $ \lambda >0 $.

(b) Queremos mostrar que $ \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t\geq 2)=0 $. Defina $ f(t)=\mathbb{P}[N_t\geq 2] $.

Note que se $ N_{t}\geq 2 $ então $ N_{t+s}\geq 2 $, ou seja, $ (N_{t}\geq 2)\subset(N_{t+s}\geq 2) $, isto implica que

$$\mathbb{P}[N_t\geq 2]\leq \mathbb{P}[N_{t+s}\geq 2],$$

ou seja, $ f(t)\leq f(t+s) $, isto é f é uma função não decrescente. Seja $ n_t=\sup(n\in\mathbb{N}: ~n\leq 1/t) $, então $ t\leq \displaystyle \frac{1}{n_t} $ e ainda $ \displaystyle \frac{1}{t}< n_t+1 $. Portanto temos que $ f(t)\leq f\left(\frac{1}{n_t}\right) $ e

$$\displaystyle 0\leq \frac{1}{t}f(t)\leq (n_t+1)f\left(\frac{1}{n_t}\right)=\frac{n_t+1}{n_t}n_t f\left(\frac{1}{n_t}\right)$$

Como temos que $ t\downarrow 0 $, isto implica que $ n_t\uparrow \infty $ e ainda $ \displaystyle \frac{(n_t+1)}{n_t}\downarrow 1 $. Desta forma é suficiente mostrar que $ \displaystyle n f\left(\frac{1}{n}\right) $ quando $ n\rightarrow \infty $.

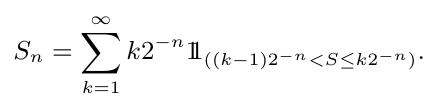

Na sequência, dividimos o intervalo $ [0,1] $ em n subintervalos de comprimento $ 1/n $ cada, seja $ S_n(\omega) $ o número de subintervalos durante os quais houveram duas ou mais chegadas para a realização $ \omega $.

Como $ N $ tem incrementos independentes, interpretamos $ S_n $ como sendo o número de sucessos em n ensaios de Bernoulli, no qual o sucesso na k-ésima tentativa significa que houveram duas ou mais chegadas durante o k-ésimo subintervalo. Então a probabilidade de sucesso de qualquer ensaio é dada por $ p=f\left(\frac{1}{n}\right) $. Portanto temos que

$$E[S_n]=np=\displaystyle nf\left(\frac{1}{n}\right).$$

Como $ N $ é processo não explosivo, temos que para quase todo $ \omega \in \Omega $, existe um tempo minimo $ \delta(\omega)> 0 $ entre duas chegadas no [0,1]. Assim para $ n $ for suficientemente grande temos que

$$\displaystyle\frac{1}{n}< \delta(\omega).$$

Então nenhum subintervalo irá conter duas chegadas, logo $ S_n(\omega)=0 $, para quase todo $ \omega\in \Omega $. Portanto, obtemos que

$$\displaystyle \lim_{n\rightarrow \infty}S_n(\omega)=0,~\mathbb{P}-qc.$$

Além disso, temos que $ S_n $ é limitado, pois não pode ser maior que o número de chegadas que ocorrem no $ [0,1] $, ou seja, $ S_n $ é limitada por $ N_1 $, o qual o valor esperado é finito. Então, temos que

$$E[S_n]\leq E[N_1]< \infty.$$

Logo, temos que a sequência $ S_n $ é dominada. Portanto, pelo teorema da convergência dominada, temos que

$$\displaystyle \lim_{n\rightarrow \infty}nf\left(\frac{1}{n_t}\right)=\lim_{n\rightarrow \infty}E[S_n]=E[\lim_{n\rightarrow \infty} S_n]=E[0]=0,$$

o que implica que $ \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t\geq 2)=0 $. Como queríamos demonstrar.

(c) Queremos mostrar que $ \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t= 1)=\lambda $, no qual $ \lambda $ é a constante que aparece em (a).

Note que,

$$\mathbb{P}[N_t=1]=1-\mathbb{P}[N_t=0]-\mathbb{P}[N_t\geq 2].$$

Então, pelos itens (a) e (b) temos que

$$\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}(N_t= 1)=\lim_{t\downarrow 0}\frac{1-e^{-\lambda t}}{t}-\lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}[N_t\geq 2]=\lambda.$$

E portanto o resultado segue.

(d) Por fim, iremos demonstrar o resultado principal, o qual nos diz que:

$$\mathbb{P}(N_t=n)=\frac{e^{-\lambda t}(\lambda t)^n}{n!},~\forall n\in \mathbb{N}.$$

Para isso, definimos a função

$$F(t)=E[\alpha^{N_t}], ~ com ~\alpha \in (0,1).$$

Sabemos que $ N_{t+s}=N_{t}+(N_{t+s}-N_t). $ Pela independência da variáveis aleatórias $ N_{t+s}-N_t $ e $ N_t $, temos que

$$F(t+s)=E[\alpha^{N_{t+s}}]=E[\alpha^{N_{t}+(N_{t+s}-N_t)}]=E[\alpha^{N_{t}}]E[\alpha^{N_{t+s}-N_t}]=F(t)F(s.)$$

Desta forma, obtemos que $ F(t)=0 $ ou $ F(t)=e^{tf(\alpha)} $, com $ f $ sendo a derivada $ F $ no ponto $ t=0 $. Desde que,

$$F(t)=E[\alpha^{N_t}]=\displaystyle \sum_{n=0}^{\infty}\alpha^n \mathbb{P}[N_t=n]\geq P[N_t=0]=e^{-\lambda t},$$

obtemos que $ F(t) $ não pode ser identicamente nula. Note também que $ F(0)=1 $, e $ F(t)=\displaystyle \sum_{n=0}^{\infty}\alpha^{n}\mathbb{P}[N_t=n] $, portanto sua derivada é dada por

$$f(\alpha)=\displaystyle \lim_{t\downarrow 0}\frac{1}{t}(F(t)-1)=$$

$$\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\left[\mathbb{P}(N_t=0)-1\right]+\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\alpha \mathbb{P}[N_t=1]+$$

$$+\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\sum_{n=2}^{\infty}\alpha^n \mathbb{P}[N_t=n].$$

Mas pelo item (a) temos que

$$\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\left[\mathbb{P}(N_t=0)-1\right]=\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\left[e^{-\lambda t}-1\right]=-\lambda,$$

e pelo item (b), o segundo limite

$$\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\alpha \mathbb{P}[N_t=1]=\alpha \lambda.$$

Além disso, pelo item (c) e para todo $ \alpha \in[0,1] $, temos que

$$0\leq \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\sum_{n=2}^{\infty}\alpha^n \mathbb{P}[N_t=n]\leq $$

$$\leq \displaystyle \lim_{t\downarrow 0}\frac{1}{t}\sum_{n=2}^{\infty}\alpha^n \mathbb{P}[N_t\geq 2]=\sum_{n=2}^{\infty}\alpha^n\displaystyle \lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}[N_t\geq 2]\leq$$

$$\displaystyle \leq \sum_{n=0}^{\infty}\alpha^n\lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}[N_t\geq 2]=\frac{1}{1-\alpha}\lim_{t\downarrow 0}\frac{1}{t}\mathbb{P}[N_t\geq 2]=0.$$

Como consequência,

$$f(\alpha)=-\lambda +\lambda\alpha,~\forall \alpha \in [0,1].$$

Desta forma,

$$F(t)=e^{-\lambda t+\lambda t\alpha}.$$

Abrindo em serie de taylor em torno do zero. Temos

$$\displaystyle \sum_{n=0}^{\infty}\alpha^n \mathbb{P}[N_t=n]=\sum_{n=0}^{\infty}\frac{e^{-\lambda t}(\lambda t)^n}{n!}\alpha^n.$$

Pela igualdade da series temos que

$$\mathbb{P}[N_t=n]=\displaystyle \frac{e^{-\lambda t}(\lambda t)^n}{n!}.$$

Portanto o resultado segue.

Na sequência, vamos mostrar que o processo de Poisson é contínuo em probabilidade, ou seja,

$$\displaystyle \lim_{t\rightarrow u}\mathbb{P}(|N_t-N_u|\geq \epsilon)=0,~ \forall \epsilon \geq 0.$$

Para isso, primeiro observemos que para $ t> u $ e $ \epsilon > 1 $ temos

$$\mathbb{P}(|N_t-N_u|\geq \epsilon)=\mathbb{P}(N_t-N_u\geq \epsilon)=\mathbb{P}(N_t-N_u\neq 0)=$$

$$1-\mathbb{P}(N_t-N_u=0)=1-\mathbb{P}(N_{t-u}=0)=1-e^{-\lambda (t-u)}.$$

Da mesma forma para $ t< u $ e $ \epsilon > 1 $ temos que

$$\mathbb{P}(|N_t-N_u|\geq \epsilon)=\mathbb{P}(N_u-N_t\geq \epsilon)=\mathbb{P}(N_u-N_t\neq 0)=$$

$$1-\mathbb{P}(N_u-N_t=0)=1-\mathbb{P}(N_{u-t}=0)=1-e^{-\lambda (u-t)}.$$

Logo,

$$\mathbb{P}(|N_t-N_s|\geq \epsilon)=1-e^{-\lambda |u-t|}.$$

Além disso, temos que

$$[|N_t-N_u|\geq \epsilon]\subset [|N_t-N_u|> 0], ~ \forall \epsilon \geq 0.$$

Portanto, temos que

$$\mathbb{P}(|N_t-N_u|> 0)\geq \mathbb{P}(|N_t-N_u|\geq \epsilon) .$$

Desta forma, ao tomarmos o limite temos que

$$\displaystyle \lim_{t\rightarrow u}\mathbb{P}(|N_t-N_s|> 0)=\lim_{t\rightarrow u}1-e^{-\lambda |u-t|}=0.$$

Portanto o resultado segue.

Definição 7.5

O parâmetro $ \lambda $ associado ao processo de Poisson dado pelo teorema 7.2 é denominado de intensidade ou taxa de chegada do processo.

Corolário 7.1

O processo de Poisson com intensidade $ \lambda $ satisfaz:

(a) $ E[N_t]=\lambda t $

(b) $ Var[N_t]=\lambda t $

Demonstração

A demonstração deste fato, decorre imediatamente do teorema 7.2. Para isto, basta calcularmos a esperança e a variância de uma v.a. com distribuição de Poisson de parâmetro $ \lambda t $.

Como consequência do teorema 7.2, obtemos a seguinte caracterização infinitessimal do processo de Poisson:

i) $ \mathbb{P}[N_{t+h} - N_t = 0]=1 - \lambda h + o(h) $,

ii) $ \mathbb{P}[N_{t+h} - N_t = 1]=\lambda h + o(h) $,

iii) $ \mathbb{P}[N_{t+h} - N_t \geq 2]=o(h) $,

no qual $ o $ é uma função tal que $ o(h)/h \rightarrow 0 $ quando $ h \rightarrow 0 $. Com isso, concluímos que exceto para um conjunto de probabilidade pequena comparada com $ h > 0 $, o processo de Poisson tem distribuição de Bernoulli tomando o valor $ 0 $ com probabilidade $ 1-\lambda t $ e o valor $ 1 $ com probabilidade $ \lambda t $. Desde que o processo de Poisson tem incrementos independentes, temos que

$$N_{t+s}-N_t = \sum_{j=1}^n N_{t+jh}-N_{t+(j-1)h},$$

com $ h=s/n $, tem aproximadamente distribuição binomial com parâmetros $ (n, \lambda s/n) $. Quando $ n \rightarrow \infty $, obtemos a convergência da distribuição binomial para a distribuição de Poisson.

Como consequência direta do teorema 7.2, temos que

$$\mathbb{P}[T_1 > t] = \mathbb{P} [N_t = 0]=e^{-\lambda t}.$$

Portanto, obtemos que $ T_1 $ tem distribuição exponencial com parâmetro $ \lambda $. Da mesma forma, temos que

$$\mathbb{P}[T_{N_s + 1} -s > t] = \mathbb{P} [N_{t+s}-N_s = 0]=e^{-\lambda t},$$

no qual $ T_{N_s + 1} -s $ é o tempo de espera após $ s $ de ocorrência do evento de interesse.

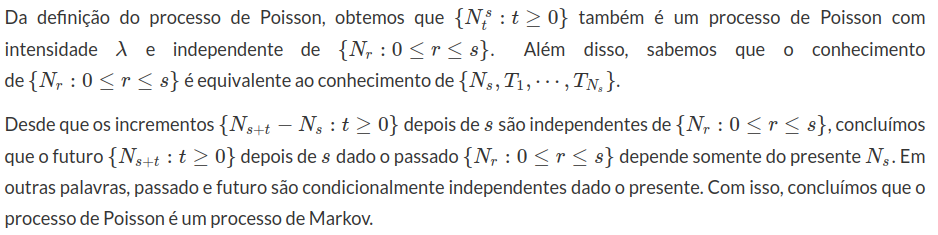

Na sequência, vamos mostrar que o processo de Poisson é um processo de Markov. Seja $ N=(N_t : t \geq 0) $ um processo de Poisson com intensidade $ \lambda $. Para todo $ s,t > 0 $, tomamos

(há elementos em falta na equação acima)

$$N^s_t = N_{s+t} - N_t.$$

Proposição 7.1

Seja $ N $ um processo de Poisson com intensidade $ \lambda $. Então $ N_t-\lambda t $ e $ (N_t-\lambda t)^2 -\lambda t $ são martingales.

Demonstração

Queremos mostrar que $ M_t=N_t-\lambda t $ é um martingale. Desde que $ \mathbb{E} M_t=0 $, basta mostrarmos que $ E[M_t|\mathcal{F_s}]=M_s, $ para todo $ t \geq s. $ De fato, note primeiramente que $ \lambda t $ é uma função não aleatória e ainda que

$$E[M_t- M_s|\mathcal{F_s}]=E[N_t-\lambda t-(N_s-\lambda s)|\mathcal{F_s}]=E[N_t-N_s|\mathcal{F_s}]-\lambda(t-s).$$

Mas $ N_t-N_s $ é independente de $ \mathcal{F_s} $ pela definição do processo de Poisson. Portanto, temos que

$$E[N_t-N_s|\mathcal{F_s}]-\lambda(t-s)=E[N_t-N_s]-\lambda(t-s)=E[N_{t-s}]-\lambda(t-s)=\lambda(t-s)-\lambda(t-s)=0.$$

O que implica que,

$$E[M_t-M_s|\mathcal{F_s}]=E[M_t|\mathcal{F_s}]-M_s=0\Rightarrow E[M_t|\mathcal{F_s}]=M_s.$$

O que mostra que $ N_t-\lambda t $ é um martingale.

Agora seja $ W_t=(N_t-\lambda)^2-\lambda t=M^2_t-\lambda t $. Queremos mostrar que $ W_t $ também é um martingale, mas antes disso mostremos algumas propriedades importantes. Sabemos que $ Var(N_t)=\lambda t $. Com isso calculamos $ E[N^2_t] $, na forma

$$Var[N_t]=E[N^2_t]-E^2[N_t]=E[N^2_t]-\lambda^2 t^2=\lambda t$$

$$\Rightarrow E[N^2_t]=\lambda t +\lambda^2 t^2.$$

Além disso,

temos que

$$E[M^2_t]=E[(N_t-\lambda t)^2]=E[N^2_t-2\lambda t N_t+\lambda^2 t^2]=\lambda t$$

e

$$E[M_t M_s|\mathcal{F_s}]=M_sE[M_t|\mathcal{F_s}]=M^2_s.$$

Assim

$$E[W_t-W_s|\mathcal{F_s}]=E[M^2_t-M^2_s-\lambda(t-s)|\mathcal{F_s}]=$$

$$E[M^2_t - M^2_s-2M_sM_t+2M_sM_t-\lambda(t-s)|\mathcal{F_s}]=E[M^2_t-M^2_s+2M^2_s-2M_sM_t-\lambda(t-s)|\mathcal{F_s}]=$$

$$E[(M_t-M_s)^2-\lambda(t-s)|\mathcal{F_s}]=E[(M_t-M_s)^2]-\lambda(t-s)$$

$$E[(M_{t-s})^2]-\lambda(t-s)=\lambda(t-s)-\lambda(t-s)=0.$$

Portanto, concluímos que

$$E[W_t-W_s|\mathcal{F_s}]=0\Rightarrow E[W_t|\mathcal{F_s}]=W_s.$$

Logo temos que $ W_t $ é um martingale e o resultado segue.

Com a proposição 7.1, obtemos que o processo estocástico $ Y_t = N_t - \lambda t $ é um martingale com respeito a filtragem $ \mathbb{F} $. Além disso, temos que $ Var(Y_t)=\lambda t $. Como $ \lambda > 0 $, obtemos que

$$\mathbb{E} [N_{t+s} \mid \mathcal{F_t}]= N_s + \lambda (t-s) \geq N_s, \quad s,t \geq 0.$$

Como consequência, dizemos que o processo de Poisson $ N $ é um submartingale. A decomposição do submartingale $ N $ em um martingale $ Y $ mais um processo “determinístico” $ \lambda t $ é denominada decomposição de Doob-Meyer.

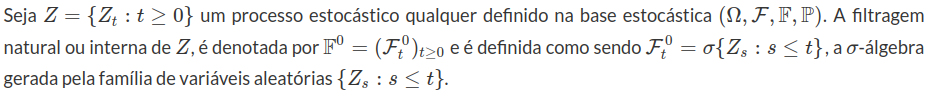

Definição 7.6

Observação

Quando não houver confusão denotaremos $ \mathbb{F}^0 $ apenas por $ \mathbb{F} $. Além disso, temos que a filtragem natural é a menor filtragem que torna $ Z $ um processo estocástico adaptado. De modo geral também temos que essa filtragem não necessariamente é completa.

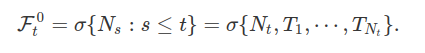

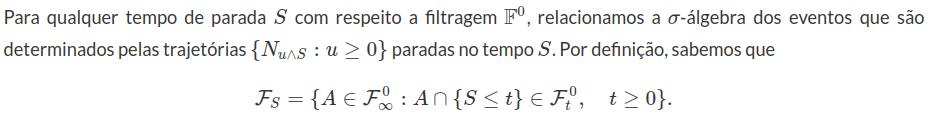

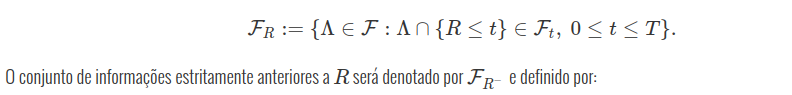

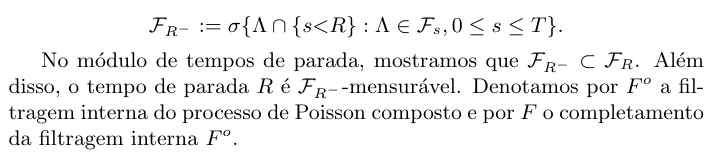

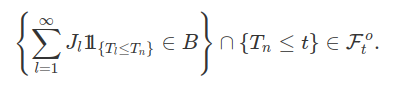

Dado $ N $ um processo de Poisson com intensidade $ \lambda $, denotamos por $ \mathbb{F}^0 $ a filtragem interna relacionada com $ N $. Por definição, temos que

Um tempo de parada $ S $ com respeito a filtragem interna $ \mathbb{F}^0 $ é uma variável aleatória não negativa satisfazendo $ (S \leq t ) \in \mathcal{F}^0_t $ para todo $ t \geq 0. $ Para todo $ s > 0 $, temos $ S=s $ é um tempo de parada. Para todo $ n \geq 1 $, as variáveis aleatórias $ T_n $ e $ T_{N_s + 1} $ também são tempos de parada. Porém, a variável aleatória $ T_{N_s} $ não é um tempo de parada, pois para todo $ t < s $, temos que

$$(T_{N_s} \leq t )=(N_s - N_t = 0 ) \not \in \mathcal{F}^0_t.$$

Propriedades da $ \sigma $-álgebra relacionada com um tempo de parada pode ser encontrado no módulo sobre “tempos de Parada”.

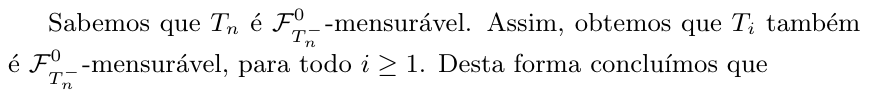

Como $ T_n $ é $ \mathcal{F}^0_{T_n} $-mensurável , temos que $ T_i $ também é $ \mathcal{F}^0_{T_n} $-mensurável para todo $ i \leq n $. Com isso consluímos que $ \sigma (T_1, \cdots , T_n) \subset \mathcal{F}^0_{T_n} $. Por outro lado, como $ N(u \wedge T_n) $ é mesurável com respeito a $ \sigma (T_1, \cdots , T_n) $ para todo $ u \geq 0 $, concluímos que

$$ \sigma (T_1, \cdots , T_n) = \mathcal{F}^0_{T_n}=\sigma ( N(u \wedge T_n) : u \geq 0 ). $$

$$\mathcal{F}^0_{T_n} = \sigma (T_1, \cdots , T_n) = \mathcal{F}_{T_{n}^{-}}^0.$$

Para todo $ A \in \mathcal{F}^0_t $, obtemos do teorema de representação de Doob-Dynkin que existe uma variável $ g $ mensurável com respeito a $ \sigma $-álgebra $ \sigma(N_{t}, T_1 , \cdots , T_{N_t}) $ satisfazendo

Como consequência, concluímos que

$$A = (H_0 \cap ( t < T_{1} ) ) \cup_{n=1}^\infty ( H_{n} \cap ( T_n \leq t < t_{n+1} )),$$

nos quais $ H_0 \in \mathcal{F}^0_0 $ e $ H_n \in \mathcal{F}^0_{T_n} $. Neste caso, dizemos que a filtragem interna $ \mathbb{F}^0 $ do processo de Poisson $ N $ é do tipo discreta, isto é,

$$ \mathcal{F}^0_{t} = (\cup_{n=0}^\infty ( H_{n} \cap ( T_n \leq t < t_{n+1} )) : H_0 \in \mathcal{F}^0_0, ~ ~ H_n \in \mathcal{F}^0_{T_n}) $$

para todo $ t > 0 $.

Teorema 7.3

Seja $ N=(N_t : t \geq 0) $ um processo de Poisson com intensidade $ \lambda $ e $ S $ um tempo de parada com respeito a filtragem interna de $ N $. Sobre o evento $ (S < \infty ) $ definimos

$$N^S_t = N_{S+t} - N_S, t \geq 0.$$

Condicional ao evento $ (S < \infty ) $, temos que $ N^S : N^S_t : t \geq 0 ) $ também é um processo de Poisson com intensidade $ \lambda $ independente de $ \mathcal{F}_S^o $.

Demonstração: Sabemos que se $ S $ é uma constante o resultado é válido. Na sequência, suponha que $ S $ toma valores em um sequência crescente $ (s_j: j \geq 1 ) $ de número reais positivos. Desde que $ S $ é um tempo de parada, temos que

$$(S=s_j)=(S \leq s_j) - (S \leq s_{j-1}) \in \mathcal{F}^o_{s_j},$$

para todo $ j \geq 1 $.

Para todo $ A \in \mathcal{F}^o_S $, $ 0 < t_1 < t_2 < \cdots < t_\ell $ e $ n_1, \cdots , n_\ell $ pertencente aos naturais, temos que

$$\mathbb{P} \left[ A \cap \left( \bigcap_{k=1}^\ell (N^S_{t_k} = n_k ) \right) \right] = \sum_{j=1}^\infty \mathbb{P} \left[ (S_j = s_j) \cap A \cap \left( \bigcap_{k=1}^\ell (N_{s_j+t_k} - N_{s_j} = n_k ) \right)\right]$$

$$= \sum_{j=1}^\infty \mathbb{P} \left[ (S=s_j) \cap A \right] \mathbb{P} \left[ \bigcap_{k=1}^\ell (N_{s_j+t_k} - N_{s_j} = n_k ) \right] = \mathbb{P} (A) \mathbb{P} \left[ \bigcap_{k=1}^\ell (N_{s_j+t_k} - N_{s_j} = n_k ) \right],$$

no qual utilizamos o fato de que $ (S=s_j) \cap A \in \mathcal{F}^o_{s_j} $ e o fato de que o processo de Poisson $ N $ tem incrementos estacionários. Portanto, o resultado é válido se $ S $ assume valores em uma sequência crescente de valores.

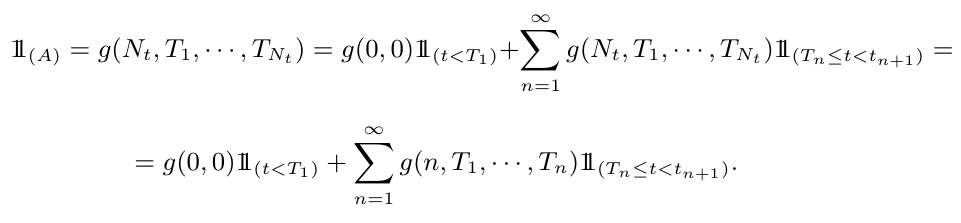

De forma geral, sabemos que qualquer tempo de parada $ S $ pode ser aproximado por uma sequência decrescente de tempos de parada $ (S_ n : n \geq 1) $, na forma

Desde que $ S_n $ assume valores em uma sequência crescente de valores, sabemos que o resultado é válido para $ S_n $. Como $ S \leq S_n $, obtemos que $ \mathcal{F}^o_{S} \subset \mathcal{F}^o_{S_n} $, para todo $ n \geq 1 $.

O fato de que $ N $ tem trajetórias contínuas à direita e de que $ A \in \mathcal{F}^o_{S} \subset \mathcal{F}^o_{S_n} $, nos leva a concluir que

$$\mathbb{P} \left[ A \cap \left( \bigcap_{k=1}^\ell (N^{S_n}_{t_k} = n_k ) \right) \right] \rightarrow \mathbb{P} \left[ A \cap \left( \bigcap_{k=1}^\ell (N^{S}_{t_k} = n_k ) \right) \right],$$

quando $ n \rightarrow \infty $. Com isso, obtemos o resultado.

Como consequência do Teorema 7.3, obtemos o seguinte corolário.

Corolário

Seja $ (S_ n : n \geq 1) $ um processo de Poisson com parâmetro $ \lambda $ e $ (T_n) $ a sequência de tempos de salto relacionado com $ N $. Tomamos os tempos de parada $ S_1=T_1 $, $ S_2=T_2 - T_1 $ e $ S_n=T_n - T_{n-1} $. As variáveis aleatórias $ S_1, S_2 , \cdots $ são independentes e identicamente distribuídas com distribuição exponencial de parâmetro $ \lambda $.

Demonstração: Sabemos que $ T_1 $ tem distribuição exponencial com parâmetro $ \lambda $. Como consequência do teorema 7.3, ao tomarmos $ S=T_n $, obtemos que $ S_n=T_n - T_{n-1} $ é o primeiro salto do processo de Poisson $ N^{T_n} $ e portanto, $ S_n $ também tem distribuição exponencial com parâmetro $ \lambda $ e é independente de $ T_1, \cdots , T_n $. Assim, concluímos que $ S_n $ é independente de $ S_1, \cdots , S_n $. Com isso, obtemos o resultado.

A seguir, apresentamos uma outra forma de definirmos o processo de Poisson que é utilizado em simulação.

Teorema 7.4

Seja $ N $ um processo de contagem. A filtragem natural de $ N $ é contínua a direita.

Demonstração

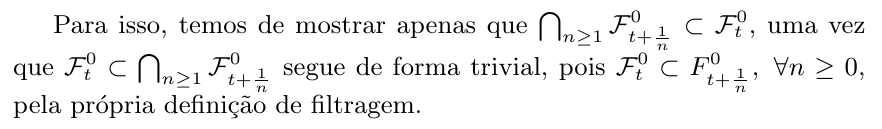

Desejamos mostrar que

$$ \bigcap_{n\geq 1} \mathcal{F}^{0}_{t+\frac{1}{n}} = \mathcal{F}^{0}_t .$$

Tome $ E = [0,\infty] $ e $ \mathcal{B} $ os borelianos de $ E $. Seja $ \Gamma $ o espaço produto dado por

$$ \Gamma = \left(\prod_{s \in [0, \infty)} E_s; \bigotimes_{s \in[0, \infty)} \mathcal{B}_s\right).$$

Definimos a relação $\pi_t: \Omega \rightarrow \Gamma$ dada por

$$ \pi_t(\omega) = s\mapsto N_{s\wedge t}(\omega).$$

Assim, temos que $ \pi_t $ é a relação que leva os elementos $ \omega $ no conjunto de funções constantes após $ t $

$$ \omega \rightarrow (N_{t\wedge s}(\omega) : \ s \in [0, \infty)). $$

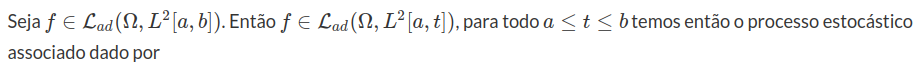

Note que, por construção, $ \pi_t $ é um gerador da filtragem interna $ \mathcal{F}^0_t $, pois $ \pi_t $ tem como imagem todos os possíveis caminhos até $ N_t $, logo $ \mathcal{F}^0_t=\sigma(\pi_t) $.

Para ilustramos melhor como funciona a função $ \pi_t $ elaboramos um gráfico. Este gráfico ilustra um ponto da função $ \pi_t $. Note que, cada ponto da função $ \pi_t $ é dado como uma trajetória (uma função). O gráfico ilustra o ponto $ \pi_t(\omega) $ para $ \omega $ fixado.

(imagem em falta)

Tome agora um evento $ \Lambda $ em $ \bigcap_{n\geq 1} \mathcal{F}^{0}_{t+\frac{1}{n}} $, temos que existe um conjunto $ A \in \bigotimes_{s \in[0, \infty)} \mathcal{B}_s $ de modo que $ \Lambda = \left(\pi_{t+\frac{1}{n}} \in A\right) $.

Defina agora um conjunto $ W_n = \left(\pi_t = \pi_{t +\frac{1}{n}}\right) $, temos que como o processo $ N_t $ é não explosivo, para cada $ \omega $, existe um $ n $, de modo que a função permanece constante em $ \left[t, t+\frac{1}{n}\right] $. Logo $ \bigcup_{n\geq 1} W_n = \Omega $.

Assim

$$\Lambda= \Omega \cap \Lambda= \lim_{n\rightarrow \infty} \left( W_n \cap \Lambda\right)$$

$$= \lim_{n\rightarrow \infty} \left( W_n \cap \left(\pi_{t+\frac{1}{t}} \in A\right)\right)= \lim_{n\rightarrow \infty} \left( W_n \cap \left(\pi_{t} \in A\right)\right)$$

$$= \lim_{n\rightarrow \infty} \left( \left(\pi_{t} \in A\right)\right)$$

Concluímos que $ \Lambda \in \mathcal{F}^0_t $.

Portanto

$$\bigcap_{n\geq 1} \mathcal{F}^{0}_{t+\frac{1}{n}} \subset \mathcal{F}^{0}_t.$$

Com isso, obtemos o resultado.

Exemplo 7.1

Suponha que os defeitos que ocorrem um cano subaquático de petróleo da Petrobras acontecem de acordo com um processo de Poisson com média $ \lambda=0,1 $ por Quilômetro.

i) Qual a probabilidade de acontecer zero defeito nos primeiros 2 Quilômetros ?

ii) Dado que não houve defeito nos primeiros 2 Quilômetros. Qual a probabilidade condicional de ter um defeito entre o segundo e o terceiro Quilômetro?

i) Basta usarmos a definição do processo de Poisson $ P[(N(t+s)-N(s))=n]=e^{-\lambda t}\frac{(\lambda t)^{n}}{n!} $ assim temos que

$$P[(N(2)-N(0))=0]=e^{- 0,2}\frac{(0,2)^{0}}{0!}=e^{- 0,2}=0,8187.$$

ii) Como $ N(3)-N(2) $ é independente de $ N(2)-N(1) $, a probabilidade condicional é dada por,

$$P[N(3)-N(2)=1|N(2)-N(0)=0]=P[N(3)-N(2)=1]=e^{- 0,1}\frac{(0,1)^{1}}{1!} = e^{-0,1} = 0,09048.$$

Exemplo 7.2

Suponha que os clientes de uma determinada loja chegam de acordo com um processo de Poisson com média $ \lambda $. Seja $ N(t) $ o número de clientes que entram até o tempo t.

i) Qual é a P[N(t)=k] para $ k=0,1,\cdots $?

ii) Fixemos t, assim para $ s\in(0,t) $. Determine $ P[N(t)=n+k|N(s)=n] $ e a $ E[N(t)N(s)] $.

i)Nesta primeira questão basta usarmos a definição do processo de Poisson como temos que N(0)=0 então

$$P[(N(t+s)-N(s))=n]=e^{-\lambda t}\frac{(\lambda t)^{n}}{n!}$$

o que implica que

$$P[(N(t+0)-N(0))=k]=P[(N(t+0)-N(0))=k]=e^{-\lambda t}\frac{(\lambda t)^{k}}{k!}$$

para $ k=0,1,\cdots $

ii) Notemos que dado que

$$\displaystyle P[N(t)=n+k|N(s)=n]=\frac{P[N(t)=n+k,N(s)=n]}{P[N(s)=n]}=\frac{P[N(t)-N(s)=k,N(s)=n]}{P[N(s)=n]}=$$

$$\frac{P[N(t)-N(s)=k]P[N(s)=n]}{P[N(s)=n]}=P[N(t)-N(s)=k]=e^{-\lambda (t-s)}\frac{(\lambda (t-s))^{k}}{k!}$$

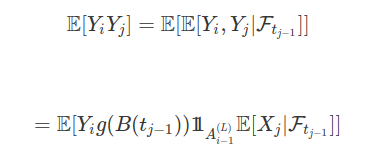

A

$$E[N(s).N(t)]=E[N(s)[N(s)+N(t)-N(s)]]=E[N^2(s)+N(s)[N(t)-N(s)]]=$$

$$E[N^2(s)]+E[N(s)[N(t)-N(s)]]=E[N^2(s)]+E[N(s)]E[N(t)-N(s)]=$$

$$\lambda s+\lambda^2 s^2+\lambda s(\lambda(t-s))=\lambda s + \lambda^2 st$$

Exemplo 7.3

Suponha que em um call center cheguem ligações de acordo com um processo de Poisson com média $ \lambda=3 $ ligações por minuto.

Qual a probabilidade de que nenhuma ligação chegue durante toda amanha das 8:00 ao 12:00.

Notemos que durante toda as 4 horas pela manha que o call center funciona para não chegar nenhuma ligação é necessário que durante todo os 240min ou seja temos queremos calcular $ P[N(240)=0]=e^{-(3)(240)}\frac{-3(240)^0}{0!}=e^{-720} $.

Exemplo 7.4

Suponha que os clientes de um supermercado cheguem a um dos caixas do mesmo de acordo com um processo de Poisson com média $ \lambda=4 $ por hora dado que o supermercado abre as 7:00 qual a probabilidade de que tenha 1 cliente por volta das 7:30 um total de 5 clientes até as 9:30 ?

Se medirmos o tempo em horas então das 7:00 as 7:30 temos meia hora e das 7:00 as 9:30 temos 2,5 horas.

$$P[N(1/2)=1;N(5/2)=5]=P[N(1/2)=1;N(5/2)-N(1/2)=4]=$$

$$P[N(1/2)=1]P[N(5/2)-N(1/2)=4]=\left[e^{-4/2}\frac{2}{1!}\right]\left[e^{-8}\frac{8^4}{4!}\right]=0,0154965.$$

Exemplo 7.5

Em certa rodovia, a intensidade média do fluxo de tráfego é de 30 carros por minuto. Um medidor é colocado na rua para registrar o número de carros

passando. Suponha válido as hipótese do processo de poison calcule:

(a) A probabilidade de que dois ou mais carros sejam registrados durante um determinado intervalo de dois segundos.

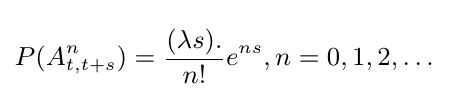

Processo de Poisson:

$ \lambda=30/min $. Agora,

$$\mathbb{P}\left[(A^0_{t,t+\frac{1}{30}})\cup(A^1_{t,t+\frac{1}{30}})^c\right]=1-\frac{(30\frac{1}{30})}{0!}e^{-30\frac{1}{30}}- \frac{(30\frac{1}{30})^1}{1!}e^{-30\frac{1}{30}}=1-2e^{-1}$$

(b) A probabilidade de passar mais de um minuto até registar o primeiro carro.

$$\mathbb{P}(A_{0,1}^0)=\frac{((30)1)^0}{0!}e^{-30\frac{1}{30}}=e^{-30}.$$

Exemplo 7.6

Consideremos um experimento em que será contado o número de estrelas em uma região longíqua do espaço, a região sendo de volume V. Façamos as seguintes

hipóteses, que são análogas espaciais das hipóteses do processo de Poisson:

(H1) A probabilidade de achar k estrelas na região depende somente de V.

(H2) Os números de estrelas contadas em regiões disjuntas do espaço são independentes.

(H3) Duas estrelas não ocupam o mesmo lugar.

Interpretando estas hipóteses de maneira semelhante à do processo de Poisson, obtenha o valor de $ \mathbb{P}_k(V)= $ probabilidade de achar exatamente $ k $

estrelas na região sendo considerada.

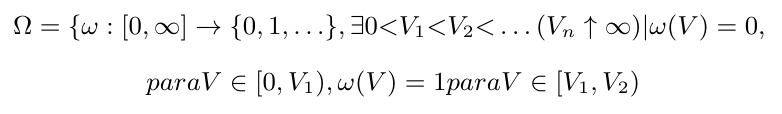

Contaremos o número de estrelas em uma determinada região V. Então, escolheremos um eixo arbitrário de coordenadas e um ponto de referência.

$$V=\frac{4}{3}\pi r^3$$

uma esfera de raio $ r $ e fazemos

Com W=[Volume da esfera de centro $ (0,0,0) $ e raio $ r=\frac{4}{3}\pi r^3 $].

Seja o evento $ A^k_{W,V}= $[Contas exatamente k estrelas no intervalo do volume $ (W,W+V] $ ]

para $ W,V > 0 $ e $ k=0,1,2,\dots $ e assumiremos que a $ \sigma $-álgebra $ \mathcal{A} $ de conjunto de $ \Omega $ contenha todos os eventos do tipo $ A^k_{W,V} $. Com

$$ A^k_{W,V}=(\omega\in \Omega: \omega(W+V)-\omega(W)=k), \quad s,t\geq 0, k=0,1,2,\dots $$

As três hipóteses adotadas são:

(H1): Incrementos estacionário: $ \mathbb{P}(A_{W,V}^k)=\mathbb{P}(A^k_{0,V})=\mathbb{P}_k(V) $, $ \forall k=0,1,2,\dots $, $ V > 0 $.

(H3) “Chegadas” não simultâneas: $ \frac{1-\mathbb{P}_0(V)-\mathbb{P}_1(V)}{1-\mathbb{P}_0(V)}\stackrel{\rightarrow}{V\rightarrow 0} 0. $

(H2) Incrementos independentes: ($ A^k_{W,V} $ e $ A^j_{U,Z} $ são independentes para toda escolha de $ k $ e $ j $ se $ (W,W+V]\cap (U,U+Z)=\emptyset $, e temos independência também no caso de $ 3,4,5, \dots $ intervalos disjuntos)

Então, temos que

$$\mathbb{P}_k(V)=\frac{(\lambda V)^k}{k!}e^{-(\lambda V)}, k=0,1,2,\dots$$

no qual $ \lambda= $(número médio de estrelas Contadas/Volume). V=(Volume de contagem)$ \geq 0 $

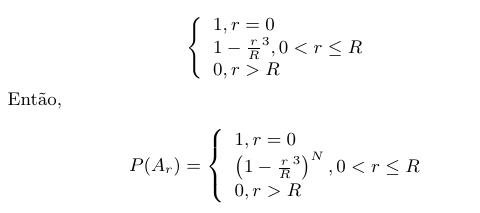

Exemplo 7.7

N pontos são escolhidos, independentemente e ao acaso, de uma esfera(bola) de raio R.

(a) Calcule a probabilidade da distância entre o centro da esfera e o ponto mais proximo ser maior que r.

Seja $ A_r= $(evento distância entre centro e ponto mais próximo é maior).

$ \mathbb{P}(A_r)= $($ \mathbb{P} $( todos os pontos distanciar do centro mais que r)=$ \mathbb{P} $( do ponto distanciar mais que r).

(b) Qual o limite da probabilidade obtida no item (a) quando $ r\rightarrow \infty $ e $ \frac{N}{r^3} $ e

$ \frac{N}{r^3}\rightarrow \frac{4}{3}\pi \lambda $ ? (Observação: este $ \lambda $ é o mesmo exercício anterior)

$$\lim \mathbb{P}(A_r)=\lim \left(1-\frac{r}{R}^3\right)^N=\lim \left(\left[1-\frac{r^3}{R^3}\right]^{R^3}\right)^{\frac{N}{R^3}}=\lim (e^{-r_3})^{\frac{N}{R^3}}=e^{-\frac{4}{3}\pi r^3 \lambda}$$

no qual $ V_r= $ volume da espera de centro na origem e raio $ r $.

Obs: Isto é o mesmo que $ \mathbb{P}_0(V_r) $ no exercício anterior.

Exemplo 7.8

Acende-se uma lâmpada no instante $ t=0 $. Para $ t= 0 $. Para $ t > 0 $, seja $ Q(t+\Delta t|t) $ a probabilidade condicional da lâmpada queimar

até o instante $ t+\Delta t $, dado que ficou acesa até o instante t. Suponha que

$$\forall t> 0, \quad \quad \frac{Q(t+\Delta t|t)}{\Delta t}\rightarrow \lambda t$$

quando $ \Delta t\rightarrow 0 $, onde $ \lambda > 0 $ não depende de t.(Este limite é chamada taxa de falha da lâmpada. Neste exemplo, a taxa de

falha, $ \lambda t $, é proporcional à idade)

(a) Ache a equação diferencial satisfeita pela função $ \mathbb{P}(t) $= probabilidade da lâmpada ficar acesa até o instante t. Você pode supor que a função

$ \mathbb{P} $ seja contínua, com $ \mathbb{P}(0)=1 $, e que as derivadas à direita e à esquerda sejam iguais.

$$Q(t+\Delta |t)=\mathbb{P}(T> t+\Delta t| T> t)=\frac{\mathbb{P}(T< t+\Delta t, T> t)}{\mathbb{P}(T> t)}$$

Já que as derivadas são iguais a direita e a esquerda e a função é contínua então $ \mathbb{P}(t) $ é diferenciável em todo $ t> 0 $. Assim

$$\mathbb{P}(t)=\lim_{\Delta t\rightarrow 0}\frac{\mathbb{P}(t+\Delta t)-\mathbb{P}(t)}{\Delta t}=\lim_{\Delta t\rightarrow 0}-\mathbb{P}(t)\left[1-\frac{1-\frac{\mathbb{P}(t+\Delta t)}{\mathbb{P}(t)}}{\Delta t}\right]=-\mathbb{P}(t)Q(t+\Delta t/t)=-\lambda t\mathbb{P}(t).$$

então, a equação diferencial será:

$$\mathbb{P}(t)+\lambda t \mathbb{P}(t)=0, \quad \quad \mathbb{P}(0)=1$$

(b) Resolva a equação diferencial do item (a)

$$\mathbb{P}(t)+\lambda t\mathbb{P}(t)=0 \rightarrow \frac{d\mathbb{P}}{dt}=-\lambda t \mathbb{P}(t)$$

o que implica

$$\int \frac{d\mathbb{P}}{\mathbb{P}}=\int -\lambda t dt\rightarrow \ln \mathbb{P}+C=-\frac{\lambda t^2}{2}$$

o que implica que

$$\mathbb{P}(t)=k e^{-\frac{\lambda t^2}{2}}$$

no qual $ k=e^{-c} $. Agora:

$$\mathbb{P}(0)=ke^{-\frac{\lambda 0^2}{2}}=k=1 \rightarrow \mathbb{P}(t)=e^{-\frac{\lambda t^2}{2}}, t\geq 0.$$

(c) Obtenha e resolva a equação diferencial satisfeita por $ \mathbb{P}(t) $ quando a taxa de falha é constante ($ =\lambda $).

Teremos:

$$\mathbb{P}(t)=-\mathbb{P}(t)Q(t+\Delta t|t)=-\mathbb{P}(t)\lambda$$

o implica que

$$\int \frac{d\mathbb{P}}{\mathbb{P}}=\int -\lambda dt\Rightarrow \ln \mathbb{P}(t) +C=e^{-\lambda t}\Rightarrow \mathbb{P}(t)= k e^{-\lambda t}$$

Agora $ \mathbb{P}(0)=1=k e^{-0 \lambda}=k $

o que implica que

$$\mathbb{P}(t)=e^{-\lambda t}, t\geq 0$$

Exemplo 7.9

Uma lâmpada está acesa no tempo $ t=0 $. Sempre que a lâmpada queimar, é substituída por uma lâmpada nova, embora isso não seja feito imediatamente.

Suponha que para todo $ t> 0 $;

(H1) dado que a lâmpada esteja acesa no instante t, a probabilidade dela estar queimada no instante $ t+\Delta t $, dividida por $ \Delta t $, converge para

$ \lambda $ quando $ \Delta t\rightarrow 0; $ e

(H2) dado que a lâmpada esteja queimada no instante t, a probabilidade dela estar novamente acesa em $ t+\Delta t $, divida por $ \Delta t $, converge para

$ \xi $ quando $ \Delta \rightarrow 0 $. ($ \lambda, \xi > 0. $)

(a) Seja $ \mathbb{P}(t) $ a probabilidade da lâmpada estar acesa no instante t, $ t\geq 0 $. Ache a equação diferencial satisfeita por $ \mathbb{P}(t) $.

$$\mathbb{P}_{q/a}(t+\Delta t|t)=(\text{ probabilidade de estar queimada em } t+\Delta t \text{ dado que estava acesa em } t)$$

$$\mathbb{P}_{a/q}(t+\Delta t|t)=(\text{ probabilidade de estar acesa em } t+\Delta t \text{ dado que estava queimada em } t)$$

Pela hipótese $ (H1) $,

$$\frac{\mathbb{P}_{q/a}(t+\Delta t|t)}{\Delta t}\rightarrow \lambda$$

Por (H2)

$$\frac{\mathbb{P}_{a/q}(t+\Delta t|t)}{\Delta t}\rightarrow \xi$$

e seja $ \mathbb{P}_a(t)=(\text{ probabilidade de estar acesa em t}) $. Então

$$\mathbb{P}_a(t+\Delta t)=\mathbb{P}(\text{ acesa em } t+\Delta t, \text{ acesa em } t \cup \text{queimada em } t)= $$

$$\mathbb{P}(\text{ acesa em } t+\Delta t, \text{ acesa em } t) \mathbb{P}(\text{ acesa em } t+\Delta t, \text{queimada em } t)=$$

Agora sendo $ \mathbb{P}_a $ contínua e com derivados iguais a direita e esquerda e portanto diferenciável em todo t.

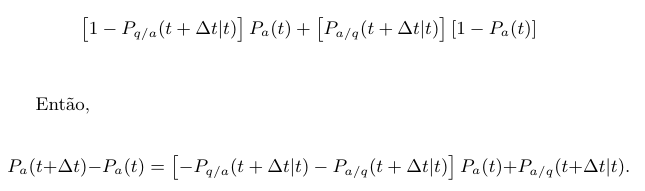

$$\mathbb{P}^\prime_a(t)=\lim_{\Delta t\rightarrow 0} \frac{\mathbb{P}_a(t+\Delta t)-\mathbb{P}_a(t)}{\Delta t}= \lim_{\Delta t\rightarrow 0}\mathbb{P}_a(t)\left[-\mathbb{P}_{q/a}(t+\Delta t| t){\Delta t}-\frac{\mathbb{P}_{a/q}(t+\Delta t| t)}{\Delta t}\right]+\frac{\mathbb{P}_{a/q}(t+\Delta t|t)}{\Delta t}= -\mathbb{P}_a(t)[\lambda +\xi]+\xi.$$

Então, a equação diferencial será

$$\mathbb{P}^\prime_a(t)+\mathbb{P}_a(t)[\lambda+\xi]-\xi=0, \mathbb{P}_a(0)=1.$$

(b) Resolva a equação diferencial do item (a). Determine $ \lim_{t\rightarrow \infty} \mathbb{P}(t) $.

Temos que

$$\mathbb{P}^\prime_a(t)+\mathbb{P}_a(t)[\lambda+\xi]=0$$

o que implica que

$$\mathbb{P}_a^h(t)=k e^{-(\lambda+\xi)t}$$

solução particular

$$\mathbb{P}_a(t)=C\Rightarrow C[\lambda +\xi]=\xi \Rightarrow C=\frac{\xi}{\lambda +\xi}$$

o que implica que

$$\mathbb{P}^p_a(t)=\frac{\xi}{\lambda+\xi}$$

e então

$$\mathbb{P}_a(t)=\mathbb{P}_a^h(t)+\mathbb{P}_a^p(t)=ke^{(\lambda+\xi)t}+\frac{\xi}{\lambda +\xi}, t\geq 0$$

Agora,

$$\lim_{t\rightarrow \infty}\mathbb{P}_a(t)=\frac{\xi}{\lambda+\xi}.$$

Este resultado tem um apelo intuitivo, pois se $ \xi\gg \lambda $ então

$$\lim_{t\rightarrow \infty}\mathbb{P}_a(t)\approx 1$$

ou seja, a lâmpada permanece acesa e se, $ \lambda \gg \xi $ então

$$\lim_{t\rightarrow \infty}\mathbb{P}_a(t)\approx 0$$

ou seja, a lâmpada permanece queimada. De fato, esta relação nos dá uma idéia da proporção do tempo que a lâmpada fica acesa.

Exemplo 7.10

Suponhamos que cada elemento de certa população ou morre ou se divide. (Exemplo: uma colônia de bactérias.) Façamos três hipóteses:

(H1) A probabilidade de que um elemento, vivo no instante t, venha a morrer até o instante $ t+\Delta t $, é assintoticamente equivalente a $ \mu\Delta<br /> t $(i.e., a razão dos dois converge para 1 quando $ \Delta t \rightarrow 0 $).

(H2) Um elemento vivo no instante t se divide até o instante $ t+\Delta t $ com probabilidade assintoticamente equivalente a $ \lambda \Delta t $, e produz

“netos” (i.e., se divide ao menos duas vezes) com probabilidade que, dividida por $ \Delta t $, converge para 0 quando $ \Delta t\rightarrow 0 $.

(H3) Não há interação entre os elementos, e eles morrem ou se dividem independentemente.

(a) Ache as equações diferenciais satisfeitas pelas probabilidades $ \mathbb{P}_n(t)= $ probabilidade da população conter exatamente $ n $ elementos no instante t $ (n=0,1,2, \dots; t\geq 0). $

(b) Mostre que se $ \lambda= \mu=1 $ e $ \mathbb{P}_1(0)=1 $, uma solução será

$$\mathbb{P}_0(t)=\frac{t}{1+t}; \mathbb{P}_n(t)=\frac{t^{n-1}}{(1+t)^{n+1}}, n=1,2, \dots.$$

(c) Supondo que a solução do item (b) seja a única, qual a probabilidade da população mais cedo ou mais tarde ficar extinta ?

7.1 - Construção do Processo de Poisson por Pontos Marcados

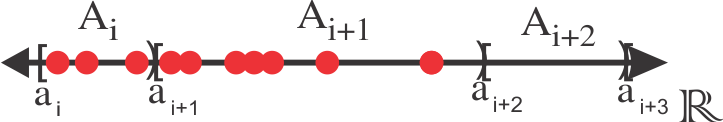

Para começar nossa construção, vamos primeiramente tomar uma partição enumerável qualquer de $ \mathbb{R} $. A partir dessa partição vamos construir nosso processo, em seguida mostraremos que a construção do processo não depende de uma particular escolha da partição.

Assim sendo seja, $ A=(A_i,i\in \mathbb{Z}) $, com $ A_i=[a_i,a_{i+1}) $ e $ a_i< a_{i+1} $. Denominaremos $ |A_i| $ o comprimento $ a_{i+1}-a_i $ do intervalo $ A_i $. Assim, como o conjunto $ A $ é uma partição temos que $ \displaystyle \bigcup_{i\in\mathbb{Z}}A_i=\mathbb{R} $ e $ A_i\cap A_j=\emptyset $ para $ i\neq j $.

Além disso, seja $ Y_i $ uma variável aleatória com distribuição Poisson de média $ \lambda|A_i| $, ou seja

$$\mathbb{P}(Y_i=k)=\displaystyle \frac{e^{-\lambda|A_i| }(\lambda|A_i|)^{k}}{k!}$$

Tome $ Y=(Y_i,\in\mathbb{Z}) $ variáveis independentes.

Para cada $ i\in\mathbb{Z} $ considere uma sequência de variáveis independentes $ (U_{j}^{i}| j=1,2,\cdots) $, uniformes no intervalo $ A_i $.

$$\mathbb{P}(U_j^i\in B\cap A_i)=\displaystyle \frac{|B\cap A_i|}{|A_i|}$$

Seja $ \mathcal{S} $ o conjunto aleatório

$$\mathcal{S}=\displaystyle \bigcup_{i\in\mathbb{Z}}S_i$$

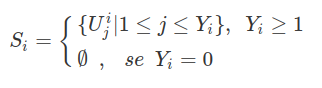

Com $ S_i $ sendo variáveis aleatória crescentes definidas por

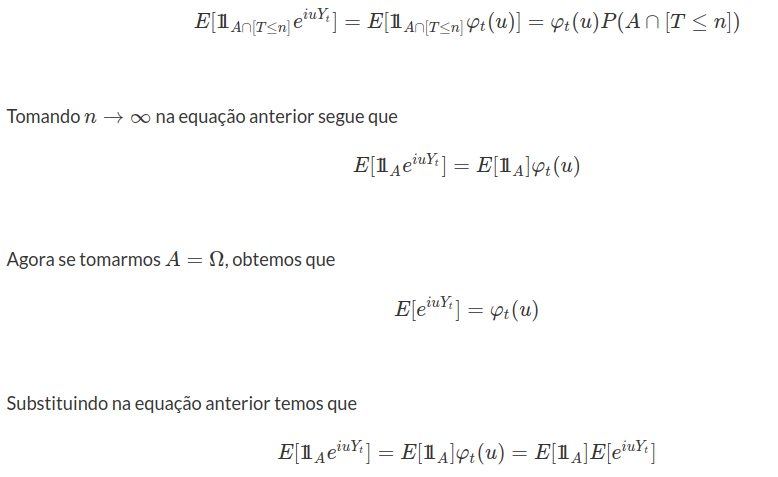

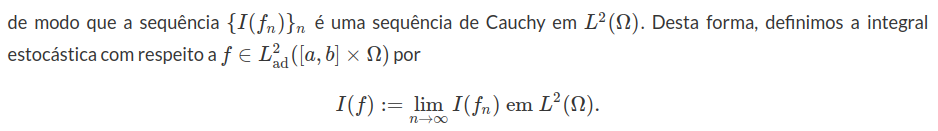

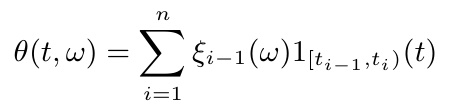

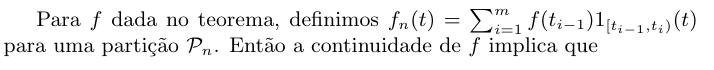

Note que $ S_i $ coloca em cada intervalo $ A_i $ exatamente $ Y_i $ pontos, sendo eles uniformentes distribuídos. Como na figura abaixo, nela temos que no intervalo $ A_i $ tem 3 pontos marcados pois $ Y_i=3 $ e $ A_{i+1} $ tem 7 pontos, pois $ Y_{i+1}=7 $, já $ A_{i+2} $ não tem nenhum ponto marcado

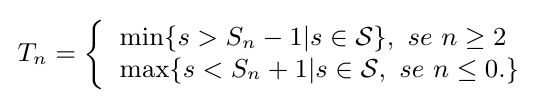

Agora ordenamos todos os pontos de $ \mathcal{S} $, assim seja $ (T_n)_{n\in\mathbb{Z}} $ a sequência ordenada dos pontos de $ \mathcal{S} $, definida da seguinte forma

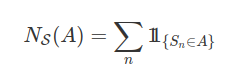

Para $ A\subset\mathbb{R} $, definimos $ N_{\mathcal{S}}(A)=(\text{ número de pontos do conjunto }\mathcal{S}\cap A) $. É claro que

Para que nosso processo não seja explosivo necessitamos colocar uma pequena restrição, necessitamos que o processo de pontos marcados não tenha pontos de acumulação, ou seja, um intervalo no qual tenha infinitos pontos marcados.

Com isso construímos nosso processo de poisson, entretanto, necessitamos mostrar que ele de fato tem distribuição de poisson com parâmetro $ \lambda t $. O incrementos independentes e estacionários decorre da própria construção do processo.

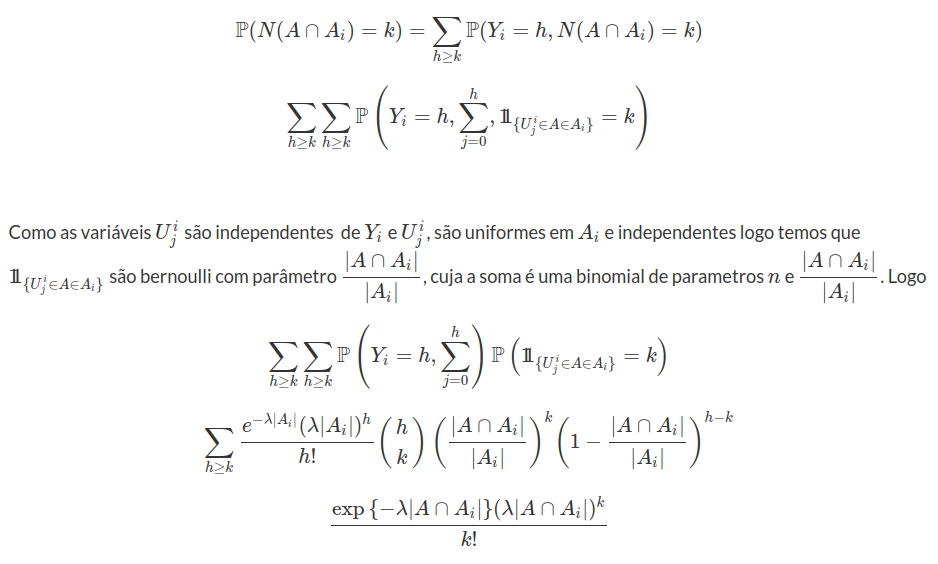

Lema 7.3.1.1

Para cada intervalo A, a variável aleatória $ N(A) $ tem distribuição de poisson com média $ \lambda |A| $.

Demonstração

Observe que $ A\cap A_i $ são conjuntos disjuntos, e por isso as variáveis $ N(A\cap A_i) $ são independentes. Assim por construção

Por fim, basta notar que $ N(A)=\displaystyle \sum_i N(A\cap A_i) $ é uma soma de variáveis aleatórias independentes com distribuição de Poisson de médias $ \lambda |A\cap A_i| $, como os $ A_i $ são disjuntos temos que $ \displaystyle \sum_i |A\cap A_i|=|A| $. Assim, $ N(A)~\sim ~Poisson(|A|) $.

Para mais detalhes sobre esse tipo de construção o leitor pode estar consultando o livro de Ferrari e Galves.

8 - Movimento Browniano

Existem diversos fenômenos biológicos, físicos, entre outros, baseados na aleatoriedade. Um exemplo clássico, de fundamental importância, em que podemos perceber a aleatoriedade está relacionado com o movimento dos preços de ativos e índices financeiros. Apesar disso, este não é o único exemplo em que temos significantes flutuações aleatórias. Por exemplo, em biologia, temos equações diferenciais que representam interações entre predadores e presas. Tais modelos, geralmente, são escritos utilizando modelos de equações diferenciais ordinárias. Entretanto, tais populações vivem em ambientes sujeitos a eventos aleatórios que não estão previstos nestas equações. A partir do teorema central do limite, assumimos que estas influências aleatórias dos processos são acumuladas de forma a tornarem-se uma distribuição normal. Neste sentido, um dos principais processos estocásticos é o movimento Browniano.

O movimento Browniano é um processo estocástico nomeado após o botânico Robert Brown observar em 1826 o movimento aleatório do pólen em seu microscópio. Inicialmente, ele imaginou que o pólen estivesse vivo e, por isso, estaria se movimentando. Mais tarde, foi verificado que, na verdade, o movimento se dava devido a pequenos, porém incessantes impactos aleatórios do pólen com moléculas de ar. Dente algumas aplicações para o movimento Browniano, destacamos o estudo de partículas microscópicas, a variação dos preços de ativos no mercado, o ruído térmico em circuitos elétricos e, até mesmo, variações e mutações genéticas. A definição formal é dada abaixo.

Definição 8.1 (Movimento Browniano Unidimensional padrão)

Um movimento Browniano contínuo é um processo adaptado $ B=(B_t,\mathcal{F_t}:0\leq t< \infty) $, definido sobre $ (\Omega,\mathcal{A},P) $, com as seguintes propriedades:

- $ B_0=0 $ quase certamente, isto é, $ \mathbb{P}(B_0 = 0) = 1 $;

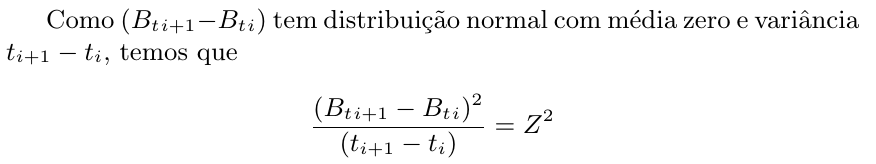

- Para qualquer $ 0\leq s \ < \ t $, o incremento $ B_t-B_s $ tem distribuição normal com média zero e variância t-s, isto é, $ B_t - B_s\sim N(0,t-s) $ ou

$$\mathbb{P}(a\leq B_t-B_s\leq b) = \frac{1}{\sqrt{2\pi(t-s)}}\int_a^b\exp\left(-\frac{x^2}{2(t-s)}\right).$$

- $ B_t $ tem incrementos independentes, isto é, para quaisquer $ 0 \ < \ t_1 \ < \ t_2 \ < \ \ldots \ < \ t_n $, as variáveis aleatórias

$$B_{t_1}, B_{t_2}-B_{t_1},\ldots,B_{t_n}-B_{t_{n-1}}$$

são independentes.

- As trajetórias de $ B_t $ são função contínuas quase certamente, isto é,

$$\mathbb{P}(B_{\cdot}(\omega) \ \text{ser contínua}) = 1.$$

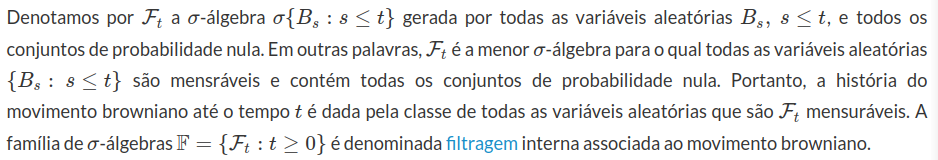

O movimento Browniano também é denominado de Processo de Wiener, já que foi Wiener quem formalizou suas propriedades no século XX. Diretamente da definição do movimento browniano, concluímos que $ \mathbb{E}(B_t)=0 $, $ ~Var(B_t)=t $ e $ Cov[B_t,B_s]=min(t,s) $.

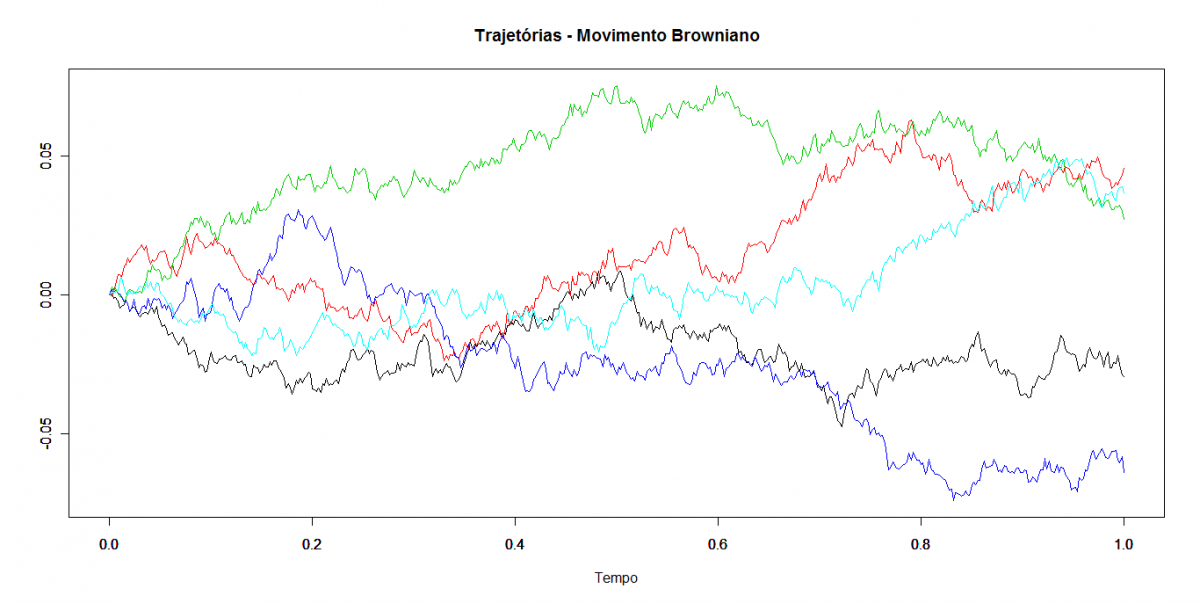

Propriedades elementares do movimento Browniano

A partir das propriedades acima, podemos simular, de maneira bastante eficiente, trajetórias do movimento Browniano. A fim de simular estas trajetórias no intervalo $ [0,T] $, consideramos os instantes $ 0 = t_0 \ < \ t_1 \ < \ t_2 \ < \ \ldots \ < t_n = T $ de forma que $ \Delta t_j = t_j -t_{j-1} = h $. Então, podemos determinar o valor de $ B_{t_j} $ a partir do valor de $ B_{t_{j-1}} $ utilizando a propriedade de incrementos independentes da forma

$$B_{t_j} = B_{t_{j-1}} + (B_{t_j} - B_{t_{j-1}}) = B_{t_{j-1}} + \sqrt{h}Z_j \ \text{com} \ Z_j\sim N(0,1) \ \text{e com} \ B_0 = 0.$$

Portanto, conhecido o valor do movimento Browniano no instante $ t_{j-1} $, para encontrar o valor $ B_{t_j} $, basta simular um valor de uma distribuição normal padrão e utilizar a fórmula acima. Desta forma, o algoritmo para simulação de uma trajetória do movimento Browniano no instante $ [0,T] $ pode ser construído a partir dos passos abaixo.

- Definir o instante final $ T $ de simulação.

- Definir o número $ n $ de subintervalos do intervalo $ [0,T] $.

- O tamanho dos subintervalos é calculado da forma $ h = T/n $.

- No instante inicial, o movimento Browniano assume o valor zero, isto é, $ B_0 = 0 $

- Para cada $ j= 1,\ldots,n $, simulamos uma variável $ Z_j $ com distribuição normal padrão, isto é, $ Z_j\sim N(0,1) $. Então, o valor do movimento Browniano no instante $ t_j $ é dado por $ B_{t_j} = B_{t_{j-1}} + \sqrt{h}Z_j $.

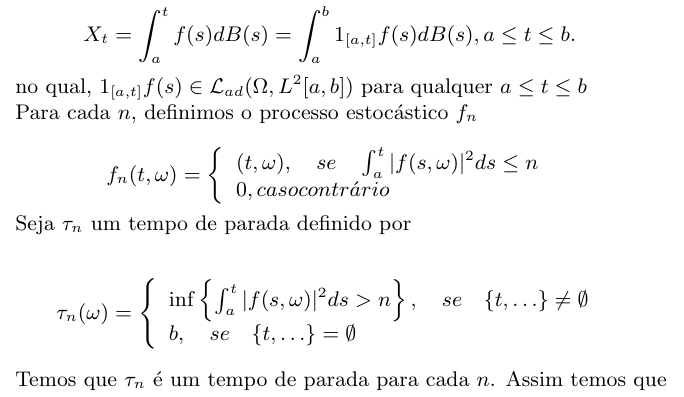

Na figura a seguir, temos a simulação de 5 trajetórias do movimento Browniano no intervalo $ [0,1] $. Utilizamos $ 500 $ instantes para a partição do intervalo e, além disso, os subintervalos são igualmente espaçados com tamanho $ h = \frac{1}{500} $.

Na sequência, vamos utilizar o teorema central do limite (TCL) para apresentar uma ideia intuitiva do comportamento do movimento browniano. O TCL nos diz, que sob condições gerais, a soma de variáveis aleatórias independentes de impacto individual “pequeno” tem distribuição “aproximadamente” normal. Ao considerarmos tais somas como processos, podemos obter aproximações para o movimento browniano.

Como consequência do TCL, ao tomarmos ma sequência de variáveis aleatórias independentes e identicamente distribuídas (iid) $ \xi_1, \xi_2, \cdots $ com $ \mathbb{E}(\xi_n)=0 $ and $ Var(\xi_n)=1 $, obtemos que

$$\frac{X_n}{\sqrt{n}} \rightarrow \xi=N(0,1), \quad \text{quando} ~ n \rightarrow \infty,$$

no qual $ X_n=\xi_1, \cdots , \xi_n $ para todo $ n \geq 1 $.

Para estendermos a sequência de variáveis aleatórias $ (X_n) $ para um processos estocástico $ (X_t : t \geq 0) $ tomamos

$$X_t=X_{[t]}=X_k, \quad t \in [k,k+1), ~k\in \mathbb{N} \cup (0),$$

no qual $ [t] $ denota a parte inteira do número $ t $. Como consequência do TCL,

$$X^n_t=\frac{X_{nt}}{\sqrt{n}} \rightarrow B_t \sim N(0,t).$$

Na realidade, temos que

$$\frac{X_{nt}}{\sqrt{n}}=\frac{X_{[nt]}}{\sqrt{[nt]}}\sqrt{\frac{[nt]}{n}}\rightarrow \xi \sqrt{n} \sim N(0,t), \quad \text{quando} ~n \rightarrow \infty,$$

no qual utilizamos o fato de que $ [nt]/n \rightarrow t $ quando $ n \rightarrow \infty $ para todo $ t \geq 0 $. Portanto, para todo $ t\geq 0 $ fixo, a sequência de variáveis aleatórias $ (X^n_t) $converge em distribuição para a variável aleatória $ B_t \sim N(0,t) $. Entretanto, isto não significa que a sequência de processos estocásticos $ (X_n) $ converge, em algum sentido, para o movimento browniano. A construção do movimento browniano está na próxima seção. A seguir, apresentamos algumas propriedades elementares do movimento browniano.

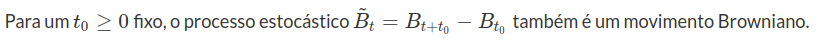

Proposição 8.1

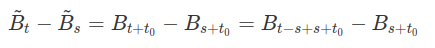

Demonstração: É imediato que $ \tilde{B}_0 = 0 $ quase certamente e que $ \tilde{B}_t $ tem trajetórias contínuas quase certamente, de forma que as condições (1) e (4) são satisfeitas. Agora, para qualquer $ s \ < \ t $, temos que

Outra importante propriedade é que o movimento Browniano não é diferenciável em qualquer ponto quase certamente. De fato, se $ t \ > \ t_0 $, o incremento $ B_{t} - B_{t_0} $ é uma variável aleatória normal com média $ 0 $ e variância $ t-t_0 $. Portanto, temos que $ (B_{t}-B_{t_0})/(t-t_0) $ é uma variável aleatória normal com média $ 0 $ e variância $ t-t_0 $. Desta forma, quando $ t\rightarrow t_0 $, a variância desta variável aleatória vai para infinito.

Proposição 8.2

Para todo $ t_0 $, temos que

$$\limsup_{t\rightarrow t_0}\left|\frac{B_t-B_{t_0}}{t-t_0}\right|=\infty \ \text{q.c}$$

o que implica que, para qualquer $ t_0 $, quase toda trajetória $ B_t $ não é diferenciável neste ponto.

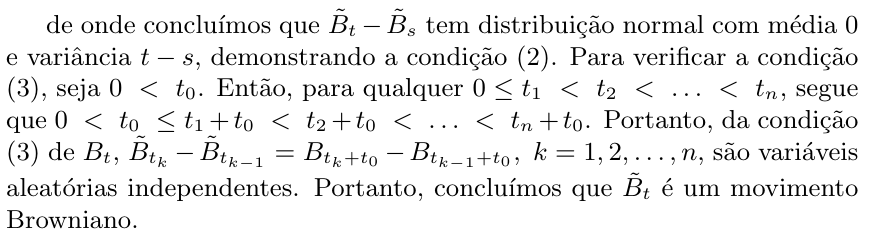

Demonstração: Sem perda de generalidade, suponha que $ t_0 = 0 $ e considere o evento

Então, para qualquer sequência $ (h_n) $ decrescente e convergindo para $ 0 $, temos que

$$A(h_n)\supset A(h_{n+1}),$$

e

$$A(h_n) \supset \left(\left|\frac{B_{h_n}}{h_n}\right| \ > \ D \right).$$

Portanto,

$$\mathbb{P}(A(h_n)) \geq \mathbb{P}\left(|B_{h_n}/\sqrt{h_n}| \ > \ D\sqrt{h_n}\right) = \mathbb{P}(|B_1| \ > \ D\sqrt{h_n}) \rightarrow 1, \ n\rightarrow \infty.$$

Então,

$$\mathbb{P}\left(\bigcap_{n=1}^{\infty}A(h_n)\right) = \lim_{n\rightarrow\infty} \mathbb{P}(A(h_n)) = 1.$$

De onde segue que

$$\sup_{0 < s \leq h_n}\left|\frac{B_s}{s}\right| \geq D \ \text{q.c para todo} \ n \ \text{e} \ D \ > 0.$$

Portanto,

$$\lim_{h\rightarrow 0}\sup_{0 < s \leq h}\left|\frac{B_s}{s}\right| = \infty \ \text{q.c}.$$

Segue a proposição.

A proposição acima nos diz que, apesar do movimento browniano ter trajetórias contínuas, estas não apresentam derivada em qualquer ponto $ 0 \leq t < \infty $.

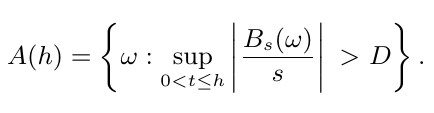

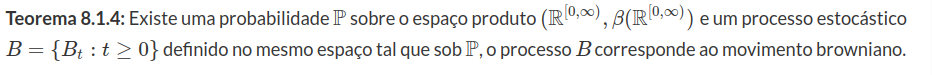

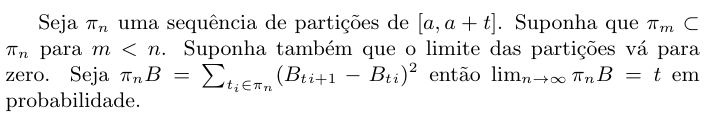

Proposição 8.3

Demonstração

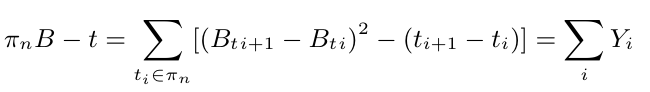

Onde $ Y_i $ são variáveis aleatórias independentes com média zero. Portanto

$$ \mathbb{E} [(\pi_n B - t)^2 ] = \mathbb{E} [(\sum_i Y_i )^2 ] = \sum_i \mathbb{E} (Y_i )^2 $$

tem distribuição qui-quadrado.

$$\mathbb{E} [(\pi_n B - t)^2]=\mathbb{E} [\sum (t_{i+1} - t_i )^2 (Z^2 -1)^2 ] = $$

$$ = \sum (t_{i+1} - t_i )^2 \mathbb{E}[(Z^2 - 1)^2 ] \leq \mathbb{E}[(Z^2 - 1)^2 ] \hbox{mesh} (\pi_n )t \to 0 $$

Na próxima seção, discutimos a questão de existência do movimento browniano.

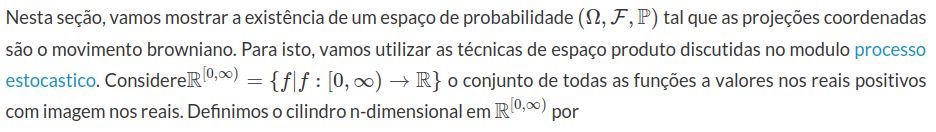

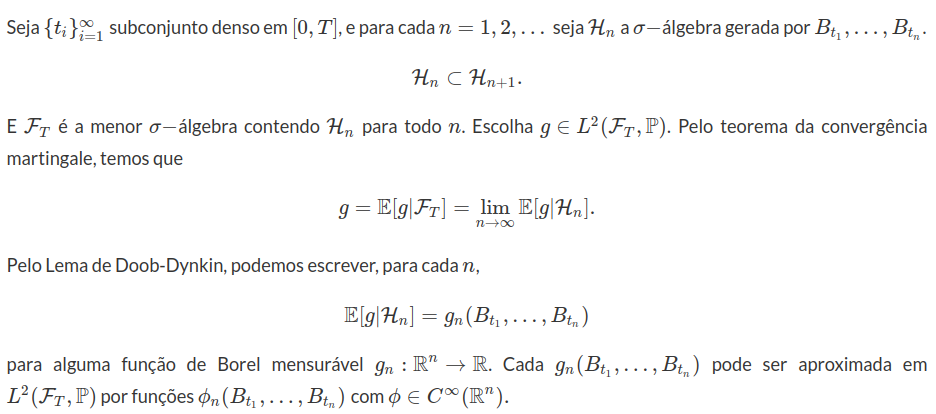

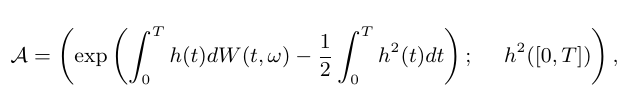

8.1 - Construção do Movimento Browniano: Probabilidade Produto.

$$C=(\omega \in \mathbb{R}^{[0,\infty)}|(\omega(t_1),\cdots,\omega(t_n))\in A),$$

no qual $ t_i\in[0,\infty), i=1,\cdots,n $ e $ A $ pertence aos borelianos de $ \mathbb{R}^n $. Denotamos por $ \mathcal{C} $ a classe de todos os cilindros. E por fim definimos $ \mathfrak{B}(\mathbb{R}^{[0,\infty)}) $ a menor $ \sigma $-álgebra que contém $ \mathcal{C} $. Para maiores detalhes sobre a classe dos cilindros e da $ \sigma $-algebra gerada pelos cilindros, ver seção produto de espaços mensuráveis.

Definição 8.1.1

Seja $ D $ o conjunto de todas as sequências finitas $ t=(t_1,\cdots,t_n) $ de números não negativos. Suponha que para cada $ t\in D $ temos uma probabilidade $ Q_t $ em $ (R^n,\mathfrak{B}(\mathbb{R}^n)) $. A coleção $ (Q_t)_{(t\in D)} $ é denominada familia de distribuições finito dimensionais.

Definição 8.1.2

A família $ (Q_t)_{t\in D} $ é consistente se esta satifaz as condições de compatibilidade de Kolmogorov:

(a)Se $ s=(t_{i_1},\cdots, t_{i_n}) $ é uma permutação de $ t=(t_1,\cdots,t_n) $, então para qualquer $ A_i\in \mathfrak{B}(\mathbb{R}) $, temos que:

$$Q_t(A_1\times \cdots \times A_n)=Q_s(A_{i_1}\times \cdots \times A_{i_n}),$$

(b)Se $ t=(t_1,\cdots,t_n) $ com $ n\geq 1 $, $ s=(t_1,\cdots, t_{n-1}) $, e $ A\in \mathfrak{B}(\mathbb{R}^{n-1}) $, então

$$Q_t(A\times \mathbb{R})=Q_s(A).$$

Observação

Se temos uma probabilidade $ \mathbb{P} $ sobre $ (\mathbb{R}^{[0,\infty)},\mathfrak{B}(\mathbb{R}^{[0,\infty)})) $, podemos definir a família de distribuições finito dimensionais, na forma

$$Q_t(A)=\mathbb{P}[\omega \in \mathbb{R}^{[0,\infty)}|(\omega(t_1),\cdots,\omega(t_n))\in A],$$

com $ A\in \mathfrak{B}(\mathbb{R}^{n}) $.

A seguir, temos por interesse construir uma probabilidade sobre $ \mathfrak{B}(\mathbb{R}^{[0,\infty)}) $ a partir de uma família de distribuições finito dimensionais. Para isto, enunciamos o seguinte teorema.

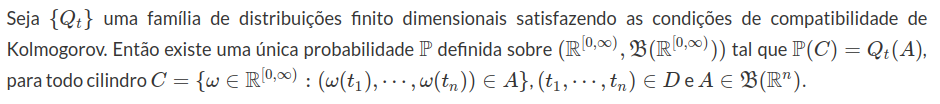

Teorema 8.1.1

Demonstração: Desde que toda probabilidade definida sobre $ (\mathbb{R}, \mathfrak{B}(\mathbb{R})) $ é compacta, basta aplicarmos os resultados da seção probailidade sobre o espaço produto.

Assim para construirmos uma probabilidade $ \mathbb{P} $ sobre $ (\mathbb{R}^{[0,\infty)},\mathfrak{B}(\mathbb{R}^{[0,\infty)})) $ tal que o movimento browniano corresponda às projeções coordenadas, precisamos construir uma família de distribuições finito dimensionais satisfazendo as condições de compatibilidade de Kolmogorov. Por definição, a função de distribuição acumulada de $ (B_{s_1},\cdots, B_{s_n}) $, com $ 0=s_0< s_1< \cdots < s_n $ é dada por:

$$F_{s_1,\cdots , s_n}(x_1,\cdots, x_n)=\displaystyle \int_{-\infty}^{x_1}\int_{-\infty}^{x_2}\cdots\int_{-\infty}^{x_n}f(s_1,0,y_1)f(s_2-s_1,y_1,y_2) \cdots f(s_n-s_{n-1},y_{n-1},y_{n})dy_n \cdots dy_1,$$

no qual $ f(t,x,y) $ é definido como sendo

$$f(t,x,y)=\frac{1}{\sqrt{2\pi t}}e^{-(x-y)^2/2t}, t> 0, x,y\in \mathbb{R}.$$

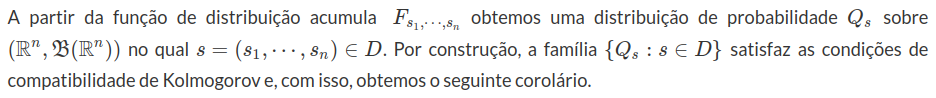

Corolário 8.1.1

Existe uma única probabilidade $ \mathbb{P} $ em $ (\mathbb{R}^{[0,\infty)},\mathfrak{B}(\mathbb{R}^{[0,\infty)})) $, sobre a qual o processo projeção coordenada

$$W_t(\omega)=\omega(t),\omega\in\mathbb{R}^{[0,\infty)}, t> 0 $$

tem incrementos independentes e estacionários. Por construção, qualquer incremento $ W_t - W_s $ no qual $ 0 \leq s \leq t $, tem distribuição normal com média zero e variância $ t-s $.

Note que nossa construção já estaria completa se não fosse pelo fato de que construímos um processo sobre $ \mathbb{R}^{[0,\infty)} $. Porém, gostaríamos que nosso espaço amostral fosse apenas as funções contínuas, o qual é denotado por $ C[0,\infty) $, com

$$C[0,\infty)=(f\in \mathbb{R}^{[0,\infty)}| f\quad \text{contínua}).$$

Talvez o leitor pense que esse problema seja fácil de se tratar, bastaria mostrar que a probabilidade $ \mathbb{P} $ do corolário anterior é uma probabilidade em $ C[0,\infty) $. Para isto, teríamos apenas que restringir $ \mathbb{P} $ sobre $ C[0,\infty) $. Porém, o problema é que o conjunto $ C[0,\infty)\notin \mathfrak{B}(\mathbb{R}^{[0,\infty)}) $, ou seja, $ \mathbb{P}(C[0,\infty)) $ não está bem definido e portanto não podemos fazer isso. Note que isso ocorre pis $ \mathfrak{B}(\mathbb{R}^{[0,\infty)}) $ é uma $ \sigma $-álgebra pequena demais, contendo apenas funções que podem ser escritas com no máximo um número enumerável de coordenadas. Obviamente que não podemos descrever uma função continua com um número enumerável de coordenadas. Assim, vamos construir uma modificação do movimento browniano para que este tenha trajetórias contínuas quase certamente. Dados dois processos estocásticos $ X $ e $ Y $ definidos no mesmo espaço de probabilidade $ (\Omega , \mathcal{F} , \mathbb{P}) $ dizemos que $ Y $ é uma modificação de $ X $ se $ \mathbb{P} [ X_t = Y_t ]=1 $ para todo $ t \in [0, \infty) $. Entretanto, antes de falarmos dessas modificações daremos uma breve introdução sobre espaços de Hölder e algumas de suas propriedades.

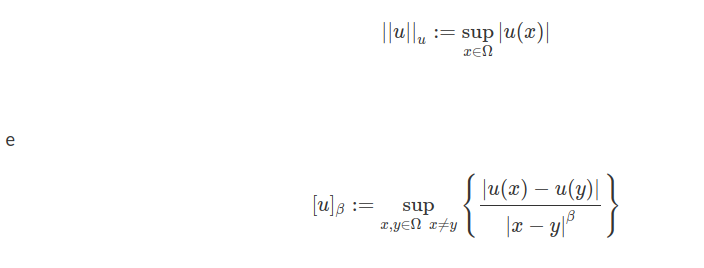

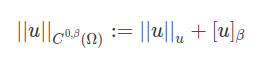

Espaço de Hölder

Seja $ \Omega $ um aberto de $ \mathbb{R}^d $, denotamos $ BC(\Omega) $ e $ BC(\overline{\Omega}) $ o conjunto das funções contínuas e limitadas em $ \Omega $ e $ \overline{\Omega} $ respectivamente, com $ \overline{\Omega} $ sendo o fecho de $ \Omega $. Identificaremos $ f\in BC(\overline{\Omega}) $ com $ f|_{\Omega}\in BC(\Omega) $, para $ u\in BC(\Omega) $ e $ 0< \beta \leq 1 $ seja

se $ [u]_{\beta}< \infty $ então u é dita Hölder-contínua com expoente de Hölder $ \beta $. A coleção de todas as funções contínuas $ \beta $-Hölder em $ \Omega $ é denotada por

$$ C^{0,\beta}(\Omega):=(u\in BC(\Omega): [u]_{\beta}< \infty ) $$

para $ u\in C^{0,\beta}(\Omega) $ seja

Definição 8.1.3

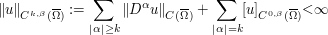

O espaço de Hölder $ C^{k,\beta}(\overline{\Omega}) $ consiste de todas as funções $ u\in C^k(\Omega) $ para os quais a norma

O espaço $ C^{k,\beta}(\overline{\Omega}) $ consiste das funções u, as quais tem a k-ésima derivada contínua, limitadas e com expoente de Hölder $ \beta $

Teorema 8.1.2

O espaço $ C^{k,\beta}(\overline{\Omega}) $ é Banach

Demonstração

Basta mostrarmos a completude do espaço, assim seja $ u_n\in C^{k,\beta}(\overline{\Omega}) $ uma sequência de Cauchy. Note que como o domínio é compacto e ainda $ u_n $ é limita e contínua. Então existe uma subsequência $ u_{n_k} $ a qual converge uniformemente para u, com u uma função limita de contínua em $ \overline{\Omega} $, pois limite uniforme de funções contínuas é contínua(lembre-se que se o limite não for uniforme isso não necessariamente é contínua). Assim utilizando o mesmo argumentos para as derivadas $ D^k u_n $ o resultado segue.

Lema 8.1.2

Seja $ u\in C^k(B_r) $, $ |\alpha|=k $. Então existe $ y\in B_r $, tal que

$$|D^{\alpha}u(y)|\leq \displaystyle \frac{(2k)^k}{r^k }|u|_{u}$$

Para obtermos uma versão do movimento browniano com trajetórias contínuas utilizaremos o teorema de Kolmogorov-Centsov, que nos fornece uma condição para que um processo estocástico tenha uma extensão contínua a partir de intervalos diádicos. Com esse teorema em mãos basta mostrarmos que o movimento Browniano satisfaça a condição imposta pelo teorema para obtermos a modificação contínua.

Teorema 8.1.3 (Kolmogorov-Centsov (1956))

Suponha que o processo $ X=(X_t; 0\leq t \leq T) $ definido no espaço de probabilidade $ (\Omega , \mathcal{F}, \mathbb{P}) $ satisfaça a seguinte condição

$$E[|X_t-X_s|^\alpha]\leq C |t-s|^{1+\beta},~ 0 \leq s,t\leq T,$$

para constantes positivas $ \alpha, \beta $ e $ C $. Então existe uma modificação com trajetórias contínuas, denotada por $ Y=(Y_t;~0 \leq s,t\leq T ) $ de X, o qual é localmente Hölder contínua com expoente $ \gamma $, para todo $ \gamma \in (0,\beta/\alpha) $, isto é

$$\displaystyle \mathbb{P}\left[\omega| \sup_{{0< t-s < h(\omega)~ s,t \in [0,T]}}\frac{|Y_t(\omega)-Y_s(\omega)|}{|t- s|^{\gamma}}\leq \delta \right]=1$$

no qual $ h(\omega) $ é uma variável aleatória positiva e $ \delta > 0 $ é uma constante apropriada.

Demonstração: Sem perda de generalidade vamos tomar $ T=1 $, apenas para facilitar os primeiros cálculos. Como consequência da desigualdade de Chebysev, temos que para qualquer $ \epsilon > 0 $, temos que:

$$\displaystyle P[|X_t-X_s|\geq \epsilon]\leq \frac{E[|X_t-X_s|^\alpha]}{\epsilon^{\alpha}}\leq \frac{C |t-s|^{1+\beta}}{\epsilon^{\alpha}}.$$

Como consequência, temos que $ X_s\rightarrow X_t $ em probabilidade quando $ s\rightarrow t $. Ao tomarmos $ t=k/2^n $, $ s=(k-1)/2^n $, e $ \epsilon = 2^{-\gamma n} $, no qual $ \gamma \in (0, \beta/\alpha) $, obtemos que

$$\displaystyle \mathbb{P}[|X_{k/2^n}-X_{(k-1)/2^n}|\geq 2^{-\gamma n}]\leq C2^{-n(1+\beta -\alpha\gamma)}.$$

Consequentemente temos que:

$$\displaystyle \mathbb{P}\left[\max_{1\leq k\leq 2^n}|X_{k/2^n}-X_{(k-1)/2^n}|\geq 2^{-\gamma n}\right]=\displaystyle \mathbb{P}\left[\bigcup_{k=1}^{2^n}|X_{k/2^n}-X_{(k-1)/2^n}|\geq 2^{-\gamma n}\right] \leq C2^{-n(1+\beta -\alpha\gamma)}.$$

Com isso, obtemos que

$$\displaystyle \sum_{n=1}^{\infty}\mathbb{P}\left[\max_{1\leq k\leq 2^n}|X_{k/2^n}-X_{(k-1)/2^n}|\geq 2^{-\gamma n}\right]\leq \sum_{n=1}^{\infty}C2^{-n(1+\beta -\alpha\gamma)}< \infty.$$

Logo, pelo lema de Borel-Cantelli, existe um conjunto $ \Omega^{\star}\in \mathcal{F} $ com $ \mathbb{P}(\Omega^{\star})=1 $, tal que para cada $ \omega\in \Omega^{\star} $,

$$\displaystyle \max_{1\leq k\leq 2^n}|X_{k/2^n}(\omega)-X_{(k-1)/2^n}(\omega)|< 2^{-\gamma n},~ n\geq n^{\star}(\omega), \quad (\star)$$

no qual $ n^{\star}(\omega) $ é uma variável aleatória assumindo valores inteiros positivos.

Agora, para cada $ n\geq 1 $, considere a partição $ D_n=((k/2^n))| k\in\mathbb{N}\cup (0)) $ formada pelos diádicos do intervalo $ [0,1] $. Seja $ D=\displaystyle \bigcup_{n=1}^{\infty}D_n $, o conjunto de todos os diádicos em $ [0,1] $. Ao fixarmos $ \omega \in \Omega^{\star}, ~n\geq n^{\star}(\omega) $, mostremos que para todo $ m> n $ temos que

$$|X_t(\omega)-X_s(\omega)|\leq 2 \displaystyle \sum_{j=n+1}^{m}2^{-\gamma j},~\forall t,s \in D_m, 0 < t-s < 2^{-n} \quad (\star \star).$$

Para $ m=n+1 $, temos como única possibilidade que $ t=(k/2^m) $ e $ s=((k-1)/2^m) $ e, assim, a desigualdade é consequência da equação $ (\star) $. Vamos mostrar que a desigualdade $ (\star \star) $ é válida através do princípio de indução.

Suponha que a equação $ (\star \star) $ seja válida para to $ n=n+1, \cdots , M-1 $. Tomamos $ s < t $ e $ s,t \in D_M $. Considere os número $ t^1 = \max ( u \in D_{M-1}: t \leq t) $ e $ s^1 = \max ( u \in D_{M-1} : u > s) $. Assim, obtemos as seguintes relações $ s \leq s^1 \leq t^1 \leq t $, $ s^1 - s \leq 2^{-M} $ e $ t-t^1 \leq 2^{-M} $. A partir da equação $ (\star) $, obemos que

$$\mid X_{s^1}(\omega) - X_s(\omega) \mid \leq 2^{-\gamma M} \quad \text{e} \quad \mid X_{t}(\omega) - X_{t^1}(\omega) \mid \leq 2^{-\gamma M}.$$

A partir da equação $ (\star \star) $ com $ m=M-1 $, concluímos que

$$ \mid X_t (\omega) - X_s (\omega) \mid \leq 2 ~\sum_{j=n+1}^{M-1} 2^{- \gamma j}.$$

Como consequência, obtemos $ (\star \star) $ é válido.

Mostremos agora que $ X=(X_t; t\in D) $ é uniformemente contínua em t para $ \omega \in \Omega^{\star} $. Para cada numero $ s,t\in D $ com $ 0< t-s < h(\omega)=2^{-n^{\star}(\omega)} $, selecionamos $ n\geq n^{\star}(\omega) $, tal que $ 2^{-(n+1)}\leq t-s < 2^{-n} $. Assim da desigualdade $ \star \star) $ temos que

$$|X_t(\omega)-X_s(\omega)|\leq 2 \displaystyle \sum_{j=n+1}^{\infty}2^{\gamma j}\leq \delta|t-s|^{\gamma}, ~ 0 < t-s < h(\omega)$$

no qual $ \delta=2/(1-2^{-\gamma}) $. Assim, temos que o processo é uniformemente contínuo em $ t \in D $ para $ \omega\in \Omega^{\star} $.

$$Y_t(\omega)=\lim_{s_n\rightarrow t}X_{s_n}.$$

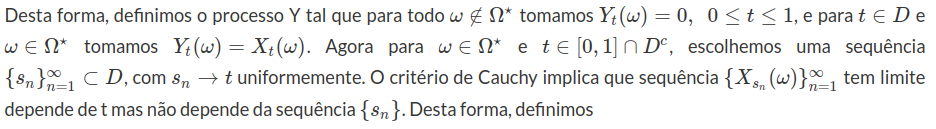

Para finalizar, vamos mostrar que $ Y $ é uma modificação de $ X $. Sabemos que $ \mathbb{P}[X_t = Y_t]=1 $ para todo $ t \in D $. Seja $ t \in [0,1] \cap D^c $ e $ (s_n) \subset D $ tal que $ s_n \rightarrow t $, então, temos que $ X_{s_n} \rightarrow X_t $ em probabilidade e, por definição, temos que $ X_{s_n} \rightarrow Y_t $ quase certamente. Como o limite é única, concluímos que $ \mathbb{P}[X_t = Y_t] $ para todo $ t \in [0,1] $. Portanto, obtemos o resultado.

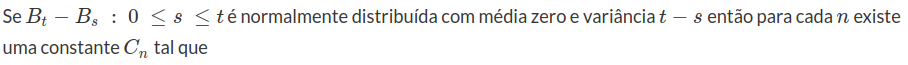

Proposição 8.1.1

$$ \mathbb{E} |B_t - B_s |^{2n} = C_n |t - s |^{n} $$

Demonstração

vamos tomar n = 1. Como o valor esperado de $ B_t - B_s $ é zero, a variância é igual ao segundo momento, assim,

$$\mathbb{E} |B_t -B_s |^2 = |t - s|.$$

A extensão para $ n > 1 $ é consequência de propriedades da distrbuição normal. Segue a proposição.

Como a Proposição 8.1.1 é válida, o teorema de Kolmogorov-Centsov nos garante que existe uma modificação do movimento browniano que é Hölder contínua. Então, existe uma modificação $ B^T $ de $ W $ tal que $ B^T $ tem trajetórias contínuas em $ [0,T] $. Tomamos

$$ \Omega_T = ( \omega : W_t(\omega) = B_t^T(\omega), ~ ~ \text{para todo número racional} ~ t \in [0,T] ) $$

tal que $ \mathbb{P}(\Omega_T)=1 $. Denotamos por

$$\tilde{\Omega} = \bigcap_{T=1}^\infty \Omega_T.$$

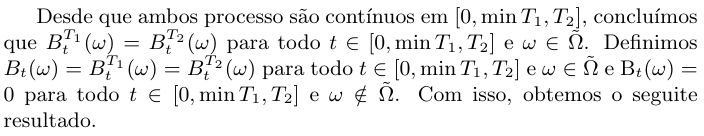

Para dois inteiros positivos $ T_1 $ e $ T_2 $, temos que

$$B^{T_1}_t (\omega) = B^{T_2}_t (\omega) , \quad \text{para todo número racional} ~ t \in [0, \min{T_1,T_2} ].$$

A seguir, apresentamos algumas propriedades do Movimento Browniano como a não diferenciabilidade em probabilidade.

Teorema 8.1.5

Com probabilidade 1, as trajetórias do Movimento Browniano não são diferenciáveis.

Demonstração: Vamos considerar, o caso unidimensional e, sem perda de generalidade no intervalo $ [0, 1) $. Suponha que $ (B_t )_{t \in [0, 1) } $ seja diferenciável em algum ponto $ t_0 $ no intervalo contendo $ [0, 1) $. Então em algum intervalo contendo $ t_0 $, devemos ter

$$ |B_t - B_{t_0 }| \leq K |t - t_0 | $$

para alguma constante k. Logo para pontos $ t_1 $ e $ t_2 $ suficiente próximos de $ t_0 $, temos pela desigualdade triangular, que

$$ | B_{t_1} - B_{t_2 } | \leq |B_{t_2 } - B_{t_0 }| + |B_{t_0 } - B_{t_1 }| \leq $$

$$ K(|t_2 - t_0 | + |t_0 - t_1 | ) ~~( \star )$$

Para $ i = 0, 1 e 2 $ e $ n \in \aleph $, definamos

$$t_2 (n, i) = \frac{\lfloor nt_0 \rfloor + i + 1}{n} ~e~ t_1 (n, i) = \frac{\lfloor nt_0 \rfloor + i }{n}$$

Assim, para i = 0, 1 e 2, temos que

$$\lim_{n \to \infty} t_2 (n, i) = \lim_{n \to \infty} t_1 (n, i) = t_0 $$

Portanto para n suficientemente grande, de acordo com $ \star $, temos que para i = 0, 1 e 2

$$\left |B_{\frac{\lfloor nt_0 \rfloor + i + 1}{n}} - B_{\frac{\lfloor nt_0 \rfloor + i}{n}} \right | \leq K \left ( \left |\frac{\lfloor nt_0 \rfloor + i + 1}{n} - t_0 \right | + \left | \frac{\lfloor nt_0 \rfloor + i}{n} - t_0 \right |\right ) $$

$$ \leq K \left ( \frac{i+1}{n} + \frac{i}{n} \right ) \leq \frac{5K}{n} $$

Portanto o evento $ (B_t )_{t\in [0,1)} $ é diferenciável em algum ponto $ t_0 \in [0,1) $ está contido no evento

$$A \equiv \bigcup_{k=1}^{\infty} \bigcup_{m=1}^{\infty} \bigcap_{n=m}^{\infty} \bigcup_{j=0}^{n-1} \bigcap_{i=0}^{2} \left ( \left | B_{\frac{j+i+1}{n} } - B_{\frac{j+1}{n}} \right | < \frac{5K}{n} \right ) $$

Mostraremos que A é união enumerável de eventos de probabilidade zero, de modo que concluímos que $ \mathbb{P}(A) = 0 $.

Para cada K seja

$$A_n^K \equiv \bigcup_{j=0}^{n-1} \bigcap_{i=0}^{2} \left ( \left | B_{\frac{j+i+1}{n} } - B_{\frac{j+1}{n}} \right | < \frac{5K}{n} \right ) $$

Então, A pode ser expresso como $ A = \bigcup_{k=1}^{\infty} (\liminf A_n^K ) $. Portanto basta mostrar que para cada K, $ \mathbb{P} (\liminf A_n^k ) = 0 $

$$\mathbb{P} [\liminf A_n^k] \leq \liminf \mathbb{P} [\bigcup_{j=0}^{n-1} \bigcap_{i=0}^{2} \left (\left | B_{\frac{j+i+1}{n} } - B_{\frac{j+1}{n}} \right | < \frac{5K}{n} \right ) ] \leq $$

$$ \leq \liminf \sum_{j=0}^{n-1} \mathbb{P} [\bigcap_{i=0}^{2} \left ( \left | B_{\frac{j+i+1}{n} } - B_{\frac{j+1}{n}} \right | < \frac{5K}{n} \right ) ] $$

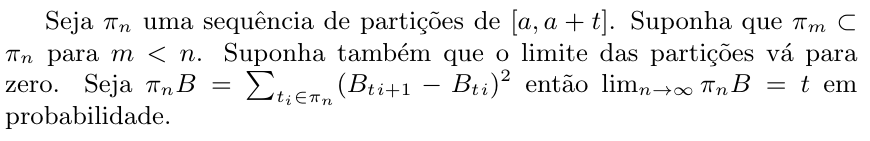

Teorema 8.1.6

Demonstração

tem distribuição qui-quadrado.

$$\mathbb{E} [(\pi_n B - t)^2]=\mathbb{E} [\sum (t_{i+1} - t_i )^2 (Z^2 -1)^2 ] = $$

$$ = \sum (t_{i+1} - t_i )^2 \mathbb{E}[(Z^2 - 1)^2 ] \leq \mathbb{E}[(Z^2 - 1)^2 ] \hbox{mesh} (\pi_n )t \to 0 $$

Corolário 8.1.2

O movimento browniano é um martingale

$$ \mathbb{E} [B_t | \mathcal{F_s} ] = \mathbb{E} [B_t - B_s + B_s | \mathcal{F_s} ] = \mathbb{E} [B_t - B_s ] + B_s = B_s $$

o resultado acima segue da mensurabilidade de $ B_s $ em relação a $ \mathcal{F_s} $ e da independência de $ (B_t - B_s ) $ de $ \mathcal{F_s} $.

Corolário 8.1.3

O valor esperado $ \mathbb{E} [B_t B_s ] $ é igual ao $ \min (t, s ) $

8.2 - Propriedades do Espaço $C[0,\infty)$

Construímos o movimento Browniano sobre o espaço $ \mathbb{R}^{[0,\infty)} $. O espaço canônico do movimento Browniano é o $ C[0,\infty) $ e devido as suas propriedades será mais conveniente utilizarmos esse espaço amostral. Além disso podemos introduzir a seguinte métrica no espaço $ C[0,\infty) $

$$\rho(\omega_1,\omega_2)=\displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)|\wedge 1)$$

Proposição 8.2.1

$ \rho $ é uma métrica sobre $ C[0,\infty) $ e ainda temos que $ C[0,\infty) $ um espaço métrico separável e completo.

Demonstração

i) $ \rho(\omega_1,\omega_2)\geq 0 $.

De fato, basta notar que é definido como soma de números positivos.

ii) $ \rho(\omega_1,\omega_2)= 0 \Leftrightarrow \omega_1=\omega_2 $.

De fato, note que:

$$\rho(\omega_1,\omega_2)= 0 \Leftrightarrow \displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)|\wedge 1)=0$$

$$\Leftrightarrow \displaystyle \frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)|\wedge 1)=0, ~\forall n\in\mathbb{N}$$

$$\Leftrightarrow \displaystyle (|\omega_1(t)-\omega_2(t)|\wedge 1)=0, ~\forall t\in[0,\infty)$$

$$\Leftrightarrow \omega_1=\omega_2$$

iii) $ \rho(\omega_1,\omega_2)=\rho(\omega_2,\omega_1) $

Basta notar que $ |\omega_1(t)-\omega_2(t)|=|\omega_2(t)-\omega_1(t)| $, o que implica no resultado

iv) $ \rho(\omega_1,\omega_3)\leq \rho(\omega_1,\omega_2)+\rho(\omega_2,\omega_1) $.

De fato, observe que

$$\rho(\omega_1,\omega_3)= \displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_3(t)|\wedge 1)$$

$$ =\displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)+\omega_2(t)-\omega_3(t)|\wedge 1)$$

$$ \leq \displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)|\wedge 1)+\max_{0\leq t\leq n}(|\omega_2(t)-\omega_3(t)|\wedge 1)$$

$$=\displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_1(t)-\omega_2(t)|\wedge 1)+\displaystyle \sum_{n=1}^{\infty}\frac{1}{2^n}\max_{0\leq t\leq n}(|\omega_2(t)-\omega_3(t)|\wedge 1)$$

$$=\rho(\omega_1,\omega_2)+\rho(\omega_2,\omega_1)$$

Portanto o resultado segue.

Teorema 8.2.1

Seja $ \mathfrak{C} $ a coleção de todos os cilindros finito dimensional definido como

$$C=(\omega\in C[0,\infty)|(\omega(t_1),\cdots, \omega(t_n))\in A),~n\geq 1, A\in \mathfrak{B}(\mathbb{R}^n)$$

com $ t_i\in[0,\infty), ~\forall i=1,\cdots n $. E denotamos por $ \mathfrak{G} $ a menor $ \sigma $-álgebra que contém $ \mathfrak{C} $ e ainda é a menor $ \sigma $-álgebra que contém todos os abertos de $ C[0,\infty) $

Demonstração

Primeiramente é importante definirmos os abertos de $ C[0,\infty) $, claro que como temos a nossa métrica, para definirmos os abertos basta definirmos as bolas. Assim dizemos que a bola de centro x e raio r é definida da seguinte forma

$$B(x,r)={y\in C[0,\infty)|p(x,y)< r}$$

Definimos um conjunto aberto da seguinte forma, dizemos que $ A\subset C[0,\infty) $ é um conjunto aberto se para todo $ \omega \in A $ existe um r tal que a bola $ B(\omega,r)\subset A $. Agora mostremos que $ \mathfrak{G}=\mathfrak{B}{(\mathbb{R}^n)} $, para isso temos que mostrar que $ \mathfrak{G}\subset\mathfrak{B}{(\mathbb{R}^n)} $ e que $ \mathfrak{G}\supset\mathfrak{B}{(\mathbb{R}^n)} $.

i) Mostremos primeiramente que qualquer $ \forall \omega_0\in C[0,\infty)\Rightarrow \omega_0\in C $, para algum $ C\in\mathfrak{C} $. De fato, basta escolhermos $ A\subset Im(\omega) $, com $ A\in\mathfrak{B}(\mathbb{R}) $ e escolhermos $ t=(t_1,\cdots,t_n) $, tal que $ t_i\in \omega_0^{-1}(A) $. Note que podemos fazer isso pois $ \omega_0 $ é contínua. E por fim tomamos

$$C=(\omega\in C[0,\infty)|(\omega(t_1),\cdots, \omega(t_n))\in A^n),~n\geq 1,~ A^n=(A\times\cdots\times A)\in \mathfrak{B}(\mathbb{R}^n)$$

então $ \omega_0 \in C $.

ii) Mostremos agora que $ \forall \omega \in C[0,\infty) $ e $ r\in \mathbb{R} $ temos que $ B(\omega,r)\in \mathfrak{G} $

9 - Processo de Lévy

Os processos de Lévy são utilizados para modelar o ruído em diversos tipos de aplicações. Em finanças, diversos estudos empíricos nos mostram que os processos de Lévy descrevem de forma mais realística o mercado financeiro do que modelos baseados somente no movimento browniano. No nundo “real”, observamos que o preço de diversos ativos apresentam saltos. Além disso, a distribuição empírica de ativos financeiros apresentam assimetria e curtose alta e com isso, desviam da tradicional distribuição normal. Em função disso, os processos de Lévy são uma alternativa importante na modelagem de diversos problemas reais. Neste módulo, vamos estudar a classe dos processos de Lévy e apresentar diversas aplicações em finanças.

-

$ X $ tem incrementos independentes, isto é, $ X(t) - X(s) $ é independente de $ \mathcal{F_s} $ para qualquer $ 0 \leq s< t \leq T $.

-

$ X $ é contínuo em probabilidade, isto é, para todo $ 0 \leq t\leq T $ e $ \epsilon> 0 $, temos que

$$\lim_{s \rightarrow t} \mathbb{P} (\mid X(t) - X(s) \mid > \epsilon)=0$$

.

Como consequência da condição (1), para qualquer $ 0 \leq t_0 < t_1 < \cdots < t_n $ temos que

$$X(t_0), X(t_1) - X(t_2), \cdots , X(t_n)-X(t_{n-1})$$

são variáveis aleatórias independentes. Esta propriedade de que incrementos de intervalos disjuntos são independentes é equivalente ao fato que o processo $ X $ tem incrementos independentes com respeito a filtragem interna de $ X $. A condição (2) não implica que o processo de Lévy tenha trajetórias contínuas. Por exemplo, o processo de Poisson satisfaz a condição (2). Esta condição serve para excluir os processos estocásticos com saltos em tempos determinísticos.

- Dizemos que o processo $ X $ tem incrementos estacionários se, para tod $ 0 \leq s < t \leq T $, a distribuição da variável aleatória $ X(t)-X(s) $ depende somente de $ t-s $.

Um processo $ X $ com incrementos independentes é denominado homogêneo se este tem incrementos estacionários. De forma geral, vamos estudar processos de Lévy não homogênos. Os exemplos elementares de processos de Lévy são o processo de Poisson e o movimento browniano.

9.1 - Processo de Lévy

Nesta seção, vamos apresentar as propriedades básicas dos processos de Lévy (incrementos independentes e contínuo em probabilidade). Inicialmente, mostraremos que todo processo de Lévy tem uma modificação com trajetórias contínuas à direta e com limite à esquerda (cadlag). Como consequência, sempre que nos referirmos a um processo de Lévy assumiremos que estamos lidando com a modificação de trajetórias cadlag. Na sequência, vamos estudar a filtragem relacionada com o processo de Lévy. Neste módulo, mostraremos que a filtragem interna do processo de Lévy, devidamente completada, é contínua à direita.

Para qualquer processo de Lévy $ X $ denotamos por $ \varphi_{s,t} $ a função característica do incremento $ X(t)-X(s) $ com $ s\leq t $:

$$\varphi_{s,t}(u)=E[\exp(iu(X(t)-X(s)))],\quad u \in \mathbb{R}.$$

Como os incrementos são independentes temos que

$$\varphi_{r,s}(u)\varphi_{s,t}(u)=\varphi_{r,t}(u),~r\leq s\leq t.$$

Além disso, como o processo $ X $ é estocasticamente contínuo (ou seja contínuo em probabilidade) temos que $ \varphi_{s,t}(u) $ é uma função contínua em $ s,t $ e u.

Lema 9.1.1

Seja $ X $ um processo de Lévy. Então para todo $ u\in\mathbb{R} $, $ s,t\in [0,T] $ e $ s< t $ temos que

$$\varphi_{s,t}(u)\neq 0.$$

Demonstração

Seja $ t_0=\inf(t\geq s:\varphi_{s,t}(u)=0) $. Desde $ \varphi_{s,s}=1 $, logo $ t_0> s $. Assim, é suficiente mostrarmos que $ t_0=\infty $. Suponha que $ t_0< \infty $, então

$$\varphi_{s,t}\varphi_{t,t_0}=0~s< t< t_0.$$

Como $ \varphi_{s,t}(u)\neq 0 $, temos que $ \varphi_{t,t_0}=0 $. Da propriedade de continuidade temos que $ \varphi_{t_0,t_0}=0 $, o que contradiz o fato de que $ \varphi_{t_0,t_0}=1 $, logo o resultado segue.

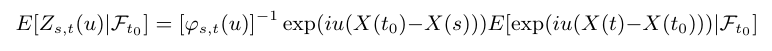

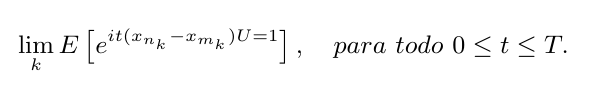

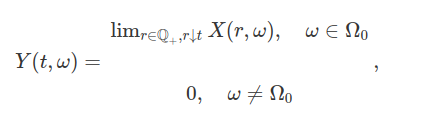

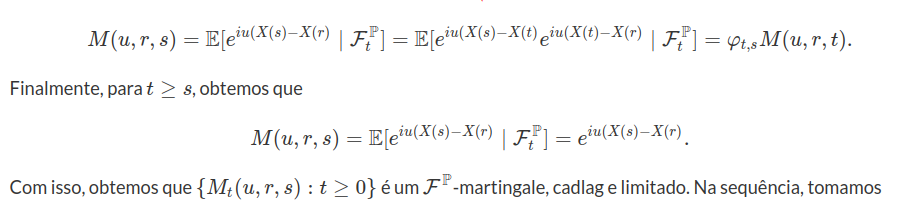

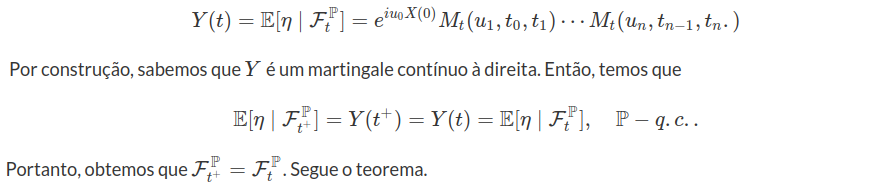

Teorema 9.1.1

Seja $ X $ um processo de Levy. Definimos

$$Z_{s,t}(u)=[\varphi_{s,t}(u)]^{-1}\exp(iu (X(t)-X(s))),~s\leq t.$$

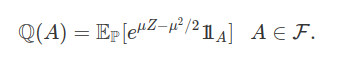

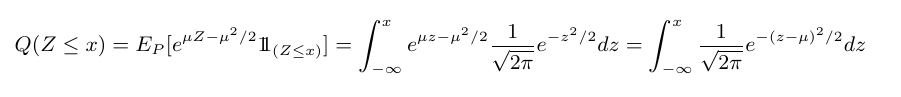

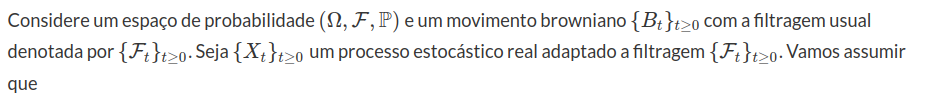

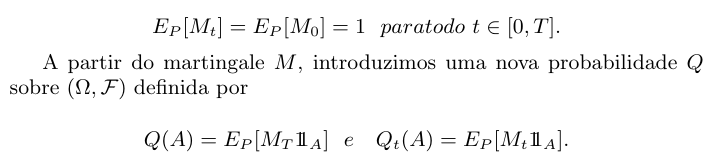

Então $ (Z_{s,t}(u) : t\geq s) $ é um $ (\mathcal{F_t}:t\geq s) $-martingale.