20. Séries Temporais

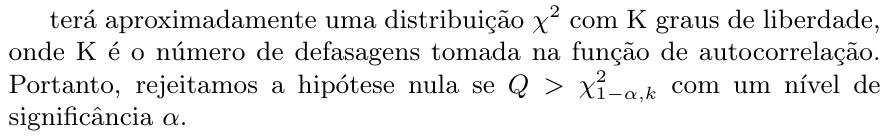

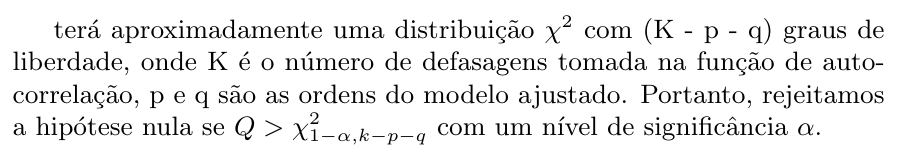

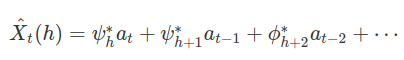

1 - Introdução

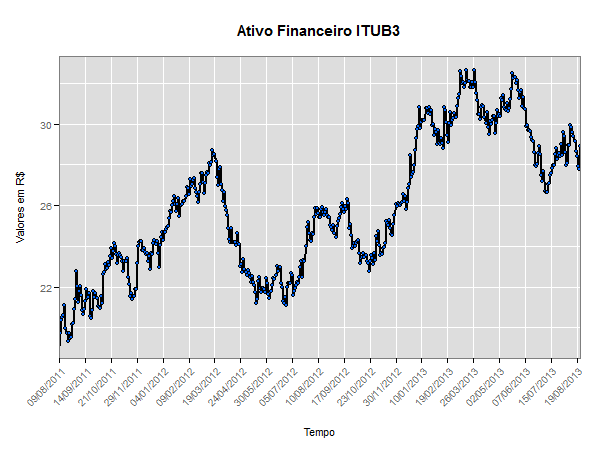

Uma série temporal é um conjunto de observações ordenadas no tempo. Alguns exemplos de séries temporais são:

- valores diários de poluição em uma cidade;

- valores mensais de temperatura registrados em uma cidade;

- índices diários da Bolsa de Valores de São Paulo;

- acidentes ocorridos nas rodovias da cidade de São Paulo durante um mês.

Os modelos utilizados para descrever séries temporais são processos estocásticos, isto é, processos controlados por leis probabilísticas.

Temos na literatura um número muito grande de modelos diferentes para descrever o comportamento de uma série particular. A construção destes modelos depende de vários fatores, tais como o comportamento do fenômeno ou o conhecimento a priori que temos de sua natureza e do objetivo da análise.

1.1 - Estacionariedade

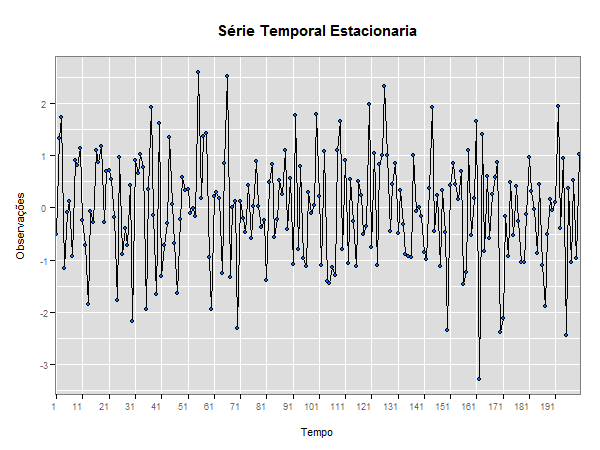

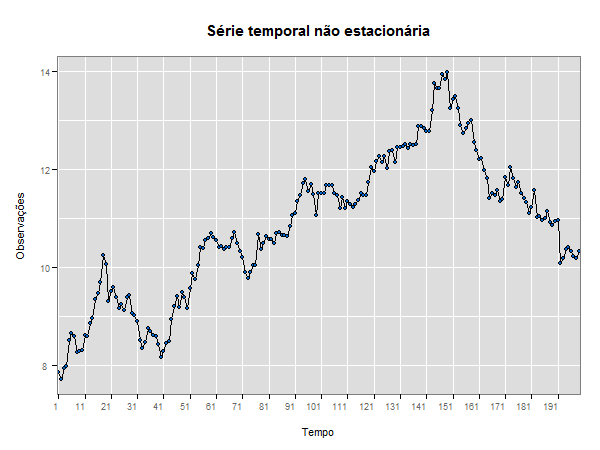

Uma série temporal é dita estacionária quando ela se desenvolve no tempo aleatoriamente ao redor de uma média constante, refletindo alguma forma de equilíbrio estável. Na prática, a maioria das séries que encontramos apresentam algum tipo de não estacionariedade, por exemplo, tendência.

Uma série pode ser estacionária por períodos curtos ou longos, o que implica uma mudança de nível e/ou inclinação. A classe dos modelos ARIMA será capaz de descrever de maneira satisfatória séries estacionárias e séries não estacionárias que não apresentem um comportamento explosivo. Este tipo de não estacionariedade é chamado homogêneo, quando a série pode ser estacionária, flutuando ao redor de um nível, por um certo tempo, depois mudar de nível e flutuar ao redor de um novo nível e assim por diante, ou então mudar de inclinação.

A maioria dos procedimentos de análise estatística de séries temporais supõe que estas sejam estacionárias, portanto, será necessário transformar os dados originais se estes não formam uma série estacionária. A transformação mais comum consiste em tomar diferenças sucessivas da série original, até se obter uma série estacionária. A primeira diferença Z(t) é definida por

$$\Delta Z(t) = Z(t) - Z(t - 1)$$

então, a segunda diferença é

$$\Delta^2 Z(t) = \Delta[\Delta Z(t)] = \Delta[Z(t) - Z(t - 1)]$$

$$\Delta^2 Z(t) = Z(t) - 2Z(t - 1) + Z(t - 2)$$

De modo geral, a n-ésima diferença de Z(t) é

$$\Delta^n Z(t) = \Delta[\Delta^{n-1} Z(t)]$$

Normalmente, será suficiente tomar uma ou duas diferenças para que a série se torne estacionária.

1.2 - Processos Estocásticos

Definição 1.2.1

Seja $ T $ um conjunto arbitrário. Um processo estocástico é uma família $ Z = (Z(t), t \in T) $, tal que, para cada $ t \in T $, Z(t) é uma variável aleatória.

Nestas condições, um processo estocástico é uma família de variáveis aleatórias, que supomos definidas num mesmo espaço de probabilidades (Ω, A, P). O conjunto $ T $ é normalmente tomado como o conjunto dos inteiros $ Z $ = {±1, ±2, ±3,…}.

Para dizermos que um processo estocástico está especificado necessitamos de certas condições. Sejam $ t_1 $, $ t_2 $,…, $ t_n $ elementos quaisquer de $ T $ e consideremos

$$F(z_1, \dots,z_n;t_1, \dots ,t_n) = P[Z(t_1) \le z_1, \dots ,Z(t_n) \le z_n]$$

Então, o processo estocástico $ Z = (Z(t), t \in T) $ estará especificado se conhecermos as distribuições finito-dimensionais, para todo n ≥ 1. As funções de distribuição devem satisfazer as duas condições seguintes:

- (Condição de Simetria) para qualquer $ j_1 $,…,$ j_n $, dos índices 1,2,…,n temos:

$$F(z_{j_n}, \dots ,z_{j_1};t_1, \dots ,t_n) = F(z_1, \dots ,z_n;t_1, \dots ,t_n)$$

- (Condição de Compatibilidade) para m < n,

$$F(z_1, \dots ,z_m,+ \infty , \dots ,- \infty ;t_1, \dots ,t_m,t_{m+1}, \dots ,t_n) = F(z_1, \dots ,z_m;t_1, \dots ,t_m)$$

Exemplo 1.2.1

Consideramos {$ X_n $, n = 1,2,…} uma sequência de v.a. definidas no mesmo espaço amostral Ω. Aqui, $ T $ = {1,2,…} e temos um processo com parâmetro discreto, ou uma sequência aleatória. Para todo n ≥ 1, podemos escrever

$$P[X_1 = a_1, \dots , X_n = a_n] = P[X_1 = a_1]P[X_2 = a_2|X_1 = a_1] \times \dots \times$$

$$P[X_n = a_n|X_1 = a_1, \dots, X_{n-1} = a_{n-1}].$$

Aqui, os $ a_j $’s representam os estados do processo e o espaço dos estados pode ser tomado como o conjunto dos reais. O caso mais simples é aquele em que temos uma sequência {$ X_n $, n ≥ 1} de v.a. mutuamente independentes e neste caso temos

$$P[X_1 = a_1, \dots , X_n = a_n] = P[X_1 = a_1] \dots P[X_n = a_n].$$

Este exemplo é conhecido como Sequência Aleatória.

Exemplo 1.2.2

Considere uma sequência aleatória $ {\varepsilon_t \ge 1} $ com v.a. i.i.d. $ (\mu_{\varepsilon} , \sigma^2_{\varepsilon}) $. Defina a sequência

$$X_t = \varepsilon_1 + \dots + \varepsilon_t.$$

Segue-se que $ E(X_t) = t\mu_{\varepsilon} $ e $ Var(X_t) = t\sigma_{\varepsilon} $, ou seja, ambas dependem de t.

Esse exemplo é conhecido como Passeio Aleatório, e têm grande importância em econometria e finanças.

1.3 - Processos Estácionarios

Dizemos que um processo é estacionário se todas as características do comportamento do processo não são alterados no tempo, ou seja, o processo se desenvolve no tempo em torno da média, de modo que a escolha de uma origem dos tempos não é importante.

Definição 1.3.1

Um processo estocástico $ Z = (Z(t), t \in T) $ diz-se estritamente estacionário se todas as distribuições finito-dimensionais permanecem as mesmas sob translações no tempo, ou seja,

$ F(z_1, \dots , z_n;t_1 + \tau , \dots , t_n + \tau) = F(z_1, \dots , z_n;t_1, \dots , t_n), $ para quaisquer $ t_1, \dots , t_{n +\tau} $ de $ T $.

Em particular, se um processo é estritamente estacionário significa que todas as distribuições unidimensionais são invariantes sob translações do tempo, logo a média $ \mu (t) $ e variância $ V(t) $ são constantes, isto é,

$ \mu (t) = \mu, \hspace{0.3cm} V(t) = \sigma^2, $ para todo $ t \in T $.

Definição 1.3.2

Dizemos que um processo estocástico $ Z(t) = (Z(t), t \in T) $ é fracamente estacionário ou estacionário de segunda ordem se e somente se

(i) $ E[Z(t)] = \mu (t) = \mu $, constante, para todo $ t \in T $;

(ii) $ E[Z^2(t)] < \infty $, para todo $ t \in T $;

(iii) $ \gamma (t_1,t_2) = Cov[Z(t_1), Z(t_2)] $ é uma função de $ |t_1 - t_2| $.

Denominaremos simplesmente por processo estacionário quando o processo for fracamente estacionário. Iremos tratar de modelos que são apropriados para os processos estacionários homogêneos, isto é, processos cujo nível e/ou inclinação mudam com o decorrer do tempo. Tais processos podem tornar-se estacionários por meio de diferenças sucessivas.

Definição 1.3.3

Um processo estocástico $ Z = (Z(t), t \in T) $ diz-se Gaussiano (ou normal) se para qualquer conjunto $ t_1 $,$ t_2 $,…,$ t_n $ de $ T $, as v.a. Z($ t_1 $),…,Z($ t_n $) tem distribuição normal n-variada.

Se um processo for Gaussiano (ou normal) ele será determinado pelas médias e covariâncias; em particular, se ele for estacionário de segunda ordem, ele será estritamente estacionário.

Função de Autocovariância

Seja $ (X_t, t \in Z) $ um processo estacionário real discreto de média zero, sua função de autocovariância (f.a.c.v.) é definida por $ \gamma_{\tau} = E[X_tX_{t + \tau}] $.

Proposição 1.3.1

A facv $ \gamma_{\tau} $ deve satisfazer as seguintes propriedades:

(i) $ \gamma_0 > 0 $;

(ii) $ \gamma_{-\tau} = \gamma_{\tau} $;

(iii) $ |\gamma_{\tau}| \le \gamma_o $;

(iv) $ \gamma_{\tau} $ é não negativa definida, tal que $ \sum^{n}_{j = 1} \sum^{n}_{k = 1}a_ja_k\gamma_{\tau_j - \tau_k} \ge 0, $

para quaisquer números reais $ a_1, \dots , a_n, $ e $ \tau_1, \dots , \tau_n $ de $ Z $.

Prova

(i) e (ii) decorrem imediatamente da definição de $ \gamma_{\tau} $.

(iii) Basta notarmos que

$$E[X_{t + \tau} \pm X_t]^2 = E[X^2_{t + \tau} \pm 2X_{t + \tau}X_t + X^2_t] \ge 0$$

mas, sabemos que

$$X^2_{t + \tau} \pm 2X_{t + \tau}X_t + X^2_t = \gamma^2 \pm 2\gamma_{\tau} + \sigma^2 \ge 0$$

ou seja,

$$2\gamma_0 \pm 2\gamma_{\tau} \ge 0 \Longrightarrow |\gamma_{\tau}| \le \gamma_0$$

.

(iv) Temos que

$$\sum_{j = 1}^{n} \sum_{k = 1}^{n} a_ja_k\gamma_{\tau_j - \tau_k} = \sum_{j = 1}^{n} \sum_{k = 1}^{n} a_ja_kE[X_{\tau_j}X_{\tau_k}] = E[\sum_{j = 1}^{n} a_jX_{\tau_j}]^2 \ge 0$$

Note que a facv de um processo estacionário tende a zero quando $ |\tau| \rightarrow 0. $

Função de Autocorrelação

A função de autocorrelação do processo é definida por

$$\rho_{\tau} = \dfrac{\gamma_{\tau}}{\gamma_0}, \tau \in Z$$

e possui as mesmas propriedades da função de autocovariância $ \gamma_{\tau} $, exceto que agora temos $ \rho_0 = 1 $.

A função de autocorrelação é utilizada para identificarmos um modelo adequado para a série temporal.

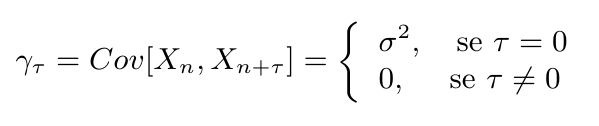

Exemplo 1.3.1

Voltando ao Exemplo 1.2.1, temos uma sequência aleatória. Se as v.a.$ X_1 $,$ X_2 $, … tiverem todas a mesma distribuição, teremos então uma sequência de v.a. independentes e identicamente distribuídas. Neste caso, o processo $ X_n $ é estacionário. Se $ E[X_n] = \mu $ e $ Var[X_n] = \sigma^2 $, para todo $ n \ge 1 $, então temos

Portanto, segue que $ \rho_{\tau} = 1 $, para $ \tau = 0 $ e $ \rho_{\tau} = 0 $, caso contrário.

Exemplo 1.3.2

Dando continuidade ao Exemplo 1.2.2 temos um Passeio Aleatório. Então, temos que $ E[X_t] = t\mu_{\varepsilon} $ e $ Var[X_t] = t\sigma^2_{\varepsilon} $. Podemos notar que se trata de um processo não estacionário, pois a média e a variância dependem de t. Calculando a função de autocovariância temos

$$Cov[X_t, X_{t - k}] = Cov[\varepsilon_1 + \dots + \varepsilon_{t-k} + \dots + \varepsilon_t , \varepsilon_1 + \dots + \varepsilon_{k-t}] = (t - k)\sigma_{\varepsilon}^2$$

assim, a função de autocorrelação fica

$$\rho_t = \dfrac{t - k}{t}.$$

Operador de Retardo

Considere um processo MA(q), podemos expressa-lo utilizando um operador de retardo, denotado por B, definido por

$$B^jX_t = X_{t-j}$$

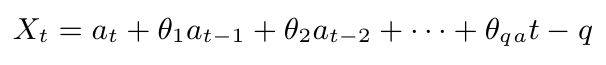

Então, podemos reescrever

$$X_t = (1 + \theta_1B + \theta_2B^2 + \cdots + \theta_qB^q)a_t = \theta(B)a_t$$

onde $ \theta(B) $ é um polinômio de ordem q em B. Dizemos que um processo MA(q) é inversível se as raízes da equação

$$\theta (B) = 1 + \theta_1B + \theta_2B^2 + \cdots + \theta_qB^q = 0$$

estiverem fora do círculo unitário, ou seja, dado $ b_1, \dots, b_q $ soluções de $ \theta(B) = 0 $ então o processo será inversível se $ |b_j| > 1, j = 1,\dots,q $, dizemos então que o processo é estacionário.

No caso de um processo AR(p)

$$X_t = \phi_0 + \phi_1X_{t-1} + \phi_pX_{t-p} + a_t$$

Utilizando o resultado de que um processo AR(p) pode ser escrito como um processo MA infinito com coeficientes $ \omega_0 , \omega_1, \dots $, ou seja

$$X_t = \omega_0a_t + \omega_1a_{t-1} + \cdots = (\omega_0 + \omega_1B + \omega_2B^2 + \cdots)a_t = \omega(B)a_t$$

segue que um processo AR(p) será estacionário se $ \sum_j \omega_j^2 < \infty $. Os $ \omega_j $ podem ser determinados por

$$\omega_0 = 1$$

$$\omega_1 = \omega_0\phi_1$$

$$\omega_2 = \omega_1\phi_1 + \omega_0\phi_2$$

$$ \quad \vdots $$

$$\omega_i = \sum_{j=1}^i \omega_{i-j}\phi_j$$

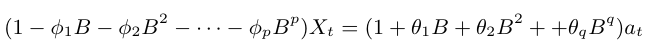

Em um modelo misto ARMA(p,q), utilizando o operador de retardo, podemos escrever

$$X_t = \phi_1X_{t-1} + \cdots \phi_pX_{t-p} + a_t + \theta_1a_{t-1} + \cdots + \theta_qa_{t-q}$$

ou seja,

$$\phi(B)X_t = \theta(B)a_t$$

Os valores de $ \phi_1, \dots, \phi_p $ que tornam o processo estacionário são tais que as raízes de $ \phi(B) = 0 $ estão fora do círculo unitário. Analogamente, os valores de $ \theta_1, \dots, \theta_q $ que tornam o processo inversível são tais que as raízes de $ \theta(B) = 0 $ estão fora do círculo unitário.

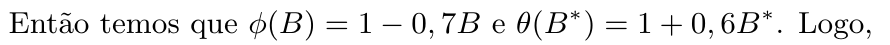

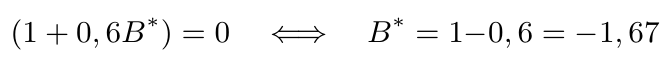

Exemplo 1.3.3

Considere um processo ARMA(1,1) dado por $ X_t = 0,7X_{t-1} + a_t + 0,6a_{t-1} $. Vamos analisar se este processo é estacionário e inversível.

Escrevendo em forma dos operadores de retardo temos

$$(1 - 0,7B)X_t = (1 + 0,6B^*)a_t$$

$$(1 - 0,7B) = 0 \quad \Longleftrightarrow \quad B = \dfrac{1}{0,7} = 1,43$$

Concluímos que o processo é estacionário e inversível.

1.4 - Testes de Estacionariedade

Grande parte dos recursos para séries temporais foram elaborados utilizando o conceito de estacionariedade nas séries. Uma forma geral para analisar este fato é fazendo um estudo da existência de alguma raiz dos operadores de retardos dentro do círculo unitário, denominada simplesmente por raiz unitária.

Portanto, utilizamos testes de hipóteses que em geral, possui as seguintes hipóteses:

$$H_0=\text{Existe pelo menos uma raiz dentro do círculo unitário}$$

$$H_1=\text{Não existem raízes dentro do círculo unitário}$$

Apresentamos a seguir três testes de raiz unitária, cada um com suas particularidades. Em um contexto geral, o ideal é aplicar os testes em conjunto para ter a certeza da estacionariedade da série.

1.4.1 - Teste de Dickey-Fuller Aumentado

O teste de Dickey-Fuller Aumentado é conhecido na literatura como teste ADF(Augmented Dickey-Fuller) e requer o estudo sobre a seguinte regressão:

$$\Delta y_t = \beta_1 + \beta_2t + \delta y_{t-1} + \sum^m_{i=1}\alpha_i \Delta y_{t-i} + \varepsilon_t$$

onde $ \beta_1 $ é o intercepto, também denominado como drift da série; $ \beta_2 $ é o coeficiente de tendência; $ \delta $ é o coeficiente de presença de raiz unitária e m é o número de defasagens tomadas na série.

Neste caso a hipótese nula é dada por $H_0: \delta = 0$

Fazemos uma regressão de $ \Delta y_t $ em $ y_{t-1}, \Delta y_{t-1}, \dots, \Delta y_{t+p-1} $ e calculamos a estatística T dada por

$$T = \dfrac{\hat{\delta}}{se(\hat{\delta})}$$

onde $ \hat{\delta} $ é um estimador para $ \delta $ e, $ se(\hat{\delta}) $ é um estimador para desvio padrão do erro de $ \delta $.

Os valores críticos da estatística $ T $ foram tabelados por Dickey e Fuller através de simulação Monte Carlo e variam nos casos de presença somente de intercepto, presença somente de tendência e presença de ambos.

1.4.2 - Teste de Phillips - Perron

O teste de Phillips - Perron, conhecido na literatura como teste PP é uma generalização do teste de Dickley - Fuller para os casos em que os erros $ (\varepsilon_t)_{t \in \mathbb{Z}} $ são correlacionados e, possivelmente, heterocedásticos. Então, vamos estudar a seguinte regressão

$$\Delta y_t = \beta_1 + \beta_2t + \delta y_{t-1} + \sum^m_{i=1}\alpha_i \Delta y_{t-i} + \varepsilon_t$$

Neste caso, a estatística $ Z $ é calculada por

$$Z = n \hat{\delta_n} - \dfrac{n^2\hat{\sigma}^2}{2s^2_n}\Bigg( \hat{\lambda_n}^2 - \hat{\gamma_{0,n}} \Bigg)$$

onde

$$\hat{\gamma_{j,n}} = \dfrac{1}{n} \sum^n_{i=1+j} r_ir_{i-j}$$

$$\hat{\lambda_n}^2 = \hat{\gamma_{0,n}} + 2\sum^q_{j = 1}\Bigg(1 - \dfrac{j}{q+1}\Bigg) \hat{\gamma}_{j,n}$$

$$s^2_n = \dfrac{1}{n-k} \sum^n_{i = 1} r_i^2$$

em que $ r_i $ representa o resíduo em $ y_i $ utilizando estimadores de mínimos quadrados, k é o número de covariáveis na regressão e, q é o número de defasagens utilizadas para calcular $ \hat{\lambda}^2_n $.

Note que $ Z $ trata-se de um ajuste na estatística de Dickley - Fuller. Caso o processo seja não correlacionado temos covariâncias nulas e neste caso, $ \hat{\lambda}^2_n = \hat{\gamma}_{0,n} $. Se o processo não for heterocedástico temos que $ se(\delta) = 1/n $ e então $ Z $ é dada por

$$Z = n\hat{\delta}= \dfrac{\hat{\delta}}{se(\hat{\delta})}$$

isto é, $ Z $ é a estatística de Dickley - Fuller e portanto, tem a mesma distribuição da estatística do teste ADF, calculada por Dickley - Fuller através de simulação de Monte Carlo.

1.4.3 - Teste KPSS

Teste criado por Denis Kwiatkowski , Peter C. B. Phillips, Peter Schmidt e Yongcheol Shin, denominado teste KPSS devido a seus nomes, tem por finalidade determinar estacionariedade em uma série temporal.

As hipóteses do teste são

$ H_0 = $ “A série é estacionária”

$ H_1 = $ “A série apresenta raiz unitária”

Note que as hipóteses deste teste não são iguais aos testes de Dickley - Fuller e Phillips - Perron para estacionariedade. A hipótese nula deste teste é igual às hipóteses alternativas nos testes anteriores.

Seja $ X_t, t = 1,2,\dots,N $ as observações de uma série temporal a qual queremos testar sua estacionariedade. Suponha que podemos decompor a série em componentes de tendência, passeio aleatório e erro

$$X_t = \xi t + r_t + \varepsilon_t$$

onde $ r_t $ é o passeio aleatório

$$r_t = r_{t-1} + \mu_t$$

com $ \mu_t $ i.i.d com média zero e variância $ \sigma_{\mu}^2 $.

Considere agora, $ e_t $, t = 1,2, … , N os resíduos de uma regressão em y explicado pelas componentes de tendência, passeio aleatório e intercepto. Denominamos $ \hat{\sigma_{\varepsilon}}^2 $ um estimador para a variância dos erros nesta regressão, isto é, $ \hat{\sigma_{\varepsilon}}^2 = \dfrac{SQE}{N} $. Definimos a soma parcial dos resíduos por

$$S_t = \sum^t_{i = 1} e_t, \quad t = 1, 2, \dots, T$$

então, a estatística do teste é dada por

$$LM = \sum^N_{t = 1} \dfrac{S_t^2}{N^2 \hat{\sigma}_{\varepsilon}^2}$$

É possível mostrar que a estatística $ LM $ tem distribuição que converge assintoticamente para um Movimento Browniano em que seus valores críticos são tabelados.

Para mais detalhes acesse o artigo de Kwiatkowski, Phillips, Schmidt e Shin no Journal of Econometrics em 1992.

1.5 - Modelos Para Séries Temporais

Estudaremos modelos paramétricos para séries temporais, ou seja, modelos que o número de parâmetros é finito.

Nestes modelos a análise é feita no domínio do tempo. Os mais frequentemente usados são os modelos de erro ( ou de regressão), os modelos autorregressivos e de médias móveis(ARMA) e os modelos autorregressivos integrados e de médias móveis(ARIMA).

Modelos de erro ou de regressão

Podemos escrever uma série temporal observada na seguinte forma

$ Z_t = f(t) + a_t, \quad t = 1, 2, \dots , N, $ onde $ f(t) $ é chamada sinal e $ a_t $ ruído.

Neste modelo o sinal $ f(t) $ é uma função do tempo completamente determinada e $ a_t $ é uma sequência aleatória, independente de $ f(t) $. Supõe-se que as v.a. $ a_t $ sejam não correlacionadas, tenham média zero e variância constante, isto é,

$$E[a_t] = 0, \forall t, \quad E[a^2_t] = \sigma^2_a, \forall t, \quad E[a_ta_s] = 0, s\neq t.$$

A série $ a_t $ com as características acima é conhecida como ruído branco.

Modelos ARMA

Para descrever o comportamento de séries econômicas e sociais, onde os erros observados são autocorrelacionados utilizamos modelos ARMA. Estes modelos são úteis nestes casos, uma vez que o fato de serem autocorrelacionados influencia na evolução do processo.

Há três casos particulares de modelos ARIMA que estudaremos:

- processo autorregressivo de ordem p: AR(p);

- processo de médias móveis de ordem q: MA(q)

- processo autorregressivo e de médias móveis de ordens p e q: ARMA(p,q).

Podemos generalizar estes processos de maneira adequada pelos chamados modelos autorregressivo integrados e de médias móveis de ordem p, d e q: ARIMA(p,d,q), em que d representa a inclusão de um operador sazonal.

Note que podemos descrever os três processos através do ARIMA. Por exemplo, um processo autorregressivo de ordem p, AR(p), pode ser escrito como ARIMA(p,0,0).

2 - Tendência e Sazonalidade

Na tentativa de descrever o comportamento de uma série temporal, utilizamos a decomposição da série original em três séries temporais, tendência, sazonalidade e uma componente aleatória, conhecida também como nível.

Seja {$ Z_t $, t = 1, … ,N} as observações de uma série temporal. Podemos decompor $ Z_t $ em duas formas.

Modelo aditivo

$$Z_t = T_t + S_t + a_t.$$

Modelo multiplicativo

$$Z_t = T_t \ast S_t \ast a_t,$$

onde $ T_t $ e $ S_t $representam a tendência e sazonalidade, respectivamente, enquanto $ a_t $ é uma componente aleatória, de média zero e variância $ \sigma_a^2 $.

O principal objetivo será estimar $ S_t $ e $ T_t $ e construir uma série livre de sazonalidade ou sazonalmente ajustada e sem tendência. Estimando-se $ S_t $ e $ T_t $ e subtraindo de $ Z_t $ obteremos uma estimativa da componente aleatória $ a_t $.

Em geral, as componentes $ T_t $ e $ S_t $ são bastante relacionadas e a influência da tendência sobre a componente sazonal pode ser muito forte.

2.1 - Tendências

Suponha inicialmente que a componente sazonal não esteja presente, então consideraremos o seguinte modelo

$$Z_t = T_t + a_t$$

onde $ a_t $ é uma variável aleatória com média zero e variância $ \sigma^2_a $. Alguns dos métodos mais utilizados para estimar $ T_t $ consistem em:

(i) ajustar uma função do tempo, como um polinômio ou uma exponencial;

(ii) suavizar os valores da série ao redor de um ponto, para estimar a tendência naquele ponto;

(iii) suavizar os valores da série através de sucessivos ajustes de retas de mínimos quadrados ponderados;

Após estimado a tendência em $ \hat T_t $ podemos ter a série ajustada para tendência ou livre de tendência,

$$Y_t = Z_t - \hat T_t.$$

Um procedimento que é normalmente utilizado para remover tendências é tomar sucessivas diferenças da série original até encontrar uma série estacionária.

$$\Delta Z_t = Z_t - Z_{t-1}$$

Para mais detalhes sobre como calcular uma estimativa da tendência $ \hat T_t $ consulte o livro: Análise de séries temporais(2006) / Pedro A. Morettin, Célia M. C. Toloi.

2.2 - Testes para tendência

Existe alguns testes não paramétricos úteis para detectar se há tendência em um conjunto de observações. Porém, estes testes em geral se baseiam em hipóteses que podem não estar verificadas no caso de uma série temporal, por exemplo, supor que as observações são independentes.

É necessário estar atento se existe outra componente (como $ S_t $) na série, além de $ T_t $. Precisamos eliminar esta componente antes de testar $ T_t $, pois há uma grande influência de outras componentes sobre a tendência.

Portanto, é necessário cautela ao utilizar estes testes.

2.2.1 - Teste de Wald - Wolfowitz

Para podermos aplicar este teste, precisamos inicialmente que a série temporal seja independente e identicamente distribuída.

Seja {Zt, t = 1, … , N} uma série temporal com N observações. Considere M sendo a mediana das N observações de Zt. Atribuímos a cada valor de Zt o simbolo “a” se ele for maior ou igual a M, e “b” caso ele for menor que M. Então, temos que N = (“Na” pontos “a”) + (“Nb” pontos “b”). Desta forma, teremos grupos de observações marcadas com “a” e grupos de observações marcadas com “b” ao longo da série temporal. O número total de grupos será a estatística do teste, iso é,

T = “número total de grupos com símbolos iguais”.

Consideramos as seguintes hipóteses:

$ H_0 = $ “Não Existe tendência”

$ H_1 = $ “Existe tendência”

Rejeitamos a hipótese nula H0 se tivermos um número pequeno de grupos com símbolos iguais, ou seja, se T for relativamente pequeno.

Para valores de Na e Nb superiores a 20, podemos utilizar o Teorema Central do Limite e aproximar a distribuição de T por uma normal, isto é, $ T \sim N(\mu , \sigma^2) $, onde

$$\mu = \dfrac{2N_aN_b}{N} + 1, $$

$$\sigma = \sqrt\dfrac{2N_aN_b(2N_aN_b - N)}{N^2(N-1)}.$$

Exemplo 2.2.1.1

Considere as observações abaixo referente aos índices do IBOVESPA no período de 01 de setembro de 2009 a 01 de novembro de 2009.

| t | Índice | t | Índice |

|---|---|---|---|

| 1 | 56176 | 12 | 60570 |

| 2 | 55706 | 13 | 60432 |

| 3 | 55582 | 14 | 60575 |

| 4 | 56258 | 15 | 61467 |

| 5 | 57504 | 16 | 61157 |

| 6 | 57898 | 17 | 60020 |

| 7 | 58153 | 18 | 60207 |

| 8 | 58460 | 19 | 61089 |

| 9 | 58448 | 20 | 61152 |

| 10 | 59082 | 21 | 61523 |

| 11 | 60088 | 22 | 60772 |

Gráfico da série:

(imagem em falta)

Resultados utilizando o Action:

(imagem em falta)

Note que para este exemplo a mediana é de 60054 e portanto, temos T = 4 grupos distintos com símbolos iguais. Aplicando o teste de Wald-Wolfowitz rejeitamos a hipótese nula com nível de confiança acima de 99%.

.

Exemplo 2.2.1.2

Observe abaixo o gráfico da série temporal dos valores diários de fechamento das ações da Petrobras no período de 10 de julho de 2007 a 09 de janeiro de 2008, com um total de 123 observações.

(imagem em falta)

Resultados do Action:

(imagem em falta)

Podemos fazer uma análise gráfica e notar que esta série possui tendência. Para confirmarmos esta analise, foi aplicado o teste de Wald-Wolfowitz e, portanto, rejeitamos a hipótese nula de não existência de tendência.

2.2.2 - Teste de Cox-Stuart

Considere um conjunto de observações X1,x2,…,xN. Agrupamos as observações em pares (X1,X1+c), (X2,X2+c),…, (XN-c,XN), onde c = N/2 se N for par e c = (N+1)/2 se N for ímpar. A cada par de observações associamos o sinal “-” se Xi$ < $ Xi+c e o sinal “+” se Xi$ > $ Xi+c, caso Xi = Xi+c eliminamos esta observação. Considere Nt o numero de pares onde Xi$ \neq $ Xi+c. Assim, queremos testar:

$$ H_0 = P(X_i < X_{i+c}) = P(X_i > X_{i+c}), \quad \forall i: \text{Não existe tendência}; $$

$$ H_1 = P(X_i < X_{i+c}) \neq P(X_i > X_{i+c}), \quad \forall i: \text{Existe tendência}. $$

Note que trata-se de um teste bilateral, onde a estatística do teste é dada por

T = Número de pares com sinal “+”.

Utilizamos a distribuição binomial para avaliar o teste, com os parâmetros p = 0,5 e n = Nt com hipóteses do teste bilateral.

Exemplo 2.2.2.1

Considere o Exemplo 2.2.1.1, onde as observações abaixo são referente aos índices do IBOVESPA no período de 01 de setembro de 2009 a 01 de novembro de 2009.

| t | Índice | t | Índice |

|---|---|---|---|

| 1 | 56176 | 12 | 60570 |

| 2 | 55706 | 13 | 60432 |

| 3 | 55582 | 14 | 60575 |

| 4 | 56258 | 15 | 61467 |

| 5 | 57504 | 16 | 61157 |

| 6 | 57898 | 17 | 60020 |

| 7 | 58153 | 18 | 60207 |

| 8 | 58460 | 19 | 61089 |

| 9 | 58448 | 20 | 61152 |

| 10 | 59082 | 21 | 61523 |

| 11 | 60088 | 22 | 60772 |

Gráfico da série:

(imagem em falta)

Resultados utilizando o Action:

(imagem em falta)

Portanto, rejeitamos a hipótese nula e concluímos que há tendência na série.

.

Exemplo 2.2.2.2

Utilizando o Exemplo 2.2.1.2, observe abaixo o gráfico da série temporal dos valores diários de fechamento das ações da Petrobras no período de 10 de julho de 2007 a 09 de janeiro de 2008, com um total de 123 observações.

(imagem em falta)

Resultados utilizando o Action:

(imagem em falta)

Neste exemplo temos um total de pares Nt = 62, isto é, em todos os pares (Xi, Xi+c), temos Xi$ < $ Xi+c para todos i. Portanto, rejeitamos a hipótese nula de que a série não tem tendência.

2.2.3 - Teste de Mann-Kendall

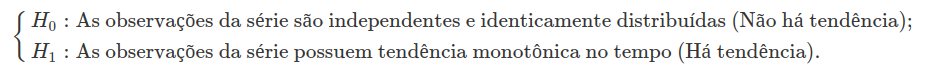

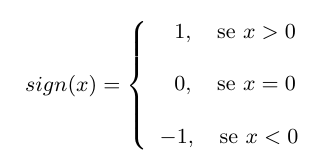

Seja as observações X1, X2,…,Xn de uma série temporal. Podemos aplicar o teste de Mann-Kendall para tendência somente se a série for serialmente independente. Então, queremos testar se as observações da série são independentes e identicamente distribuída, isto é, queremos testar as hipóteses

Sendo assim, sob $H_0$ a estatística do teste é dada por:

$$ S = \sum_{k=1}^{n-1} \sum_{j = k+1}^{n} sign(x_j - x_k)$$

onde

É possível mostrar que S é normalmente distribuída, ou seja, $ S \sim N(\mu, \sigma^2) $ com

$$\mu = 0$$

$$\sigma^2 = \dfrac{n(n-1)(2n+5) - \sum^{P}_{j = 1} t_j(t_j -1)(2t_j + 5)}{18}$$

em que n é o número de observações e, considerando o caso em que a série pode ter grupos com observações iguais, P é o número de grupos com observações iguais e tj é o numero de observações iguais no grupo j.

No caso em que o número de observações é superior a 30, a estatística do teste é calculada por

Mesmo para um número de observações inferiores a 30, podemos utilizar a estatística Z para realizarmos o teste.

Em um teste bilateral, não rejeitamos a hipótese nula H0 para um dado nível de significância $ \alpha $, se para o quantil $ Z_{\alpha /2} $ de uma distribuição normal padrão temos $ |Z| \leq Z_{\alpha /2} $.

Exemplo 2.2.3.1

Considere Exemplo 2.2.1.1, as observações abaixo são referente aos índices do IBOVESPA no período de 01 de setembro de 2009 a 01 de novembro de 2009.

| t | Índice | t | Índice |

|---|---|---|---|

| 1 | 56176 | 12 | 60570 |

| 2 | 55706 | 13 | 60432 |

| 3 | 55582 | 14 | 60575 |

| 4 | 56258 | 15 | 61467 |

| 5 | 57504 | 16 | 61157 |

| 6 | 57898 | 17 | 60020 |

| 7 | 58153 | 18 | 60207 |

| 8 | 58460 | 19 | 61089 |

| 9 | 58448 | 20 | 61152 |

| 10 | 59082 | 21 | 61523 |

| 11 | 60088 | 22 | 60772 |

Gráfico da série:

(imagem em falta)

Resultados utilizando o Action:

(imagem em falta)

Portanto, rejeitamos a hipótese nula de não existência de tendência na série.

.

Exemplo 2.2.3.2

Observe abaixo o gráfico da série temporal, do Exemplo 2.2.1.2, os valores diários de fechamento das ações da Petrobras no período de 10 de julho de 2007 a 09 de janeiro de 2008, com um total de 123 observações.

(imagem em falta)

Resultados utilizando o Action:

(imagem em falta)

Analisando os resultados, rejeitamos a hipótese nula de que as informações são independentes e identicamente distribuídas, ou seja, rejeitamos que a série não possui tendência.

2.3 - Sazonalidade

Dizemos que uma série temporal é sazonal quando os fenômenos que ocorrem durante o tempo se repete a cada período idêntico de tempo, ou seja, fenômenos que ocorrem diariamente em uma certa hora, todos os dias, ou em um certo mês em todos os anos. Um exemplo fácil de visualizar seria o aumento das vendas de passagens aéreas todos os finais de ano, ou ainda, o aumento das vendas do comércio no período do natal.

Considerando a série temporal composta pelas três componentes $S_t$, $T_t$ e $a_t$, onde $S_t$ é a componente sazonal, queremos então encontrar um estimador para $S_t$.

(imagem em falta)

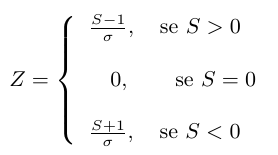

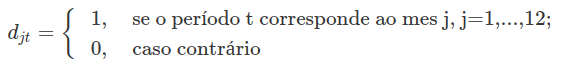

2.3.1 - Sazonalidade determinística

Sazonalidade determinística é quando pressupomos um padrão sazonal regular e estável no tempo, desta forma podemos prever o comportamento sazonal perfeitamente a partir de dados anteriores.

Modelos de regressão são ótimos para séries que apresentam este tipo de sazonalidade. Então, utilizando a decomposição aditiva da série temporal temos temos

$$ T_t = \sum^m_{j=0} \beta_j t^j$$

$$S_t = \sum_{j=0}^{12}\alpha_j d_{jt}$$

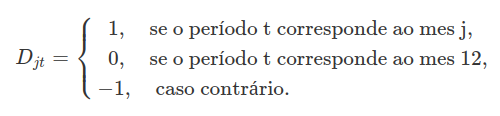

onde $ d_{jt} $ são variáveis periódicas. Estamos supondo sazonalidade constante, ou seja, $ \alpha_j $ não depende de t, portanto, para uma sazonalidade determinística com período 12 temos

Assim, temos

$$ \sum_{j = 1}^{12} d_{jt} = 1, \quad t = 1, \dots , N$$

tal que a matriz de regressão é de posto m+12. Desta forma, precisamos impor a restrição abaixo para obtermos o modelo completo

$$\sum^{11}_{j = 1} \alpha_j = 0$$

assim, o modelo de posto completo é dado por

$$Z_t = \sum^m_{j = 0} \beta_j t^j + \sum^{11}_{j = 1} \alpha_j D_{jt} + a_t$$

tal que

Agora, a partir do modelo com posto completo, podemos utilizar o método dos mínimos quadrados para obter os estimadores de $ \alpha_j $ e $ \beta_j $.

2.3.2 - Sazonalidade Estocástica

Dizemos que uma série temporal possui sazonalidade estocástica quando a componente sazonal da série varia com o tempo. Este procedimento pode ser utilizado e normalmente é utilizado quando temos um padrão sazonal constante.

Dada a série temporal $ Z_t $, seja $ \hat{T_t} $ um estimador para a tendência calculado previamente, consideramos a seguinte série temporal

$$ Y_t = Z_t - \hat{T_t}.$$

Assim, considerando o caso em que temos um padrão sazonal constante, utilizaremos $ Y_t $ para estimar $ S_t $. Inicialmente, considerando os dados fornecidos anualmente, tomamos a média dos meses

$$\bar{Y_{.j}} = \frac{1}{n_j} \sum^{n_j}_{i = 1} Y_{ij}, \quad j= 1, \dots , 12;$$

em geral, a soma dos $ \bar{Y_{.j}} $ não é zero e, portanto, tomamos como estimativas das constantes sazonais

$$\hat{S_j} = \bar{Y_{.j}} - \bar{Y}, \quad \hbox{onde} \quad \bar{Y} = \frac{1}{12} \sum^{12}_{j = 1} \bar{Y_{.j}}$$

Assim, o modelo da série original $ Z_t $ pode ser escrito na forma aditiva por

$$ Z_t = T_t + S_j + a_t$$

com t = 12i + j, i = 0, 1, … ,p-1, j = 1, … ,12, onde p é o número de anos.

Então, a série livre de sazonalidade pode ser escrita como

$$Z^{\ast_t} = Z_t - \hat{S_t}.$$

Exemplo 2.3.2

Considere a série temporal AirPassengers que representa o número de passageiros mensalmente em uma empresa de transporte aéreo no período de 1949 a 1960.

Nota-se pelo gráfico da série que esta possui sazonalidade anualmente e portanto, podemos obter a série livre de sazonalidade:

(imagem em falta)

2.4 - Testes para sazonalidade deterministíca

Utilizando o modelo para sazonalidade determinística visto na seção 2.3.1, temos

$$Z_t = \sum^m_{i=0}\beta_it^i + \sum^{n_j}_{j=1}\alpha_jD_{jt} + a_t$$

então, dizemos que não existe sazonalidade determinística na série temporal se a hipótese nula de que todos os $ \alpha_j $ são nulos não for rejeitada, ou seja, se

$$H_0 : \alpha_1 = \dots = \alpha_{n_j} = 0$$

não for rejeitada.

Podemos utilizar métodos paramétricos e não paramétricos para determinar sazonalidade determinísticas e, para qualquer teste, é necessário eliminar a tendência da série se ela existir, ou seja, vamos trabalhar com a série $ Y_t = Z_t - \hat{T_t} $.

2.4.1 - Teste de Kruskal-Wallis

Supondo uma amostra de uma população, subdividida em k conjuntos de amostras de tamanho $ n_j $ cada, que varia dependendo da série que estamos trabalhando. Por exemplo, se a série for anual e temos observações mensais, isto é, nj = 12 e k representaria o número de anos.

Então, temos as seguintes amostras

$$Y_{ij}, \quad j=1,\dots,k, \ \ i=1, \dots, n_j, \quad N = \sum^k_{j=1} n_j$$

Substituímos as observações Yij por seus respectivos postos dentre todas as N observações, somamos todos os postos em cada subgrupo j, ou seja

$$R_{.j} = \sum^{n_j}_{i=1} R_{ij}, \quad j=1,\dots,k.$$

Assim, a estatística para o teste é dada por

$$H=\frac{\frac{12}{N(N+1)}\sum_{i=1}^kn_i\left(R_{i\cdot}-\frac{N+1}{2}\right)^2}{1-\frac{ \sum_{j=1}^g t_j^3-t_j}{N^3-N}}=\frac{\left(\frac{12}{N(N+1)}\sum_{i=1}^k \frac{R_i^2}{n_i} \right)-3(N+1)}{1-\frac{\sum_{j=1}^g t_j^3-t_j}{N^3-N}}$$

onde t é o número de observações repetidas no grupo j e g é o número de grupos com observações repetidas.

Sob H0, para nj suficientemente grande, ou k $ \ge $ 4, a distribuição de H pode ser aproximada por uma variável $ \chi^2 $ com k-1 graus de liberdade. Portanto, rejeitamos a hipótese nula de não existência de sazonalidade determinística se $ P_{h_0}(H \ge \chi^2_{(k-1), \alpha}) = \alpha $, tal que $ \alpha $ é o nível de significância do teste.

Exemplo 2.4.1

Consideramos novamente a série temporal AirPassengers do Exemplo 2.3.2 e aplicamos o teste de Kruskal-Wallis.

| Ano/Mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 112 | 118 | 132 | 129 | 121 | 135 | 148 | 148 | 136 | 119 | 104 | 118 |

| 1950 | 115 | 126 | 141 | 135 | 125 | 149 | 170 | 170 | 158 | 133 | 114 | 140 |

| 1951 | 145 | 150 | 178 | 163 | 172 | 178 | 199 | 199 | 184 | 162 | 146 | 166 |

| 1952 | 171 | 180 | 193 | 181 | 183 | 218 | 230 | 242 | 209 | 191 | 172 | 194 |

| 1953 | 196 | 196 | 236 | 235 | 229 | 243 | 264 | 272 | 237 | 211 | 180 | 201 |

| 1954 | 204 | 188 | 235 | 227 | 234 | 264 | 302 | 293 | 259 | 229 | 203 | 229 |

| 1955 | 242 | 233 | 267 | 269 | 270 | 315 | 364 | 347 | 312 | 274 | 237 | 278 |

| 1956 | 284 | 277 | 317 | 313 | 318 | 374 | 413 | 405 | 355 | 306 | 271 | 306 |

| 1957 | 315 | 301 | 356 | 348 | 355 | 422 | 465 | 467 | 404 | 347 | 305 | 336 |

| 1958 | 340 | 318 | 362 | 348 | 363 | 435 | 491 | 505 | 404 | 359 | 310 | 337 |

| 1959 | 360 | 342 | 406 | 396 | 420 | 472 | 548 | 559 | 463 | 407 | 362 | 405 |

| 1960 | 417 | 391 | 419 | 461 | 472 | 535 | 622 | 606 | 508 | 461 | 390 | 432 |

Então, temos

$$n_j = \hbox{número de meses} = 12, \quad j = 1,2,\dots,12$$

$$N = \sum^{12}_{j=1}n_j = 144$$

Os postos de cada observação, são dados pela tabela abaixo

| Ano/mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | Out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 2,0 | 5,5 | 12,0 | 11,0 | 8,0 | 14,5 | 21,5 | 21,5 | 16,0 | 7,0 | 1,0 | 5,5 |

| 1950 | 4,0 | 10,0 | 18,0 | 14,5 | 9,0 | 23,0 | 29,5 | 29,5 | 25,0 | 13,0 | 3,0 | 17,0 |

| 1951 | 19,0 | 24,0 | 34,5 | 27,0 | 32,5 | 34,5 | 47,5 | 47,5 | 40,0 | 26,0 | 20,0 | 28,0 |

| 1952 | 31,0 | 36,5 | 43,0 | 38,0 | 39,0 | 54,0 | 59,0 | 67,5 | 52,0 | 42,0 | 32,5 | 44,0 |

| 1953 | 45,5 | 45,5 | 64,0 | 62,5 | 57,0 | 69,0 | 71,5 | 77,0 | 65,5 | 53,0 | 36,5 | 49,0 |

| 1954 | 51,0 | 41,0 | 62,5 | 55,0 | 61,0 | 71,5 | 84,0 | 82,0 | 70,0 | 57,0 | 50,0 | 57,0 |

| 1955 | 67,5 | 60,0 | 73,0 | 74,0 | 75,0 | 91,5 | 112,0 | 100,5 | 89,0 | 78,0 | 65,5 | 80,0 |

| 1956 | 81,0 | 79,0 | 93,0 | 90,0 | 94,5 | 113,0 | 123,0 | 119,5 | 104,5 | 86,5 | 76,0 | 86,5 |

| 1957 | 91,5 | 83,0 | 106,0 | 102,5 | 104,5 | 127,0 | 133,0 | 134,0 | 117,5 | 100,5 | 85,0 | 96,0 |

| 1958 | 98,0 | 94,5 | 109,5 | 102,5 | 111,0 | 129,0 | 137,0 | 138,0 | 117,5 | 107,0 | 88,0 | 97,0 |

| 1959 | 108,0 | 99,0 | 121,0 | 116,0 | 126,0 | 135,5 | 141,0 | 142,0 | 132,0 | 122,0 | 109,5 | 119,5 |

| 1960 | 124,0 | 115,0 | 125,0 | 130,5 | 135,5 | 140,0 | 144,0 | 143,0 | 139,0 | 130,5 | 114,0 | 128,0 |

Utilizando o Action para efetuar os cálculos obtemos:

(imagem em falta)

Portanto, sob $ H_0 $ temos $ P(H \ge \chi^2_{11, \alpha}) \approx 0 $ e rejeitamos a hipótese nula de que não existe sazonalidade determinística.

2.4.2 - Teste de Friedman

Considere a série temporal $ Z_t $ tal que podemos interpreta-la na forma do modelo aditivo $ Z_t = T_t + S_t + a_t $.

Para podermos aplicar o teste de Friedman para sazonalidade determinística precisamo considerar a série livre de tendência, ou seja, considerando $ \hat{T_t} $ o estimador para a tendência da série, vamos trabalhar com a série

$$Y_t = Z_t - \hat{T_t}.$$

Dividimos a série em blocos de períodos e calculamos o posto de cada observação em cada bloco, por exemplo, se estivermos analisando uma série temporal com dados mensais durante 20 anos, vamos testar a sazonalidade em cada mês durante os 20 anos, então temos um período de 12 meses e 20 blocos de períodos.

Assim, a estatística do teste pode ser calculada por

$$H = \frac{12}{nk(k+1)}\sum_{j=1}^kR_{.j}^2 - 3n(k+1), \quad \hbox{onde} \ \ R_{,j} = \sum_{i=1}^nR_{ij},$$

onde $ R_{ij} $ é o posto da observação $ Y_{ij} $ dentro do bloco i, n é o número de blocos e k é o tamanho do período. A distribuição de H pode ser aproximada por uma distribuição $ \chi^2 $ com k-1 graus de liberdade.

Exemplo 2.4.1

Consideramos novamente a série temporal AirPassengers do Exemplo 2.3.2 e aplicamos o teste de Friedman.

| Ano/Mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 112 | 118 | 132 | 129 | 121 | 135 | 148 | 148 | 136 | 119 | 104 | 118 |

| 1950 | 115 | 126 | 141 | 135 | 125 | 149 | 170 | 170 | 158 | 133 | 114 | 140 |

| 1951 | 145 | 150 | 178 | 163 | 172 | 178 | 199 | 199 | 184 | 162 | 146 | 166 |

| 1952 | 171 | 180 | 193 | 181 | 183 | 218 | 230 | 242 | 209 | 191 | 172 | 194 |

| 1953 | 196 | 196 | 236 | 235 | 229 | 243 | 264 | 272 | 237 | 211 | 180 | 201 |

| 1954 | 204 | 188 | 235 | 227 | 234 | 264 | 302 | 293 | 259 | 229 | 203 | 229 |

| 1955 | 242 | 233 | 267 | 269 | 270 | 315 | 364 | 347 | 312 | 274 | 237 | 278 |

| 1956 | 284 | 277 | 317 | 313 | 318 | 374 | 413 | 405 | 355 | 306 | 271 | 306 |

| 1957 | 315 | 301 | 356 | 348 | 355 | 422 | 465 | 467 | 404 | 347 | 305 | 336 |

| 1958 | 340 | 318 | 362 | 348 | 363 | 435 | 491 | 505 | 404 | 359 | 310 | 337 |

| 1959 | 360 | 342 | 406 | 396 | 420 | 472 | 548 | 559 | 463 | 407 | 362 | 405 |

| 1960 | 417 | 391 | 419 | 461 | 472 | 535 | 622 | 606 | 508 | 461 | 390 | 432 |

Então, temos

$$n_j = \hbox{número de meses} = 12, \quad j = 1,2,\dots,12$$

$$N = \sum^{12}_{j=1}n_j = 144$$

Os postos de cada observação, são dados pela tabela abaixo

| Ano/mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | Out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 2,0 | 5,5 | 12,0 | 11,0 | 8,0 | 14,5 | 21,5 | 21,5 | 16,0 | 7,0 | 1,0 | 5,5 |

| 1950 | 4,0 | 10,0 | 18,0 | 14,5 | 9,0 | 23,0 | 29,5 | 29,5 | 25,0 | 13,0 | 3,0 | 17,0 |

| 1951 | 19,0 | 24,0 | 34,5 | 27,0 | 32,5 | 34,5 | 47,5 | 47,5 | 40,0 | 26,0 | 20,0 | 28,0 |

| 1952 | 31,0 | 36,5 | 43,0 | 38,0 | 39,0 | 54,0 | 59,0 | 67,5 | 52,0 | 42,0 | 32,5 | 44,0 |

| 1953 | 45,5 | 45,5 | 64,0 | 62,5 | 57,0 | 69,0 | 71,5 | 77,0 | 65,5 | 53,0 | 36,5 | 49,0 |

| 1954 | 51,0 | 41,0 | 62,5 | 55,0 | 61,0 | 71,5 | 84,0 | 82,0 | 70,0 | 57,0 | 50,0 | 57,0 |

| 1955 | 67,5 | 60,0 | 73,0 | 74,0 | 75,0 | 91,5 | 112,0 | 100,5 | 89,0 | 78,0 | 65,5 | 80,0 |

| 1956 | 81,0 | 79,0 | 93,0 | 90,0 | 94,5 | 113,0 | 123,0 | 119,5 | 104,5 | 86,5 | 76,0 | 86,5 |

| 1957 | 91,5 | 83,0 | 106,0 | 102,5 | 104,5 | 127,0 | 133,0 | 134,0 | 117,5 | 100,5 | 85,0 | 96,0 |

| 1958 | 98,0 | 94,5 | 109,5 | 102,5 | 111,0 | 129,0 | 137,0 | 138,0 | 117,5 | 107,0 | 88,0 | 97,0 |

| 1959 | 108,0 | 99,0 | 121,0 | 116,0 | 126,0 | 135,5 | 141,0 | 142,0 | 132,0 | 122,0 | 109,5 | 119,5 |

| 1960 | 124,0 | 115,0 | 125,0 | 130,5 | 135,5 | 140,0 | 144,0 | 143,0 | 139,0 | 130,5 | 114,0 | 128,0 |

Utilizando o Action para efetuar os cálculos obtemos:

(imagem em falta)

Portanto, sob $ H_0 $ temos $ P(H \ge \chi^2_{11, \alpha}) \approx 0 $ e rejeitamos a hipótese nula de que não existe sazonalidade determinística.

2.4.3 - Teste F

O teste $ F $ para detectar sazonalidade determinística se trata do mesmo teste de hipóteses utilizado para comparar variâncias em um modelo estatístico.

Considere a série temporal $ Z_t $ tal que podemos interpreta-la na forma do modelo aditivo, neste caso, escrevemos as observações da série temporal sem a componente de tendência no seguinte modelo

$$Y_{ij} = S_j + e_{ij}, \quad i = 1,\dots,n_j; \quad j=1,\dots, k.$$

onde $ n_j $ é o tamanho do período a ser considerado e k o número de blocos de períodos, supondo $ e_{ij} \sim N(0, \sigma^2) $. A estatística do teste $ F $ pode ser escrita como

$$H = \frac{N - k}{k - 1}\frac{\sum_{j=1}^kn_j(\bar{Y_{.j}} - \bar{Y})^2}{\sum_{i=1}^k\sum_{j=1}^{n_j}(Y_{ij} - \bar{Y_{.j}})^2}, \quad \hbox{onde} \quad N = \sum_{j=1}^kn_j.$$

Aproximamos a distribuição de H por uma F de Fisher-Snedcor com (k-1) e (N-k) graus de liberdade, ou seja, $ H \sim F(k-1,N-k) $.

Exemplo 2.4.3

Consideramos novamente a série temporal AirPassengers do Exemplo 2.3.2 e aplicamos o teste F para uma análise de variância.

Os postos de cada observação, são dados pela tabela abaixo

| Ano/mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | Out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 2,0 | 5,5 | 12,0 | 11,0 | 8,0 | 14,5 | 21,5 | 21,5 | 16,0 | 7,0 | 1,0 | 5,5 |

| 1950 | 4,0 | 10,0 | 18,0 | 14,5 | 9,0 | 23,0 | 29,5 | 29,5 | 25,0 | 13,0 | 3,0 | 17,0 |

| 1951 | 19,0 | 24,0 | 34,5 | 27,0 | 32,5 | 34,5 | 47,5 | 47,5 | 40,0 | 26,0 | 20,0 | 28,0 |

| 1952 | 31,0 | 36,5 | 43,0 | 38,0 | 39,0 | 54,0 | 59,0 | 67,5 | 52,0 | 42,0 | 32,5 | 44,0 |

| 1953 | 45,5 | 45,5 | 64,0 | 62,5 | 57,0 | 69,0 | 71,5 | 77,0 | 65,5 | 53,0 | 36,5 | 49,0 |

| 1954 | 51,0 | 41,0 | 62,5 | 55,0 | 61,0 | 71,5 | 84,0 | 82,0 | 70,0 | 57,0 | 50,0 | 57,0 |

| 1955 | 67,5 | 60,0 | 73,0 | 74,0 | 75,0 | 91,5 | 112,0 | 100,5 | 89,0 | 78,0 | 65,5 | 80,0 |

| 1956 | 81,0 | 79,0 | 93,0 | 90,0 | 94,5 | 113,0 | 123,0 | 119,5 | 104,5 | 86,5 | 76,0 | 86,5 |

| 1957 | 91,5 | 83,0 | 106,0 | 102,5 | 104,5 | 127,0 | 133,0 | 134,0 | 117,5 | 100,5 | 85,0 | 96,0 |

| 1958 | 98,0 | 94,5 | 109,5 | 102,5 | 111,0 | 129,0 | 137,0 | 138,0 | 117,5 | 107,0 | 88,0 | 97,0 |

| 1959 | 108,0 | 99,0 | 121,0 | 116,0 | 126,0 | 135,5 | 141,0 | 142,0 | 132,0 | 122,0 | 109,5 | 119,5 |

| 1960 | 124,0 | 115,0 | 125,0 | 130,5 | 135,5 | 140,0 | 144,0 | 143,0 | 139,0 | 130,5 | 114,0 | 128,0 |

Portanto, temos

$$\sum_{j=1}^{12}12(\bar{Y_{.j}} - \bar{Y})^2 = 211306,90$$

$$\sum_{j=1}^{12}\sum_{i=1}^{12}(Y_{ij} - \bar{Y_{.j}})^2 = 58286,99$$

$$H = \frac{144 - 12}{12 - 1}*\frac{211306,90}{58286,99} = 43,50$$

Utilizando o Action obtemos o mesmo resultado:

(imagem em falta)

Pela tabela da distribuição F para um nível de significância de $ \alpha = 0,05 $, temos $ F_{(11, 132, \alpha=0,05)} = 1,86 $. Portanto, rejeitamos a hipóteses nula de que a série não possui sazonalidade determinística.

3 - Modelos de Suavização Exponencial

Modelos de suavização é uma grande classe de métodos de previsão que se baseiam na ideia de que observações passadas contêm informações sobre o padrão da série temporal. O propósito dos métodos é distinguir um padrão de comportamento de qualquer outro ruído que possa estar contido nas observações da série e então usar esse padrão para prever valores futuros da série.

3.1 - Médias Móveis Simples (MMS)

Considere a série temporal $ Z_1 $, $ Z_2 $, … , $ Z_n $, estacionária e localmente constante, composta de seu nível e mais um ruído aleatório da seguinte forma

$$Z_t = \mu_t + a_t, \quad t=1,\dots,N$$

onde E(at) = 0, Var(at) = $ \sigma_a^2 $ e $ \mu_t $ é um parâmetro desconhecido que varia com o tempo.

A técnica de média móvel consiste em calcular a média aritmética das k observações mais recentes, ou seja

$$M_t = \frac{Z_t + Z_{t-1} + \dots + Z_{t-k+1}}{k} = M_{t-1} + \frac{Z_t - Z_{t-k}}{k}$$

Denotamos por k como sendo o comprimento da média.

Desta forma, $ M_t $ é uma estimativa do nível $ \mu_t $ que não leva em consideração as observações mais antigas. Note que a cada período a observação mais antiga é substituída pela mais recente, calculando-se uma média nova.

Portanto, a previsão dos h valores futuros é dada pela última média móvel calculada, ou seja

$$\hat{Z_t}(h) = M_t,$$

ou ainda

$$\hat{Z_t}(h)= \hat{Z_{t-1}}(h+1) + \frac{Z_t - Z_{t-k}}{k}, \quad \forall h > 0.$$

Podemos perceber que a equação acima corrige a previsão de $ Z_{t+h} $ a cada instante, ou seja, a cada nova observação na série, $ Z_{t+h} $ é atualizado.

Assumindo que $ a_t \sim N(0,\sigma_a^2) $, podemos afirmar que $ \hat{Z_t}(h) \sim N(\mu,\frac{\sigma_a^2}{k}) $ e construir um intervalo de confiança com nível de significância \alpha, dado por

$$\Bigg(\hat{Z_t}(h) - z_{\alpha}\frac{\sigma_a}{\sqrt{k}} ; \hat{Z_t}(h) + z_{\alpha}\frac{\sigma_a}{\sqrt{k}}\Bigg),$$

onde $ z_{\alpha} $ é o quantil de uma distribuição normal padrão, com nível de significância $ \alpha $.

Exemplo 3.1.1

Seja $ Z_t $ uma série temporal referente às médias anuais das temperaturas na cidade de Nova York durante os anos de 1912 e 1971. Vamos ajustar um modelo MMS a está serie temporal e tentar prever a temperatura nos próximos 6 anos.

| Ano | Temperatura | Ano | Temperatura | Ano | Temperatura |

|---|---|---|---|---|---|

| 1912 | 49,9 | 1932 | 51,8 | 1952 | 53,1 |

| 1913 | 52,3 | 1933 | 51,1 | 1953 | 54,6 |

| 1914 | 49,4 | 1934 | 49,8 | 1954 | 52 |

| 1915 | 51,1 | 1935 | 50,2 | 1955 | 52 |

| 1916 | 49,4 | 1936 | 50,4 | 1956 | 50,9 |

| 1917 | 47,9 | 1937 | 51,6 | 1957 | 52,6 |

| 1918 | 49,8 | 1938 | 51,8 | 1958 | 50,2 |

| 1919 | 50,9 | 1939 | 50,9 | 1959 | 52,6 |

| 1920 | 49,3 | 1940 | 48,8 | 1960 | 51,6 |

| 1921 | 51,9 | 1941 | 51,7 | 1961 | 51,9 |

| 1922 | 50,8 | 1942 | 51 | 1962 | 50,5 |

| 1923 | 49,6 | 1943 | 50,6 | 1963 | 50,9 |

| 1924 | 49,3 | 1944 | 51,7 | 1964 | 51,7 |

| 1925 | 50,6 | 1945 | 51,5 | 1965 | 51,4 |

| 1926 | 48,4 | 1946 | 52,1 | 1966 | 51,7 |

| 1927 | 50,7 | 1947 | 51,3 | 1967 | 50,8 |

| 1928 | 50,9 | 1948 | 51 | 1968 | 51,9 |

| 1929 | 50,6 | 1949 | 54 | 1969 | 51,8 |

| 1930 | 51,5 | 1950 | 51,4 | 1970 | 51,9 |

| 1931 | 52,8 | 1951 | 52,7 | 1971 | 53 |

Utilizando o , obtemos os seguintes resultados para um ajuste MMS com comprimento de média k = 3

(há elementos em falta na equação acima)

(imagem em falta)

(imagem em falta)

Desta forma, as previsões com um intervalo de confiança de 95% são dadas por:

(imagem em falta)

3.2 - Suavização Exponencial Simples (SES)

Seja $ Z_1 $,$ Z_2 $, … ,$ Z_n $ uma série temporal estacionária. Podemos descrever uma SES por

$$\bar{Z_t} = \alpha\sum_{j=0}^{t-1}(1- \alpha)^jZ_{t-j} + (1-\alpha)^t\bar{Z}_0, \quad t=1,\dots,N,$$

onde $ \bar{Z_t} $ é denominado valor exponencialmente suavizado e $ \alpha $ é a constante de suavização, tal que $ 0 \le \alpha \le 1 $.

Expandindo a equação acima temos

$$\bar{Z_t} = \alpha Z_t + \alpha(1-\alpha)Z_{t-1} + \alpha(1-\alpha)^2Z_{t-2} + \dots$$

então, podemos concluir que a SES é uma média ponderada que da pesos maiores às observações mais recentes, eliminando uma das desvantagens do método de MMS.

A previsão dos h valores futuros é dada pelo último valor exponencialmente suavizado, ou seja

$$\hat{Z}(h) = \bar{Z_t}, \quad \forall h$$

$$\hat{Z}(h) = \alpha Z_t + (1 - \alpha)\hat{Z_{t-1}}(h+1)$$

Supondo $ a_t \sim N(0,\sigma_a^2) $, podemos construir um intervalo de confiança assintótico para $ Z_{t+h} $, dado por

$$\Bigg(\hat{Z_t}(h) - z_{\gamma}\sigma_a\sqrt{\frac{\alpha}{2 - \alpha}} \ ; \ \hat{Z_t}(h) + z_{\gamma}\sigma_a\sqrt{\frac{\alpha}{2 - \alpha}}\Bigg)$$

onde $ z_{\gamma} $ é o quantil de uma distribuição normal padrão com nível de significância $ \gamma $.

Exemplo 3.2.1

Considere a série temporal AirPassengers que representa o número de passageiros em um aeroporto no decorrer do tempo. Vamos ajustar um modelo de SES para estes dados.

| Ano/Mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 112 | 118 | 132 | 129 | 121 | 135 | 148 | 148 | 136 | 119 | 104 | 118 |

| 1950 | 115 | 126 | 141 | 135 | 125 | 149 | 170 | 170 | 158 | 133 | 114 | 140 |

| 1951 | 145 | 150 | 178 | 163 | 172 | 178 | 199 | 199 | 184 | 162 | 146 | 166 |

| 1952 | 171 | 180 | 193 | 181 | 183 | 218 | 230 | 242 | 209 | 191 | 172 | 194 |

| 1953 | 196 | 196 | 236 | 235 | 229 | 243 | 264 | 272 | 237 | 211 | 180 | 201 |

| 1954 | 204 | 188 | 235 | 227 | 234 | 264 | 302 | 293 | 259 | 229 | 203 | 229 |

| 1955 | 242 | 233 | 267 | 269 | 270 | 315 | 364 | 347 | 312 | 274 | 237 | 278 |

| 1956 | 284 | 277 | 317 | 313 | 318 | 374 | 413 | 405 | 355 | 306 | 271 | 306 |

| 1957 | 315 | 301 | 356 | 348 | 355 | 422 | 465 | 467 | 404 | 347 | 305 | 336 |

| 1958 | 340 | 318 | 362 | 348 | 363 | 435 | 491 | 505 | 404 | 359 | 310 | 337 |

| 1959 | 360 | 342 | 406 | 396 | 420 | 472 | 548 | 559 | 463 | 407 | 362 | 405 |

| 1960 | 417 | 391 | 419 | 461 | 472 | 535 | 622 | 606 | 508 | 461 | 390 | 432 |

Assim, utilizando o Action para efetuar os cálculos, obtemos os resultados:

(há elementos em falta na equação acima)

(imagem em falta)

(imagem em falta)

(imagem em falta)

A previsão será de 432 pessoas em janeiro de 1961. Note que esse tipo de previsão não é efetiva para mais do que um passo no futuro, pois devido sua formula de previsão o valor é repetido consecutivamente, independente do valor da constante de suavização $ \alpha $.

3.3 - Suavização Exponencial de Holt (SEH)

Esta técnica de suavização é recomendada para séries que apresentam tendência. Considere o caso de uma série temporal que é composta localmente da soma de nível, tendencia e resíduo com média zero e variância constante $ \sigma_a^2 $, isto é

$$Z_t = \mu_t + T_t + a_t, \quad t = 1, \dots , N$$

Esta técnica é similar a uma Suavização Exponencial Simples (SES) com uma constante extra para modelar a componente de tendência. Os valores do nível e da tendência da série serão estimados por

$$\bar{Z_t} = AZ_t + (1-A)(\bar{Z_{t-1}} + \hat{T_{t-1}}), \quad 0< A < 1 \quad e \quad t = 2, \dots , N,$$

$$\hat{T_t} = C(\bar{Z_t} - \bar{Z_{t-1}}) + (1-C)\hat{T_{t-1}}, \quad 0 < C < 1 \quad e \quad t = 2, \dots , N$$

onde A e C são denominados constantes de suavização, tal que $ A \ge C $.

Assim, a previsão do valor $ Z_{t+h} $ com origem em t é dada por

$$\hat{Z_t}(h) = \bar{Z_t} + h\hat{T_t} \quad \forall h > 0$$

Exemplo 3.3.1

Considere a mesma série temporal do exemplo 3.2.1, vamos tentar prever o número de passageiros na linha aérea para os próximos 6 anos.

| Ano/Mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 112 | 118 | 132 | 129 | 121 | 135 | 148 | 148 | 136 | 119 | 104 | 118 |

| 1950 | 115 | 126 | 141 | 135 | 125 | 149 | 170 | 170 | 158 | 133 | 114 | 140 |

| 1951 | 145 | 150 | 178 | 163 | 172 | 178 | 199 | 199 | 184 | 162 | 146 | 166 |

| 1952 | 171 | 180 | 193 | 181 | 183 | 218 | 230 | 242 | 209 | 191 | 172 | 194 |

| 1953 | 196 | 196 | 236 | 235 | 229 | 243 | 264 | 272 | 237 | 211 | 180 | 201 |

| 1954 | 204 | 188 | 235 | 227 | 234 | 264 | 302 | 293 | 259 | 229 | 203 | 229 |

| 1955 | 242 | 233 | 267 | 269 | 270 | 315 | 364 | 347 | 312 | 274 | 237 | 278 |

| 1956 | 284 | 277 | 317 | 313 | 318 | 374 | 413 | 405 | 355 | 306 | 271 | 306 |

| 1957 | 315 | 301 | 356 | 348 | 355 | 422 | 465 | 467 | 404 | 347 | 305 | 336 |

| 1958 | 340 | 318 | 362 | 348 | 363 | 435 | 491 | 505 | 404 | 359 | 310 | 337 |

| 1959 | 360 | 342 | 406 | 396 | 420 | 472 | 548 | 559 | 463 | 407 | 362 | 405 |

| 1960 | 417 | 391 | 419 | 461 | 472 | 535 | 622 | 606 | 508 | 461 | 390 | 432 |

Assim, utilizando o Action para efetuar os cálculos, obtemos os resultados:

(há elementos em falta na equação acima)

(imagem em falta)

(imagem em falta)

(imagem em falta)

Note que este modelo de suavização é o mais indicado quando o fator predominante na série temporal é a tendência, pois é o diferencial do modelo, utilizar a tendência para diferenciar e aproximar mais as previsões.

3.4 - Suavização Exponencial de Holt - Winters (HW)

No caso de séries que apresentam um comportamento um pouco mais complexo, como sazonalidade, utilizamos outras formas de suavização como o método de Holt - Winters.

Essa técnica envolve três equações com três parâmetros de suavização que são associados a cada componente da série: nível, tendência e sazonalidade.

Portanto, temos dois casos a serem considerados

Série Sazonal Multiplicativa

Considere uma série sazonal com período p. A variante mais usual do método de HW considera o fator sazonal $ S_t $ como sendo multiplicativo, enquanto a tendência continua aditiva, ou seja

$$Z_t = \mu_t S_t + T_t + a_t, \quad t = 1, \dots , N.$$

E assim, calculamos as três equações de suavização por

$$\hat{S_t} = D\Bigg(\frac{Z_t}{\bar{Z_t}}\Bigg) + (1-D)\hat{S}_{t-p}, \quad 0 < D < 1,$$

$$\bar{Z_t} = A\Bigg(\frac{Z_t}{\hat{S_{t-s}}}\Bigg) + (1-A)(\bar{Z_{t-1}} + \hat{T_{t-1}}), \quad 0 < A < 1,$$

$$\hat{T_t} = C(\bar{Z_t} - \bar{Z_{t-1}}) + (1-C)\hat{T_{t-1}}, \quad, 0 < C < 1,$$

que representam estimativas do fator sazonal, do nível e da tendência, respectivamente; onde A, C e D são as constantes de suavização.

Uma previsão de h passos a frente utilizando o modelo Multiplicativo pode ser encontrado através da seguinte fórmula

$$\hat{Z}(h) = (\bar{Z_t} + h\hat{T_t})\hat{S_{t+h-p}}, \quad h= 1, 2, \dots , p,$$

$$\hat{Z}(h) = (\bar{Z_t} + h\hat{T_t})\hat{S_{t+h-2p}}, \quad h= p+1, \dots , 2p,$$

$$\vdots \quad \quad \quad \quad \quad \vdots$$

onde $ \bar{Z_t} $, $ \hat{S_t} $ e $ \hat{T_t} $ são dadas pelas equações acima. Para atualizarmos as previsões quando temos uma nova observação $ Z_{t+1} $ basta fazermos os mesmos procedimentos com a nova observação e voltando um passo na previsão, ou seja

$$\hat{Z_{t+1}}(h-1) = (\bar{Z_{t+1}} + (h-1)\hat{T_{t+1}})\hat{S}_{t+1+h-p}, \quad h= 1, 2, \dots , p+1,$$

$$\hat{Z_{t+1}}(h-1) = (\bar{Z_{t+1}} + (h-1)\hat{T_{t+1}})\hat{S}_{t+1+h-2p}, \quad h= p+2, \dots , 2p+1,$$

Para um valor inicial das equações de recorrência, utilizamos as seguintes fórmulas

$$\hat{S_j} = \frac{Z_j}{(\frac{1}{p})\sum_{k=1}^{p}Z_k}, \quad j = 1,2,\dots , p; \quad \quad \bar{Z}_p = \frac{1}{p}\sum_{k=1}^pZ_k; \quad \quad \hat{T}_p = 0.$$

Série Sazonal Aditiva

Neste caso, a série é composta por

$$Z_t = \mu_t + T_t + S_t + a_t $$

E portanto, podemos calcular as equações de suavização por

$$\hat{S_t} = D(Z_t - \hat{Z_t}) + (1-D)\hat{S_{t-s}} , \quad 0 < D < 1,$$

$$\bar{Z_t} = A(Z_t - \hat{S_{t-s}}) + (1-A)(\bar{Z_{t-1}} + \hat{T_{t-1}}), \quad 0 < A < 1,$$

$$\hat{T_t} = C(\bar{Z_t} - \bar{Z_{t-1}}) + (1-C)\hat{T_{t-1}}, \quad 0 < C < 1.$$

que representam a estimativa do fator sazonal, do nível e da tendência, respectivamente, onde A, C e D são as constantes de suavização.

Uma previsão de h passos a frente pode ser feita através das equações

$$\hat{Z_t}(h) = \bar{Z_t} + h\hat{T_t} + \hat{S_{t+h-p}}, \quad h = 1,2,\dots p,$$

$$\hat{Z_t}(h) = \bar{Z_t} + h\hat{T_t} + \hat{S_{t+h-2p}}, \quad h = p+1,\dots 2p,$$

$$\vdots \quad \quad \quad \quad \quad \vdots$$

Se obtemos uma nova observação $ Z_{t+1} $ podemos atualizar a previsão de $ Z_{t+h} $ recalculando as equações de recorrência para o ponto t+1, ou seja

$$\hat{S_{t+1}} = D(Z_{t+1} - \hat{Z_{t+1}}) + (1-D)\hat{S_{t+1-s}}$$

$$\bar{Z_{t+1}} = A(Z_{t+1} - \hat{S}_{t+1-s}) + (1-A)(\bar{Z}_{t} + \hat{T}_{t}),$$

$$\hat{T_{t+1}} = C(\bar{Z_{t+1}} - \bar{Z}_{t}) + (1-C)\hat{T}_{t}.$$

e assim, a nova previsão para $ Z_{t+h} $ será

$$\hat{Z_{t+1}}(h-1) = \bar{Z_{t+1}} + (h-1)\hat{T_{t+1}} + \hat{S}_{t+1+h-p}, \quad h = 1,2,\dots p+1,$$

$$\hat{Z_{t+1}}(h-1) = \bar{Z_{t+1}} + (h-1)\hat{T_{t+1}} + \hat{S}_{t+1+h-2p}, \quad h = p+2,\dots 2p+1,$$

$$\vdots \quad \quad \quad \quad \quad \vdots$$

Exemplo 3.4.1

Considere a mesma série temporal do exemplo 3.2.1, vamos tentar prever o número de passageiros na linha aérea para os próximos três anos, isso é 36 passos à frente.

| Ano/Mês | Jan | Fev | Mar | Abr | Mai | Jun | Jul | Ago | Set | out | Nov | Dez |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1949 | 112 | 118 | 132 | 129 | 121 | 135 | 148 | 148 | 136 | 119 | 104 | 118 |

| 1950 | 115 | 126 | 141 | 135 | 125 | 149 | 170 | 170 | 158 | 133 | 114 | 140 |

| 1951 | 145 | 150 | 178 | 163 | 172 | 178 | 199 | 199 | 184 | 162 | 146 | 166 |

| 1952 | 171 | 180 | 193 | 181 | 183 | 218 | 230 | 242 | 209 | 191 | 172 | 194 |

| 1953 | 196 | 196 | 236 | 235 | 229 | 243 | 264 | 272 | 237 | 211 | 180 | 201 |

| 1954 | 204 | 188 | 235 | 227 | 234 | 264 | 302 | 293 | 259 | 229 | 203 | 229 |

| 1955 | 242 | 233 | 267 | 269 | 270 | 315 | 364 | 347 | 312 | 274 | 237 | 278 |

| 1956 | 284 | 277 | 317 | 313 | 318 | 374 | 413 | 405 | 355 | 306 | 271 | 306 |

| 1957 | 315 | 301 | 356 | 348 | 355 | 422 | 465 | 467 | 404 | 347 | 305 | 336 |

| 1958 | 340 | 318 | 362 | 348 | 363 | 435 | 491 | 505 | 404 | 359 | 310 | 337 |

| 1959 | 360 | 342 | 406 | 396 | 420 | 472 | 548 | 559 | 463 | 407 | 362 | 405 |

| 1960 | 417 | 391 | 419 | 461 | 472 | 535 | 622 | 606 | 508 | 461 | 390 | 432 |

Assim, utilizando o Action para efetuar os cálculos, obtemos os resultados:

(há elementos em falta na equação acima)

(imagem em falta)

(imagem em falta)

(imagem em falta)

Neste caso, o comprimento sazonal é k = 12. Como esta série tem um comportamento sazonal e tendência bastante evidente, torna-se um caso ótimo para previsão utilizando a suavização de HW.

3.5 - Medidas de Acurácia

As estatísticas MAPE, MAD e MSD são informações importantes para comparmos os modelos de suavização e decidirmos se estes representam um bom ajuste aos nossos dados.

Média Percentual Absoluta do Erro (MAPE - Mean Absolute Percentage Erro)

Expressa a acurácia do erro em percentagem. Por exemplo, se temos um MAPE de 7%, quer dizer que o nosso ajuste esta errado em 7% dos dados.

Para calcular o MAPE utilizamos a seguinte formula:

$$ \frac{\sum_{t=1}^{n} |(y_t - \hat{y_t})/y_t|}{n}\times 100\quad\text{se } y_t \not= 0 $$

onde $ y_t $ são os nossos dados, $ \hat{y_t} $ são os ajustes e $ n $ é o número de observações. Note que se $ y_t = \hat{y_t} $ obtemos MAPE = 0, ou seja, quanto menor o MAPE melhor é o nosso ajuste.

Desvio Padrão Absoluto da Média (MAD - Mean Absolute Deviation)

Representa o desvio padrão do ajuste em relação à média nas mesmas unidades dos dados. Por exemplo, se estamos ajustando uma série temporal de visitas durante o tempo e encontramos um MAD de 72, quer dizer que o nosso ajuste possui um desvio padrão da média de 72 dias.

Para encontrarmos os MAD, realizamos o seguinte calculo:

$$ \frac{\sum_{t=1}^{n} |(y_t - \hat{y_t})|}{n} $$

onde $ y_t $ são os nossos dados, $ \hat{y_t} $ são os ajustes e $ n $ é o número de observações. Note que se $ y_t = \hat{y_t} $ obtemos MAD = 0, ou seja, quanto menor o MAD melhor é o nosso ajuste.

Desvio Padrão Quadrático da Média (MSD - Mean Squared Deviation)

Esta medida de acurácia é bastante comum em ajustes de séries temporais. Quando temos outliers em nosso conjunto de dados, essa medida é mais afetada do que o MAD. Portanto se temos um MAD baixo e um MSD alto podemos imaginar que temos outliers em nosso conjunto de dados.

Para calcularmos o MSD utlizamos a formula:

$$ \frac{\sum_{t=1}^{n} |(y_t - \hat{y_t})|^2}{n} $$

onde $ y_t $ são os nossos dados, $ \hat{y_t} $ são os ajustes e $ n $ é o número de observações. Note que se $ y_t = \hat{y_t} $ obtemos MSD = 0, ou seja, quanto menor o MSD melhor é o nosso ajuste.

4 - Modelos ARIMA

Esta metodologia consiste em ajustar modelos autorregressivos integrados de médias móveis, ARIMA(p,d,q), a um conjunto de dados. Para a construção do modelo seguimos um algorítimo no qual a escolha da estrutura do modelo é baseado nos próprios dados.

Podemos descrever o algorítimo através dos seguintes passos:

- Considera-se uma classe geral de modelos para a análise;

- identifica-se um modelo com base na análise de autocorrelações, autocorrelações parciais e outros critérios;

- estima-se os parâmetros do modelo identificado;

- verificar se o modelo ajustado é adequado aos dados através de uma análise de resíduos.

- Caso o modelo não seja adequado o algoritmo é repetido, voltando à fase de identificação.

Existem vários critérios para identificação de um modelo, por isso, é possível identificar modelos diferentes dependendo do critério que foi escolhido para identificação.

4.1 - Modelos Autorregressivos (AR)

Dizemos que $ {X_t, t \in Z} $ é um processo autorregressivo de ordem p e escrevemos $ X_t \sim AR(p) $ se podemos escrever o processo na seguinte forma

$$X_t = \phi_0 + \phi_1X_{t-1} + \dots + \phi_pX_{t-p} + \varepsilon_t$$

onde $ \phi_0, \phi_1, \dots , \phi_p $ são parâmetros reais e $ \varepsilon_t $ é i.i.d. com $ E(\varepsilon_t) = 0 $ e $ Var(\varepsilon_t) = \sigma^2 $.

Um caso particular simples de grande importância é o processo autorregressivo de ordem p = 1, AR(1)

$$X_t = \phi X_{t-1} + \varepsilon_t$$

Fazendo substituições sucessivas, $ X_{t-1}, X_{t-2} $, etc, na equação acima obtemos

$$X_t = \varepsilon_t + \phi\varepsilon_{t-1} + \phi^2\varepsilon_{t-2} + \dots = \sum_{j=0}^{\infty} \phi^j\varepsilon_{t-j} \hspace{6.0cm} (4.11)$$

onde a convergência é em média quadrática. Logo, a condição $ |\phi| < 1 $ é suficiente para que $ X_t $ seja estácionario.

Podemos calcular a função de autocovariância (f.a.c.v.) multiplicando ambos os lados de (4.11) por $ X_{t-\tau} $ e tomando a esperança

$$E(X_tX_{t-\tau}) = \phi E(X_{t-1}E_{t-\tau}) + \phi^2E(X_{t-2}X_{t-\tau}) + \dots + \phi^pE(X_{t-p}X_{t - \tau}) + E(\varepsilon_tX_{t-\tau})$$

$$\gamma_{\tau} = \phi\gamma_{\tau-1} = \dots = \phi^{\tau}\gamma_0$$

mas, sabemos que

$$\gamma_0 = \sigma^2_X = \sigma^2\sum^{\infty}_{j=0}\phi^{2j} = \frac{\sigma^2}{1 - \phi^2}$$

portanto, segue que

$$\gamma_{\tau} = \frac{\sigma^2}{1 - \phi^2}\phi^{|\tau|} , \quad \tau \in Z$$

Assim, a partir da função de autocovariância podemos calcular também a função de autocorrelação (f.a.c.)

$$\rho_{\tau} = \frac{\gamma_{\tau}}{\gamma_0} = \phi^{|\tau|}, \quad \tau \in Z$$

No caso geral, podemos calcular as funções de autocovariância e autocorrelação por

$$\gamma_j = \phi_1\gamma_{j-1} + \phi_2\gamma_{j-2} + \dots + \phi_p\gamma_{j-p}, \quad j > 0 $$

$$\rho_j = \phi_1\rho_{j-1} + \phi_2\rho_{j-2} + \dots + \phi_p\rho_{j-p}, \quad j > 0, \quad \quad (4.12)$$

respectivamente.

Se fizermos j = 1, 2, … , p, em (4.12) obtemos

$$\rho_1 = \phi_1 + \phi_2\rho_2 + \dots + \phi_p\rho_{p-1}$$

$$\rho_2 = \phi_1\rho_1 + \rho_2 + \dots + \phi_p\rho_{p-2}$$

$$\vdots \quad = \quad \vdots$$

$$\rho_p = \phi_1\rho_{p-1} + \phi_2\rho_{p-2} + \dots + \phi_p$$

que é um método recursivo para calcular as autocorrelações, conhecidas como equações de Yule-Walker.

Exemplo 4.1.1

Considere um modelo AR(1), com $ \phi = 0,7 $. Como $ -1 < \phi < 1 $ temos que o modelo satisfaz as condições de estacionariedade. Calculando a função de autocorrelação temos

$$\rho_j = \phi\rho_{j-1} = \phi^j, \quad j \ge 0.$$

Então, a função de autocorrelação decai exponencialmente, com valores todos positivos. Se $ \phi = 0,7 $, $ \rho_j = (0,7)^j $, $ j \ge 0 $, a função de auto correlação decairia exponencialmente para zero.

Como conhecemos $ \phi $ podemos calcular os $ \rho_j $ exatamente, mas normalmente precisamos estimar os valores de $ \phi $ e obtermos estimativas $ r_j $ para os valores da f.a.c

| j | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| $ \rho_j $ | 1,00 | 0,70 | 0,49 | 0,34 | 0,24 | 0,17 | 0,12 | 0,08 | 0,06 | 0,04 | 0,03 |

| $ r_j $ | 1,00 | 0,71 | 0,41 | 0,36 | 0,20 | 0,10 | -0,09 | -0,12 | -0,04 | -0,11 | -0,16 |

(imagem em falta)

4.2 - Modelos de Médias Móveis (MA)

Considere um processo linear $ (X_t, t \in Z) $, dizemos que este processo é de médias móveis de ordem q, denotado por MA(q), se satisfizer a equação de diferenças

$$X_t = a_t - \theta_1 a_{t-1} - \dots - \theta_q a_{t-q}$$

onde $ \mu, \theta_1, \dots , \theta_q $ são constantes reais, $ a_t $ é i.i.d. e $ a_t \sim N(0,\sigma^2) $.

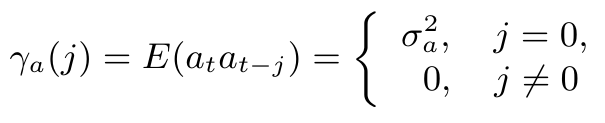

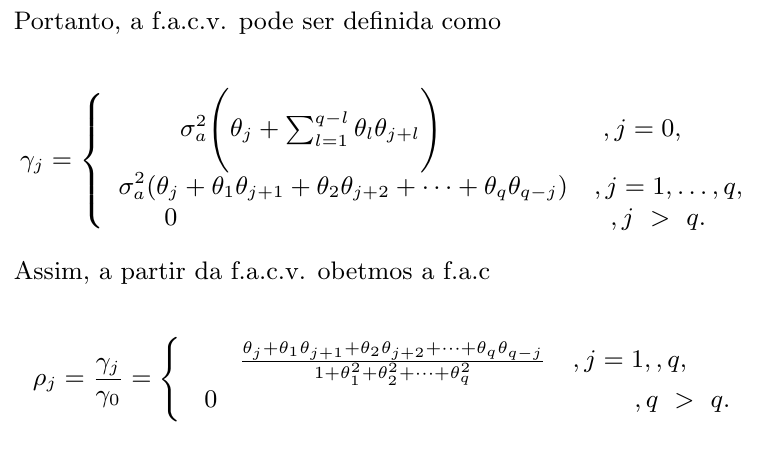

Segue que $ X_t $ é estacionário, de média $ \mu $. Suponha que $ \mu = 0 $, calculando a função de autocovariância(f.a.c.v.) do processo obtemos

$$\gamma_j = E(X_tX_{t-j}) = E\Bigg(\Bigg[a_t - \sum_{k=1}^q \theta_k a_{t-k} \Bigg] \Bigg[ a_{t-j} - \sum_{l=1}^q \theta_l a_{t-l-j} \Bigg[\Bigg)$$

$$\gamma_j = E(a_ta_{t-j}) - \sum_{k=1}^q E(a_{t-j}a_{t-k}) - \sum_{l=1}^q E(a_t a_{t-j-l}) + \sum_{k=1}^q\sum_{l=1}^q \theta_k \theta_l E(a_{t-l}a_{t-j-l})$$

Como os $ a_t $ são não correlacionados, temos

$$\gamma_0 = Var(X_t) = \sigma_X^2 = \sigma^2(1 + \theta_1^2 + \dots + \theta_q^2)$$

Então,

$$ \gamma_j = \gamma_a(j) - \sum_{k=1}^q \gamma_a(k-j) - \sum_{l=1}^q \gamma_a(j+l) + \sum_{k=1}^q\sum_{l=1}^q \theta_k \theta_l E(a_{t-l}a_{t-j-l})\gamma_a(j+l+k) $$

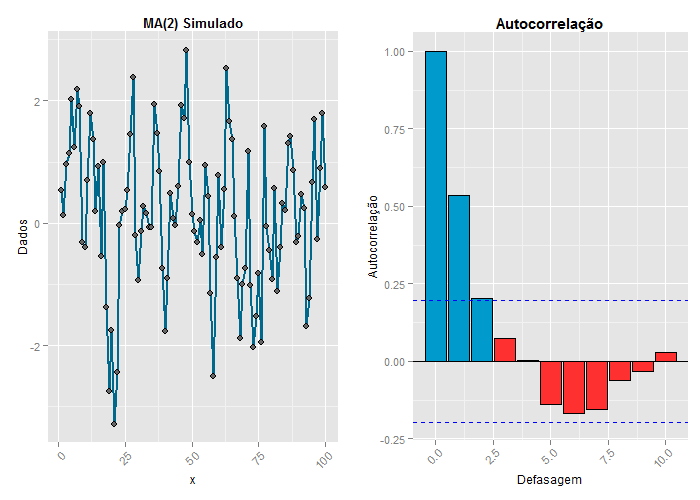

Exemplo 4.2.1

Considere a série simulada com 50 observações, geradas de acordo com um processo MA(2): $ X_t = a_t + 0,63a_{t-1} + 0,2a_{t-2} $ e $ \sigma^2_a = 1 $. Os dados deste exemplo podem ser obtidos clicando aqui.

Podemos calcular as f.a.c.v. e f.a.c. exatas por

$$\gamma_0 = (1 + \theta_1^2 + \theta_2^2)\sigma_a^2 = (1 + (0,63)^2 + (0,2)^2)1 = 1,437$$

$$\rho_1 = \frac{\theta_1(1 +\theta_2)}{1+\theta_1^2 + \theta_2^2} = \frac{0,63(1 - 0,2)}{1+0,63^2 + (0,2)^2} = 0,526;$$

$$\rho_2 = \frac{\theta_2}{1+\theta_1^2 + \theta_2^2} = \frac{0,2}{1+(0,63)^2+(0,2)^2} = 0,139;$$

$$\rho_j = 0, \quad j=3,4,5, \dots$$

| j | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| $ \rho_j $ | 1,00 | 0,526 | 0,139 | 0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| $ r_j $ | 1,00 | 0,536 | 0,202 | 0,073 | 0,004 | -0,138 | -0,168 | -0,154 | -0,061 | -0,031 | 0,028 |

4.3 - Modelos Autorregressivos e de Médias Móveis

Modelos autorregressivos e de médias móveis é a junção dos modelos AR e MA. Denotamos por ARMA(p,q) um processo autorregressivo e de médias móveis de ordem (p,q) e pode ser representado por

$$X_t = \phi_1X_{t-1} + \cdots \phi_pX_{t-p} + a_t - \theta_1a_{t-1} - \cdots - \theta_qa_{t-q}$$

Um modelo frequentemente utilizado é o ARMA(1,1), ou seja

$$X_t = \phi X_{t-1} + a_t - \theta a_{t-1}$$

No caso geral, calculamos a f.a.c.v. por

$$\gamma_j = \phi_1 \gamma_{j-1} + \phi_2 \gamma_{j-2} + \cdots + \phi_p \gamma_{j-p} +\gamma_{Xa}(j) - \theta_1\gamma_{Xa}(j-1) - \cdots - \theta_q\gamma_{Xa}(j-q)$$

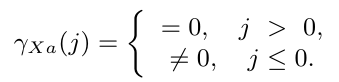

onde $ \gamma_{Xa}(j) $ é a covariância cruzada entre $ X_t $ e $ a_t $, definida por

Assim, a f.a.c.v. fica

$$\gamma_j = \phi_1\gamma_{j-1} + \phi_2\gamma_{j-2} + \cdots + \phi_p\gamma_{j-p}, \quad j \ > \ q$$

e a f.a.c. é obtida por

$$\rho_j = \frac{\gamma_j}{\gamma_0} = \phi_1\rho_{j-1} + \phi_2\rho_{j-2} + \cdots + \phi_p\rho_{j-p}, \quad j \ > \ q.$$

Um processo ARMA(p,q) tem f.a.c. infinita, a qual decai de acordo com exponenciais e/ou senoides amortecidas após o “lag” p-q. Essa observação é importante na identificação do modelo aos dados observados.

Exemplo 4.3.1

Considere um modelo ARMA(2,1) simulado com n = 200, dado por $ X_t = 0,26X_{t-1} + 0,37X_{t-2} + 0,81a_{t-1} + a_t. $

Calculando a função de autocorrelação estimada e teórica temos:

| $ \bold{j} $ | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| $ \bold{\rho_j} $ | 1,000 | 0,809 | 0,580 | 0,450 | 0,332 | 0,253 | 0,188 | 0,143 | 0,107 | 0,081 | 0,060 |

| $ \bold{r_j} $ | 1,000 | 0,779 | 0,519 | 0,405 | 0,312 | 0,195 | 0,044 | -0,028 | -0,052 | -0,121 | -0,187 |

(imagem em falta)

4.4 - Modelos Autorregressivos, Integrados e de Médias Móveis

Os modelos AR, MA e ARMA, são apropriados para descrever séries temporais estacionárias, isto é, séries que se desenvolvem no tempo ao redor de uma média constante.

Muitas séries encontradas na prática não são estacionárias, mas, como visto anteriormente, quando tomamos a série diferenciada esta se torna estacionária.

Modelos autorregressivos, integrados e de médias móveis (ARIMA) trata-se de representar série diferenciada por um modelo ARMA.

Seja $ Z_t $ uma série temporal não estacionária. Tomamos $ W_t = \Delta Z_t = Z_t - Z_{t-1} $ sendo a série diferenciada uma vez de $ Z_t $, denotamos por $ W_t^d = \Delta^d Z_t $ a série temporal diferenciada d vezes de $ Z_t $.

Podemos representar $ W_t $ por um modelo ARMA, como $ W_t $ é uma diferença de $ Z_t $ então, $ Z_t $ é uma integral de $ W_t $, assim dizemos que $ Z_t $ segue um modelo autorregressivo, integrado e de médias móveis, isto é, um modelo ARIMA de ordem (p,d,q) e escrevemos ARIMA(p,d,q) onde p é a ordem da componente autorregressiva, d é o número de diferenças tomadas na série e q é a ordem da componente de médias móveis.

Portanto, podemos descrever todos os modelos vistos anteriormente utilizando a nomenclatura ARIMA, isto é

i) ARIMA(p,0,0) = AR(p);

ii)ARIMA(0,0,q) = MA(q);

iii)ARIMA(p,0,q) = ARMA(p,q).

e no caso de uma série não estacionária utilizamos o modelo completo, ARIMA(p,d,q) com d diferenças na série original.

4.5 - Identificação de Modelos ARIMA

A identificação particular de um modelo ARIMA a ser ajustado aos dados pode ser considerado uma das fases mais críticas ao se utilizar uma modelagem ARIMA. A escolha do modelo a ser utilizado é feita principalmente com base nas autocorrelações e autocorrelações parciais estimadas, que utilizaremos para comparar com as quantidades teóricas e identificar um possível modelo para os dados.

Lembramos que a f.a.c. $ \rho_j $ é estimada por

$$r_j = \frac{g_j}{g_0}, \quad j = 0, 1, \dots , N-1$$

onde $ g_j $ é a estimativa da f.a.c.v. $ \gamma_j $, dado por

$$g_j = \frac{1}{N}\sum_{t=1}^{N-j} [(X_t - \bar{X})(X_{t+j} - \bar{X})], \quad j = 0,1,\dots , N-1$$

sendo $ \bar{X} = \frac{1}{N}\sum_{j=1}^{N}X_t $ a média amostral. Como as funções de auto correlação são funções pares, temos que $ g_{-j} = g_j $ e $ r_{-j} = r_{j} $.

Os modelos AR(p), MA(q) e ARMA(p,q) apresentam f.a.c. com características especiais:

i) um processo AR(p) tem f.a.c. infinita em extensão que decai de acordo com exponenciais e/ou senoides amortecidas;

ii) um processo MA(q) tem f.a.c. finita, no sentido que ela apresenta um corte após a defasagem q;

iii) um processo ARMA(p,q) tem f.a.c. infinita que decai de acordo com exponencias e/ou senoides amortecidas após a defasagem (q-p).

Assim, a partir das f.a.c. estimadas, tentamos identificar um padrão que se comporte teoricamente com algum modelo. Em particular, a f.a.c. estimada é útil para identificar modelos MA por causa da característica (ii) e não são muito úteis na identificação de modelos ARMA, que possuem f.a.c. complicadas.

Função de Autocorrelação Parcial (f.a.c.p.)

Uma outra ferramenta utilizada no processo de identificação do modelo é a função de autocorrelação parcial(f.a.c.p.). Esta medida corresponde a correlação de $ X_t $ e $ X_{t-k} $ removendo o efeito das observações $ X_{t-1}, X_{t-2}, \dots , X_{t-k+1} $ e é denotada por $ \phi_{kk} $, ou seja

$$\phi_{kk} = Corr(X_t, X_{t-l}/X_{t-1}, X_{t-2},\dots,X_{t-k+1})$$

Um método geral para encontrar a f.a.c.p. para um processo estacionário com f.a.c. $ \rho_k $ é utilizando as equações de Yule-Walker, isto é, para um certo k temos

$$\rho_j = \phi_{k1}\rho_{j-1} + \phi{k2}\rho_1 + \cdots + \phi_{kk}\rho{j-1}, \quad j = 1, 2, \dots , k$$

Desenvolvendo a equação temos

$$\rho_1 = \phi_{k1} + \phi_{k2}\rho_1 + \cdots + \phi_{kk}\rho_{j-1}$$

$$\rho_2 = \phi_{k1}\rho_1 + \phi_{k2} + \cdots + \phi_{kk}\rho_{j-2}$$

$$\quad \vdots \quad = \quad \vdots$$

$$\rho_j = \phi_{k1}\rho_{j-1} + \phi_{k2}\rho_{j-2} + \cdots + \phi_{kk}$$

Resolvendo as equações acima sucessivamente para k = 1, 2, …, obtemos $ \phi_{kk} $ da seguinte maneira

$ \phi_{11} = \rho_1 $

em geral temos

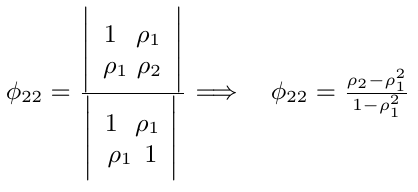

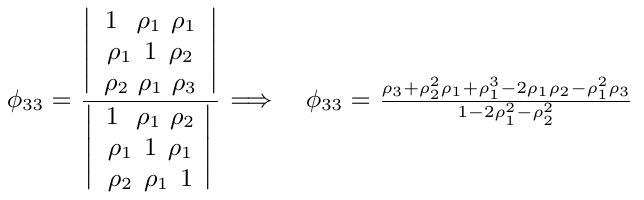

$$\phi_{kk} = \frac{|P^*_k|}{|P_k|}$$

onde $ P_k $ é a matriz de autocorrelação, e $ P^*_k $ é a matriz $ P_k $ com a ultima coluna substituída pelo vetor de autocorrelação.

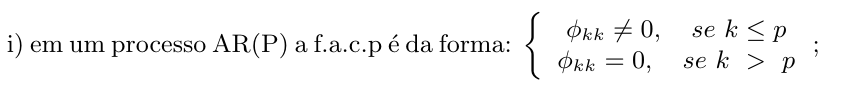

Nos processos AR, MA e ARMA temos as seguintes f.a.c.p. teóricas:

ii)em um processo MA(q) a f.a.c.p. se comporta de maneira similar à f.a.c. de um processo AR(p), isto é, composta por exponenciais e\ou senoides amortecidas;

iii)um processo ARMA(p,q) tem f.a.c.p. que se comporta como a f.a.c.p. de um processo MA puro.

Devido aos fatores acima, segue que a f.a.c.p. é útil para identificar modelos AR puros, não sendo tão útil para identificar modelos MA e ARMA.

Uma maneira simples de estimar as f.a.c.p. de um processo consistem em substituir nas equações de Yullie-Walker as f.a.c. por sua estimativas

$$r_j = \hat{\phi_{k1}}r_{j-1} + \cdots + \hat{\phi_{kk}}r_{j-k}, \quad j=1,\dots,k,$$

e resolver estas equações para k=1, 2, 3,….

Exemplo 4.5.1

Observe na tabela abaixo uma estimativa das f.a.c.p. dos processos AR(1), MA(1) e ARMA(1,1), de séries temporais simuladas computacionalmente com 100 observações cada.

| j | AR(1) | MA(1) | ARMA(1,1) |

|---|---|---|---|

| 1 | -0,4514 | 0,3828 | -0,0187 |

| 2 | -0,0640 | -0,2738 | -0,0833 |

| 3 | -0,0460 | -0,0710 | -0,1950 |

| 4 | -0,0305 | -0,1540 | 0,1094 |

| 5 | 0,0144 | -0,0599 | -0,0949 |

| 6 | -0,0425 | -0,0412 | 0,0537 |

| 7 | 0,0939 | -0,0412 | 0,0708 |

| 8 | -0,0470 | -0,1616 | -0,1851 |

| 9 | -0,0256 | 0,0528 | 0,1552 |

| 10 | 0,0080 | -0,0296 | 0,0474 |

| 11 | -0,0754 | -0,0305 | -0,1351 |

| 12 | 0,0846 | -0,1096 | -0,0056 |

| 13 | 0,0457 | -0,0883 | 0,0532 |

| 14 | 0,0330 | 0,0115 | -0,0495 |

| 15 | -0,0132 | 0,0761 | 0,0547 |

Representadas graficamente por:

(imagem em falta)

Critérios de informação AIC e BIC

Após selecionarmos possíveis modelos ARIMA para os dados observados, identificamos o melhor modelo possível utilizando os critérios AIC e BIC. Queremos encontrar as ordens k e l que minimizam os critérios AIC e BIC para a determinação das ordens p e q do modelo, isto é, queremos minimizar

$$AIC(k,l) = -2ln(\hat{\sigma}^2_{k,l}) + 2(k+l+2)$$

$$BIC(k,l) = -2ln(\hat{\sigma}^2_{k,l}) + (k+l)\frac{lnN}{N}$$

onde, N é o número de observações e $ \hat{\sigma}_{k,l}^2 $ é o estimador de máxima verossimilhança da variância residual do modelo ARMA(k,l).

Exemplo 4.5.2

Considere os retornos das ações da Petrobras durante o período de 10/01/2008 a 10/02/2008. Construímos uma série temporal utilizando a média dos retornos em cada hora por dia, com um total de 110 observações. Vamos identificar um modelo ARIMA para esta série.

| j | $ X_j $ | j | $ X_j $ | j | $ X_j $ | j | $ X_j $ | j | $ X_j $ |

|---|---|---|---|---|---|---|---|---|---|

| 1 | -0,0012 | 23 | 0,0004 | 45 | -0,0011 | 67 | 0,0106 | 89 | -0,0036 |

| 2 | 0,0006 | 24 | -0,0035 | 46 | -0,0149 | 68 | -0,0025 | 90 | 0,0001 |

| 3 | -0,0059 | 25 | 0,0019 | 47 | 0,0003 | 69 | 0,0058 | 91 | -0,0030 |