7. TÉCNICAS NÃO PARAMÉTRICAS

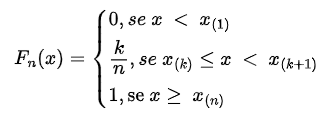

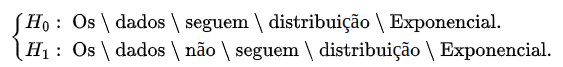

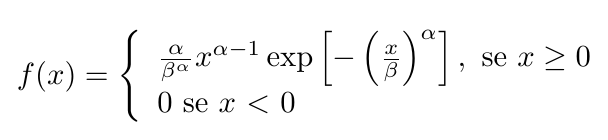

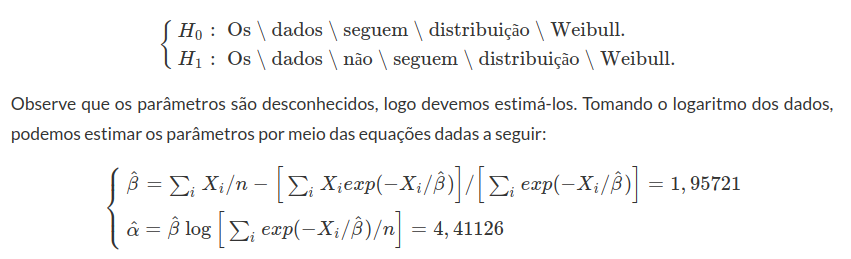

Todos os procedimentos básicos de estatística - o teste T, o teste F, a análise de variância (ANOVA), entre outros - dependem fortemente da suposição de que os dados da amostra (ou as estatísticas suficientes) estejam distribuídos de acordo com uma distribuição específica. Mas, para cada teste clássico, existe uma alternativa não-paramétrica com menos hipóteses sobre os dados. Mesmo se as hipóteses a partir de um modelo paramétrico são modestas e pouco restritivas, elas serão, sem dúvida, falsas, no sentido mais puro.

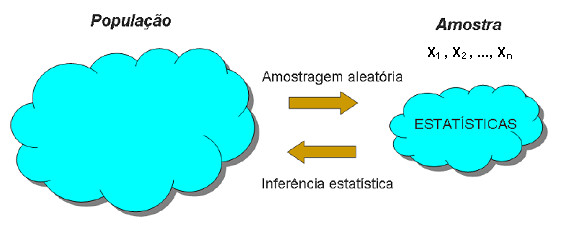

Os testes paramétricos assumem que a distribuição de probabilidade da população no qual retiramos os dados seja conhecida e que somente os valores de certos parâmetros, tais como a média e o desvio padrão, sejam desconhecidos. Se os dados não satisfazem as suposições assumidas pelas técnicas tradicionais, métodos não paramétricos de inferência estatística devem usados. As técnicas não paramétricas assumem pouca ou nenhuma hipótese sobre a distribuição de probabilidade da população no qual retiramos os dados

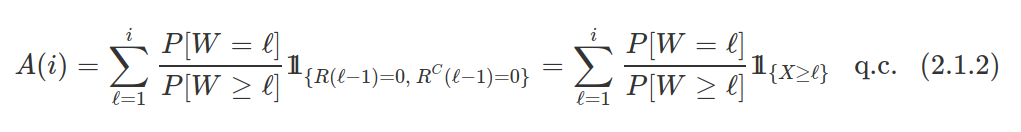

A partir dos anos de 1940, a ideia de testes de postos (ranks) ganharam força na literatura estatística. Hotelling e Pabst (1936) escreveram um dos primeiros artigos sobre o assunto, as correlações de ordem. Desde então, temos testes não-paramétricos para uma amostra, para comparação de duas ou mais amostras, para amostras pareadas, correlação bivariada e muito mais. A chave para avaliar os dados em uma estrutura não-paramétrica é comparar observações com base em seus postos no interior da amostra. A tabela a seguir mostra as analogias dos testes não-paramétricos para os procedimentos conhecidos paramétricos.

| Paramétrico | Não-Paramétrico |

|---|---|

| Coeficiente de Pearson para Correlação | Coeficiente de Spearman para Correlação |

| Teste-t 1 Amostra | Teste de Wilcoxon 1 Amostra |

| Teste-t Pareado | Teste de Wilcoxon Pareado |

| Teste-t 2 Amostras | Teste de Wilcoxon-Mann-Whitney Amostras Independentes |

| ANOVA | Teste de Kruskal-Wallis |

| ANOVA experimento fatorial em blocos | Teste de Friedman |

Figura: Frank Wilcoxon (1892-1965). Henry Berthold Mann (1905-2000) e Professor Emeritus Donald Ransom Whitney.

Em geral, os métodos não paramétricos são aplicados em problemas de inferência no qual as distribuições das populações envolvidas não precisam pertencer a uma família específica de distribuições de probabilidade tal como Normal, Uniforme, Exponencial etc. Por isso, os testes não paramétricos são também chamados testes livres de distribuição (“distribution free tests”).

1 - Teste de Wilcoxon - Amostra Única

Consideremos uma população P com distribuição contínua e simétrica no qual retiramos uma amostra aleatória $X_{1}$, $X_{2}$, …, $X_{n}$ . Nosso interesse é estudar o comportamento da mediana populacional com relação a um valor $θ_{0}$ especificado.

O teste de Wilcoxon é baseado nos postos (ranks) dos valores obtidos. Postos são as posições, representados por números, que os valores ocupam quando colocados em ordem crescente. Por exemplo, considere o seguinte conjunto de valores:

| 12 | 17 | 15 | 19 | 14 | 16 | 11 |

|---|

Colocando em ordem crescente e atribuindo a cada valor seu posto, temos

| Valor | 11 | 12 | 14 | 15 | 16 | 17 | 19 |

|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3 | 4 | 5 | 6 | 7 |

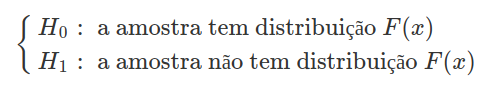

As seguintes hipóteses são necessárias para o desenvolvimento deste teste de hipóteses:

-

As observações $X_{i}$’s são independentes.

-

Cada observação $X_{i}$ é obtida de uma população que é contínua e simétrica em torno de $θ_{0}$. Desta forma, admitimos que a probabilidade (em teoria) de que dois valores amostrais coincidam é zero.

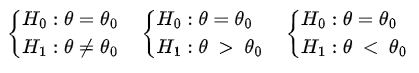

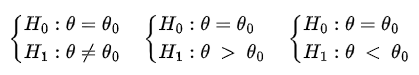

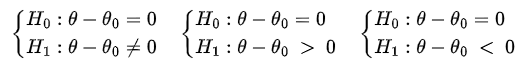

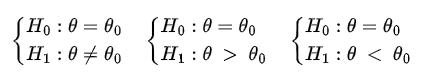

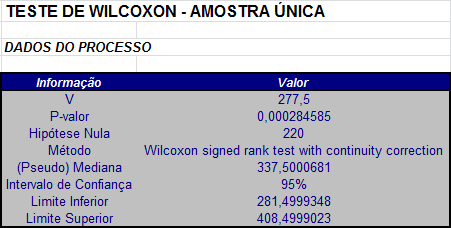

Para a realização do teste de Wilcoxon estabelecemos uma das seguintes hipóteses:

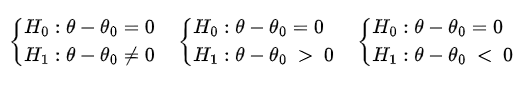

que são equivalentes as hipóteses

Inicialmente devemos subtrair $θ_{0}$ de cada valor $X_{i}$, i = 1, …, n, da amostra e assim obtemos um novo conjunto de dados, $Z_{1}$, $Z_{2}$, …, $Z_{n}$ onde $Z_{i}$ = $X_i-θ_{0}$.

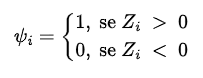

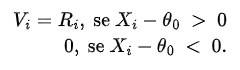

Ordenamos de forma crescente o novo conjunto de dados {$|Z_{1}|, |Z_{2}|, …, |Z_{n}|$} (observe que ordenamos o conjunto dos valores absolutos, ou seja, não consideramos o sinal do elemento $Z_{i}$) e associamos a cada valor $Z_{i}$ o posto $R_{i}$ correspondente. A seguir, definimos as variáveis indicadoras $ψ_{i}$, i = 1, 2, …, n, dadas por

ou seja, se $X_i-θ_{0 }$> 0, então $ψ_{i }$= 1, caso contrário, $ψ_{i}$ = 0.

Obtemos os n produtos $R_1ψ_{1}$, …, $R_nψ_{n}$. Cada produto $R_iψ_{i}$ é chamado posto positivo de $Z_{i}$. Neste caso, se $Z_{i}$ > 0, $R_iψ_{i}$ é igual ao posto $R_{i}$ correspondente e se $Z_{i}$ < 0, $R_iψ_{i}$ é igual a 0.

Definimos a estatística $T^{+}$ como a soma dos postos que têm sinal positivo, ou seja, $$T^+=\sum_i^n R_i\psi_i$$

Exemplo 1.1

Considere a seguinte amostra

| 126 | 142 | 156 | 228 | 245 | 246 |

|---|---|---|---|---|---|

| 370 | 419 | 433 | 454 | 478 | 503 |

Suponha que os dados da amostra são distribuídos simetricamente em torno da mediana $θ_{0}$ = 220.

Subtraindo o valor 220 de cada valor da amostra temos um novo conjunto de dados:

| -94 | -78 | -64 | 8 | 25 | 26 | 150 | 199 | 213 | 234 | 258 | 283 |

|---|

Colocando em ordem crescente os valores absolutos, associamos à cada valor o posto correspondente $(R_{i}$) e as variáveis indicadoras $ψ_{i}$.

| Valor | 8 | 25 | 26 | -64 | -78 | -94 | 150 | 199 | 213 | 234 | 258 | 283 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| ψi | 1 | 1 | 1 | 0 | 0 | 0 | 1 | 1 | 1 | 1 | 1 | 1 |

Tabela 1.1: Postos combinados para uma amostra única.

Neste caso, a estatística $T^{+}$ é a soma dos postos positivos, isto é $$T^+=\sum_{i=1}^{12} R_i\psi_i = 1 + 2 + 3 + 7 + 8 + 9 + 10 + 11 + 12 = 63.$$

1.1 - Um estimador do parâmetro de posição

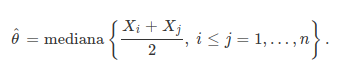

Na tentativa de estimar o parâmetro de posição θ, consideraremos as médias ($X_i$+$X_j$)/2 entre as observações $X_i$ e $X_j$ tais que i ≤ j. Neste caso, se temos n observações da população, segue que temos M = n(n+1)/2 médias desse tipo. O estimador de θ associado com a estatística $T^{+}$ do teste de Wilcoxon é

Sejam $W^{(1)}$, $W^{(2)}$, …, $W^{(M)}$ os valores ordenados de $(X_i+X_j)/2$ com i ≤ j. Então, se M é ímpar, ou seja, M = 2k + 1, então k = (M-1)/2 e $$\hat{\theta}=W^{(k+1)},$$

que é o valor que ocupa a posição k + 1 na lista de médias ($X_i+X_j$)/2. Se M é par, ou seja, M = 2k, então k = M/2 e $$\hat{\theta}=\frac{W^{(k)}+W^{(k+1)}}{2}.$$

Isto é, quando M é par, $\hat{\theta}$ é a média dos dois valores ($X_i+X_j$)/2 que ocupam as posições k e k + 1.

Definição 1.1.1

O estimador $\hat{\theta}$ é chamado de pseudo-mediana.

Exemplo 1.1.1

Encontre a pseudo-mediana para o seguinte conjunto de dados

| -4 | -3 | -1 | 2 | 5 | 6 |

|---|

Temos que as médias ($X_i+X_j$)/2 entre as observações $X_i$ e $X_j$ tais que i ≤ j ordenadas são dadas na tabela abaixo

| -4 | -3,5 | -3 | -2,5 | -2 | -1 | -1 |

|---|---|---|---|---|---|---|

| -0,5 | 0,5 | 0,5 | 1 | 1 | 1,5 | 2 |

| 2 | 2,5 | 3,5 | 4 | 5 | 5,5 | 6 |

Como temos 6 observações, temos 6(6+1)/2 = 21 médias entre as observações $X_i$ e $X_j$ com i ≤ j. Como M = 21 é um número ímpar, então temos que a pseudo-mediana será a observação 11, ou seja $$\hat{\theta}=1.$$

1.2 - Distribuição exata da estatística de Wilcoxon

Para encontrar a distribuição exata de $T^{+}$ sob $H_0$, considere B o número de $Z_i’s$ positivos ($Z_i = X_i - θ_0$) e sejam $r_1$ < … < $r_B$ os ranks (posições) ordenadas dos valores absolutos destes $Z_i’s$ positivos. Podemos obter a distribuição diretamente da representação $T^+=\sum_{i=1}^Br_i$. Sob a hipótese de que as distribuições de cada $Z_i$ são todas contínuas, a probabilidade de que os valores absolutos de $Z_i’s$ sejam iguais ou que algum $Z_i$ seja 0 é zero. Além disso, sob $H_0$ as distribuições de todos os $Z_i’s$ são simétricas em torno de θ = $θ_0$. Portanto, se temos uma amostra de n elementos, temos 2^n possibilidades para a configuração ($r_1, r_2, …, r_B$) e cada uma delas ocorre com probabilidade (1/2)^n. Neste caso, temos que

$$P(T^+=t)=\frac{u(t)}{2^n}$$

onde u(t) é o número de maneiras de atribuir valores para as configurações ($r_1, r_2, …, r_B$) de forma que $$\sum_{i=1}^Br_i=t.$$

Exemplo 1.2.1

Considere o caso em que temos uma amostra de n = 3 elementos.

Neste caso, temos $2^3$ = 8 possíveis configurações para ($r_1, r_2, …, r_B$) e os valores associados de $T^{+}$ são dados na seguinte tabela.

| B | (r1, r2, …, rB) | Probability under $H_0$ | $ T^+=\sum_{i=1}^Br_i $ |

|---|---|---|---|

| 0 | 1/8 | 0 | |

| 1 | r1 = 1 | 1/8 | 1 |

| 1 | r1 = 2 | 1/8 | 2 |

| 1 | r1 = 3 | 1/8 | 3 |

| 2 | r1 = 1, r2 = 2 | 1/8 | 3 |

| 2 | r1 = 1, r2 = 3 | 1/8 | 4 |

| 2 | r1 = 2, r2 = 3 | 1/8 | 5 |

| 3 | r1 = 1, r2 = 2, r3 = 3 | 1/8 | 6 |

Assim, para este exemplo, a probabilidade de $T^{+}$ ser igual a 3 (P[$T^{+}$ = 3]) é igual a 2/8 já que o evento $T^{+}$ = 3 ocorre quando B = 1 ($r_1 = 3$) ou quando B = 2 ($r_1 = 1, r_2 = 2$) e cada uma dessas ocorrências ocorre com probabilidade 1/8.

| $T^{+}$ | Probabilidade sob $H_0$ |

|---|---|

| 0 | 1/8 |

| 1 | 1/8 |

| 2 | 1/8 |

| 3 | 2/8 |

| 4 | 1/8 |

| 5 | 1/8 |

| 6 | 1/8 |

Em um teste de Wilcoxon em que o tamanho amostral n é pequeno (geralmente n < 50) utilizamos a distribuição exata da estatística $T^{+}$ e, a partir desta distribuição, calculamos os valores críticos do teste, o p-valor e o intervalo de confiança.

- Cálculo dos valores críticos.

Se estamos realizando um teste bilateral, então devemos encontrar os valores críticos $t_1$ e $t_2$ tais que $$P[T^+ \ < \ t_1] = P[T^+ \ > \ t_2]\approx \frac{\alpha}{2}.$$

Se o teste é unilateral à direita, então devemos encontrar o valor crítico t tal que $$P[T^+ \ > \ t] \approx \alpha$$

e se o teste é unilateral à esquerda, então devemos encontrar o valor crítico t tal que $$P[T^+ \ < \ t] \approx \alpha.$$

- Critério.

Se o teste é bilateral e

$$T^{+}_{obs} < t_1$$

ou $$T^{+}_{obs} > t_2$$

então rejeitamos $H_0$, caso contrário não rejeitamos $H_0$. Ou seja, se $t_1$ ≤ $T^{+}_{obs}$ ≤ $t_2$, não rejeitamos a hipótese nula $H_0$.

No caso do teste unilateral à direita, se $T^{+}$ > t, rejeitamos a hipótese $H_0$, caso contrário não rejeitamos $H_0$. Isto é, se $T^{+}$ ≤ t não rejeitamos a hipótese nula $H_0$.

Se o teste é unilateral à esquerda e $T^{+}$ < t, rejeitamos a hipótese $H_0$, caso contrário não rejeitamos $H_0$. Isto é, se $T^{+}$ ≥ t não rejeitamos a hipótese nula $H_0$.

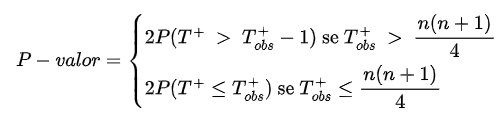

- Cálculo do p-valor.

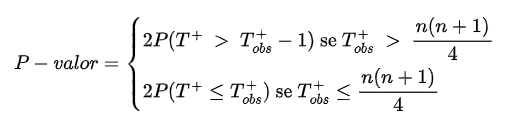

Se o teste é bilateral, o p-valor do teste exato é dado por

Se o teste é unilateral à direita, o p-valor do teste exato é dado por $$P-valor=P(T^+ \ > \ T^+_{obs}-1)$$

e se o teste é unilateral à esquerda, o p-valor do teste exato é dado por $$P-valor=P(T^+ \leq \ T^+_{obs}).$$

- Intervalo de Confiança para o parâmetro de posição.

De forma análoga à estimativa do parâmetro de posição, consideramos as médias $(X_i+X_j)/2$ entre as observações $X_i$ e $X_j$ tal que i ≤ j. Neste caso, se temos n observações da população, segue que temos M = n(n+1)/2 médias desse tipo.

Sejam $W^{(1)}, W^{(2)}, …, W^{(M)}$ os valores ordenados desta médias.

Se o teste é bilateral e o nível de significância é α encontramos os valores L e U tais que $$P(T^+ \leq L)\approx \frac{\alpha}{2} \qquad U = \frac{n(n+1)}{2}-L$$

e o intervalo de confiança 100(1-α)% para o parâmetro de posição θ é então dado por $$IC_{1-\alpha}(\theta)=(W^{(L)},W^{(U+1)}).$$

Se o teste é unilateral à direita, encontramos o valor L tal que $$P(T^+ \leq L)\approx \alpha$$

e o intervalo de confiança 100(1-α)% para o parâmetro de posição θ é então dado por $$IC_{1-\alpha}(\theta)=(W^{(L)},\infty).$$

Se o teste é unilateral à esquerda, encontramos os valores L e U tais que $$P(T^+ \leq L)\approx \alpha \qquad U = \frac{n(n+1)}{2}-L$$

e o intervalo de confiança 100(1-α)% para o parâmetro de posição θ é então dado por $$IC_{1-\alpha}(\theta)=(-\infty,W^{(U+1)}).$$

Exemplo 1.2.2

Considere a seguinte amostra

| 126 | 142 | 156 | 228 | 245 | 246 |

|---|---|---|---|---|---|

| 370 | 419 | 433 | 454 | 478 | 503 |

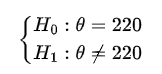

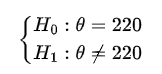

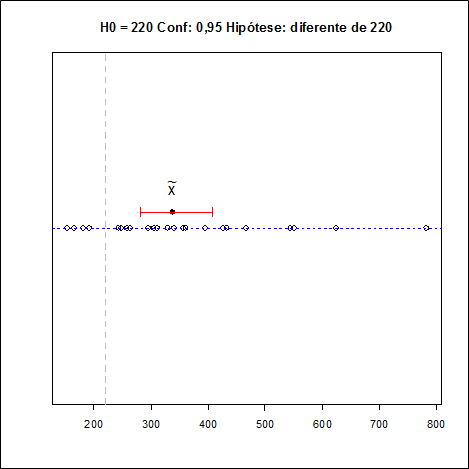

Vamos testar, com um nível de significância α = 0,05, se os dados estão distribuídos simetricamente em torno de $θ_0$ = 220.

- Estabelecemos as hipóteses

já que queremos testar se os dados estão ou não distribuídos simetricamente em torno $θ_0$ = 220.

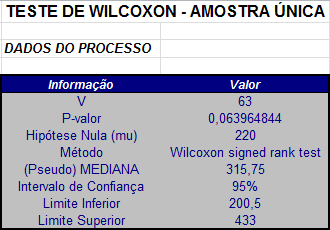

Como já vimos no Exemplo 1.1, o valor da estatística $T^{+}$ é dado por $T^{+}$ = 63.

- Cálculo dos valores críticos.

Como estamos realizando um teste bilateral, devemos encontrar os valores $t_1$ e $t_2$ tais que $$P(T^+ \ < \ t_1) = P(T^+ \ > \ t_2)\approx \frac{\alpha}{2}.$$

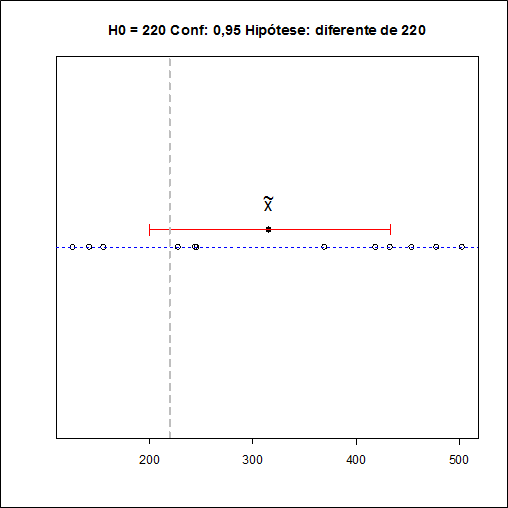

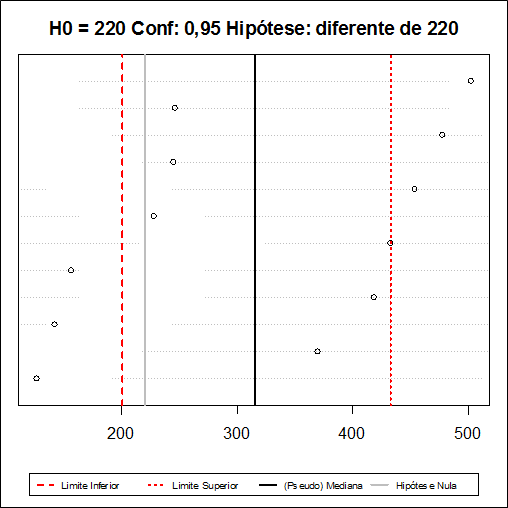

Neste caso, temos que os valores $t_1$ e $t_2$ são dados por $t_1$ = 14 e $t_2$ = 64. Como $t_1$ = 14 < $T^{+}_{obs}$ = 63 < $t_2$ = 64, então não rejeitamos a hipótese nula de que os dados estão distribuídos simetricamente em torno de $θ_0$ = 220.

- Cálculo do p-valor.

Como o teste é bilateral, o p-valor do teste exato é dado por

Temos que n(n+1)/4 = 52 e como $T^{+}_{obs}$ = 63 > 52, segue que

$$P-valor = 2P(T^+ \ > \ T^+_{obs}-1) = 2P(T^+ \ > \ 62) = 0,06396484.$$

- Intervalo de confiança.

Para se calcular o intervalo de confiança, consideramos os valores ordenados das médias $(X_i+X_j)/2$ com i ≤ j. Estes valores estão calculados na tabela abaixo:

Médias ordenadas $(Xi+Xj)/2$:

| 126 | 134 | 141 | 142 | 149 | 156 |

|---|---|---|---|---|---|

| 177 | 185 | 185,5 | 186 | 192 | 193,5 |

| 194 | 200,5 | 201 | 228 | 236,5 | 237 |

| 245 | 245,5 | 246 | 248 | 256 | 263 |

| 272,5 | 279,5 | 280,5 | 287,5 | 287,5 | 290 |

| 294,5 | 298 | 299 | 302 | 305 | 307,5 |

| 308 | 310 | 314,5 | 317 | 322,5 | 323,5 |

| 329,5 | 330,5 | 332 | 332,5 | 339 | 339,5 |

| 341 | 349,5 | 350 | 353 | 361,5 | 362 |

| 365,5 | 370 | 374 | 374,5 | 394,5 | 401,5 |

| 412 | 419 | 424 | 426 | 433 | 436,5 |

| 436,5 | 443,5 | 448,5 | 454 | 455,5 | 461 |

| 466 | 468 | 478 | 478,5 | 490,5 | 503 |

Encontramos agora os valores L e U tais que $$P(T^+\leq L)\approx\alpha/2 \qquad U = \frac{n(n+1)}{2}-L.$$

Neste caso, temos que L = 14 e U = 64 e o intervalo de confiança com será dado por $$IC_{1-\alpha}(\theta)=(W^{(14)},W^{(65)})=(200,5;433).$$

- Estimador para o parâmetro de posição (pseudo-mediana)

A partir da tabela das médias acima, temos que a quantidade total dessas médias é M = 78 = 2k com k = 39. Neste caso, segue que $$\hat{\theta}=\frac{W^{(k)}+W^{(k+1)}}{2}=\frac{314,5+317}{2}=315,75.$$

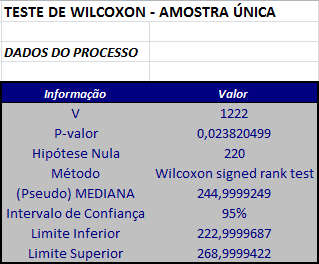

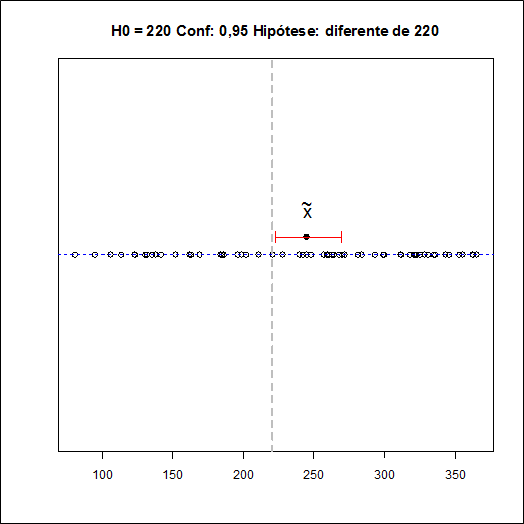

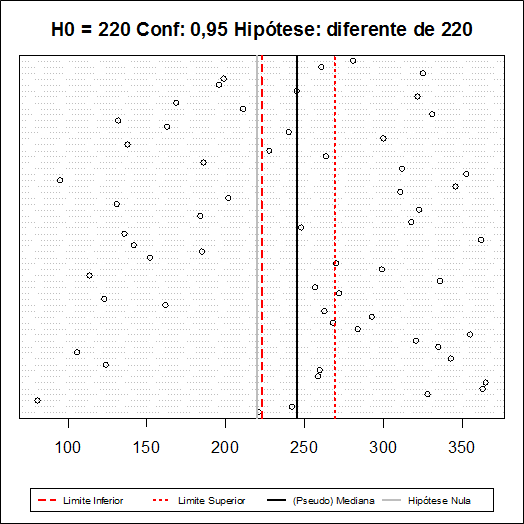

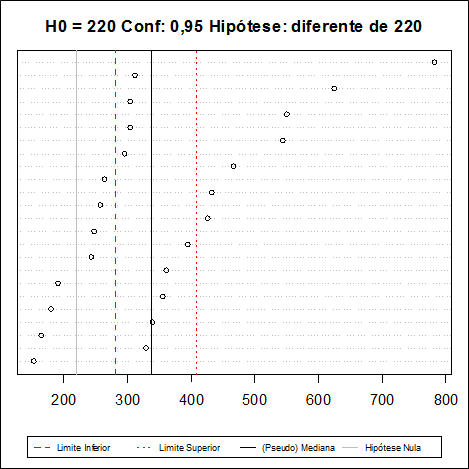

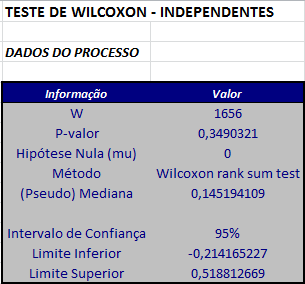

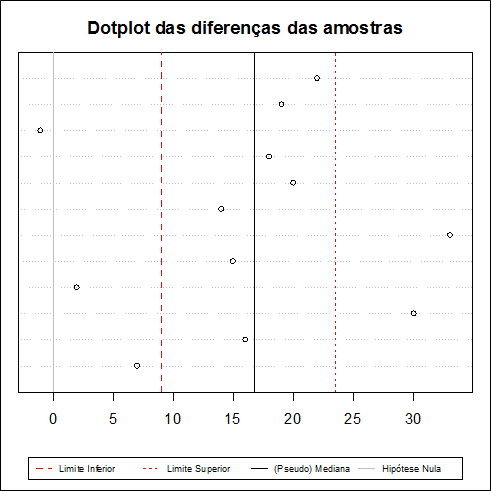

Utilizando o software Action, os resultados são dados a seguir

1.3 - Aproximação Normal

Para amostras de tamanho n > 50, utilizamos uma aproximação normal. Consideremos a estatística $T^{+}$ como dada anteriormente, ou seja, $T^{+}$ é a soma de todos os postos positivos.

Teorema 1.3.1

Sob a hipótese nula, ou seja, sob a hipótese de que os valores $X_{i }$estão igualmente distribuídos em torno do valor $θ_{0}$ temos que o valor esperado de $T^{+}$, $E_{0}$($T^{+}$), e a variância de $T^{+}$, $Var_{0}$($T^{+}$), são dados pelas fórmulas abaixo $$E(T^+ \mid \theta=\theta_0)=\frac{n(n+1)}{4} \quad \hbox{e} \quad Var(T^+ \mid \theta=\theta_0)=\frac{n(n+1)(2n+1)}{24}$$

Demonstração

Para cada i, considere a variável aleatória $V_{i}$ dada por

Sob a hipótese $H_{0}$, temos que os valores de $X_{i}$ estão igualmente distribuídos em torno de $θ_{0}$, desta forma as variáveis aleatórias $V_{i}$ são igualmente distribuídas com a seguinte distribuição de probabilidade $$P(V_i=i) =P(V_i=0)=\frac{1}{2}$$

para i = 1, 2, …, n. Desta forma, temos que $$E(T^+ \mid \theta=\theta_0)=E\left[\sum_{i=1}^n V_i \mid \theta=\theta_0\right]=\sum_{i=1}^n E [V_i \mid \theta=\theta_0]= \frac{1}{2} \sum_{i=1}^n i=\frac{1}{2}\left[\frac{n(n+1)}{2}\right]=\frac{n(n+1)}{4}$$

e $$Var(T^+\mid\theta=\theta_0)=\sum_{i=1}^n Var(V_i \mid \theta=\theta_0)=\sum_{i=1}^n E(V_i^2 \mid \theta=\theta_0)-[E(V_i \mid \theta=\theta_0)]^2=$$

$$\sum_{i=1}^n \left(\frac{i^2}{2}-\frac{i^2}{4}\right)=\frac{i^2}{4}$$

ou seja, $$Var(T^+ \mid \theta=\theta_0)=\frac{1}{4}\sum_{i=1}^n i^2= \frac{1}{4}\left[\frac{n(n+1)(2n+1)}{6}\right] = \frac{n(n+1) (2n+1)} {24}$$

como queríamos demonstrar.

Aproximação Normal

Utilizando resultados assintóticos, temos que a estatística Z, dada por $$Z = \frac{T^+-E_0(T^+)}{\sqrt{Var_0(T^+)}}=\frac{T^+-\frac{1}{4}n(n+1)}{\sqrt{[n(n+1) (2n+1)/24]}} \qquad (1.3.1)$$

tem distribuição aproximadamente Normal com média 0 e variância 1. Então o teste fica reduzido para um teste normal padrão.

Os passos para a realização deste teste:

- Estabelecemos as seguintes hipóteses:

que são equivalentes as hipóteses

-

Primeiramente devemos subtrair $θ_{0}$ de cada valor $X_{i}$, i = 1, 2, …, n, da amostra e assim obtemos um novo conjunto de dados, $(X_1-θ_{0}$, $X_2-θ_{0}$, …, $X_n-θ_{0}$).

-

Ordenamos de forma crescente de magnitude os valores desse novo conjunto de dados e associamos a cada valor o posto correspondente, tendo cada posto o mesmo sinal do valor que este representa.

-

Calculamos o valor da estatística $T^{+}$.

-

Calculamos o valor de $Z_{obs}$ através da equação (1.3.1) . Em seguida, fixamos o nível de significância α.

-

Encontramos os valores críticos referentes ao nível de significância α fixado.

-

Se o teste é bilateral, os valores críticos são $-Z_{\alpha/2}$ e $Z_{\alpha/2}$.

-

Se o teste é unilateral à direita, o valor crítico é $Z_{\alpha}$.

-

Se o teste é unilateral à esquerda, o valor crítico é $-Z_{\alpha}$.

- Critério de rejeição:

-

Se o teste é bilateral, rejeitamos a hipótese nula se $Z_{obs} \ > \ Z_{\alpha/2}$ ou se $Z_{obs} \ < \ -Z_{\alpha/2}$, caso contrário, não rejeitamos a hipótese nula.

-

Se o teste é unilateral à direita, rejeitamos a hipótese nula se $Z_{obs} \ > \ Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

-

Se o teste é unilateral à esquerda, rejeitamos a hipótese nula se $Z_{obs} \ < \ -Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

- Cálculo do p-valor

-

Se o teste é bilateral, então o p-valor é dado por $$P-valor = P[|Z| \ > \ |Z_{obs}||H_0] = 2 P[Z \ > |Z_{obs}|].$$

-

Se o teste é unilateral à direita, então o p-valor é dado por $$P-valor = P[Z \ > \ Z_{obs}|H_0].$$

-

Se o teste é unilateral à esquerda, então o p-valor é dado por $$P-valor = P[Z \ < \ Z_{obs}|H_0].$$

Aproximação normal com correção de continuidade

Como estamos utilizando uma distribuição contínua, é conveniente utilizar uma correção de continuidade, de acordo com o tipo de teste que está sendo realizado.

- Se o teste é bilateral, calculamos A dado por $$A = T^+-\frac{n(n+1)}{4}.$$

Se A ≥ 0, a estatística será dada por $$Z_{cor}=\frac{T^+-\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)}{24}}}$$

e se A < 0, a estatística será dada por $$Z_{cor}=\frac{T^++\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)}{24}}}.$$

-

Se o teste é unilateral à direita, a estatística será dada por $$Z_{cor}=\frac{T^+-\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)}{24}}}.$$

-

Se o teste é unilateral à esquerda, a estatística será dada por $$Z_{cor}=\frac{T^++\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)}{24}}}.$$

Os passos utilizados são análogos aos anteriores, porém utilizamos $Z_{cor}$ ao invés de $Z_{obs}$.

Exemplo 1.3.1

Considere a seguinte amostra de 60 elementos

| 221 | 106 | 272 | 136 | 353 | 331 |

|---|---|---|---|---|---|

| 242 | 335 | 257 | 248 | 312 | 211 |

| 81 | 321 | 336 | 318 | 186 | 169 |

| 328 | 355 | 114 | 184 | 264 | 322 |

| 363 | 284 | 299 | 323 | 228 | 245 |

| 365 | 268 | 270 | 131 | 138 | 196 |

| 259 | 293 | 152 | 202 | 300 | 199 |

| 260 | 263 | 185 | 311 | 240 | 325 |

| 124 | 162 | 142 | 346 | 163 | 261 |

| 343 | 123 | 362 | 95 | 132 | 281 |

Vamos testar se os elementos estão distribuídos simetricamente em torno de $θ_{0}$ = 220.

- Para realizar este teste, estabelecemos as hipóteses

- Subtraindo $θ_{0}$ = 220 de cada elemento da amostra e colocando todos os valores em ordem crescente de magnitude, obtemos:

| 1 | 8 | -9 | -18 | 20 | -21 |

|---|---|---|---|---|---|

| 22 | -24 | 25 | 28 | -34 | -35 |

| -36 | 37 | 39 | 40 | 41 | 43 |

| 44 | 48 | 50 | -51 | 52 | -57 |

| -58 | 61 | 64 | -68 | 73 | -78 |

| 79 | 80 | -82 | -84 | -88 | -89 |

| 91 | 92 | -96 | -97 | 98 | 101 |

| 102 | 103 | 105 | -106 | 108 | 111 |

| -114 | 115 | 116 | 123 | -125 | 126 |

| 133 | 135 | -139 | 142 | 143 | 145 |

- Associando os postos correspondentes destes valores, temos que

Postos:

| 1 | 2 | -3 | -4 | 5 | -6 |

|---|---|---|---|---|---|

| 7 | -8 | 9 | 10 | -11 | -12 |

| -13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | -22 | 23 | -24 |

| -25 | 26 | 27 | -28 | 29 | -30 |

| 31 | 32 | -33 | -34 | -35 | -36 |

| 37 | 38 | -39 | -40 | 41 | 42 |

| 43 | 44 | 45 | -46 | 47 | 48 |

| -49 | 50 | 51 | 52 | -53 | 54 |

| 55 | 56 | -57 | 58 | 59 | 60 |

-

A partir dos valores dos postos acima, calculamos o valor $T^{+}$ que será dado por $$T^+=1222.$$

-

Calculamos o valor da estatística Z dada na equação (1.3.1) $$Z = \frac{T^+-\frac{1}{4}n(n+1)}{\sqrt{[n(n+1)(2n+1)/24]}}=\frac{1222-915}{135,84}=2,260012.$$

Fixamos o nível de significância α = 0,05.

-

Encontramos os valores críticos da distribuição Normal. Neste caso, como o teste é bilateral, os valores são $Z_{α/2}$ = 1,96 e $-Z_{α/2}$ = -1,96.

-

Critério.

Como $Z_{obs }$= 2.260012 > 1,96, rejeitamos a hipótese nula de que os dados estão simetricamente distribuídos em torno de $θ_{0}$ = 220.

- Cálculo do p-valor

Neste caso, com o teste é bilateral, o p-valor é dado por $$P-valor = 2P(Z \ > \ Z_{obs})=2P(Z \ > \ 2.260012)=0,0238.$$

Utilizando o software Action, temos os seguintes resultados:

Caso, quiséssemos realizar o teste com correção de continuidade calculamos o valor A dado por $$A = T^+-\frac{n(n+1)}{4}= 1222-915=307.$$

Como A = 307 ≥ 0, a estatística é dada por $$Z_{cor}=\frac{T^+-\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)}{24}}}=\frac{306,5}{135,84}=2,256331.$$

E, neste caso, o p-valor é dado por $$P-valor = 2P(Z \ > \ 2.256331)=0,02405.$$

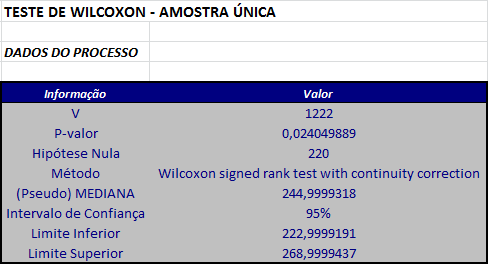

Utilizando o software Action, temos os seguinte resultados:

1.4 - Observações Repetidas

Agora veremos o caso em que, ao observarmos uma amostra, encontramos valores repetidos.

Consideremos uma amostra de tamanhos n. Os passos para a realização deste teste são análogos ao do caso anterior. O que mudará neste caso são os postos: quando os módulos dos números se repetem, teremos postos iguais para os números. O posto desses números será a média entre os postos que eles assumiriam no caso comum. Os postos dos números que não se repetem continuam sendo os números associados à posição em que o valor se encontra na listagem.

Para um maior esclarecimento consideremos a seguinte sequência de números:

| -8 | 9 | -15 | 15 | 16 | 18 | 32 | 32 | 32 | -39 |

|---|

Os postos no caso comum seriam:

| Valor | -8 | 9 | -15 | 15 | 16 | 18 | 32 | 32 | 32 | -39 |

|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

Mas observe que nesta sequência o número 15 aparece 2 vezes e o número 32 aparece 3 vezes. Assim, temos repetições. Portanto, o posto dos dois números 15 será a média dos números que correspondem à suas colocações na listagem, ou seja, (3+4)/2 = 3,5. De maneira análoga, o posto dos três números 32 será (7+8+9)/3 = 8. Os valores que não se repetem continuam com os mesmos postos. Então, temos que os valores observados e seus respectivos postos são

| Valor | -8 | 9 | -15 | 15 | 16 | 18 | 32 | 32 | 32 | -39 |

|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3,5 | 3,5 | 5 | 6 | 8 | 8 | 8 | 10 |

Se tivermos valores 0 na amostra, eliminamos estes valores e realizamos o teste para os valores restantes.

Exemplo 1.4.1

Suponha que em um teste de Wilcoxon temos os seguintes desvios:

| 0 | 0 | 3 | -7 | 9 | 9 | -11 | 11 | 11 | 14 | 16 | 17 | 17 | 18 |

|---|

Como temos dois valores 0 no conjunto de dados, esses valores são eliminados e ficamos com os dados restantes, isto é,

| 3 | -7 | 9 | -9 | -11 | 11 | 11 | 14 | 16 | 17 | 17 | 18 |

|---|

A seguir, calculamos o módulo de cada elemento do conjunto de dados e atribuímos a ele, seu posto correspondente. Desta forma, os postos serão:

| $Z_i$ | 3 | -7 | 9 | -9 | -11 | 11 | 11 | 14 | 16 | 17 | 17 | 18 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3,5 | 3,5 | 6 | 6 | 6 | 8 | 9 | 10,5 | 10,5 | 12 |

Observação

Para amostras que possuem valores repetidos ou valores zeros, o p-valor e o intervalo de confiança para um teste de Wilcoxon não são calculados de forma exata e os testes realizados são sempre assintóticos (utilizando aproximação normal).

Observações repetidas

Se existem r conjuntos diferentes de repetições, seja $d_{i}$, i = 1, …, r o número de observações repetidas no conjunto i. Definimos $d_{0}$ como o número de zeros existente na amostra. Neste caso, a estatística Z, dada por

$$Z = \frac{T^{+}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)-d_{0}(d_{0}+1)(2d_{0}+1)}{24} - \frac{\sum_{i=1}^{r}(d_{i}^3-d_{i})}{48}}}.~~~(1.4.1)$$

tem uma distribuição aproximadamente normal, para valores grandes de n.

Vejamos os passos para aplicar o Teste de Wilcoxon para observações repetidas.

- Estabeleça uma hipóteses:

-

Primeiramente, subtraímos $θ_{0}$ de cada valor $X_{i}$, i = 1, …, n da amostra e assim obtemos um novo conjunto de dados, $(X_{1}$ - $θ_{0}$, …, $X_{n }$- $θ_{0}$).

-

Ordenamos de forma crescente os módulos dos valores desse novo conjunto de dados e associamos a cada valor o posto correspondente, sendo esse posto como definido acima.

-

Calculamos o valor da estatística $T^{+}$, que foi definida como sendo a soma dos postos dos elementos que tem sinal positivo.

-

Seja $d_{i}$, i = 1, …, r o número de observações repetidas, se existem r conjuntos de diferentes repetições. Calculamos o valor de Z através da equação (1.4.1). Em seguida, fixamos o nível de significância α.

-

Encontramos na Tabela da distribuição Normal os valores críticos.

-

Se o teste é bilateral, encontramos os valores $Z_{α/2}$ e $-Z_{α/2}$.

-

Se o teste é unilateral à direita, encontramos o valor crítico $Z_{α}$.

-

Se o teste é unilateral à esquerda, encontramos o valor crítico $-Z_{α}$.

- Critério:

-

No caso bilateral, rejeitamos a hipótese nula se $Z_{obs} \ > \ Z_{\alpha/2}$ ou $Z_{obs} \ < \ -Z_{\alpha/2}$, caso contrário, não rejeitamos a hipótese nula.

-

No caso unilateral à direita, rejeitamos a hipótese nula se $Z_{obs} \ > \ Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

-

No caso unilateral à esquerda, rejeitamos a hipótese nula se $Z_{obs} \ < \ -Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

- Cálculo do p-valor

- Se o teste é bilateral, o p-valor é calculado da seguinte forma

$$P-valor = P[|Z| \ > \ |Z_{obs}||H_0]=2P[Z \ > \ |Z_{obs}|].$$

- Se o teste é unilateral à direita, então o p-valor é dado por

$$P-valor = P[Z \ > \ Z_{obs}|H_0].$$

- Se o teste é unilateral à esquerda, então o p-valor é dado por

$$P-valor = P[Z \ > \ Z_{obs}|H_0].$$

Correção de Continuidade

- Se o teste é bilateral, então calculamos o valor A dado por

$$A = T^+-\frac{n(n+1)}{4}$$

e, se A ≥ 0 segue que a estatística será dada por

$$Z_{cor}=\frac{T^+-\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)-d_0(d_0+1)(2d_0+1)} {24}-\frac{\sum_{i=1}^{r}(d_{i}^3-d_{i})}{48}}}$$

e se A < 0, a estatística será dada por

$$Z_{cor}=\frac{T^++\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)-d_0(d_0+1)(2d_0+1)} {24}-\frac{\sum_{i=1}^{r}(d_{i}^3-d_{i})}{48}}}.$$

- Se o teste é unilateral à direita, a estatística será dada por

$$Z_{cor}=\frac{T^+-\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)-d_0(d_0+1)(2d_0+1)} {24}-\frac{\sum_{i=1}^{r}(d_{i}^3-d_{i})}{48}}}.$$

- Se o teste é unilateral à esquerda, a estatística será dada por

$$Z_{cor}=\frac{T^++\frac{1}{2}-\frac{n(n+1)}{4}}{\sqrt{\frac{n(n+1)(2n+1)-d_0(d_0+1)(2d_0+1)} {24}-\frac{\sum_{i=1}^{r}(d_{i}^3-d_{i})}{48}}}.$$

Exemplo 1.4.2

Consideremos a amostra:

| 153 | 166 | 181 | 192 | 244 | 248 | 258 | 264 | 296 | 305 | 305 | 312 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 330 | 340 | 356 | 361 | 395 | 427 | 433 | 467 | 544 | 551 | 625 | 783 |

Use o teste de Wilcoxon para testar as hipóteses

Subtraindo 220 de cada valor da amostra e colocando todos os valores obtidos em ordem crescente de magnitude, obtemos:

| 24 | -28 | 28 | 38 | -39 | 44 | -54 | -67 | 76 | 85 | 85 | 92 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 110 | 120 | 136 | 141 | 175 | 207 | 213 | 247 | 324 | 331 | 405 | 563 |

A seguinte tabela nos dá os desvios obtidos acima, seus respectivos postos e os valores $R_iψ_{i}$.

| Valor | 24 | -28 | 28 | 38 | -39 | 44 | -54 | -67 | 76 | 85 | 85 | 92 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | -2,5 | 2,5 | 4 | -5 | 6 | -7 | -8 | 9 | 10,5 | 10,5 | 12 |

| $R_iψ_i$ | 1 | 0 | 2,5 | 4 | 0 | 6 | 0 | 0 | 9 | 10,5 | 10,5 | 12 |

| Valor | 110 | 120 | 136 | 141 | 175 | 207 | 213 | 247 | 324 | 331 | 405 | 563 |

| Posto | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| $R_iψ_i$ | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 | 21 | 22 | 23 | 24 |

A partir dos valores $R_iψ_{i}$, calculamos o valor $T^{+}$, dado por

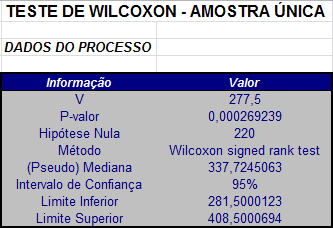

$$T^+=\sum_{i=1}^{24}R_i\Psi_i=277,5.$$

Com temos duas repetições envolvendo duas observações, segue que $d_{1}=d_{2}=2$ e $n=24$.

A estatística Z é dada por

$$Z=\frac{277,5-150}{\sqrt{\frac{24(24+1)(48+1)}{24}-\frac{(6+6)}{48}}}=3,643229.$$

Neste caso, o p-valor é dado por

$$P-valor = P[|Z| \ > \ |Z_{obs}||H_0]=2P[Z \ > \ 3,643229]=0,000269239.$$

Conclusão

Rejeitamos $H_{0}$ se considerarmos qualquer nível de significância maior que 0,0269239%.

Utilizando o software Action temos os seguinte resultados:

Utilizando a correção de continuidade, como o teste é bilateral, temos que A é dado por

$$A = T^+-\frac{n(n+1)}{4}=277,5-\frac{24\times25}{4}=277,5-150=127,5 \ > \ 0.$$

Então, utilizando a correção de continuidade, a estatística $Z_{cor}$ é calculada da seguinte forma

$$Z_{cor}=\frac{277,5-0,5-150}{\sqrt{\frac{24(24+1)(48+1)}{24}-\frac{(6+6)}{48}}}=3,628942$$

e, neste caso, o p-valor é dado por

$$P-valor = P[|Z| \ > \ |Z_{obs}||H_0]=2P[Z \ > \ 3,628942]=0,000284585$$

Conclusão

Rejeitamos $H_{0}$ se considerarmos qualquer nível de significância maior que 0,0284585%.

2 - Teste de Wilcoxon-Mann-Whitney - Amostras Independentes

Consideremos duas populações $P_1$ e $P_2$ das quais não temos informações a respeito de suas distribuições, mas as variáveis envolvidas tenham uma escala de medida pelo menos ordinal. Ou seja, podemos abordar o caso de variáveis aleatórias qualitativas ordinais ou quantitativas. Consideremos também duas amostras independentes das duas populações. Queremos testar se as distribuições são iguais em localização, isto é, estaremos interessados em saber se uma população tende a ter valores maiores do que a outra, ou se elas têm a mesma mediana. Este teste é chamado de Teste de Wilcoxon-Mann-Whitney.

O teste de Wilcoxon-Mann-Whitney é baseado nos postos dos valores obtidos combinando-se as duas amostras. Isso é feito ordenando-se esses valores, do menor para o maior, independentemente do fato de qual população cada valor provém.

No caso de termos uma variável aleatória qualitativa ordinal, comumente associamos números às diversas categorias (ou classes, ou atributos), segundo as quais a variável é classificada. Por exemplo, podemos ter 1 para bom, 2 para muito bom e 3 para ótimo. Vemos, então, que esses valores são postos. Neste caso e em outras situações é preferível trabalhar com postos do que com valores arbitrários associados à variável qualitativa.

Sejam $X_1, X_2, …, X_m$ uma amostra aleatória da população $P_1$ e $Y_1, Y_2, …, Y_n$ uma amostra aleatória da população $P_2$ de modo que os $X_i’s$ são independentes e identicamente distribuídos e os $Y_i’s$ são independentes e identicamente distribuídos. Além disso, suponha que os $X_i’s$ e os $Y_i’s$ são mutuamente independentes e tome a amostra Y aquela com o menor tamanho amostral, isto é, n ≤ m.

Para aplicar o teste de Wilcoxon-Mann-Whitney, supomos que F e G sejam as funções de distribuição correspondentes as populações $P_1$ e $P_2$, respectivamente e, neste caso, consideramos como hipótese nula, a hipótese

$$H_0: F(t)=G(t) \ \hbox{para todo} \ t.$$

A hipótese alternativa consiste em considerar que Y tende a ser maior (ou menor) que X. Um modelo útil para descrever esta alternativa é um modelo de translação chamado modelo de mudança de posição. Neste modelo temos que

$$G(t)=F(t-\Delta) \ \hbox{para todo} \ t.$$

Outra maneira de interpretação é considerar que Y tem a mesma distribuição de X+Δ. Neste caso, considerando que a esperança E(X) da população 1 exista e tomando E(Y) como a esperança da população 2, segue que

$$\Delta = E(Y)-E(X)$$

e, desta forma, a hipótese nula $H_0$ se reduz a

$$H_0:\Delta=0.$$

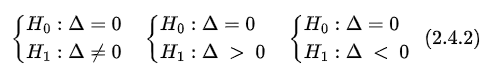

Com isto, estabelecemos uma das seguintes hipóteses em um teste de Wilcoxon-Mann-Whitney:

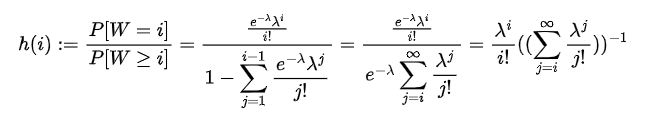

Em seguida, ordenamos todos os valores (das duas amostras) em ordem crescente e colocamos os postos associados. Consideramos $S_m$ e $S_n$ as somas dos postos relacionados aos elementos das amostras X e Y respectivamente. A partir dos valores $S_m$ e $S_n$, calculamos os valores

$$U_{m} = S_{m}-\frac{1}{2}m(m+1)~~~(2.1)$$

e

$$U_{n} = S_{n}-\frac{1}{2}n(n+1).~~~(2.2)$$

Como $S_m + S_n$ é igual a soma de todos os postos (das duas amostras), isto é,

$$S_{m}+S_{n} = \frac{1}{2}(m+n)(m+n+1)~~~(2.3)$$

é fácil ver que os valores $U_m$ e $U_n$ estão relacionados segundo a equação abaixo

$$U_{m} = mn - U_{n}~~~(2.4)$$

por isso, apenas um dos $U_m, U_n$ precisa ser calculado e, através da equação (2.4) encontramos o valor do outro de maneira fácil. No teste de Wilcoxon-Mann-Whitney, a estatística W do teste será dada por $U_n$.

Exemplo 2.1

Duas amostras forneceram os seguintes valores de certa variável.

Amostra 1:

| 29 | 39 | 60 | 78 | 82 | 112 | 125 | 170 |

|---|---|---|---|---|---|---|---|

| 192 | 224 | 263 | 275 | 276 | 286 | 369 | 756 |

Amostra 2:

| 126 | 142 | 156 | 228 | 245 | 246 |

|---|---|---|---|---|---|

| 370 | 419 | 433 | 454 | 478 | 503 |

Temos na Tabela (2.1) todos os valores amostrais em ordem crescente e os postos associados. Para facilitar a identificação, valores e postos da segunda amostra foram sublinhados.

| Valor | 29 | 39 | 60 | 78 | 82 | 112 | 125 | 126 | 142 | 156 |

|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| Valor | 170 | 192 | 224 | 228 | 245 | 246 | 263 | 275 | 276 | 286 |

| Posto | 11 | 12 | 13 | 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| Valor | 369 | 370 | 419 | 433 | 454 | 478 | 503 | 756 | ||

| Posto | 21 | 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tabela 2.1: Postos combinados para as duas amostras independentes.

Aqui m = 16 e n = 12. Então,

$$S_{m} = 1+2+3+4+5+6+7+11+12+13+17+18+19+20+21+28=187$$

e

$$S_n = 8+9+10+14+15+16+22+23+24+25+26+27=219$$

Então,

$$U_{m}=187-(\frac{1}{2}\times 16\times 17)=51$$

e

$$U_{n}=219-(\frac{1}{2}\times 12\times 13)=141.$$

Portanto, a estatística W é dada por

$$W=U_{n}=141.$$

2.1 - Um Estimador para a Diferença entre as Posições

Para estimar a diferença Δ entre as medianas das populações, consideramos todas as m x n diferenças $y_i - x_j$ ordenadas de forma crescente. O estimador $\hat{\Delta}$ associado a estatística de Wilcoxon-Mann-Whitney é definido por

$$\hat{\Delta}= \ \hbox{mediana}{((y_i-x_j), \ i=1,\ldots, n; j=1,\ldots,m)}.$$

Sejam $U^{(1)}, U^{(2)}, …, U^{(mn)}$, os valores ordenados destas diferenças. Se m é um número ímpar, isto é, mn = 2k +1, temos que k = (mn-1)/2 e então tomamos

$$\hat{\Delta}=U^{(k+1)},$$

isto é, a diferença que ocupa a posição k + 1 na lista das diferenças ordenadas. Se mn é um número par, isto é, mn = 2k, então k = mn/2 e então tomamos

$$\hat{\Delta}=\frac{U^{(k)}+U^{(k+1)}}{2},$$

isto é, $\hat{\Delta}$ é a média das diferenças $y_i - x_j$ que ocupam as posições k e k + 1 na lista das diferenças ordenadas.

Obs: O estimador $\hat{\Delta}$ é chamado de pseudo-mediana.

Exemplo 2.1.1

Considere os dados do Exemplo 2.1.

Temos na Tabela 2.1.1 as diferenças entre valores observados.

| 126 | 142 | 156 | 228 | 245 | 246 | 370 | 419 | 433 | 454 | 478 | 503 | |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 29 | 97 | 113 | 127 | 199 | 216 | 217 | 341 | 390 | 404 | 425 | 449 | 474 |

| 39 | 87 | 103 | 117 | 189 | 206 | 207 | 331 | 380 | 394 | 415 | 439 | 464 |

| 60 | 66 | 82 | 96 | 168 | 185 | 186 | 310 | 359 | 373 | 394 | 418 | 443 |

| 78 | 48 | 64 | 78 | 150 | 167 | 168 | 292 | 341 | 355 | 376 | 400 | 425 |

| 82 | 44 | 60 | 74 | 146 | 163 | 164 | 288 | 337 | 351 | 372 | 396 | 421 |

| 112 | 14 | 30 | 44 | 116 | 133 | 134 | 258 | 307 | 321 | 342 | 366 | 391 |

| 125 | 1 | 17 | 31 | 103 | 120 | 121 | 245 | 294 | 308 | 329 | 353 | 378 |

| 170 | -44 | -28 | -14 | 58 | 75 | 76 | 200 | 249 | 263 | 284 | 308 | 333 |

| 192 | -66 | -50 | -36 | 36 | 53 | 54 | 178 | 227 | 241 | 262 | 286 | 311 |

| 224 | -98 | -82 | -68 | 4 | 21 | 22 | 146 | 195 | 209 | 230 | 254 | 279 |

| 263 | -137 | -121 | -107 | -35 | -18 | -17 | 107 | 156 | 170 | 191 | 215 | 240 |

| 275 | -149 | -133 | -119 | -47 | -30 | -29 | 95 | 144 | 158 | 179 | 203 | 228 |

| 276 | -150 | -134 | -120 | -48 | -31 | -30 | 94 | 143 | 157 | 178 | 202 | 227 |

| 286 | -160 | -144 | -130 | -58 | -41 | -40 | 84 | 133 | 147 | 168 | 192 | 217 |

| 369 | -243 | -227 | -213 | -141 | -124 | -123 | 1 | 50 | 64 | 85 | 109 | 134 |

| 736 | -610 | -594 | -580 | -508 | -491 | -490 | -366 | -317 | -303 | -282 | -258 | -233 |

Tabela 2.1.1: Diferenças

Temos que nm = 12 x 16 = 192 que é um número par, isto é 192 = 2k com k = 96. Deste modo, o estimador da mediana entre as diferenças $y_i - x_j$ é dado por

$$\hat{\Delta}=\frac{U^{(96)}+U^{(97)}}{2}=\frac{133+134}{2}=133,5.$$

2.2 - Distribuição exata da estatística de Wilcoxon-Mann-Whitney

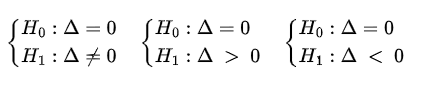

Suponha que sob $H_0$, a distribuição de W é contínua, de modo que a probabilidade de encontrarmos valores repetidos nas amostras de X e Y é zero. Para encontrar a distribuição exata da estatística W sob $H_0$, considere n e m os tamanhos amostrais das populações Y e X, respectivamente. Além disso, considere que N = n + m. Deste modo, temos

possibilidades para os ranks (posições) dos elementos de Y e cada um deles tem probabilidade

Por exemplo, no caso em que m = 3 e n = 2, existem

possibilidades para os ranks das duas observações dos elementos de Y e os valores correspondentes da estatística W são dados na seguinte tabela

| Ranks | Probabilidade | W |

|---|---|---|

| 1,2 | 1/10 | 3 |

| 1,3 | 1/10 | 4 |

| 1,4 | 1/10 | 5 |

| 1,5 | 1/10 | 6 |

| 2,3 | 1/10 | 5 |

| 2,4 | 1/10 | 6 |

| 2,5 | 1/10 | 7 |

| 3,4 | 1/10 | 7 |

| 3,5 | 1/10 | 8 |

| 4,5 | 1/10 | 9 |

Assim, sob $H_0$, a probabilidade de que W seja igual a 5 é igual a 2/10, pois W = 5 quando a configuração dos ranks de Y é {1,4} ou {2,3} e cada uma delas ocorre com probabilidade 1/10. Deste modo, temos para a distribuição sob $H_0$ que

| Valores de W | Probabilidade |

|---|---|

| 3 | 0,1 |

| 4 | 0,1 |

| 5 | 0,2 |

| 6 | 0,2 |

| 7 | 0,2 |

| 8 | 0,1 |

| 9 | 0,1 |

Então, por exemplo, a probabilidade sob $H_0$ de W ser maior ou igual a 7 é dada por

$$P[W\geq 7]=P(W=7)+P(W=8)+P(W=9)=0,2+0,1+0,1=0,4$$

Em um teste de Wilcoxon-Mann-Whitey em que o tamanho amostral n é pequeno (geralmente n < 50) e não temos observações repetidas ou nulas, utilizamos a distribuição exata da estatística W e, a partir desta distribuição, calculamos os valores críticos do teste, o p-valor e o intervalo de confiança.

- Cálculo dos valores críticos.

Se estamos realizando um teste bilateral, então sob $H_0$, devemos encontrar os valores críticos $t_1$ e $t_2$ tais que

$$P[W \ < \ t_1]=P[W \ > \ t_2]=\approx\frac{\alpha}{2}.$$

Se o teste é unilateral à direita, então devemos encontrar o valor crítico t tal que

$$P[W \ > \ t]\approx\alpha$$

e se o teste é unilateral à esquerda, então devemos encontrar o valor crítico t tal que

$$P[W \ < \ t]\approx\alpha.$$

- Critério.

Se o teste é bilateral e $W_{obs}$ < $t_{1}$ ou $W_{obs}$ > $t_2$ então rejeitamos $H_0$, caso contrário, não rejeitamos $H_0$, ou seja, se $t_1$ < $W_{obs}$ < $t_2$, não rejeitamos a hipótese nula $H_0$.

No caso do teste unilateral à direita, se $W_{obs}$ > $t$, então rejeitamos $H_0$, caso contrário, não rejeitamos $H_0$, ou seja, se $W_{obs}$ < t, não rejeitamos a hipótese nula $H_0$.

Se o teste é unilateral à esquerda e $W_{obs}$ < t, então rejeitamos $H_0$, caso contrário, não rejeitamos $H_0$, ou seja, se $W_{obs}$ > t, não rejeitamos a hipótese nula $H_0$.

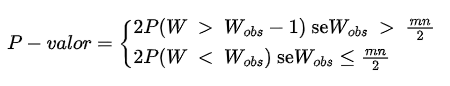

- Cálculo do p-valor.

Se o teste é bilateal, o p-valor do teste exato é dado por

Se o teste é unilateal à direita, o p-valor do teste exato é dado por

$$P-valor = P(W \ > \ W_{obs}-1)$$

e se o teste é unilateral à esquerda, o p-valor do teste exato é dado por

$$P-valor = P(W \ < W_{obs}).$$

- Intervalo de confiança para a diferença entre os parâmetros de posição das populações Y e X.

De forma análoga a utilizada na estimativa da diferença entre os parâmetros de posição das populações Y e X, consideramos todas as m x n diferenças $y_i$ - $x_j$ ordenadas de forma crescente. Considerando que X tem m elementos e Y tem n elementos e que n ≤ m, então temos m x n diferenças deste tipo.

Sejam $W^{(1)}, W^{(2)}, …, W^{(mn)}$ estas diferenças ordenadas.

Se o teste é bilateral e o nível de significância é α, encontramos os valores L e U tais que

$$P(W \ < \ L)\approx \frac{\alpha}{2} \qquad U = nm-L$$

e o intervalo de confiança 100(1-α)% é dado por

$$IC_{1-\alpha}(\theta)=(W^{(L)},W^{(U+1)}).$$

Se o teste é unilateral à direita, encontramos o valor L tal que

$$P(W \ < \ L)\approx\alpha$$

e o intervalo de confiança 100(1-α)% é dado por

$$IC_{1-\alpha}(\theta)=(W^{(L)},\infty)$$

e se o teste é unilateral à esquerda, encontramos o valor U tal que

$$P(W \ > \ U)\approx\alpha$$

e o intervalo de confiança 100(1-α)% é dado por

$$IC_{1-\alpha}(\theta)=(-\infty,W^{(U+1)}).$$

Exemplo 2.2.1

Considere novamente o Exemplo 2.1 em que duas amostras fornecem valores de determinada variável.

Amostra 1:

| 29 | 39 | 60 | 78 | 82 | 112 | 125 | 170 |

|---|---|---|---|---|---|---|---|

| 192 | 224 | 263 | 275 | 276 | 286 | 369 | 756 |

Amostra 2:

| 126 | 142 | 156 | 228 | 245 | 246 |

|---|---|---|---|---|---|

| 370 | 419 | 433 | 454 | 478 | 503 |

Vamos testar se, a um nível de significância de 5%, existe diferença significativa entre as medidas de posições das duas populações. Neste caso, estabelecemos as hipóteses

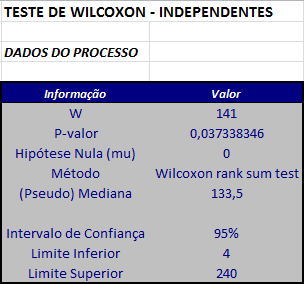

Como já foi visto, a estatística W é dada por

$$W=141.$$

- Cálculo dos valores críticos.

Como estamos realizando um teste bilateral, devemos encontrar os valores $t_1$ e $t_2$ tais que

$$P[W \ < \ t_1]=P[W \ > \ t_2]\approx 0,025.$$

Neste caso, temos que os valores de $t_1$ e $t_2$ são dados por $t_1$ = 54 e $t_2$ = 138.

- Critério.

Como $W_{obs}$ = 141 > $t_{2}$ = 138, então rejeitamos a hipótese nula. Neste caso, temos evidência de que as duas populações não possuem medidas de posição iguais.

- Cálculo do p-valor.

Como $W_{obs}$ 141 > mn/2 = 96, o p-valor é dado por

$$P-valor = 2P(W \ > \ W_{obs}-1)=0,03733835.$$

- Intervalo de Confiança.

Consideramos as m x n diferenças da forma $y_i$ - $x_j$ ordenadas de forma crescente na tabela abaixo

| -630 | -614 | -600 | -528 | -511 | -510 | -386 | -337 | -323 | -302 | -278 | -253 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| -243 | -227 | -213 | -160 | -150 | -149 | -144 | -141 | -137 | -134 | -133 | -130 |

| -124 | -123 | -121 | -120 | -119 | -107 | -98 | -82 | -68 | -66 | -58 | -50 |

| -48 | -47 | -44 | -41 | -40 | -36 | -35 | -31 | -30 | -30 | -29 | -28 |

| -18 | -17 | -14 | 1 | 1 | 4 | 12 | 17 | 21 | 22 | 30 | 31 |

| 36 | 44 | 44 | 48 | 50 | 53 | 54 | 58 | 60 | 64 | 64 | 66 |

| 74 | 75 | 76 | 78 | 82 | 84 | 85 | 87 | 94 | 95 | 96 | 97 |

| 103 | 103 | 107 | 109 | 113 | 116 | 117 | 120 | 121 | 127 | 133 | 133 |

| 134 | 134 | 143 | 144 | 146 | 146 | 147 | 150 | 156 | 157 | 158 | 163 |

| 164 | 167 | 168 | 168 | 168 | 170 | 178 | 178 | 179 | 185 | 186 | 189 |

| 191 | 192 | 195 | 199 | 200 | 202 | 203 | 206 | 207 | 209 | 215 | 216 |

| 217 | 217 | 227 | 227 | 228 | 230 | 240 | 241 | 245 | 249 | 254 | 258 |

| 262 | 263 | 279 | 284 | 286 | 288 | 292 | 294 | 307 | 308 | 308 | 310 |

| 311 | 321 | 329 | 331 | 333 | 337 | 341 | 341 | 342 | 351 | 353 | 355 |

| 359 | 366 | 372 | 373 | 376 | 378 | 380 | 390 | 391 | 394 | 394 | 396 |

| 400 | 404 | 415 | 418 | 421 | 425 | 425 | 439 | 443 | 449 | 464 | 474 |

Os valores de L e U para o cálculo do intervalo de confiança são dados por

$$L = 54 \ \hbox{e} \ U = 138.$$

Desta forma, segue que o intervalo com 95% de confiança é dado por

$$IC_{0,95}(\theta)=(W^{(L)},W^{(U+1)})=(4,230).$$

- Para o cálculo da pseudo mediana da diferença entre a população Y e a população X, utilizamos a tabela acima. Como mn = 192 e 192 = 2 x 96 é um número par, a pseudo mediana é dada por

$$\hat{\Delta}=\frac{W^{(96)}+W^{(97)}}{2}=\frac{133+134}{2}=133,5.$$

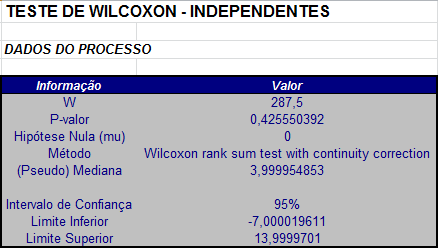

Utilizando o software Action, obtemos os seguintes resultados:

2.3 - Aproximação Normal

Para valores m e n grandes, geralmente maiores que 50, uma aproximação normal, como veremos a seguir, é utilizada. Consideremos a estatística W como definida anteriormente, isto é, W = $U_{n}$.

Teorema 2.3.1

Sob a hipótese nula, ou seja, sob a hipótese de que a diferença entre as posições é Δ = 0, temos que o valor esperado de W, $E_{0}$(W) e a variância de W, $Var_{0}$(W) são dados pelas fórmulas abaixo

$$E_0(W)=\frac{mn}{2} \ \hbox{e} \ Var_0(W)=\frac{mn(m+n+1)}{12}$$

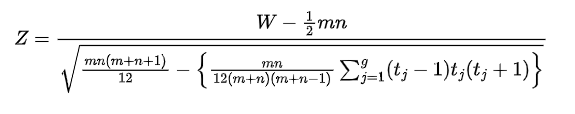

Aproximação Normal

Utilizando resultados assintóticos, temos a estatística Z dada por

$$Z = \frac{W-\frac{1}{2}mn}{\sqrt{\frac{mn(m+n+1)}{12}}}~~~(2.3.1)$$

tem distribuição aproximadamente Normal com média 0 e variância 1. Então o teste fica reduzido a um teste normal padrão.

Vejamos com realizar este teste:

- Estabelecemos uma das seguintes hipóteses:

-

Ordenamos todos os valores (das duas amostras) em ordem crescente e colocamos os postos associados.

-

Em seguida, calculamos o valor de $S_{n}$ (a soma dos postos associados aos elementos da amostra y).

-

Obtemos o valor W = $U_{n}$. Em seguida, fixamos o nível de significância α.

-

Calculamos o valor

$$Z_{obs}= \frac{W-\frac{1}{2}mn}{\sqrt{\frac{mn(m+n+1)}{12}}}.$$

- Encontramos os valores críticos da distribuição Normal padrão segundo o tipo de teste.

-

Se o teste é bilateral, encontramos os valores críticos $Z_{\alpha/2}$ e $-Z_{\alpha/2}$ tais que $P[Z \ > \ Z_{\alpha/2}]=P[Z \ < \ -Z_{\alpha/2}]=\alpha/2.$

-

Se o teste é unilateral à direita, encontramos o valor crítico $Z_{\alpha}$ tal que $P[Z \ > \ Z_{\alpha}]=\alpha$.

-

Se o teste é unilateral à esquerda, encontramos o valor crítico $-Z_{\alpha}$ tal que $P[Z \ < \ -Z_{\alpha}]=\alpha$.

- Critério:

-

Se o teste é bilateral, rejeitamos a hipótese nula $H_{0}$ se o valor observado $Z_{obs} \ > \ Z_{\alpha/2}$ ou se $Z_{obs} \ < \ -Z_{\alpha/2}$, caso contrário não rejeitamos a hipótese nula.

-

Se o teste é unilateral à direita, rejeitamos a hipótese nula $H_{0}$ se o valor observado $Z_{obs} \ > \ Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

-

Se o teste é unilateral à esquerda, rejeitamos a hipótese nula $H_{0 }$se o valor observado $Z_{obs} \ < \ -Z_{\alpha}$, caso contrário, não rejeitamos a hipótese nula.

- Cálculo do p-valor:

Se o teste é bilateral, o p-valor é dado por

$$P-valor = P(|Z| \ > \ |Z_{obs}||H_0) = 2P(Z \ > \ |Z_{obs}||H_0).$$

Se o teste é unilateral à direita, o p-valor é dado por

$$P-valor = P(Z \ > \ Z_{obs}|H_0)$$

e se o teste é unilateral à esquerda, o p-valor é dado por

$$P-valor = P(Z \ < \ Z_{obs}|H_0).$$

onde Z ~ N(0,1).

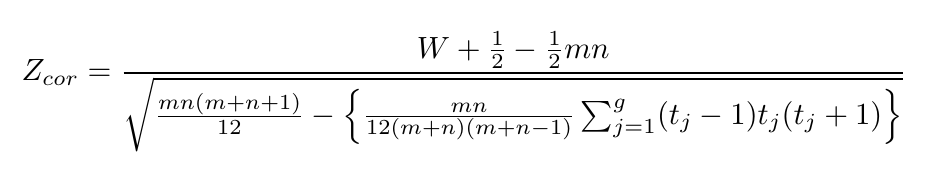

Aproximação Normal com correção de continuidade

Como estamos utilizando uma distribuição contínua, é conveniente utilizar uma correção de continuidade. Assim como foi visto anteriormente, a correção é feita de acordo com o tipo de teste efetuado.

- Se o teste é bilateral, calculamos A dado por

$$A = W -\frac{1}{2}nm.$$

Se A ≥ 0, então

$$Z_{cor}= \frac{W - \frac{1}{2}-\frac{1}{2}nm}{\sqrt{\frac{mn(m+n+1)}{12}}}.$$

Se A < 0, então

$$Z_{cor}= \frac{W+\frac{1}{2}-\frac{1}{2}nm}{\sqrt{\frac{mn(m+n+1)}{12}}}.$$

- Se o teste é unilateral à direita, a estatística é dada por

$$Z_{cor}=\frac{W-\frac{1}{2}-\frac{1}{2}nm}{\sqrt{\frac{mn(m+n+1)}{12}}}.$$

- Se o teste é unilateral à esquerda, a estatística é dada por

$$Z_{cor}=\frac{W+\frac{1}{2}-\frac{1}{2}nm}{\sqrt{\frac{mn(m+n+1)}{12}}}.$$

Exemplo 2.3.1

Considere as duas amostras dadas abaixo. A primeira de tamanho m = 60 e a segunda de tamanho n = 50 e vamos testar se existe diferença significativa entre suas medidas de posição.

Amostra 1:

| 0,020783 | 1,190577 | 0,254776 | 0,326478 | 0,166423 | -0,60854 |

|---|---|---|---|---|---|

| -1,09347 | -0,87468 | -0,68062 | -0,44368 | 1,107722 | 0,835386 |

| -0,4732 | 0,614336 | -0,14765 | -0,73586 | 1,103766 | 0,304864 |

| 0,487065 | 1,437288 | -0,01432 | -0,39427 | -0,0318 | -0,55498 |

| -0,92408 | -0,09976 | 0,730077 | 0,698887 | -1,62009 | -0,61324 |

| -1,31087 | -2,12763 | 0,445035 | 0,321711 | 1,583911 | -0,10288 |

| -0,90719 | 0,390517 | -0,95791 | -0,13997 | 1,192579 | 0,78557 |

| -0,70691 | -0,36727 | -0,36615 | -0,12643 | -1,55418 | -1,74463 |

| 0,102534 | 0,29614 | 1,496525 | 0,037918 | 1,334108 | -2,17951 |

| -1,23783 | 0,43527 | -0,70575 | 1,53077 | 0,773895 | -0,80207 |

Amostra 2:

| 0,849954 | -0,06994 | 0,459771 | -1,39136 | -0,36113 |

|---|---|---|---|---|

| 0,130024 | -0,57095 | 0,1313 | 1,494435 | 2,012758 |

| 0,357575 | 0,881379 | 0,343893 | 2,295901 | -0,04778 |

| 0,2508 | 0,767977 | 0,622242 | -0,00538 | 0,823678 |

| 0,310109 | -0,45953 | -0,26607 | -1,60654 | -1,49409 |

| -1,05302 | -1,62618 | 0,833893 | -1,75903 | -0,32571 |

| 1,770791 | -0,0034 | -0,13192 | 1,438544 | -0,30188 |

| -0,00674 | 0,392139 | 1,307978 | 0,065984 | -1,32595 |

| -0,85192 | 0,653739 | 0,838055 | 0,406276 | -1,11364 |

| 0,267735 | 0,412184 | 0,10388 | -0,71385 | -0,3809 |

Neste caso, temos que m = 60 e n = 50.

Como queremos testar se existe diferença significativa entre suas medidas de posição, estabelecemos as seguintes hipóteses

Ordenando os valores das duas amostras e calculando a soma dos postos associados aos elementos da amostra de tamanho n = 50, temos que $S_{n}$ = 2931. Deste modo, a estatística W é dada por

$$W = U_n = S_n-\frac{n(n+1)}{2}=2931-\frac{50\times 51}{2}= 1656.$$

A seguir calculamos o valor da estatística Z dada por

$$Z=\frac{W-1/2mn}{\sqrt{[mn(m+n+1)/12]}}=\frac{1656-(0,5\times60\times50)}{\sqrt{(60\times50\times111)/12}}=0,9364684.$$

Fixando o nível de significância α = 0,05 temos que os valores críticos são $Z_{\alpha/2} = 1,96$ e $-Z_{\alpha/2} = -1,96$, uma vez que o teste é bilateral. Como o valor observado foi $Z_{obs}$ = 0,9364684, não rejeitamos a hipótese nula, isto é, concluímos que não existe diferença significativa entre as medidas de posição das duas amostras.

Calculamos o p-valor da seguinte forma:

$$P-valor = P[|Z| \ > \ |Z_{obs}||H_0]= 2P[Z \ > \ |Z_{obs}||H_0]=2P[Z \ > \ 0,9364684]= 0,3490321.$$

Utilizando o software Action temos os seguintes resultados:

Caso quiséssemos realizar o teste com correção de continuidade, calculamos o valor de A dado por

$$A = W - \frac{mn}{2}=1656=\frac{3000}{2}=156.$$

Como A ≥ 0, temos que

$$Z_{cor}=\frac{W - \frac{1}{2}-\frac{1}{2}nm}{\sqrt{\frac{mn(m+n+1)}{12}}}=\frac{155,5}{166,5833}=0,9334669.$$

Como -1,96 = $-Z_{α/2}$ < $Z_{cor}$ = 0,9334669 < $Z_{α/2}$ = 1,96, então a um nível de significância de 5% não rejeitamos a hipótese de que os dados tem mesma medida de posição.

E, neste caso, o p-valor é dado por

$$P-valor = 2P(Z \ > \ 0,9334669 = 0,350579.$$

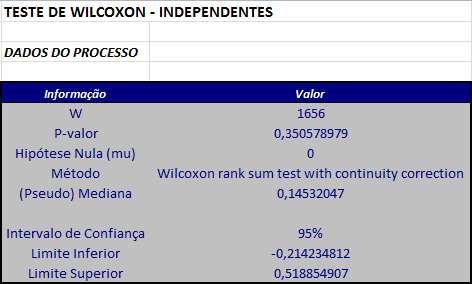

Utilizando o software Action, temos os seguintes resultados:

2.4 - Observações Repetidas

Agora vamos ver o caso em que ao observarmos duas amostras encontramos valores repetidos ou valores nulos. De forma análoga a realizada no caso de uma única amostra, quando os módulos dos números se repetem, teremos postos iguais para os números e o posto destes números será a média aritmética que os números assumiriam no caso comum.

Observação

Se as amostras possuem valores repetidos ou nulos, o p-valor e os intervalos de confiança não são calculados de forma exata e os testes realizados são sempre assintóticos (utilizando aproximação normal)

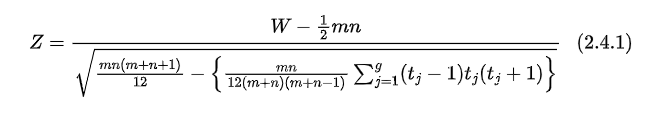

Consideremos duas amostras X e Y de duas populações $P_{1}$ e $P_{2}$, com tamanhos m e n respectivamente de modo que existam valores repetidos e/ou nulos no conjunto das duas amostras. Neste caso, a estatística será modificada para

em que $t_{j}$ é o tamanho do grupo de elementos repetidos j e g é o número total de grupos. Uma observação que não se repete é considerada como um grupo de tamanho 1.

Vejamos os passos para realizar este teste:

- Estabelecemos uma das hipóteses:

-

Ordenamos os valores da duas amostras em ordem crescente.

-

Consideramos $S_{m}$ e $S_{n}$ como anteriormente (soma dos postos correspondentes aos valores das amostras de tamanhos m e n respectivamente). Seja

$$W=U_n=S_n-\frac{n(n+1)}{2}.$$

- Calculamos o valor de $Z$ utilizando a equação (2.4.1), isto é

-

Fixamos o nível de significância α.

-

Encontramos o valor crítico utilizando a distribuição Normal Padrão.

-

Se o teste é bilateral, encontramos os valores críticos $Z_{α/2}$ e $-Z_{α/2}$ tais que P[Z > $Z_{α/2}$] = P[Z < $-Z_{α/2}$] = α/2.

-

Se o teste é unilateral à direita, encontramos o valor crítico $Z_{α}$ tal que P[Z > $Z_{α}$] = α.

-

Se o teste é unilateral à esquerda, encontramos o valor crítico $-Z_{α}$ tal que P[Z < $-Z_{α}$] = α.

- Critério:

-

Se o teste é bilateral e $Z_{obs}$ > $Z_{α/2}$ ou $Z_{obs}$ < $-Z_{α/2}$ rejeitamos a hipótese nula $H_{0}$, caso contrário, não rejeitamos a hipótese nula.

-

Se o teste é unilateral à direita e $Z_{obs}$ > $Z_{α}$ rejeitamos a hipótese nula $H_{0}$, caso contrário não rejeitamos a hipótese nula.

-

Se o teste é unilateral à esquerda e $Z_{obs}$ < $-Z_{α}$ rejeitamos a hipótese nula $H_{0}$, caso contrário não rejeitamos a hipótese nula.

- Cálculo do p-valor.

- Se o teste é bilateral o p-valor é dado por

$$P-valor = P[|Z| \ > \ |Z_{obs}||H_0]=2P[Z \ > \ |Z_{obs}||H_0].$$

- Se o teste é unilateral à direita, o p-valor é dado por

$$P-valor = P[Z \ > \ Z_{obs}|H_0].$$

- Se o teste é unilateral à esquerda, o p-valor é dado por

$$P-valor = P[Z \ < \ Z_{obs}|H_0].$$

onde Z ~ N(0,1).

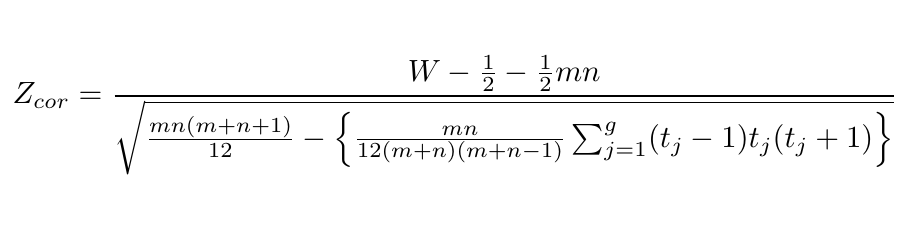

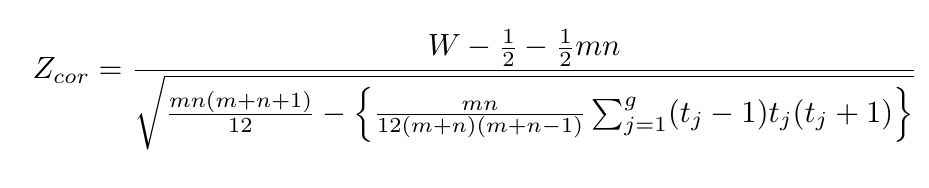

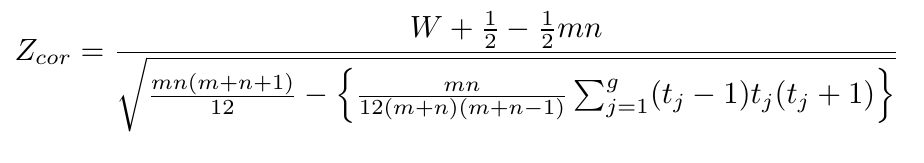

Aproximação Normal com correção de continuidade

Aqui também é conveniente utilizar uma correção de continuidade. Assim como visto anteriormente, a correção é feita de acordo com o tipo de teste utilizado.

- Se o teste é bilateral, calculamos A dado por

$$A = W -\frac{1}{2}nm.$$

Se A ≥ 0, então

Se A < 0, então

- Se o teste é unilateral à direita, a estatística é dada por

- Se o teste é unilateral à esquerda, a estatística é dada por

Exemplo 2.4.1

Consideremos duas amostras:

Amostra 1:

| 0 | 19 | 22 | 30 | 31 | 37 | 55 | 56 | 66 | 66 | 67 | 67 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 68 | 71 | 73 | 75 | 75 | 78 | 79 | 82 | 83 | 83 | 88 | 96 |

Amostra 2:

| 13 | 13 | 22 | 26 | 33 | 33 | 59 | 72 | 72 | 72 | 77 | 78 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 78 | 80 | 81 | 82 | 85 | 85 | 85 | 86 | 88 |

Usamos o teste da aproximação normal para amostras grandes para testar a hipótese de que estes dados podem ser considerados como amostras para populações idênticas contra a hipótese de que as populações diferem em localização.

Como os tamanhos das amostras são m = 24 e n = 21, respectivamente, a aproximação para amostras grandes será suficiente.

Na Tabela 2.3.1 temos os valores das amostras 1 e 2 colocados em ordem crescente com seus respectivos postos. Os postos dos valores repetidos são as médias entre os valores que os postos assumiriam normalmente. Veja a tabela:

| Valor | 0 | 13 | 13 | 19 | 22 | 22 | 26 | 30 | 31 | 33 | 33 | 37 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Posto | 1 | 2,5 | 2,5 | 4 | 5,5 | 5,5 | 7 | 8 | 9 | 10,5 | 10,5 | 12 |

| Valor | 55 | 56 | 59 | 66 | 66 | 67 | 67 | 68 | 71 | 72 | 72 | 72 |

| Posto | 13 | 14 | 15 | 16,5 | 16,5 | 18,5 | 18,5 | 20 | 21 | 23 | 23 | 23 |

| Valor | 73 | 75 | 75 | 77 | 78 | 78 | 78 | 79 | 80 | 81 | 82 | 82 |

| Posto | 25 | 26,5 | 26,5 | 28 | 30 | 30 | 30 | 32 | 33 | 34 | 35,5 | 35,5 |

| Valor | 83 | 83 | 85 | 85 | 85 | 86 | 88 | 88 | 96 |

Tabela 2.4.1: Postos combinados para as duas amostras independentes com valores repetidos.

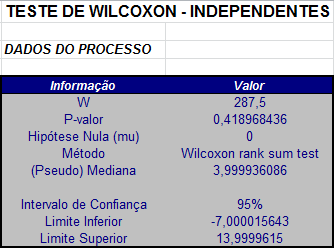

Assim, temos que

$$S_n=518,5.$$

Pela equação(2.4) temos que

$$W= U_n = S_n-\frac{n(n+1)}{2}=518,5-\frac{21\times 22}{2}= 287,5.$$

Neste caso, temos 19 grupos e o número de elementos de cada grupo pode ser visto na tabela abaixo

| 0 | 13 | 19 | 22 | 26 | 30 | 31 | 33 | 37 | 55 | 56 | 59 | 66 | 67 | 68 | 71 | 72 | 73 | 75 | 77 | 78 | 79 | 80 | 81 | 82 | 83 | 85 | 86 | 88 | 96 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 2 | 1 | 2 | 1 | 1 | 1 | 2 | 1 | 1 | 1 | 1 | 2 | 2 | 1 | 1 | 3 | 1 | 2 | 1 | 3 | 1 | 1 | 1 | 2 | 2 | 3 | 1 | 2 | 1 |

e então, segue que

$$\sum_{j=1}^{19}(t_j-1)t_j(t_j+1)=126$$

Usando a equação(2.4.1) temos que

$$Z = (287,5 - 252)/\sqrt{1929,327}= 35,5/43,9241=0,8082123.$$

Ao nível de significância de 5%, temos que $Z_{0,025}$ = 1,96 e como -1,96 < 0,8082123 < 1,96, não rejeitamos a hipótese de que as populações são idênticas.

O p-valor, neste caso é dado por

$$P-valor = 2P[Z \ > \ |Z_{obs}||H_0]=2P[Z \ > \ 0,8082123|H_0]=0,4189684.$$

Se tivéssemos utilizado a correção de continuidade, teríamos

$$A = W-\frac{1}{2}nm=287,5-252 = 35,5 \ > \ 0$$

e então,

$$Z_{cor}=\frac{287,5-0,5-252}{\sqrt{1929,443}}=\frac{35}{43,9241}=0,796829.$$

Deste modo, também não rejeitamos a hipótese de que as populações são idênticas, porém, neste caso, o p-valor é dado por

$$P-valor = 2P[Z \ > \ |Z_{cor}||H_0]=2P[Z \ > \ 0.796829]=0,4255504.$$

3 - Teste de Wilcoxon Pareado

O teste de Wilcoxon pareado é utilizado para comparar se as medidas de posição de duas amostras são iguais no caso em que as amostras são dependentes.

Para isto, consideramos duas amostras dependentes de tamanho n vindas de duas populações $P_{1}$ e $P_{2}$, isto é, $X_{1}$, …, $X_{n}$ e $Y_{1}$, …, $Y_{n}$. Como neste caso as amostras são dependentes não podemos aplicar o Teste de Wilcoxon-Mann-Whitney.

Neste caso vamos considerar observações pareadas, isto é, podemos considerar que temos na realidade uma amostra de pares:

$${(X_1, Y_1),\ldots , (X_n, Y_n)}.$$

Vamos definir $D_{i}$ = $X_{i}$ - $Y_{i}$, para i = 1, 2, …, n. Assim, obtemos a amostra $D_{1}$, $D_{2}$, …, $D_{n}$, resultante das diferenças entre os valores de cada par.

Para realizar o Teste de Wilcoxon Pareado devemos primeiramente estabelecer as hipóteses:

Ou seja, estaremos testando se as populações diferem em localização ou não utilizando a seguinte idéia: se aceitarmos a hipótese nula, temos que a mediana da diferença é nula, ou seja, as populações não diferem em localização. Já, se a hipótese nula for rejeitada, ou seja, se a mediana da diferença não for nula, temos que as populações diferem em localização.

Dessa forma, o nosso teste se tornou um Teste de Wilcoxon para uma única amostra - a amostra $D_{1}$, …, $D_{n}$ onde $θ_{0}$ = 0.

A partir daí, devemos seguir os passos do Teste de Wilcoxon para uma única amostra.

Observação

No Teste de Wilcoxon o conjunto de dados analisado é o conjunto obtido subtraindo-se $θ_{0}$ de cada valor da amostra. Como neste caso $θ_{0}$ = 0, o conjunto que analisaremos é o próprio conjunto $D_{1}$, …, $D_{n}$.

Exemplo 3.1

Consideremos duas amostras dependentes cujos dados estão na Tabela abaixo. Existem evidências de diferença entre as duas amostras?

| Amostra 1 | 564 | 521 | 495 | 564 | 560 | 481 | 545 | 478 | 580 | 484 | 539 | 467 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Amostra 2 | 557 | 505 | 465 | 562 | 545 | 448 | 531 | 458 | 562 | 485 | 520 | 445 |

| Diferença | 7 | 16 | 30 | 2 | 15 | 33 | 14 | 20 | 18 | -1 | 19 | 22 |

Denotamos as observações da amostra 1 por $X_{i}$, i = 1, …, 12, e da amostra 2 por $Y_{i}$, i = 1, …, 12. Podemos escrever os pares de observações $(X_1,Y_{1}$), $(X_2,Y_{2}$), …, $(X_{12},Y_{12}$). Analisamos a diferença $D_{i}$= $Y_{i}$$-X_{i}$. $D_{1}$, …, $D_{12}$ é uma amostra de 12 observações independentes e igualmente distribuídas.

A Tabela abaixo nos da as diferenças da Tabela 3.1 ordenadas de forma crescente (a partir dos valores absolutos das diferenças) e seus respectivos postos.

| Diferença | -1 | 2 | 7 | 14 | 15 | 16 | 18 | 19 | 20 | 22 | 30 | 33 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Postos | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 |

Assim, nosso teste agora se resume em um Teste de Wilcoxon para uma única amostra.

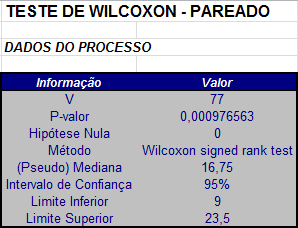

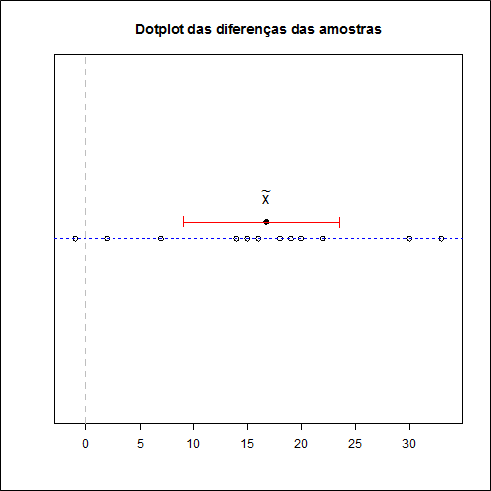

Temos que a estatística $T^{+}$ que é soma dos postos positivos é dada por

$$T^+=2+3+4+5+6+7+8+9+10+11+12 = 77.$$

Utilizando a distribuição exata da estatística de Wilcoxon para uma única amostra, temos que, para α = 5%, os valores críticos são $t_{1}$ = 14 e $t_{2}$ = 64.

Conclusão

Como o valor crítico $T_{obs}^{+}$ = 77 > $t_{2}$ = 64, rejeitamos a hipótese nula. Portanto, há evidências de diferenças entre as duas amostras.

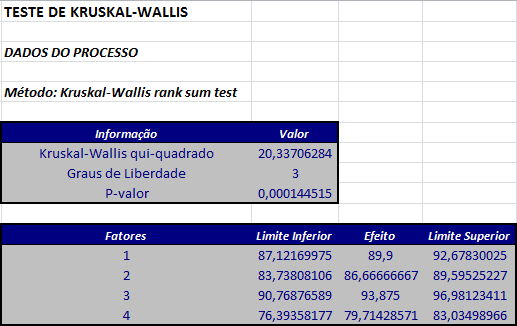

4 - Teste de Kruskal Wallis

O teste de Kruskal-Wallis (KW) é uma extensão do teste de Wilcoxon-Mann-Whitney. É um teste não paramétrico utilizado para comparar três ou mais populações. Ele é usado para testar a hipótese nula de que todas as populações possuem funções de distribuição iguais contra a hipótese alternativa de que ao menos duas das populações possuem funções de distribuição diferentes.

Figura 4.1: William Henry Kruskal (1919 - 2005); Wilson Allen Wallis (1912-1998).

O teste de Kruskal-Wallis é o análogo ao teste F utilizado na ANOVA 1 fator. Enquanto a análise de variância dos testes dependem da hipótese de que todas as populações em confronto são independentes e normalmente distribuídas, o teste de Kruskal-Wallis não coloca nenhuma restrição sobre a comparação. Suponha que os dados provenham de k amostras aleatórias independentes com tamanhos amostrais $n_{1}$, $n_{2}$, …, $n_{k}$ sendo N = $n_{1 }$+ $n_{2 }$+ … + $n_{k}$ o número total de elementos considerados em todas as amostras.

| Amostra 1 | $ X_{11} $ | $ X_{12} $ | …… | $ X_{1,n_1} $ |

|---|---|---|---|---|

| Amostra 2 | $ X_{21} $ | $ X_{22} $ | …… | $ X_{2,n_2} $ |

| ⋮⋮ | ⋮⋮ | ⋮⋮ | ⋮⋮ | ⋮⋮ |

| Amostra k-1 | $ X_{k-1,1} $ | $ X_{k-1,2} $ | …… | $ X_{k-1,n_{k-1}} $ |

| Amostra k | $ X_{k,1} $ | $ X_{k,2} $ | …… | $ X_{k,n_k} $ |

Hipóteses

1) As N variáveis aleatórias ${X_{j1}, X_{j2}, \ldots, X_{j,n_j}}$ com $j=1,2,\ldots, k$ são mutuamente independentes.

2) Para cada $j\in {1,\ldots,k}$ as $n_{j}$ variáveis aleatórias ${X_{j1},X_{j2},\ldots,X_{j,n_j}}$ são uma amostra aleatória de uma distribuição contínua com função de distribuição $F_{j}$.

3) As funções de distribuição $F_{1}$, $F_{2}$, …, $F_{k}$ se relacionam através da relação

$$F_j(t)=F(t-\tau_j),\quad -\infty < t < \infty,$$

para j = 1, 2, …, k, em que F é uma função de distribuição para uma distribuição contínua com mediana desconhecida e $τ_{j}$ é o efeito do tratamento (desconhecido) para a população j.

Neste caso, a hipótese nula $H_{0}$ de interesse é a de que não há diferença entre os efeitos $\tau_1, \cdots , \tau_k$, isto é

$$H_0: \tau_1=\tau_2=\ldots=\tau_k.$$

Esta hipótese nula garante que cada função de distribuição $F_{1}$, $F_{2}$, …, $F_{k}$ é igual, ou seja, $F_1_{ }$= $F_{2}$ = … = $F_{k}$.

Para aplicar o método de Kruskal-Wallis, primeiramente ordenamos todas as N observações das k amostras da menor para a maior observação e consideramos $r_{ij}$ como sendo o posto de $X_{ij}$. Tomamos

$$R_i=\sum_{j=1}^{n_i}r_{ij} \quad \hbox{e} \quad R_{i\cdot}=\frac{R_i}{n_i}, \quad i = 1,\ldots, k.$$

Deste modo, temos por exemplo, que $R_{1}$ é a soma dos postos dos elementos da amostra 1 e $R_{i.}$ é o posto médio destas mesmas observações. A estatística de Kruskal-Wallis H, será dada por

$$H=\frac{\frac{12}{N(N+1)}\sum_{i=1}^kn_i\left(R_{i\cdot}-\frac{N+1}{2}\right)^2}{1-\frac{ \sum_{j=1}^g t_j^3-t_j}{N^3-N}}=\frac{\left(\frac{12}{N(N+1)}\sum_{i=1}^k \frac{R_i^2}{n_i} \right)-3(N+1)}{1-\frac{\sum_{j=1}^g t_j^3-t_j}{N^3-N}}$$

em que $t_{j}$ é o tamanho do grupo de elementos repetidos j e g é o número de grupos. Uma observação que não se repete é considerada como um grupo de tamanho 1. Esta estatística tem, aproximadamente, uma distribuição qui-quadrado com k-1 graus de liberdade.

Os passos para realização deste teste são dados a seguir:

- Estabelecemos as hipótese

-

Ordenamos de forma crescente de magnitude os valores deste novo conjunto de dados e associamos a cada valor seu posto correspondente, tendo cada posto o mesmo sinal do valor que este representa.

-

Calculamos o valor da estatística H. Em seguida, fixamos o nível de significância α.

-

Encontramos os valores críticos referentes ao nível de significância fixado. Neste caso, calculamos os valores $Q_{α}$ de modo que P[H > $Q_{α }$] = α (sob $H_0$).

-

Se $H_{obs}$ > $Q_{α}$ rejeitamos a hipótese nula de que as amostras provém de populações igualmente distribuídas.

-

O p-valor é calculado da seguinte forma

$$P-valor = P[\chi^2_{k-1} \geq H|H_0]$$

Exemplo 4.1

Os dados a seguir são de uma experiência clássica agrícola para avaliar o rendimento de culturas divididas em quatro grupos diferentes. Para manter a simplicidade, identificamos os tratamentos usando os números inteiros {1,2,3,4}. Queremos avaliar se os dados provém de distribuições igualmente distribuídas.

| Grupos | Resposta |

|---|---|

| 1 | 83 |

| 1 | 91 |

| 1 | 94 |

| 1 | 89 |

| 1 | 89 |

| 1 | 96 |

| 1 | 91 |

| 1 | 92 |

| 1 | 90 |

| 1 | 84 |

| 2 | 91 |

| 2 | 90 |

| 2 | 81 |

| 2 | 83 |

| 2 | 84 |

| 2 | 83 |

| 2 | 88 |

| 2 | 91 |

| 2 | 89 |

| 3 | 101 |

| 3 | 100 |

| 3 | 91 |

| 3 | 93 |

| 3 | 96 |

| 3 | 95 |

| 3 | 94 |

| 3 | 81 |

| 4 | 78 |

| 4 | 82 |

| 4 | 81 |

| 4 | 77 |

| 4 | 79 |

| 4 | 81 |

| 4 | 80 |

- Estabelecemos as hipóteses:

- A partir dos dados temos a seguinte tabela, relacionando os postos de cada elemento, os tamanhos amostrais de cada grupo e os valores $R_{i}$ para cada grupo:

| $j$ | $r_{1j}$ | $r_{2j}$ | $r_{3j}$ | $r_{4j}$ |

|---|---|---|---|---|

| 1 | 11 | 23 | 34 | 2 |

| 2 | 23 | 19,5 | 33 | 9 |

| 3 | 28,5 | 6,5 | 23 | 6,5 |

| 4 | 17 | 11 | 27 | 1 |

| 5 | 17 | 13,5 | 31,5 | 3 |

| 6 | 31,5 | 11 | 30 | 6,5 |

| 7 | 23 | 15 | 28,5 | 4 |

| 8 | 26 | 23 | 6,5 | |

| 9 | 19,5 | 17 | ||

| 10 | 13,5 | |||

| $R_i$ | 210 | 139,5 | 213,5 | 32 |

| $N$ | 34 | 34 | 34 | 34 |

| $ni$ | 10 | 9 | 8 | 7 |

- Cálculo da estatística H.

$$H=\frac{\left(\frac{12}{N(N+1)}\sum_{i=1}^k \frac{R_i^2}{n_i} \right)-3(N+1)}{1-\frac{\displaystyle\sum_{j=1}^g t_j^3-t_j}{N^3-N}}=$$

$$=\frac{0,010084034*(122,5+36+675,28125+1170,035714)}{1-0,006417112}=$$

$$=20,337.$$

- Cálculo dos valores críticos.

Fixando o nível de significância α = 0,05 e sabendo que k = 4, temos que o valor crítico corresponde ao ponto $Q_{0,95}$ = 7,815.

- Critério de rejeição.

Como $H_{obs}$ = 20,337 > $Q_{0,95}$ = 7,815, rejeitamos a hipótese nula.

- Neste caso, o p-valor é dado por

$$P-valor = P[\chi^2_{k-1}\geq H_{obs}]=P[\chi^2_{3}\geq 20,337]=0,0001445.$$

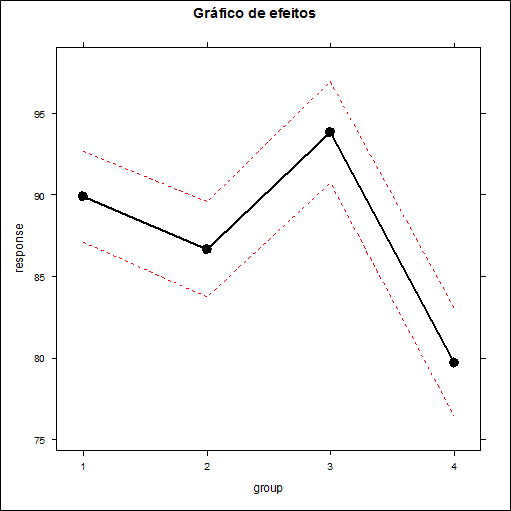

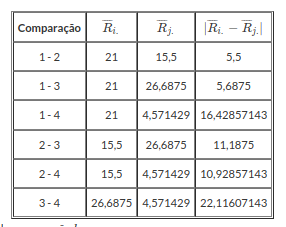

Comparações Múltiplas

Ao compararmos vários tratamentos, por exemplo na área médica, o números de tratamentos geralmente é bastante pequeno. Porém, ao compararmos a evasão dos alunos de graduação de alguma universidade, por exemplo, obtemos maior números de tratamentos. Quando rejeitamos a hipótese nula $H_0$ no teste de Kruskal-Wallis, indica que ao menos um dos grupos é diferente dos demais. Porém, não temos a informação de quais são diferentes. Neste sentido, procedimento de comparações múltiplas nos permite determinar quais grupos são diferentes. Existe um procedimento simples para determinar quais os pares de grupos são diferentes.

Começamos testando as diferenças para todos os pares de grupos. Quando o tamanho da amostra é grande, estas diferenças tem distribuição assintótica normal padrão. No entanto, quando temos um grande número de diferenças e se essas diferenças não forem independentes, o procedimento de comparação múltipla deve ser ajustada de forma apropriada. Suponha que a hipótese de não haver diferença entre os $k$ grupos foi testada e rejeitada ao nível de significância $\alpha.$ Uma alternativa descrita em Siegel e Castellan é testar a significância dos pares de diferenças através da seguinte desigualdade,

$$|R_{i.}-R_{j.}|\geq Z_{\left(\frac{\alpha}{k(k-1)}\right)}\sqrt{\frac{N(N+1)}{12}\left(\frac{1}{n_i}+\frac{1}{n_j}\right)}~~~(4.1)$$

em que

- $n_i$ e $n_j$ são os tamanhos da amostra dos grupos $i$ e $j$ respectivamente;

- $N=n_1+n_2+\dots+n_k$ o número total de elementos considerados em todas as amostras;

- $R_{i.}$ e $R_{j.}$ é o efeito dos postos (ranks) dos grupos $i$ e $j$ respectivamente;

- $|R_{i.}-R_{j.}|$ é a diferença observada;

- $Z_{\left(\frac{\alpha}{k(k-1)}\right)}\sqrt{\frac{N(N+1)}{12}\left(\frac{1}{n_i}+\frac{1}{n_j}\right)}$ é a diferença crítica.

Assim, se (4.1) ocorre podemos rejeitar a hipótese $H_0:\tau_i=\tau_j$ e concluir que $H_1:\tau_i\neq\tau_j.$ Vale lembrar que neste teste de comparações múltiplas, se temos $k$ grupos, então o número de comparações é de $\frac{k(k-1)}{2}.$ Agora, vamos aplicar os conceitos no seguinte exemplo.

Exemplo 4.2

Voltando ao exemplo 4.1

1. Calcular as diferenças observadas.

| $j$ | $r_{1j}$ | $r_{2j}$ | $r_{3j}$ | $r_{4j}$ |

|---|---|---|---|---|

| 1 | 11 | 23 | 34 | 2 |

| 2 | 23 | 19,5 | 33 | 9 |

| 3 | 28,5 | 6,5 | 23 | 6,5 |

| 4 | 17 | 11 | 27 | 1 |

| 5 | 17 | 13,5 | 31,5 | 3 |

| 6 | 31,5 | 11 | 30 | 6,5 |

| 7 | 23 | 15 | 28,5 | 4 |

| 8 | 26 | 23 | 6,5 | |

| 9 | 19,5 | 17 | ||

| 10 | 13,5 | |||

| $\overline{R}_{i.}$ | 21 | 15,5 | 26,68 | 4,57 |

Tabela 4.1: Postos para cada grupo.

Tabela 4.2: Diferença observada para cada comparação $k$.

2. Consultar na tabela da normal padrão o valor de Z:

$$Z_{\left(\frac{\alpha}{k(k-1)}\right)}=Z_{\left(\frac{0,05}{4(4-1)}\right)}=2,638257$$

3. Calcular as diferenças críticas:

| Comparação | $Z_{(\frac{\alpha}{k(k-1)})}$ | $\sqrt{\frac{N(N+1)}{12}\left(\frac{1}{n_i}+\frac{1}{n_j}\right)}$ | Diferença Crítica |

|---|---|---|---|

| 1 - 2 | 2,638257 | 4,575498 | 12,07134 |

| 1 - 3 | 2,638257 | 4,723611 | 12,4621 |

| 1 - 4 | 2,638257 | 4,907477 | 12,94719 |

| 2 - 3 | 2,638257 | 4,838838 | 12,7661 |

| 2 - 4 | 2,638257 | 5,018484 | 13,24005 |

| 3 - 4 | 2,638257 | 5,153882 | 13,59727 |

Tabela 4.3: Diferenças Críticas.

Veja a seguir os resultados obtidos pelo software Action para o mesmo exemplo.

(imagem em falta)

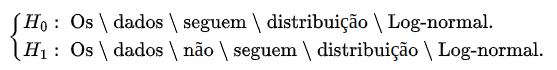

5 - Teste de Friedman

O teste de Friedman é uma alternativa não paramétrica para o teste de experimentos em blocos ao acaso (RBD - Randon Blocks Design) na ANOVA regular. Ele substitui o RBD quando os pressupostos de normalidade não estão assegurados, ou quando as variações são possivelmente diferentes de população para população. Este teste utiliza os ranks dos dados ao invés de seus valores brutos para o cálculo da estatística de teste. Como o teste de Friedman não faz suposições sobre a distribuição, ele não é tão poderoso quanto o teste padrão se as populações forem realmente normais.

Milton Friedman publicou os primeiros resultados para este tipo teste. Ele recebeu o Prêmio Nobel de Economia em 1976 e uma das publicações sobre sua descoberta foi o artigo “O Uso de Ranks para evitar a suposição de normalidade implícitos na análise de variância “, publicado em 1937.

Figura 5.1: Milton Friedman (1912-2006).

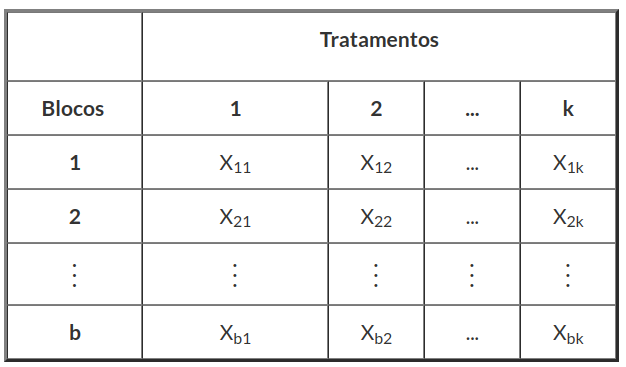

Lembremos que o projeto RBD exige medidas repetidas para cada bloco em cada nível de tratamento. Suponha que $X_{ij}$, representa o resultado experimental do fator (ou “bloco”) i com o tratamento j, onde i = 1, …, b e j = 1, …, k.

Tabela 5.1: Tabela Cruzada dos Dados.

Para calcular a estatística de teste de Friedman, ordenamos as k observações da menor para a maior de forma separada em cada um dos b blocos e atribuímos os ranks {1, 2, …, k} para cada bloco da tabela de observações. Assim, a posição esperada de qualquer observação sob $H_{0}$ é (k + 1)/2. Sendo $r(X_{ij}$) o rank da observação $X_{ij}$ definimos a soma de todos os ranks da coluna j (ou seja, de cada tratamento) por

$$R_j=\sum^b_{i=1}r(X_{ij}), \quad 1\leq j\leq k.\quad (5.1)$$

Se $H_{0}$ é verdadeira, o valor esperado de $R_{j}$ é $E(R_{j}$)=b(k+1)/2. Desta forma, a estatística

$$\sum^k_{j=1}\left(R_j-\frac{b(k+1)}{2}\right)^2$$

é uma forma intuitiva para revelar as diferenças entre os tratamentos.

A estatística do teste de Friedman será dada por

$$S=\frac{12b}{k(k+1)}\sum_{j=1}^k\left(\frac{R_j}{b}-\frac{k+1}{2}\right)^2=\left[\frac{12} {bk(k+1)}\displaystyle\sum_{j=1}^k R_j^2\right]-3b(k+1)$$

Se $F_{j}$(t) = $F(t+τ_{j}$) é a função de distribuição do tratamento j, com j = 1, 2, …, k, no teste de Friedman estamos interessados em testar a hipótese $H_{0}$: $τ_{1}$ = $τ_{2}$ = … = $τ_{k}$ contra a hipótese alternativa de que $τ_{1}$, $τ_{2}$, …, $τ_{k}$ não são todos iguais. Neste caso, ao nível de significância α, rejeitamos a hipótese $H_{0}$ se S ≥ $s_{α}$, caso contrário não rejeitamos a hipótese nula, em que a constante $s_{α}$ é escolhida de modo que a probabilidade de erro do tipo I seja igual a α.

Aproximação para amostras grandes

Sob $H_{0}$, a estatística S tem, quando n tende ao infinito, uma distribuição qui-quadrado $\chi^2$ com k-1 graus de liberdade. Neste caso, utilizando a aproximação qui-quadrado, rejeitamos $H_{0}$ se $S\geq \chi_{k-1,\alpha}^2$, caso contrário não rejeitamos $H_{0}$, onde $\chi_{k-1,\alpha}^2$ é tal que $P[\chi^2_{k-1}\geq \chi^2_{k-1,\alpha}]=\alpha$.

Observações repetidas

Se existem observações repetidas entre as k observações de um mesmo bloco, uma modificação para a estatística S é necessária. Neste caso substituímos S por

$$S^{\prime}=\frac{12\displaystyle\sum_{j=1}^k R_j^2-3b^2k(k+1)^2}{bk(k+1)-[\frac{1}{k-1}]\displaystyle\sum_{i=1}^n ({(\displaystyle\sum_{j=1}^{g_1}t_{i,j}^3)-k})},$$

no qual $g_{i}$ denota o número de grupos de observações repetidas no i-ésimo bloco e $t_{i,j}$ é o tamanho do j-ésimo grupo de observações repetidas no i-ésimo bloco. Em particular, se não há observações repetidas entre as observações no i-ésimo bloco, então $g_{i}$ = k e $t_{i,j}$ = 1 para cada j = 1, …, k. Se em todos os blocos não existem observações repetidas, então S' se reduz a S.

O p-valor é calculado da seguinte forma

$$P-valor = P[\chi^2_{k-1}\geq S^{\prime}|H_0].$$

Exemplo 5.1

Em uma avaliação de desempenho de veículos, seis motoristas avaliaram três carros (A, B e C) em um estudo aleatório. O objetivo do estudo é estudar o desempenho dos veículos e supostamente, na análise dos motoristas, a marca do veículo não influencia na avaliação. Na tabela abaixo, temos as classificações de cada carro, segundo cada motorista, em uma escala de 1 a 10.

| Carro | Motorista | Resposta |

|---|---|---|

| A | 1 | 7 |